国科大UCAS《信息论与机器学习》课程,中国科学院自动化研究所胡包钢研究员

中国科学院大学人工智能技术学院是国内首创该主题的学院,成立于2017年5月28日。因此在受邀为学院开课方面,我们将该课程具体定位为“前瞻理论综合,创新特色,国际水准”。我与赫然教授合作完成2018-2019年两次授课工作。

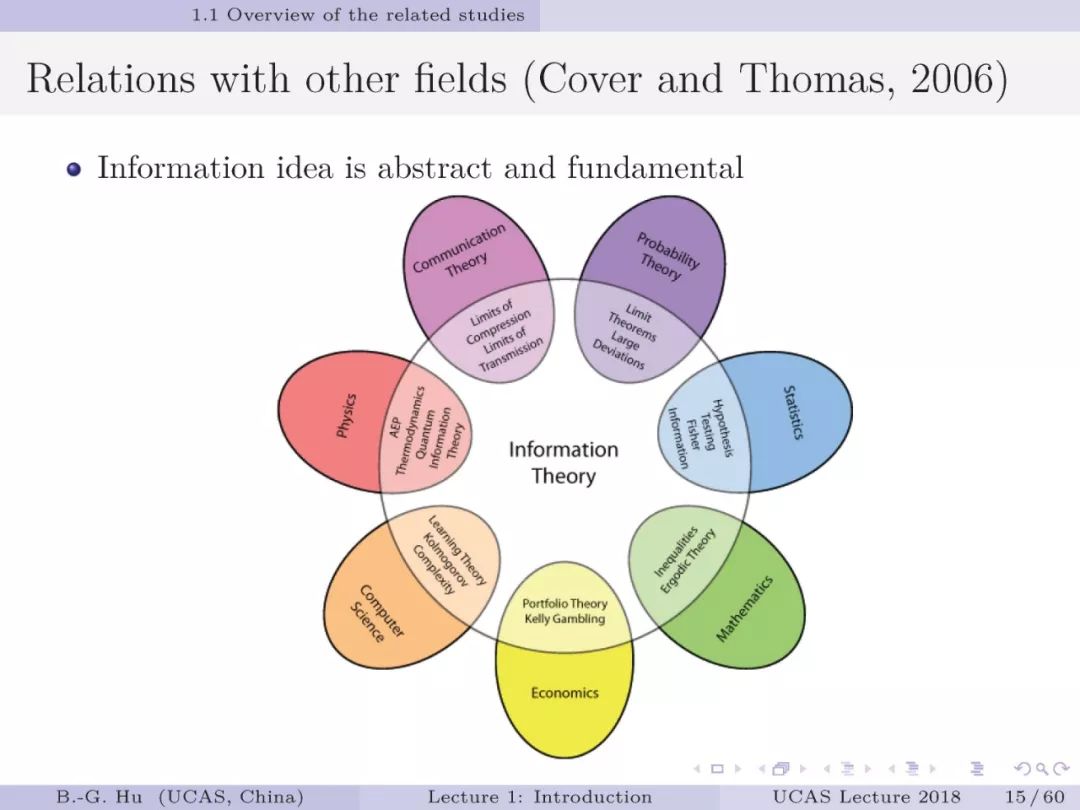

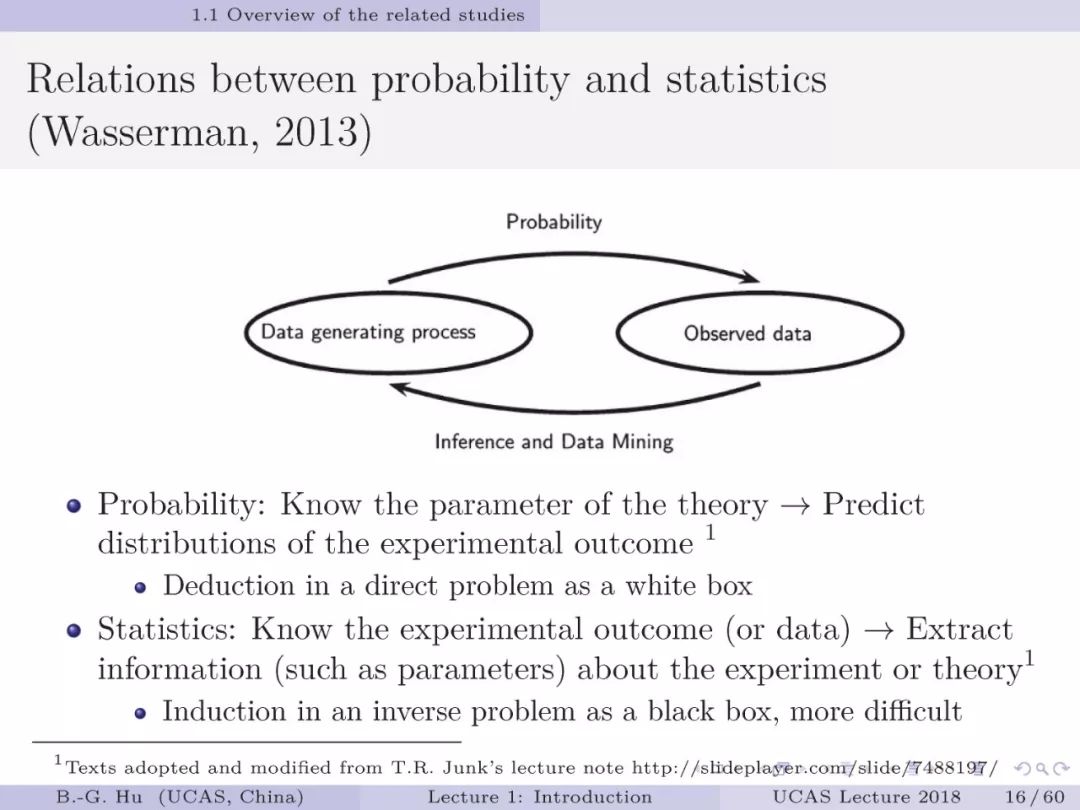

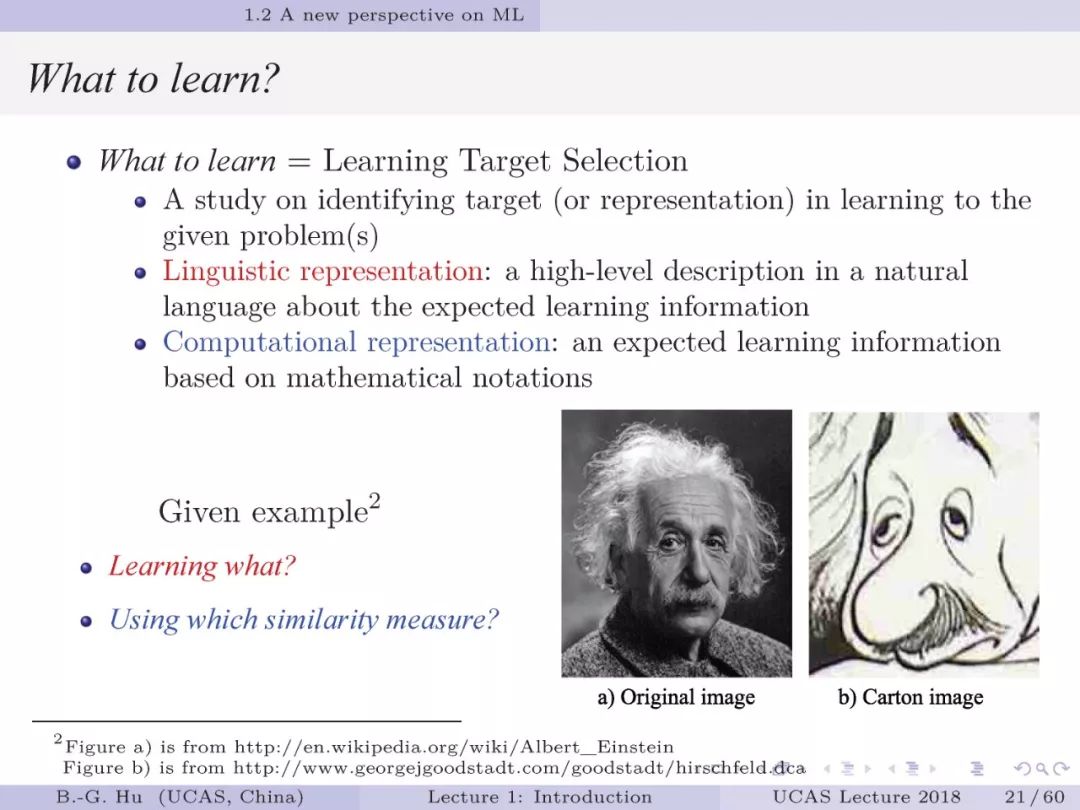

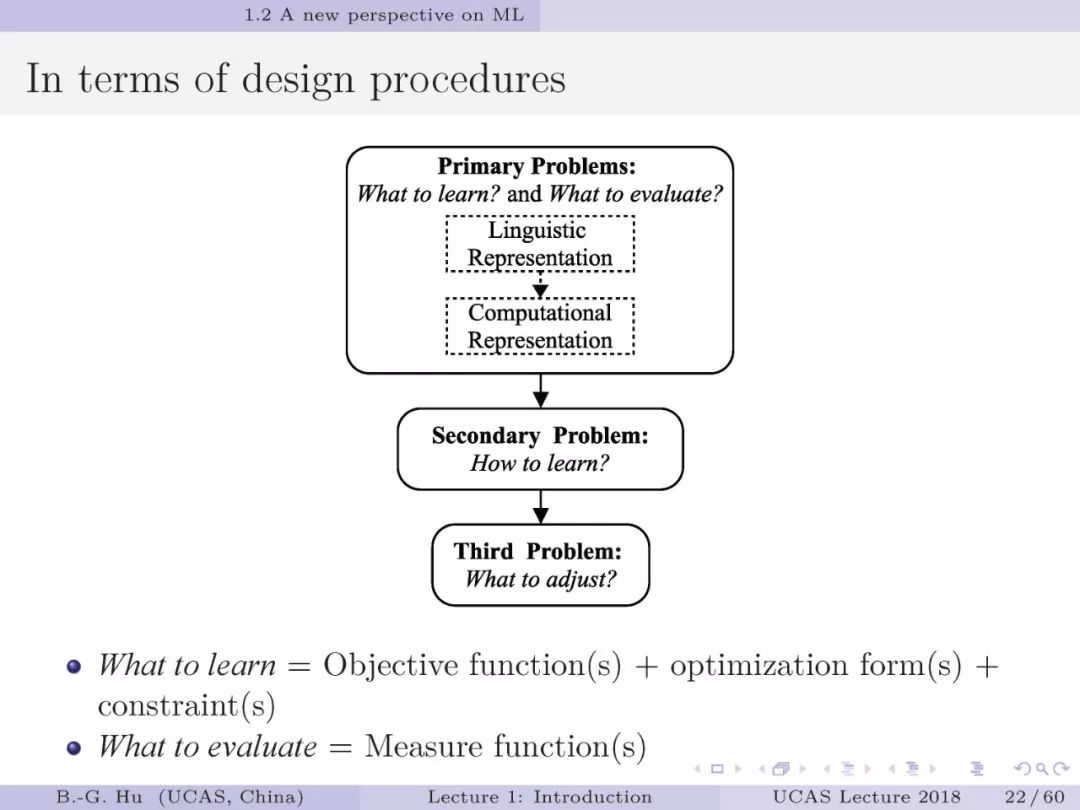

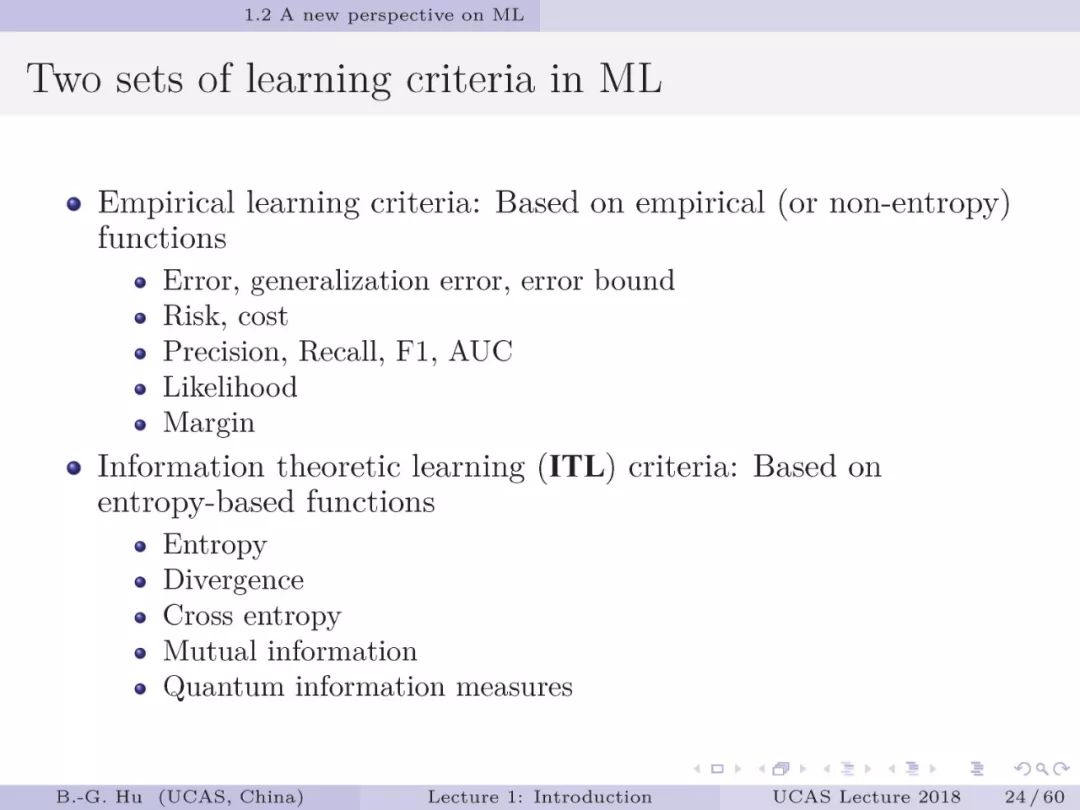

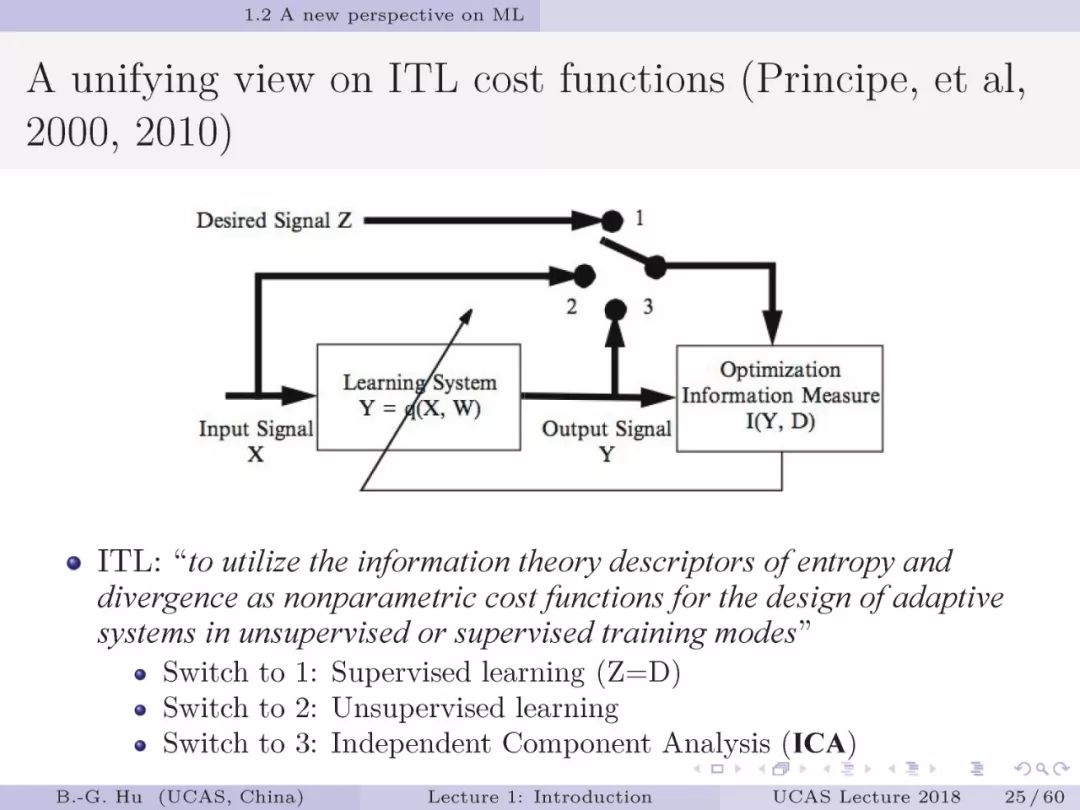

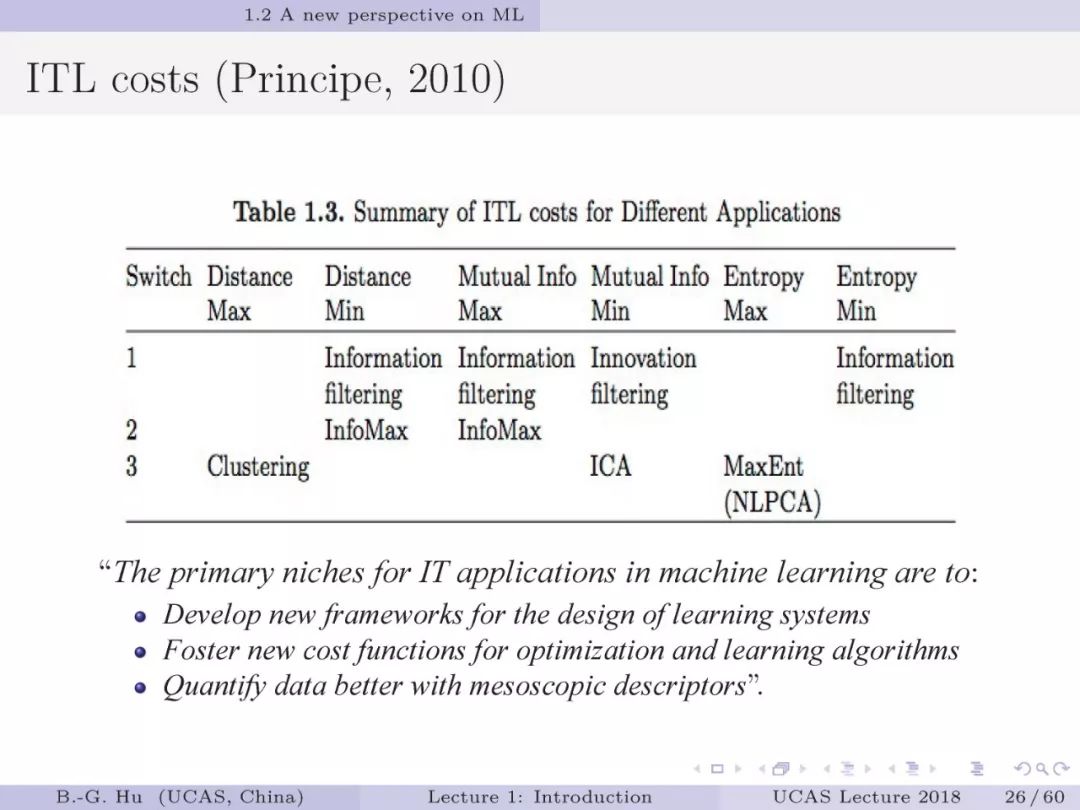

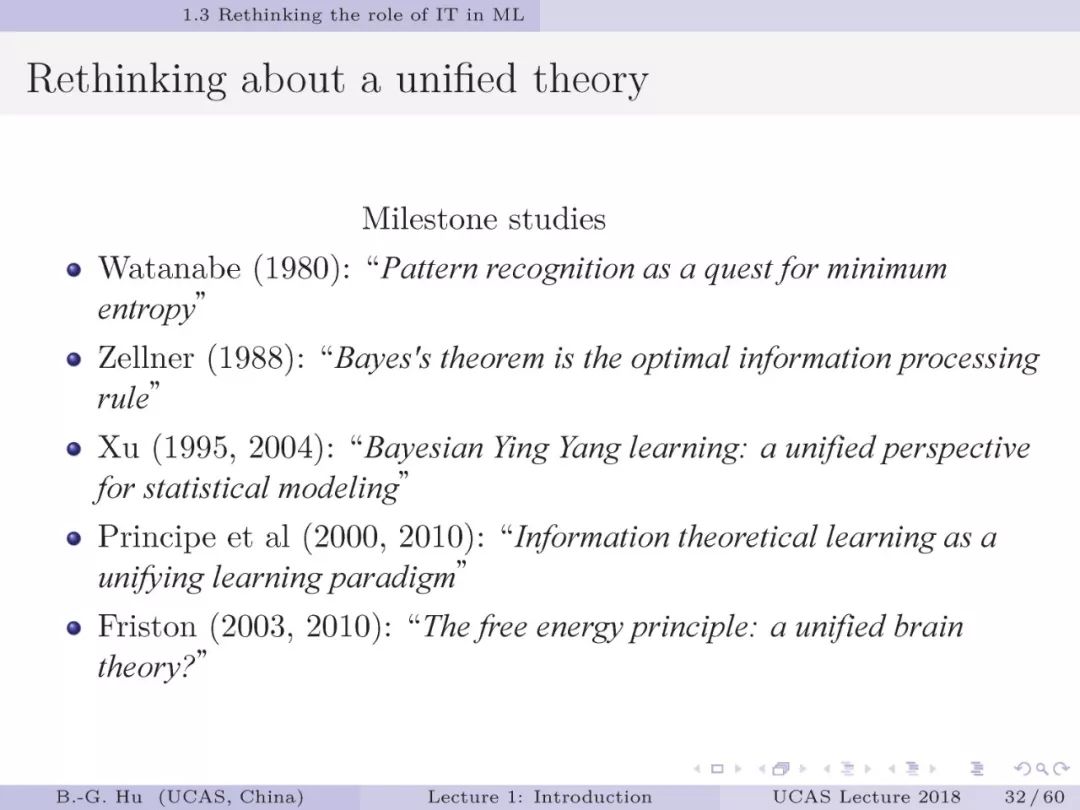

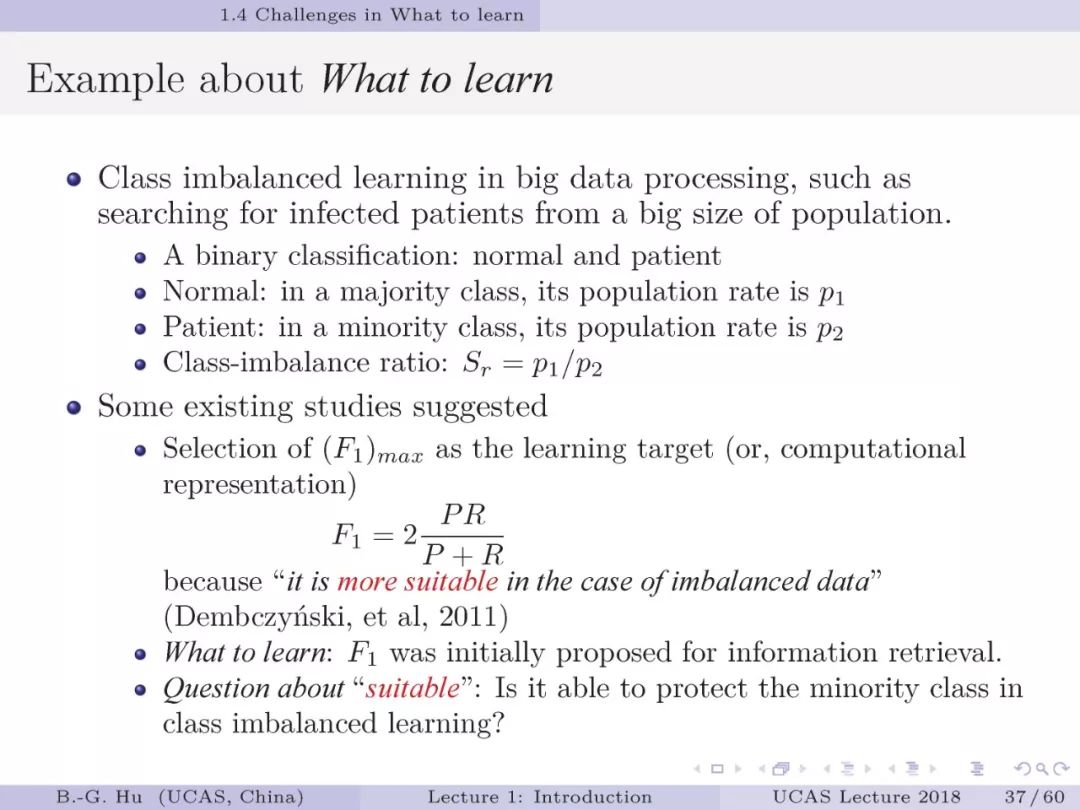

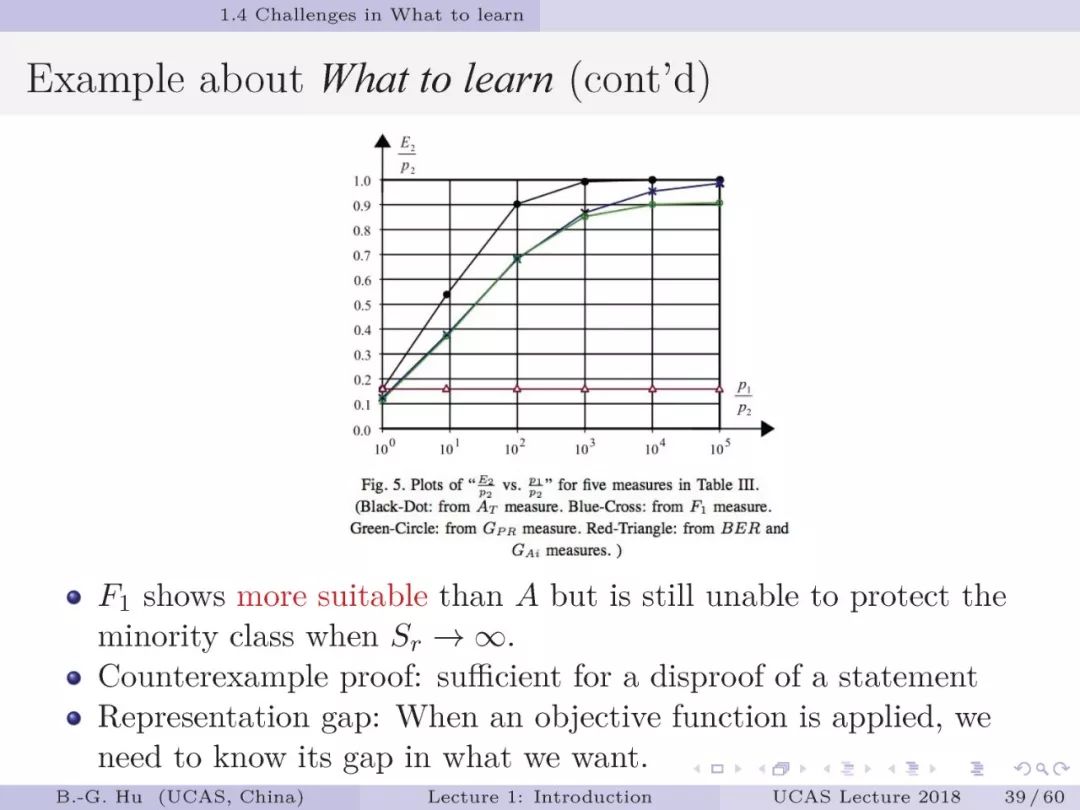

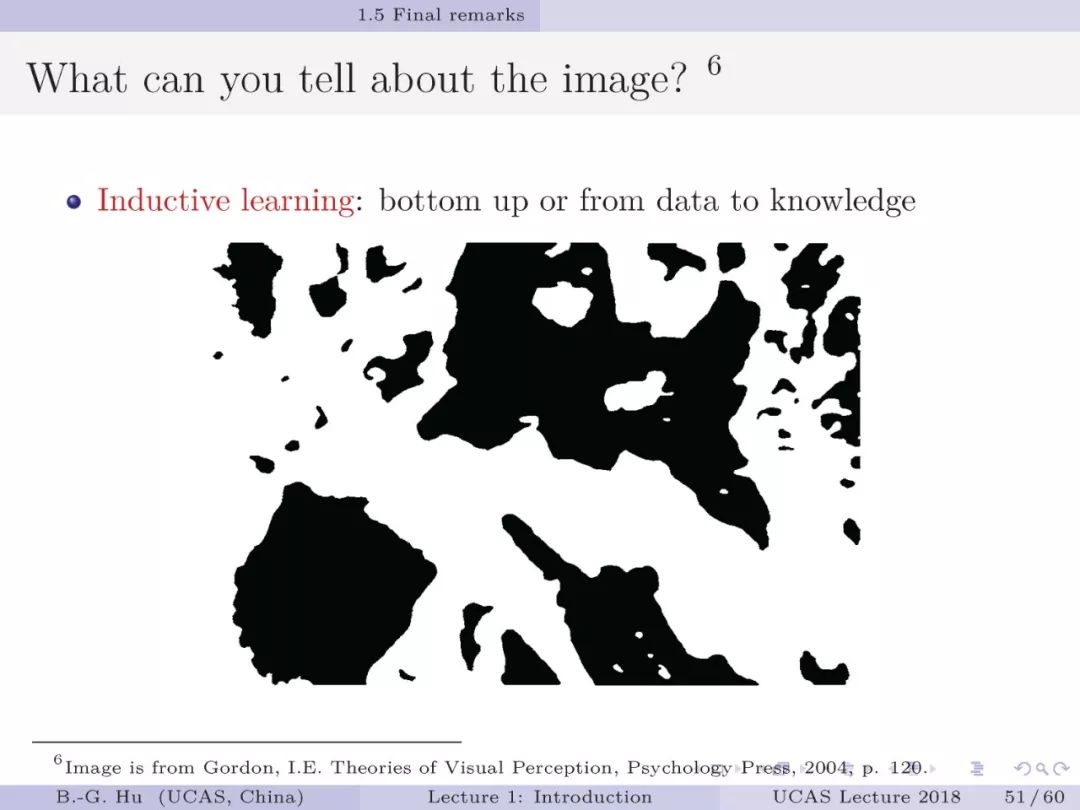

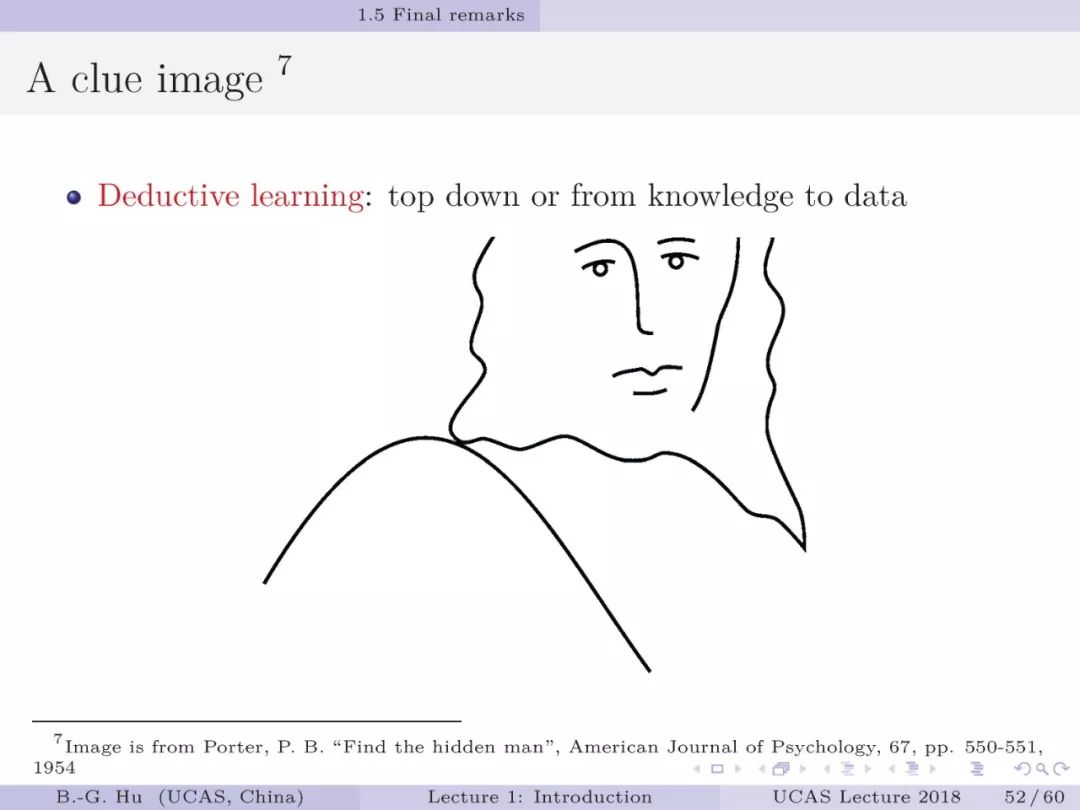

所谓“理论综合”是指信息论与机器学习有机结合。该课主题受美国佛罗里达大学Principe教授前瞻性学术思想影响,又可以称为“基于信息论的机器学习”。 由于目前机器学习课程主要是以统计学为教学内容。很多人则认为人工智能与机器学习就是统计学。为此本章第20-39页讲解了统计学并非能够回答机器学习中的首要基本问题:“学什么?”或者称为“学习目标选择”的问题。而信息论将会扮演重要角色并是前瞻理论基础。所谓“前瞻”是指未来的机器学习目标中可能更多地应用信息论原理与准则,并提供统一理论解释基础。在此我愿意用以下故事来讲解。

2017年9月23日国外的一篇报道(https://www.quantamagazine.org/new-theory-cracks-open-the-black-box-of-deep-learning-20170921/)介绍深度学习三剑客之一的加拿大多伦多教授Hinton写信给以色列教授Tishiby并评价他发展的信息瓶颈(Information Bottleneck”)理论可以揭示深度学习本质,要学1万遍(原话:“I have to listen to it another 10,000 times to really understand it, but it’s very rare nowadays to hear a talk with a really original idea in it that may be the answer to a really major puzzle”)。所谓“信息瓶颈”理论中的基础就是应用了信息论中互信息定义。不要以为Hinton教授不熟悉信息论。1992年他的博士生Becker(之后她成为加拿大McMaster大学教授)与他本人于NIPS会议上发表机器学习方面论文(Becker, S., and Hinton, G. E., "Learning to make coherent predictions in domains with discontinuities". In NIPS, pp. 372-379, 1992.)就是应用了互信息为学习目标来解决无监督学习中无标准答案的问题。Hinton教授形容“要学1万遍”的语义内涵是信息论太深刻了,远远不是数学定义层面上的学习。设想一下人类大脑或深度学习不就是网络结构吗?机器学习结合信息论是揭示生物脑或机器脑智能本质的必要条件(非充分条件)。他们该项研究之后并未发展出更多后续工作,说明信息论与机器学习“综合”不是那么简单。

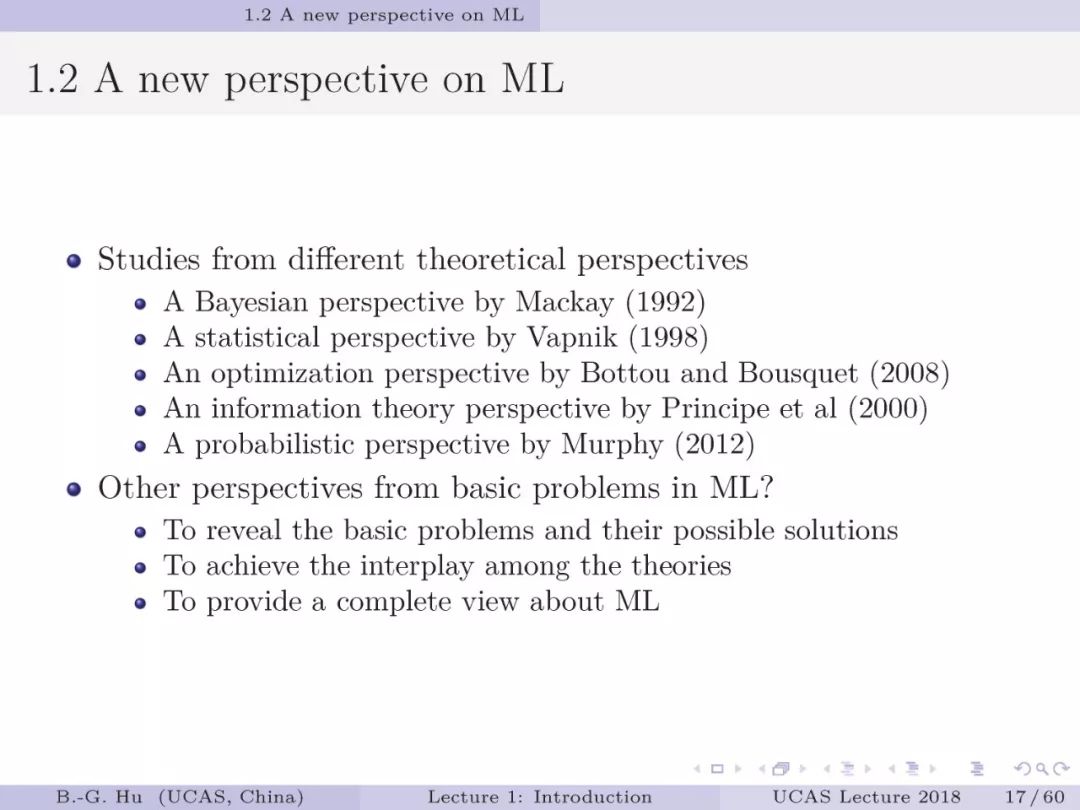

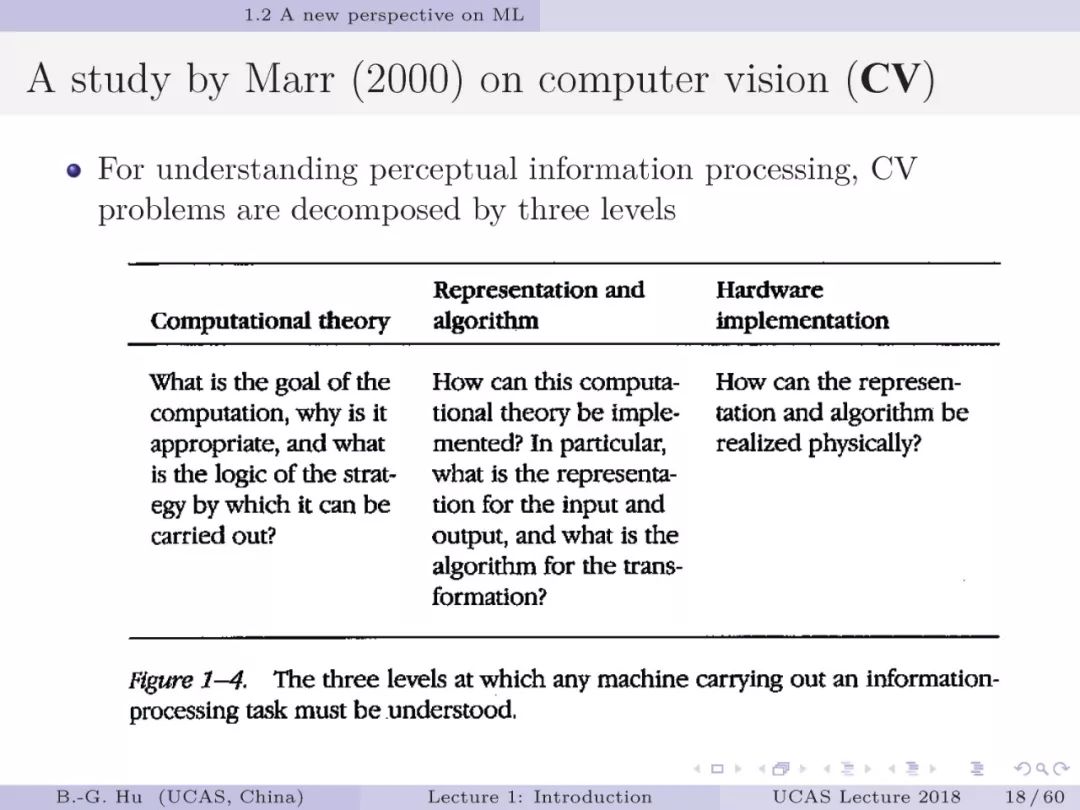

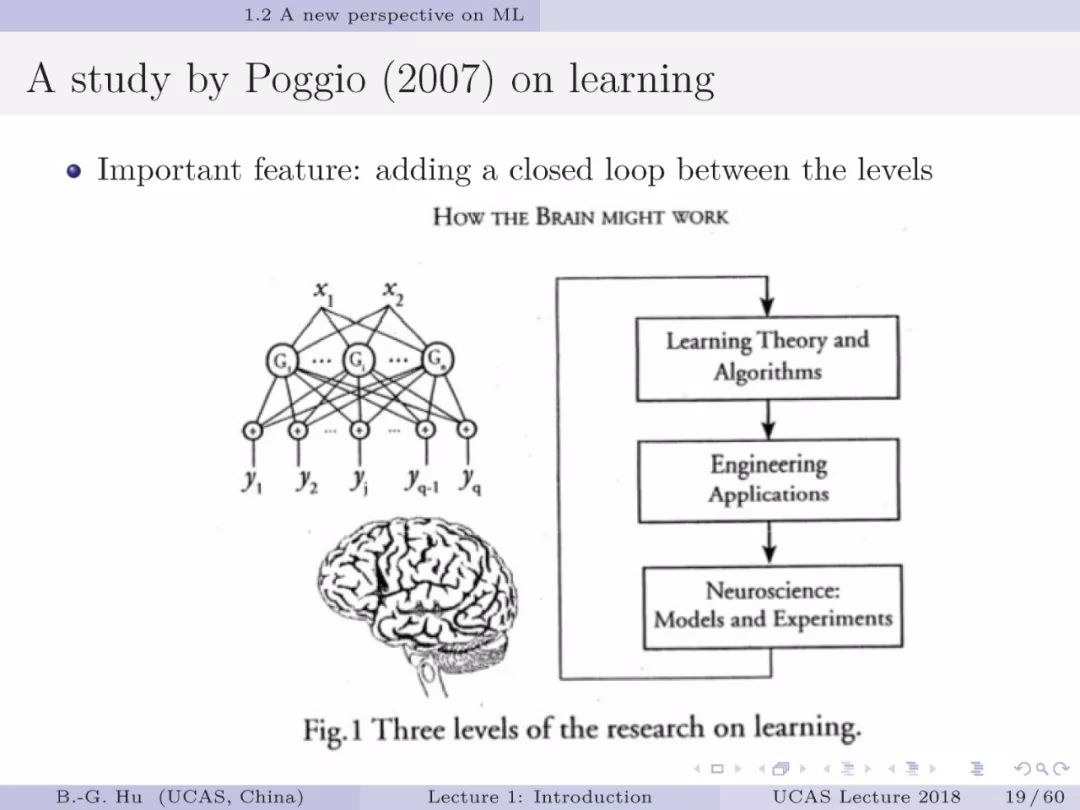

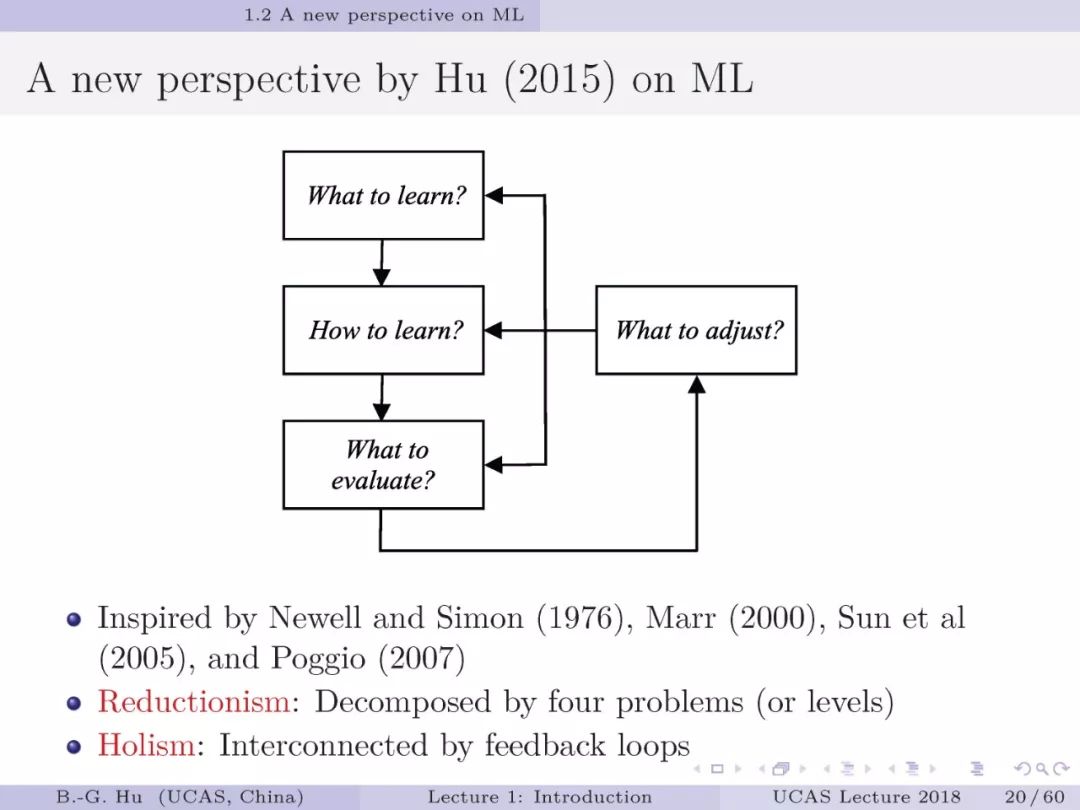

有关“创新特色”在第一章中首先体现在对机器学习基本问题的梳理。在介绍前人见解的同时,我们对机器学习基本问题的划分有利于理解各种学科在其中的地位和局限性。比如人机交互应用中的机器学习将更多需要社会科学、伦理学、认知科学方面的基础知识。我们期待第一章引言能够为研究者带来机器学习研究的全新视角:即有基本问题之间“还原论+整体论”解释(第20页),还有对信息论地位的大胆猜想(第33“页)。我们在以后各章会介绍其它创新思想。授课中我们强调“学术思想大于技术细节”,并给出具体实例。

目标“国际水准”是指课程设置与内容质量在国际水准中可比较。考虑当下十分活跃的人工智能发展,更多前沿知识内容也是关键。可以看到网上有许多信息论与机器学习独立开设的教学课件。而两主题合并的课程就很少(主要是英国剑桥大学McKay教授2003年的专著及其课程)。本人应用约半年时间完成个人部分课件,采取英文编写课件正是期待中国的教学内容能够走向世界。很高兴这个课程从设置与内容上能够为同行教学提供独特样例,这与我们学院为中国首创与“面向国际学科前沿”目标是相称的。

此次公开我个人教学课件(共七章,共21学时)是为了更快更广地传播新知识。也是个人作品历史阶段记录。为促进思考与创新,课件中给出许多个人不成熟见解。欢迎同行引用、批评、发展课件内容并予以标注。之后各章内容会有更大的学习难度。希望同学们不要气馁。本人也是从原始基础很弱,外行起步自学信息论与机器学习方面知识,走到后来能够创造新知识。

自学中要力争一种境界:“学而时习之,不亦说乎”。

推荐读者阅读香港城市大学陈关荣教授介绍香农的一篇文章:“你遇见过香农吗?

http://www.ee.cityu.edu.hk/~gchen/pdf/Shannon.pdf

作业:

1. 试给出你对机器学习或人工智能不同于第20页内容的个人见解讨论。(学习或研究中要避免只见树木不见森林,且无有个人独立见解的全局思考。“学”之中要有“思(新知识)”与“悟(大智慧)”的主动与反复过程。

2.你认为人工智能芯片或量子计算研究在机器学习基本问题中更偏属于哪个?为什么?

3. 如果你是正在开展机器学习研究,可否从学习目标方面给出创新考察,并有否包括广义约束的内容?(要理解机器学习方法的不同更多是从学习目标选择方面不同。)

说明:

1. 本课是针对有《机器学习》或《模式识别》知识背景的学生开设的课程。

2. 有关课件内容难免存在问题。欢迎读者提出修正意见。

致谢:

1. 特别致谢中国自然科学基金委的多次项目资助,保证我们长期学术发展与积累。

2. 特别致谢我们学术团队中研究生们的学术贡献,具体贡献在各章文献中均有给出。

3. 致谢赫然教授(授课)与李志航博士生(助教),我们合作完成2018-2019年两次教学工作。

4. 致谢所有听本课的学生对教学提出的建议与指正。

5. 致谢专知公众号,为他们持久传播人工智能专业知识工作点赞。

第32页: Zellner研究结论是贝叶斯原理可由熵原理导出。反之则不然(至少目前没有证明)。这个结论有益于质疑一些学者提出的“贝叶斯大脑假设”(Knill and Pouget, 2004)。大脑智能机理可以应用贝叶斯原理解释,但是它无法成为统一理论。本人理解香港中文大学教授徐雷教授提出的阴阳和谐学习机中重要学术思想是大脑智能不是基于“预测性能”,而是基于“性价比”,且全部应用信息论为学习目标函数的计算表达(约束可以为其它方式表达)。这不同于传统MDL,AIC等方法,更具普适性。英国伦敦大学学院Friston教授是“大脑自由能原理假设”的领军人物。要知道是Hinton团队首创应用自由能原理为机器学习目标。(致谢戴博博士回国期间特意当面告知我Zellner研究文章。)

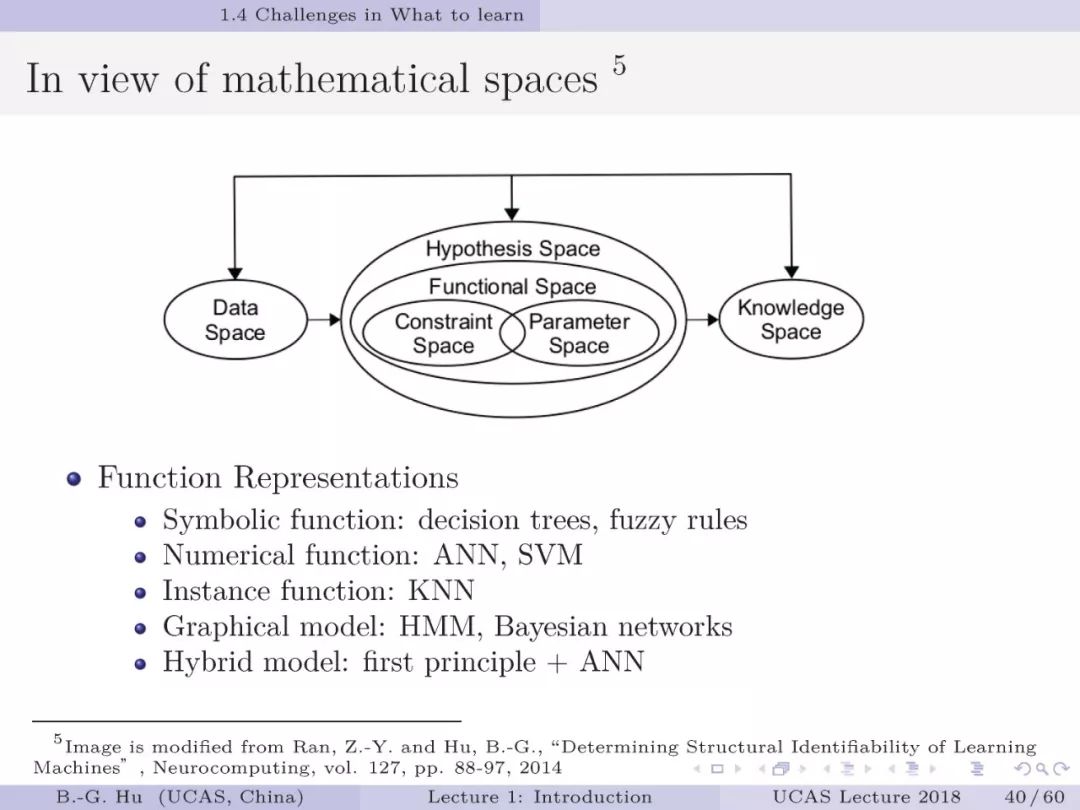

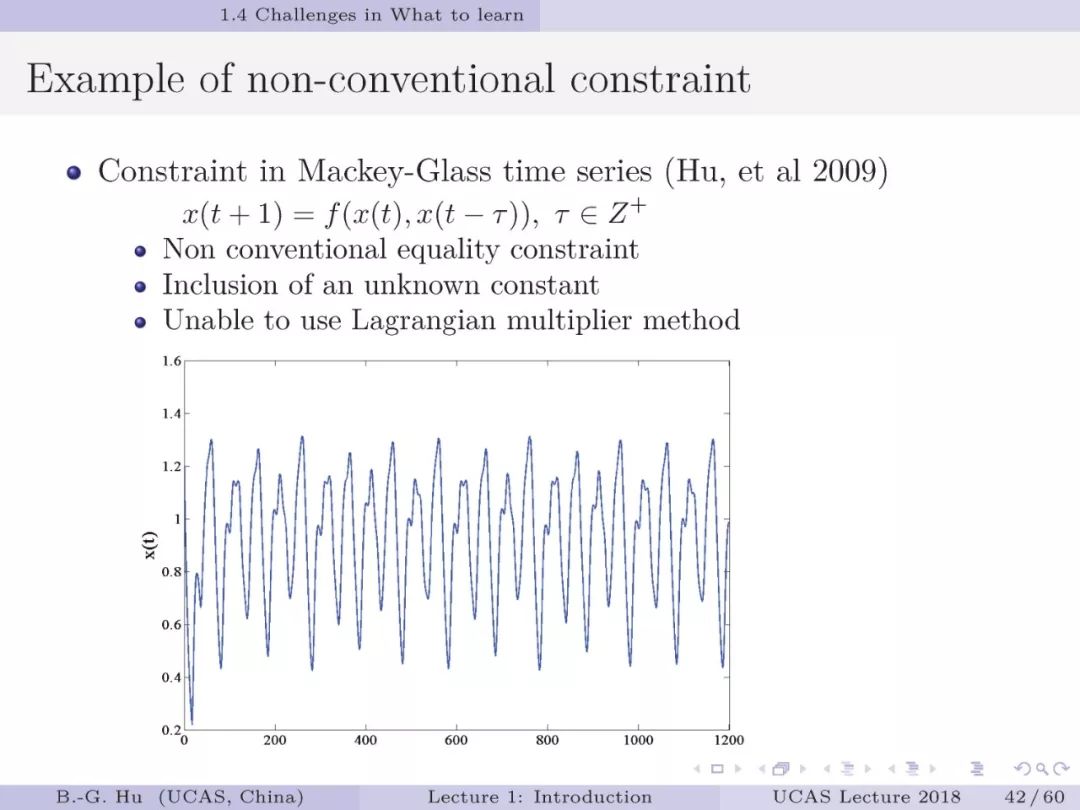

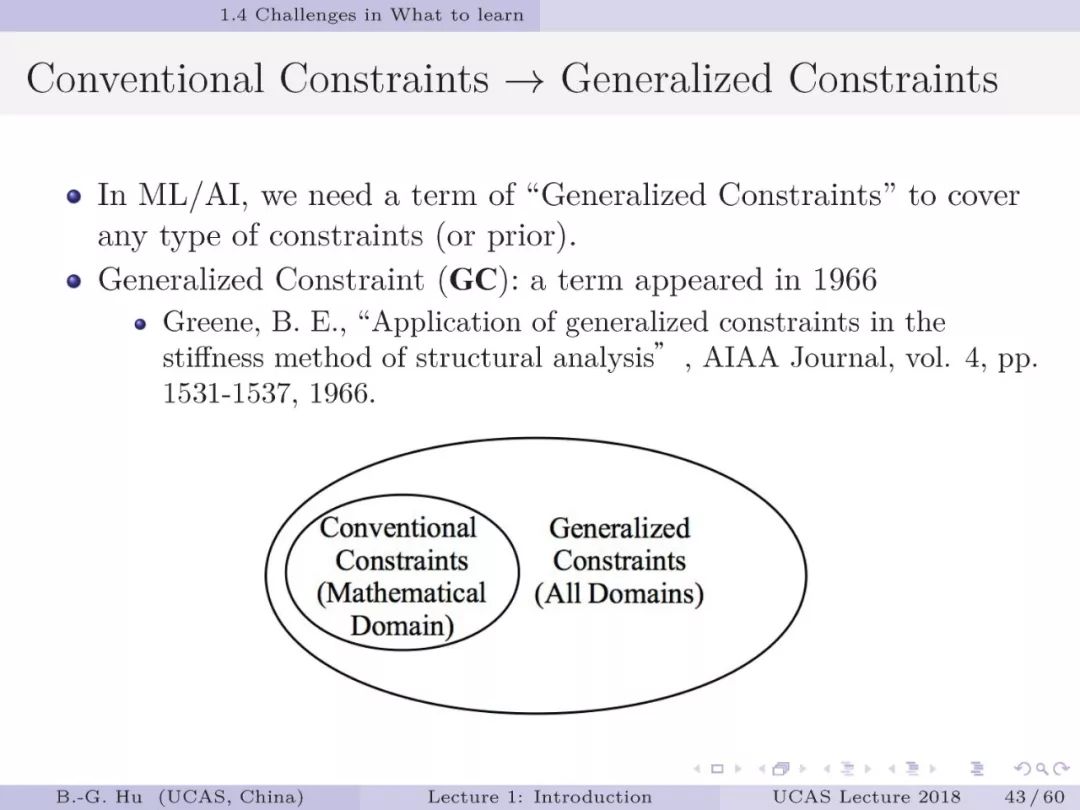

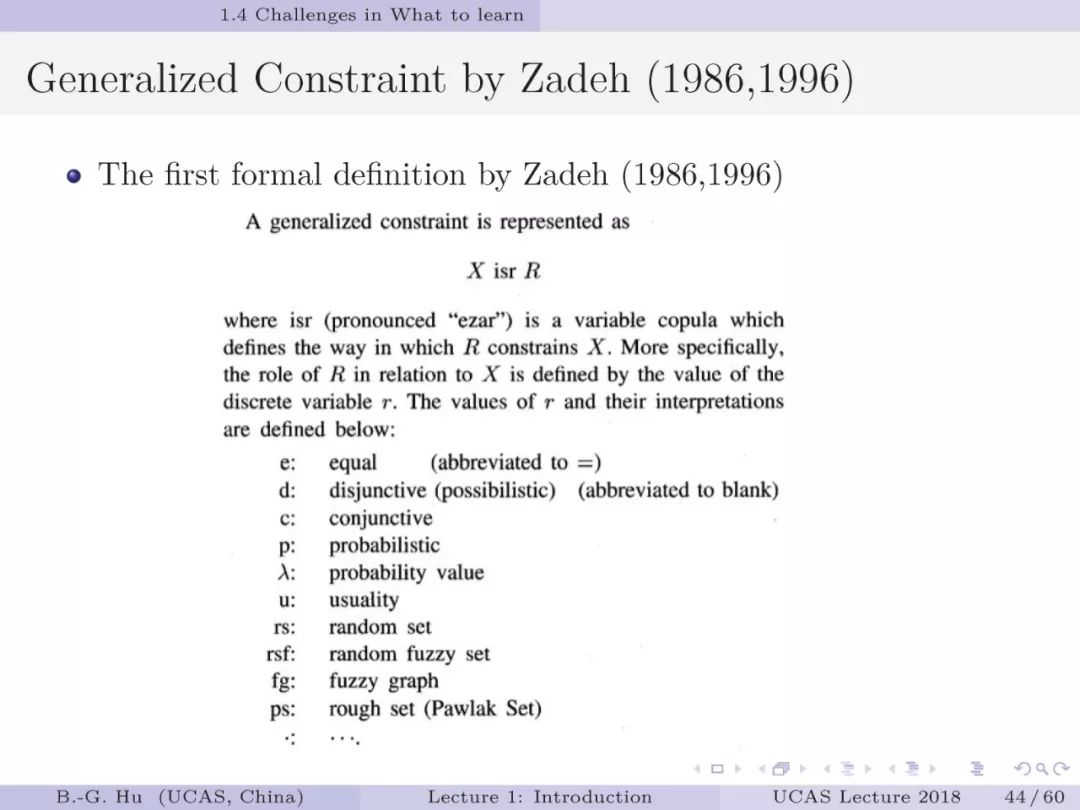

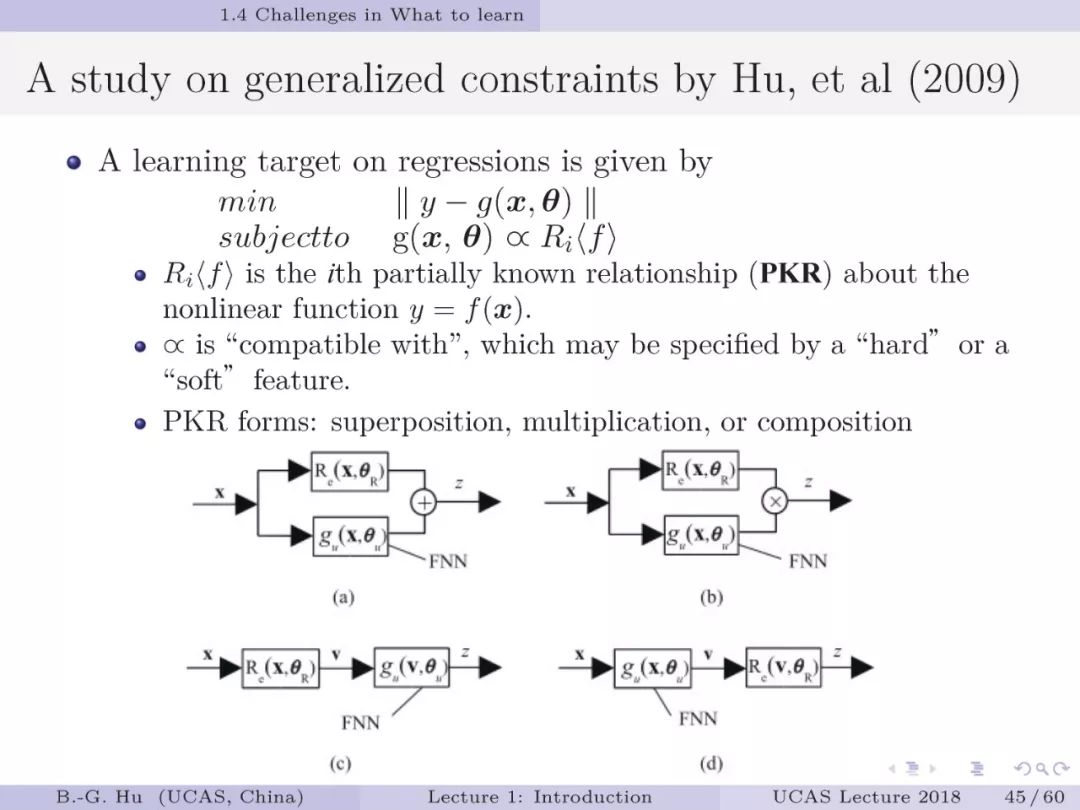

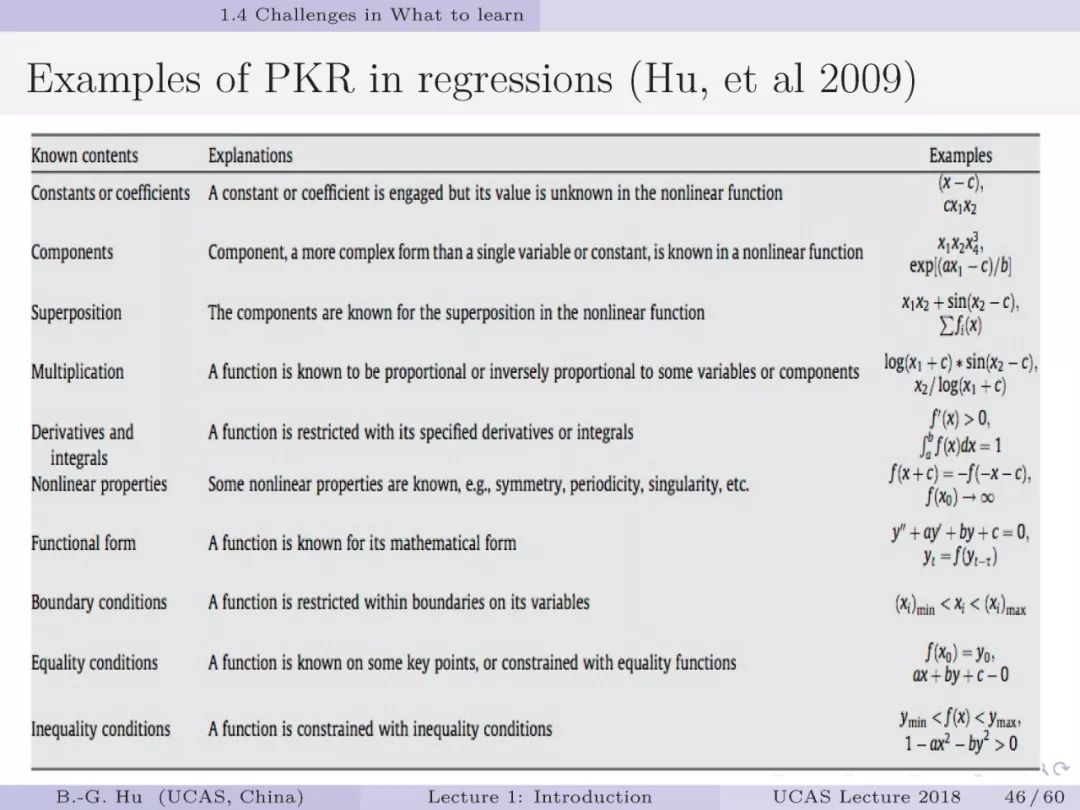

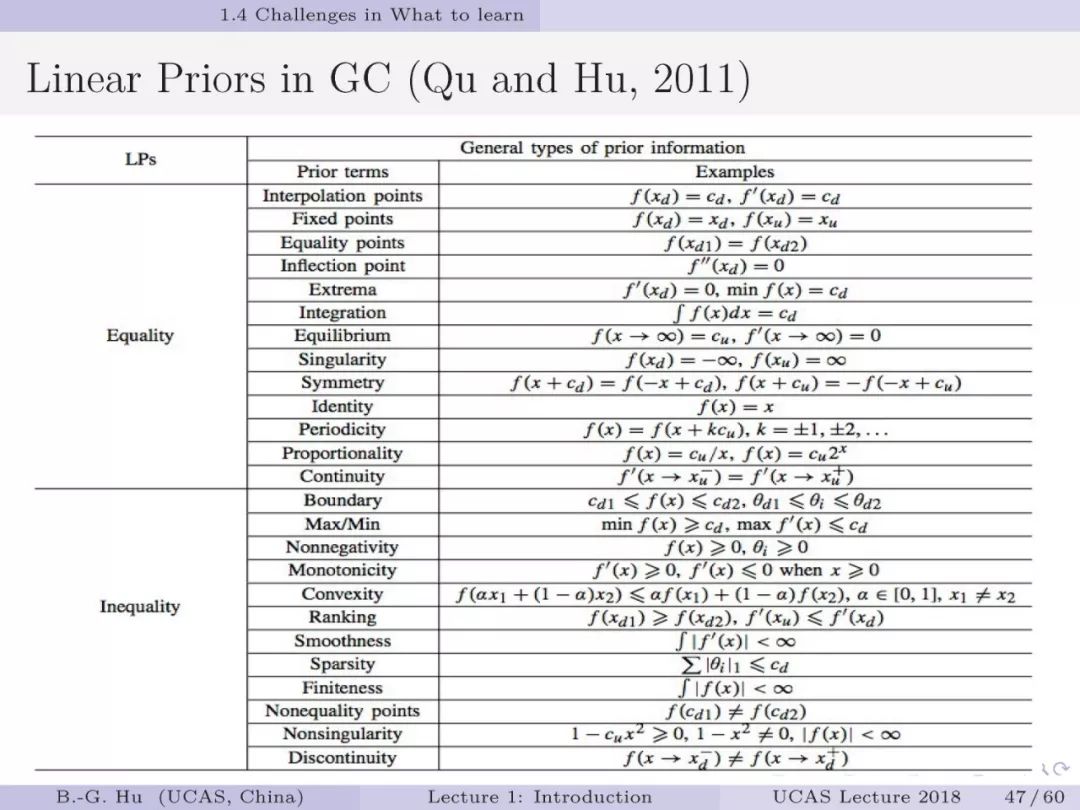

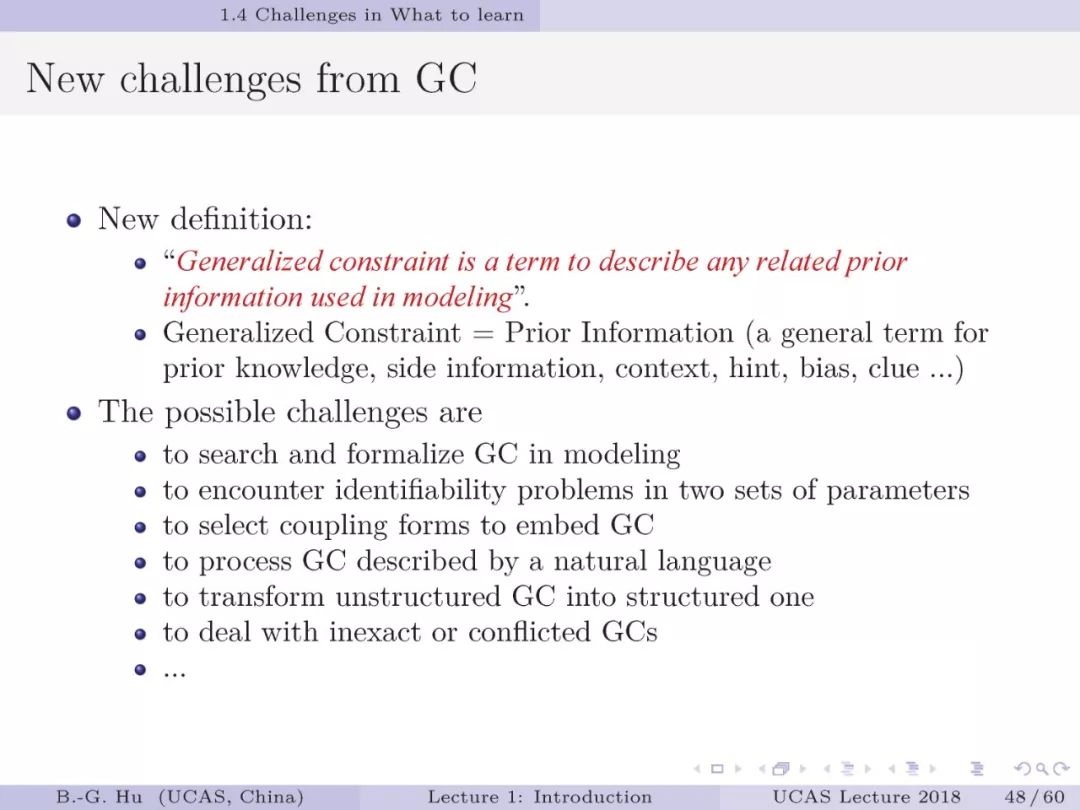

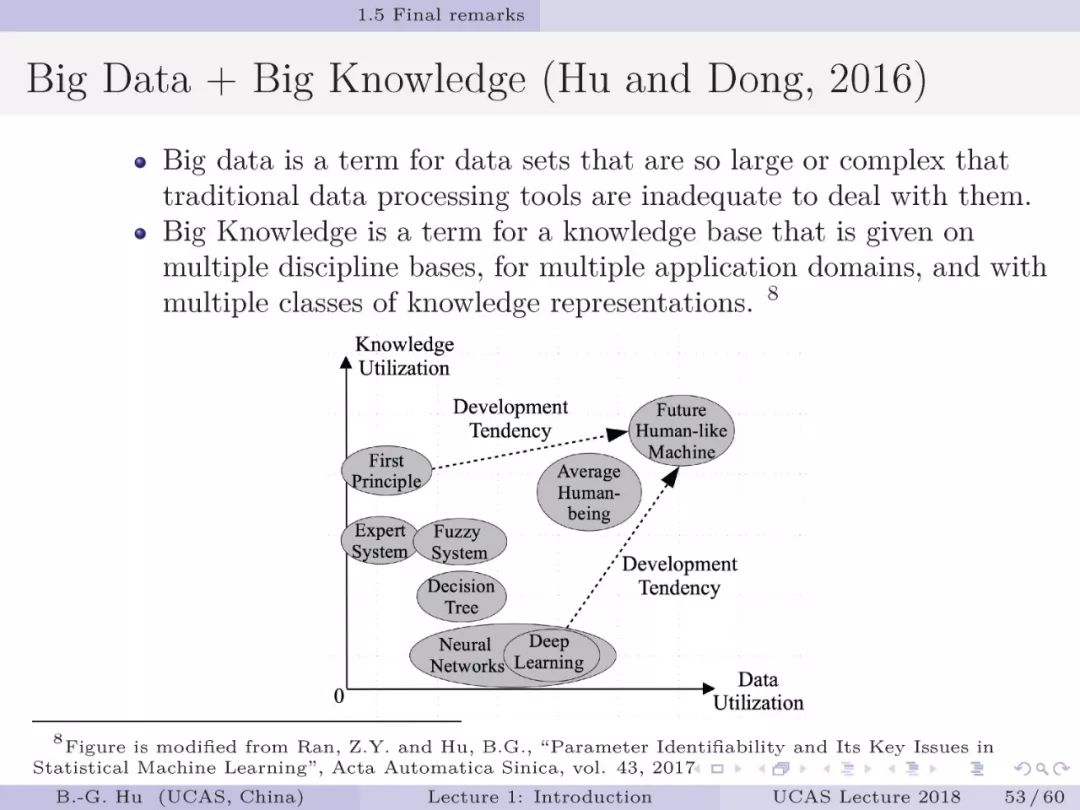

第40-48页: 人工智能与机器学习发展还应从数学层面考察,比如是否带来新的数学问题?在此给出一个实例是“广义约束”。介绍了该实例的“源”与“流”。虽然提出很早了,但是广义约束对未来研究张开了一个“新”的数学空间“,且比传统常规约束提出了更多挑战问题。我认为世界上许多因果或相关性结局是可以由未知或部分已知的广义约束来解释的。大数据下的广义约束学习会成为人工智能可解释性研究中的重要内容。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“ITML2020” 就可以获取《国科大UCAS《信息论与机器学习》课件》专知下载链接