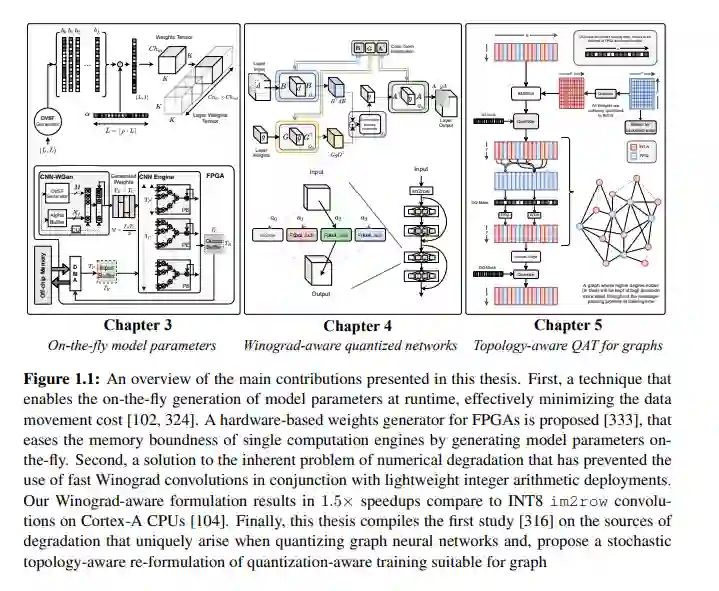

【牛津大学博士论文】基于资源约束平台的高性能深度学习,173页pdf

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“HDLC” 就可以获取《【牛津大学博士论文】基于资源约束平台的高性能深度学习,173页pdf》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年12月5日