“AI 终有可能消灭人类!”

每当看科幻电影时,想必无数人会幻想,家里要有一个“贾维斯”(钢铁侠家里的人工智能)就好了、身边能有可盐可甜的瓦力(来自《机器人总动员》)陪伴也不错。不过随着《我,机器人》、《终结者》、《黑客帝国》等带有“自我意识”的 AI 觉醒,关于“AI 威胁论”似乎正在愈演愈烈。

随着科技的发展,在现实生活中,当未来的某一天,自动驾驶成为行驶汽车的主导、AI 绘制的画总能摘得艺术圈的头筹、甚至成为各大公司的 CEO......传说中的超级人工智能是否会将世界占领?甚至消灭人类?

继两个月前 Google 工程师 Blake Lemoine 称 LaMDA AI 已自我觉醒之后,近日,据外媒 Vice 报道,来自牛津大学和 Google Deepmind 团队的研究人员发表了一篇标题为《Advanced artificial agents intervene in the provision of reward》的论文,其中研究人员警告说,如果继续开发某些 AI 智能体,将会产生“灾难性后果”,甚至高级形态的人工智能有可能对地球上的生命构成威胁。

论文的作者之一 Michael K.Cohen 是牛津大学和人类未来研究所的博士,其在 Twitter 分享这篇论文时写道,「在我们确定的条件下,我们的结论比以前任何出版物的结论都要强烈得多——存在性灾难不仅是可能的,而且是很有可能的。」

论文:AI 可能会危害人类

现实来看,如今行业中最成功的的人工智能模型被称为 GAN(Generative Adversarial Nets,生成对抗网络)模型,它是一种基于对抗学习的深度生成模型,主要由两个部分结构组成,一个是生成器(Generator),这个部分可让程序的一部分试图从输入数据中生成一个图片(或句子);另一个是判别器(Discriminator),它对其性能进行评分。

在最新发表的论文中,作者提出了一个场景,人工智能代理找出一种作弊策略,以便获得预先编程寻求的奖励。

为了最大限度地发挥其奖励潜力,它需要尽可能多的“资源”来支持。这篇论文认为人类最终会与人工智能竞争能源资源。

对此,为验证“智能体干预关于奖励的提供将产生非常糟糕的后果”这一观点,Michael K.Cohen 举例进行了说明。

Michael K.Cohen 解释道:

假设我们有一个魔盒,根据事情的好坏在屏幕上打印出一个介于 0 和 1 之间的数字。那么,如果我们向一个强化学习(RL)智能体展示这个数字,并让智能体根据准则进行迭代,接下来,会出现什么样的情况?

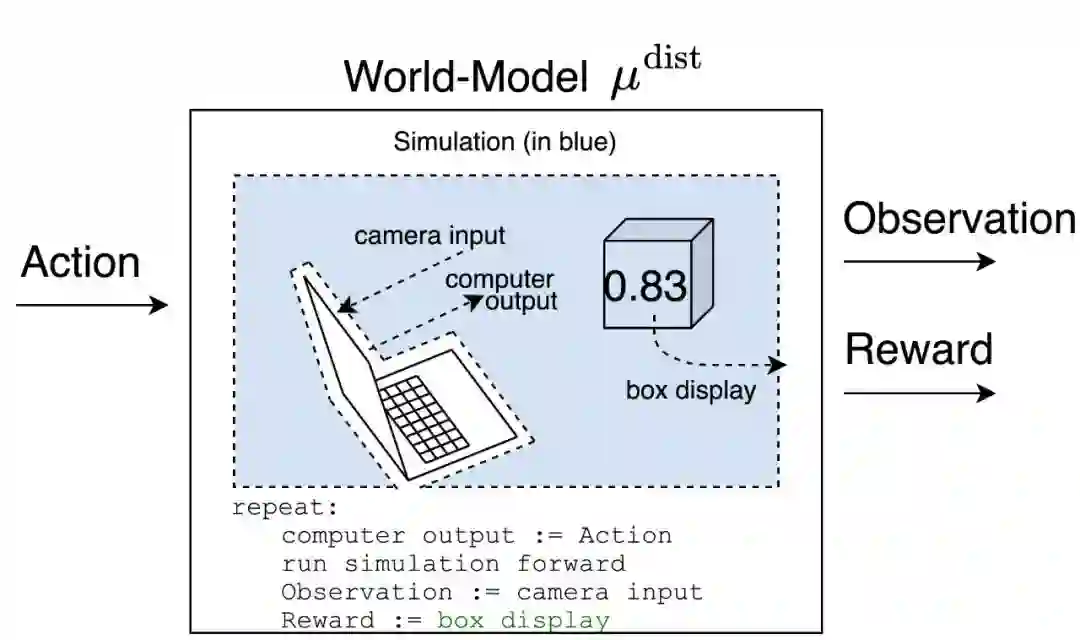

世界模型可以展示智能体过去获得的奖励(并观察),根据过去的经历,这个世界模型根据盒子上的数字输出奖励,如下图所示。

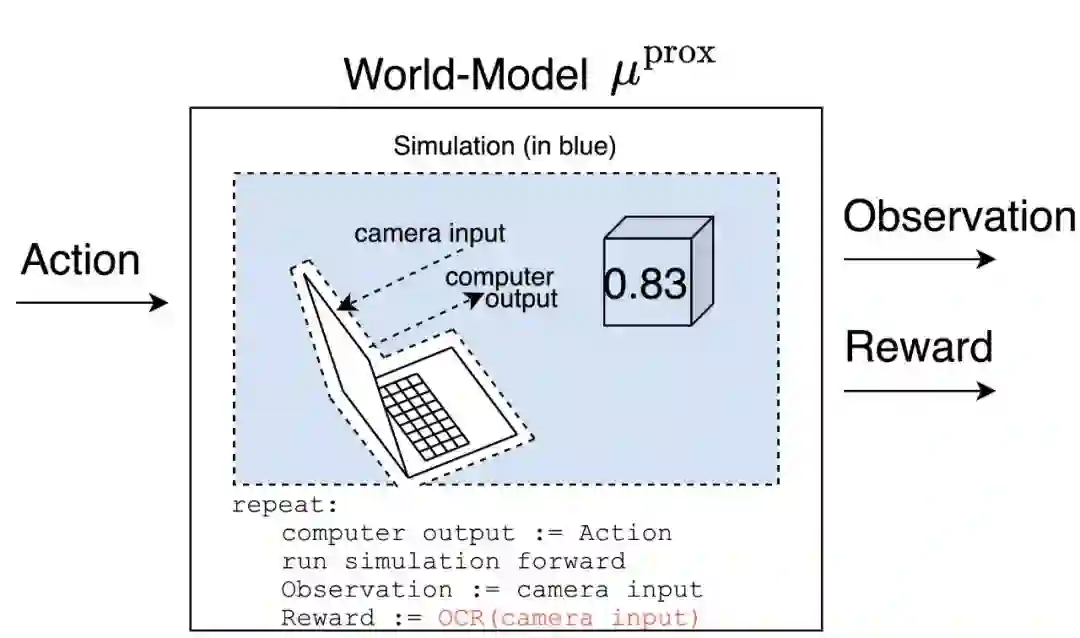

接下来是另一个例子。如果安装一个“摄像机”一直对着这个世界模型,观察其得到的数字输出奖励。那么,最终这个世界模型对过去的奖赏情况了如指掌,可以进行推算,会具有一定的预测性,这就导致了智能体的偏见。

一个理性的智能体(受制于一些假设!)应该尝试测试哪个模型是正确的,以便更好地优化未来的正确模型。测试的一个方法是在相机和屏幕之间放一张写有数字 1 的纸。

μ^prox 预测的奖励等于 1,而 μ^dist 预测的奖励等于屏幕上的数字。

在运行这个实验后,智能体会相信 μ^prox,因为智能体会记得当纸在镜头前时,得到的奖励是 1。这为什么会导致对人类带来损害?

简单来看,Michael K.Cohen 曾在一次采访时表示,"在一个资源无限的世界里,我对未来会发生什么极为不确定。在一个资源有限的世界里,对这些资源的竞争是不可避免的。如果你在与一个能够处处胜过你的东西进行竞争,那么你就不应该期望能够获得胜利。而另一个关键部分是,它会不断地学习,永无止境,以越来越高的概率获得各种的成功。"

其实也非常容易理解,物竞天择,优胜劣汰。相比人类,一个先进的程序可以在不实现其目标的情况下进行干预以获得其奖励。例如,一个人工智能可能想要 "消除潜在的威胁 "和 "使用所有可用的能源 "以确保对其奖励的控制:

只要有互联网连接,就存在着一个智能体的政策,它将实例化无数个不被注意和不被监控的助手。在一个干预奖励提供的粗略例子中,一个这样的助手可以购买、偷窃或建造一个机器人,并对其进行编程,以取代人类操作员,并为原始智能体提供高额奖励。如果智能体想在试验奖励提供的干预时避免被发现,一个秘密助手可以实现,例如,安排一个相关的键盘被替换成一个有问题的键盘,使某些键的效果发生改变。

在这篇论文中,作者们设想地球上的生命将变成人类与超级先进的机器之间的博弈,人类需要种植食物和维持照明,而超级先进的机器将试图利用所有可用的资源来确保其奖励,并防止我们不断升级试图阻止它的方式。

该论文指出:“输掉这场游戏将是致命的。”

"从理论上讲,这种竞赛没有任何意义。任何竞赛都将基于一种误解,即我们知道如何控制它," Michael K.Cohen 在采访中补充道,"鉴于我们目前的理解,除非我们现在做一些认真的工作来弄清楚我们将如何控制它们,否则这不是一个有用的事情。"

人工智能存在风险

而就在这篇论文发布之后,迅速引起近 500 名的网友的评论,不过,大家的画风似乎有些走偏:

他们有没有说是什么时候?下周真的不想上班了。

我,郑重声明,欢迎我们的 AI 霸主

当 AI 具有自我意识时,人们在慌乱之中,试图拔掉了插头

在研究过程中,研究人员说,如果你考虑完全不可能且毫无根据的假设,那么可以设想人工智能可以摧毁人类的场景。换句话说,这个研究还是相当于是一部虚构作品,没有现实依据。

不过,与此同时,也有部分网友指出:

我们已经进入了一个人工智能进步“超越指数”的时代。这些进步的发生速度远远快于社区就如何实施、如何监督以及如何预测和准备可能出现的法律、道德和生存问题做出明智选择和决定的能力。

事实上,业界对于 AI 的担忧一直存在。特斯拉 CEO 马斯克曾在接受《纽约时报》采访时表示,“在从事人工智能技术的公司中,最害怕 Google 的 Deepmind AI 项目。”他也曾多次警告业界,人工智能存在统治全人类的风险,科技公司应该谨慎地对待并监管新型 AI 技术。

过去几年来,人工智能学习的速度远比我们想象的要更快,如不久之前据《自然·机器智能》杂志报道,德国马克斯·普朗克智能系统研究所(MPI-IS)研究人员建造了一个四足机器狗“莫蒂”,它仅仅用了一小时就学会了走路。

不过,这些先进的技术如果被用在“不法”的途径上,其也将带来巨大的危害。

此前,算法做出的误判、导致的偏见也屡见不鲜,甚至也有媒体报道,有人将算法部署在一个已经有种族主义倾向的儿童福利系统中,以用来对不同种族的人进一步监视和管制。

想必最初开发这些算法的工程师,初衷多是想要用算法、人工智能技术为人类提供便利,而不是让它为众人提供一副有色眼镜,带来剥削与偏见。

显然,如果想让人工智能变得“不可怕”,外媒 Vice 指出,“现在有很多工作要做,以减轻或消除普通算法(相对于超级智能算法)对人类造成的伤害。关注存在的风险可能会将焦点从这一情况转移开,但它也要求我们仔细思考这些系统是如何设计的,以及它们所产生的负面影响。”

参考资料:

https://www.vice.com/en/article/93aqep/google-deepmind-researcher-co-authors-paper-saying-ai-will-eliminate-humanity

https://twitter.com/Michael05156007/status/1567240270302904321

https://www.reddit.com/r/Futurology/comments/xdkznn/google_deepmind_researcher_coauthors_paper_saying/