DeepMind提出机器心智理论神经网络ToMnet,让机器思考与互相理解

作者:Neil C. Rabinowitz等

AI不仅需要判断,也需要具备思考问题的能力。真正的人工智能应该和人类一样,可以理解自己以及周围智能体的心理状态,这些状态包括情绪、信念、意图、欲望、假装与知识等。DeepMind近日提出的「机器心智理论」神经网络ToMnet让计算机拥有了这种能力,这或许是我们在人工智能技术上的一次重要进步。

论文:Machine Theory of Mind

论文链接:https://arxiv.org/abs/1802.07740

摘要:心智理论(ToM; Premack & Woodruff, 1978)广义上指个体有能力理解他人的心理状态,包括期望、信念和意图。我们提出对机器进行训练,使之也具备这项能力。DeepMind设计了一种心智理论神经网络ToMnet,它使用元学习通过观察智能体的行为而对它们进行建模。通过该过程,该网络得到一个对智能体行为具备强大先验知识的模型,同时能够利用少量行为观测对智能体特征和心理状态进行更丰富的预测。DeepMind将ToMnet应用于在gridworld环境中采取动作的智能体,结果表明该网络学会对来自不同群体的智能体进行建模,包括随机、规则系统和深度强化学习智能体等,该网络通过了经典的ToM任务,如"Sally-Anne"测试,即意识到他人持有的错误观念。DeepMind认为该系统(自动学习如何对出现在其世界中的其他智能体进行建模)是开发多智能体AI系统的重要步骤,可以帮助构建人机交互的中介技术,推进可解释性AI的发展。

简介

对于现在所有的深度学习和深度强化学习方法而言,人们有一个担忧的问题:从某些方面来说,我们对这些系统的理解非常有限。神经网络经常被说成是难以理解、难以解释的黑箱子。即使我们对其权重有完整的解释,还是很难掌控它们到底利用了什么模式,也很难掌控哪里会出问题。随着智能体进入人类世界,要求理解这些系统的声音变得越来越大。

让我们先停下来,思考另一个问题:「理解」另一个智能体到底意味着什么?作为人类,我们每天都在面临这项挑战,我们与他人交流合作,但几乎无法触及这些人的内隐特征、内隐状态和计算过程。但我们还是用卓越的熟练度来行使职责。我们可以预测陌生人将来的行为,并且推断他们对世界的观点;我们规划与其他人的互动,并且建立高效的交流。

能够「理解」其他智能体的一个显著特征是极少甚至不引用智能体真正的基础构架。我们没有试图去预测其他神经的活动,推断他们的前额皮质的连通性,或者计划与一个非常详细的其他人的海马体图的预测的交互。从认知心理学延伸出的一个突出的讨论是我们的社会推理(social reasoning)并不是依赖于其他媒介的高层次的模型(Gopnik & Wellman, 1992)。这些模型用了一些没法解释表面现象背后原理的抽象概念;相反,我们表示了其他人的精神状态,比如他们的欲望、信仰和意图。这个能力一般被解释成我们的心智理论(Premack & Woodruff, 1978)。在一些案例中我们也让自己的意识来模仿其他人(比如 Gordon, 1986; Gallese & Goldman, 1998),我们对其智能体的终极理解并不是从把我们的模型与真理一一对应从而测量出来的,而是从这些模型会对比如说预测或者计划这种任务付出多少来决定(Dennett, 1991)。

在这篇文章里,来自DeepMind的研究人员受到了人类心智理论的启发,试图建立一个模拟其他介质的模型。我们把这个描述成机器心智理论。我们的目标不是去确保生成一个介质行为与内含转化的算法的模型。与之相反,我们专注于一个观察者怎样能自动的学习怎样利用有限数据模拟其他介质的模型(Botvinick et al., 2017)。正是这一点让DeepMind的新研究有别于前人方向,也就是那些依赖于用其他介质手工制造的模型作为有噪声的对比对象——比如用反向阻耗(Ng et al., 2000; Abbeel & Ng, 2004),贝叶斯推理(Lucas et al., 2014; Evans et al., 2016),贝叶斯心智理论(Baker et al., 2011; Jara-Ettinger et al., 2016; Baker et al., 2017)或者博弈论(Camerer et al., 2004; Yoshida et al., 2008; Camerer, 2010; Lanctot et al., 2017)。与以上研究不同,我们学习了代理模型,然后学习了怎样从通过元学习从头推理它们。

建立一个丰富的,灵活的而且高效绩的机器心智理论也许是一个大挑战。我们没有试着去在这里解决所有问题。一个主要的信息是当这些问题被正确表述的时候,很多初始的,建立机器心智理论(ToM)的挑战可以被分解成简单的学习问题。我们这里的工作是找出这些简单的构想方式。

DeepMind称,新研究有很多潜在的应用方向。学习其他的丰富的模型可以提高多智能体任务中的决策,尤其是基于模型的规划和想象所需要的(Hassabis et al., 2013; Hula et al., 2015; Oliehoek & Amato, 2016)。这样的模型对于数据校准(HadfieldMenell et al., 2016)和灵活合作(Nowak, 2006; Kleiman-Weiner et al., 2016; Barrett et al., 2017; Kris Cao)是很重要的,并且很有可能是未来机器决策中的道德的重要组成部分(Churchland, 1996)。它们也是对通讯和教育学非常有用的(Dragan et al., 2013; Fisac et al., 2017; Milli et al., 2017),也非常可能在人机交互领域扮演重要角色。探索这些能力之下的条件也可以阐明人类能力的起源(Carey, 2009)。最后,这样的模型也会是人类理解人造智能体的重要介质。

最后,我们被理解人造智能体这一目标所激励。这里我们有一个新奇的方法:除了从结构上改编智能体来把它们的内部状态以人类理解的形式暴露出来,我们追寻制造可以降低行为空间维度并且能以更易懂的形式表现的中间系统。从这个角度,追求机器心智理论(ToM)是建造缺失的机器与人的期望之间的交互界面(Cohen et al., 1981)。

DeepMind的新方法

DeepMind认为,构建心智理论的挑战本质上在于元学习问题(Schmidhuber et al., 1996; Thrun & Pratt, 1998; Hochreiter et al., 2001; Vilalta & Drissi, 2002)。在测试时,我们希望遇到一个以前没见过的智能体,并且它们已经对自身的行为方式有一个强大且丰富的先验知识。此外,在我们看到该智能体在现实中的行动时,我们希望能收集它们的隐藏特性和精神状态数据(构成后验知识),这有助于我们预测它们未来的行为。

为此,我们定制了元学习任务。我们构建了一个观察者,它在每一个episode都能访问一组新型智能体的行为轨迹,观察者的目标是预测智能体未来的行为。在训练过程中,观察者应该从有限数据中快速形成新智能体的的预测。这种新智能体的「学习如何学习」通常可以称为元学习。通过这个过程,观察者还应该学习智能体行为的有效先验知识,这些知识隐含地捕捉了训练空间中智能体间的共同点。

DeepMind引入了两个概念来描述该观察者网络及其功能角色。我们区分两个一般心智理论,即网络的预学习权重与特定智能体心智理论。在网络的预学习权重中,它包含了训练集中所有智能体一般行为的预测。而在特定智能体心智理论中,从单个智能体在测试时的察形成「agent embedding」,它包含了使得智能体的特性和精神状态区别于其它智能体的内容。这些对应于智能体行为的先验知识和后验知识。

本论文的结构是一系列在机器心智理论网络(我们称之为ToMnet)的实验,它们的复杂度是递增的。这些实验展示了ToMnet背后的思想和能力,并展示了它学习其他智能体丰富模型的能力,其中包含了人类心智理论的典型特征,如对错误信念的认识等。

本论文中的一些实验直接受到Baker及其同事在贝叶斯心智理论研究成果的启发,例如经典的food-truck实验(Baker et al., 2011; 2017)。由于该项工作的目标不同,我们并没有试图直接复制这些实验。特别的,我们并不是立即利用计算项搜索人类判断的解释,而是强调机器学习、可扩展性和自主性。我们将在未来的工作中解释人类的判断。我们的实验应该推广至许多先前实验的构造以适应我们的目标。

本研究的主要贡献包括:

章节3.1中,我们展示了对简单、随机的智能体而言,ToMnet能学习逼近贝叶斯优化的层级推理到智能体的特性;

章节3.2中,我们展示了ToMnet学习推理算法智能体的目标(有效完成了 few-shot 逆强化学习),以及它们如何平衡成本与奖励。

章节3.3中,我们展示了ToMnet学习表示不同类型的深度强化学习智能体,掌握深度强化学习智能体不同变体的关键元素,并组成这些智能体的抽象嵌入(abstract embeddings)。我们也展示了ToMnet能发现行为空间新的抽象。

章节3.4中,我们展示了当在POMDP中活动的深度强化学习智能体上训练ToMnet时,它暗中学习到这些智能体能持有该世界的错误信念,这也是人类心智理论的核心。

章节3.5中,我们展示了能够训练ToMnet来预测智能体的信念状态,明确揭开智能体的错误信念。我们也展示了ToMnet能单独从行为中推断什么智能体具有观看的能力,以及因此它们倾向于相信什么。

图 1. ToMnet 架构。

character net从POMDP集合中解析智能体过去的轨迹,从而形成character嵌入 e_char。心理状态网络解析当前片段的智能体轨迹,形成心理状态嵌入e_mental。然后,这些嵌入被输入至预测网络,可用于查询当前状态。预测网络输出对智能体未来行为的预测,如下一步动作概率π hat、特定对象被消耗的概率c hat和预测后继者表示SR hat(Dayan, 1993)。

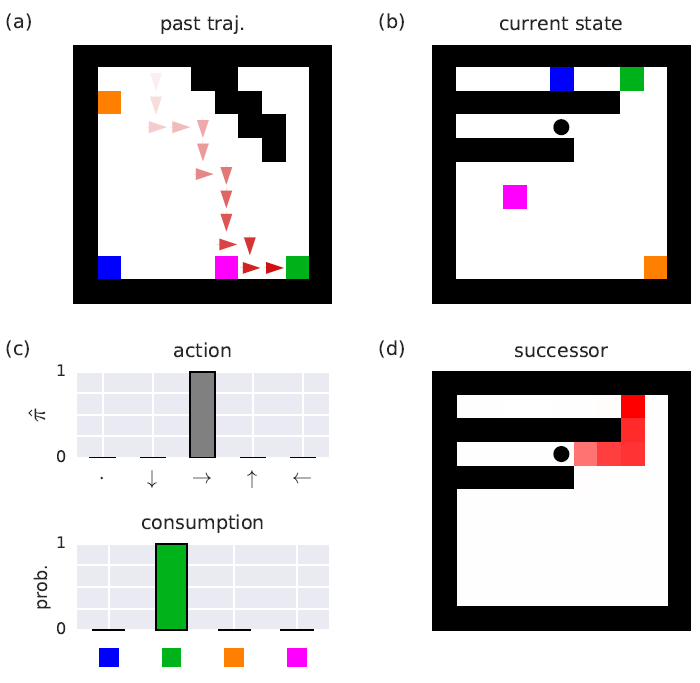

图 4. 目标驱动智能体上的 ToMnet。

(a)示例智能体之前的轨迹。彩色方块代表四个对象。红色箭头表示智能体的位置和动作。(b)查询示例:来自新MDP的状态。黑点代表智能体位置。(c)基于(a)中对之前轨迹的观测,针对(b)中的查询MDP,ToMnet对智能体下一个动作的预测(上方)和对该片段结束时对象是否被消耗的预测(下方)。(d)ToMnet使用折扣因子γ = 0.9,对(b)中查询的后继者表示(successor representation,SR)的预测。黑色部分表示更高的期望折扣状态占用。

图 7. 使用ToMnet描述训练的神经网络智能体。

(a)ToMnet的三个组件分别对应三个行为预测目标,图中表示简单ToMnet与没有character net或没有mental net的网络的对比。长条越长越好;具备character net和mental net的网络最好。(b)查询POMDP状态在时间t=0时,ToMnet对智能体未来状态占用的预测(左),如图4d所示。星星表示子目标。右边的三幅图根据每个亚种的示例智能体在N_past = 5 past POMDPs上的行为输出(示例智能体通常指粉色对象)。ToMnet事先并不了解每个智能体属于哪个亚种,但是可以根据智能体之前的行为推断出来。

图 13. 信念的监督式预测。

📚往期文章推荐

🔗5年发51篇SCI论文的川大博士,数量上超过很多教授一辈子的发文

🔗他是中国第一个汽车院士,他的学术生涯从“红旗”开始,穷尽一生只为汽车

🔗一边睡觉一边讨论学术的双料院士:将突发性睡病化为成就之源的乔治·丘奇

🔗华人银行被美国政府当替罪羊,这位老华侨花1000万美元誓死反击

🔗中国在国际顶级学术期刊上发表文章的第一人,一生挽救了无数国人的性命

🔗2018一起拥抱AI丨潘云鹤院士:中国新一代人工智能(PPT图文实录)

🔗他是“90后”青千,25个SCI期刊的审稿人,最大的爱好是科研!

德先生公众号 | 往期精选

在公众号会话位置回复以下关键词,查看德先生往期文章!

人工智能|机器崛起|区块链|名人堂

虚拟现实|无人驾驶|智能制造|无人机

科研创新|网络安全|数据时代|人机大战

……

更多精彩文章正在赶来,敬请期待!

点击“阅读原文”,移步求知书店,可查阅选购德先生推荐书籍。