【AAAI2021】Co-GAT:一种用于联合对话行为识别和情感分类的协同交互图注意力网络

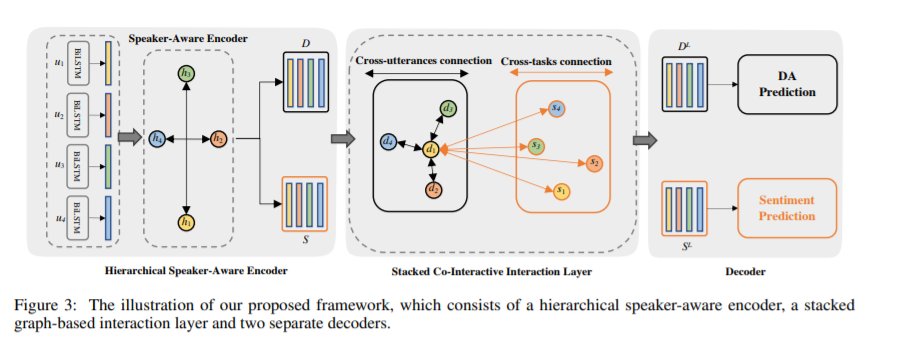

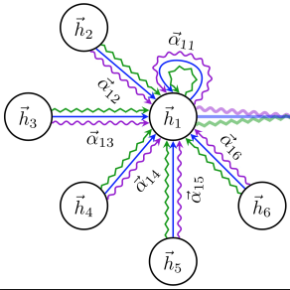

在对话系统中,对话行为识别和情感分类是捕获对话者意图的两个相关任务,其中对话行为可以捕获显式的意图,情感可以表达隐性的意图。其中上下文信息(contextual information)和相互交互信息(mutual interaction information)是这两个相关任务的关键因素。但是,现有方法都无法同时考虑这两个重要的信息。为了解决这个问题,在本文中,我们提出了一个协同交互图注意力网络(Co-GAT)来联合建模这两个任务。核心模块是我们提出的协同交互图交互层,可以在统一的图网络中构建跨历史连接(cross-utterances connection)和跨任务连接(cross-tasks connection)。我们的模型在两个公开的数据集达到了SOTA性能。此外,我们发现上下文和相互交互信息的贡献与预训练模型并不完全重叠,在多种预训练模型上(BERT,RoBERTa,XLNet)均取得了性能提升。

https://www.zhuanzhi.ai/paper/7d3e71694898473073a4c7382ea5c83c

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“CGAT” 可以获取《【AAAI2021】Co-GAT:一种用于联合对话行为识别和情感分类的协同交互图注意力网络》专知下载链接索引

登录查看更多

相关内容

Arxiv

5+阅读 · 2018年4月3日