SIGIR主席公开信回应抄袭事件:正调查但无法撤稿,已联系Reddit锁帖

新智元报道

【新智元导读】论文抄袭乃学术大忌,前段时间传闻有一篇SIGIR 2019的论文抄袭了一篇RecSys 2018的论文,在Reddit上炸开了锅,连SIGIR主席Ben Carterette也被惊动了。他代表SIGIR发了一封公开信回应该事件,表示正在调查,对公开匿名指控不予回应,并号召大家不要参与Reddit上的公开讨论。你怎么看,来新智元 AI 朋友圈说说你的观点~

-

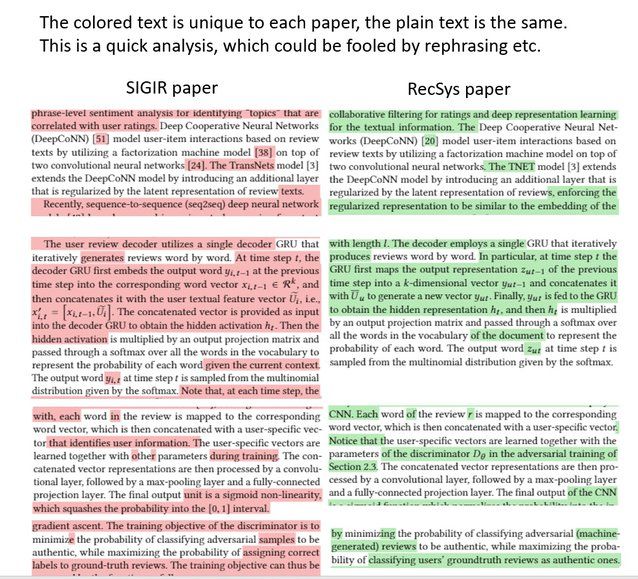

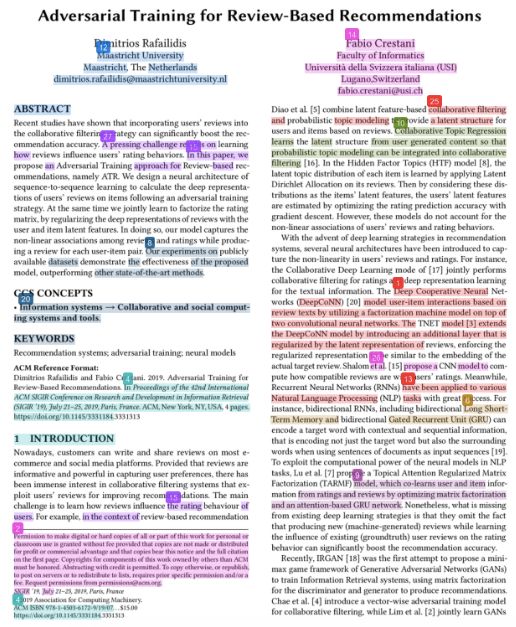

两篇论文都使用了矩阵分解框架上的对抗性序列到序列学习模型。 -

对于生成器和判别器部分,两篇论文都使用GRU作为生成器,使用CNN作为鉴别器。 -

优化方法相同,即两部分交替优化。 -

评估相同,即评估MSE的推荐性能和评估判别器的准确性,以表明生成器已经学会生成相关的评论。 -

这两篇论文所用的符号和公式看起来极其相似。

-

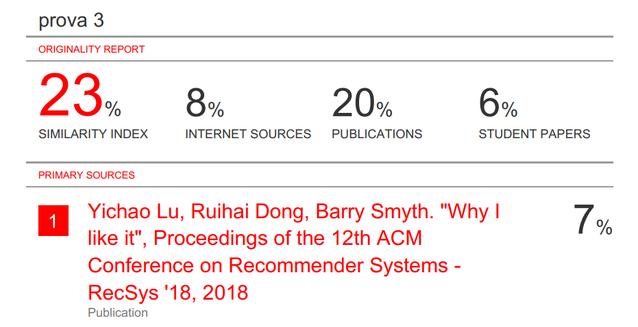

重新进行发布前检查。经验证,本文没有触发任何发布前检查中的抄袭警报。 -

我们对论文进行了重新审阅。这是为了确定我们向ACM提交标记的论文部分,ACM不会接受匿名报告。 -

在Reddit上发帖,告知其他人ACM官方政策和程序,并邀请任何希望举报抄袭的人。 -

要求Reddit版主锁定原帖。 Reddit论坛需要遵循其社区标准,原贴内容似乎不符合该标准。截止本文发布时,该贴尚未锁定。 -

亲自与ACM出版委员会联席chairman取得联系。该团队负责处理抄袭指控。他重申,我们唯一可以采取的正式行动就是提出声明。 -

撰写一份正式声明。此事我正在与ACM联系,但是我无法谈论细节。

登录查看更多

相关内容

Arxiv

10+阅读 · 2019年9月5日

Arxiv

11+阅读 · 2018年12月6日