人类大脑并不是很大,却承载着所有的计算任务。出于这一原因,许多研究者开始对创建模拟大脑神经信号处理的人工网络感兴趣。这种人工网络被称为脉冲神经网络(spiking neural networks, SNN)。

脉冲神经网络最早由 Maass 教授于 1997 年提出,它是基于大脑运行机制的新一代人工神经网络,被誉为第三代神经网络模型。它是目前最接近类脑计算水平的一类生物启发模型,具有可处理生物激励信号以及解释大脑复杂智能行为的优势。

SNN 旨在弥合神经科学和机器学习之间的差距,使用最拟合生物神经元机制的模型来进行计算,它与目前流行的神经网络和机器学习方法有着根本上的不同。

SNN 使用脉冲,这是一种发生在时间点上的离散事件,而非常见的连续值。每个峰值由代表生物过程的微分方程表示出来,其中最重要的是神经元的膜电位。本质上,一旦神经元达到了某一电位,脉冲就会出现,随后达到电位的神经元会被重置。

然而,大脑有 1000 亿个微小神经元,每个神经元通过突触与其他 10000 个神经元相连,这些神经元通过协调的电峰值模式来表示信息。事实证明,在一个紧凑的设备上使用硬件来模拟这些神经元,同时还要确保以一种节能的方式进行计算,非常具有挑战性。

在最近的一项研究中,来自孟买理工学院的研究者实现了超低功耗人工神经元,允许 SNN 排列更紧凑。

论文地址:https://ieeexplore.ieee.org/document/9782075

就像大脑中的神经元,超出能量阈值会出现脉冲信号,SNN 依赖于人工神经网络,其中电流源为 leaky 电容器充电,直到达到阈值水平,人工神经元 fires,之后存储的电量重置为零 。然而,现有的 SNN 需要大的晶体管电流来为其电容器充电,这导致了高功耗,以及人工神经元 fire 过快。

在该研究中,孟买理工学院的 Udayan Ganguly 教授和他的同事合作创造了一种 SNN,这种 SNN 依赖于一种新的、紧凑的电流源来为电容器充电,这种电流源被称为 BTBT( band-to-band-tunneling current)。

在 BTBT 中,量子隧穿电流以极低的电流使电容器充电,这意味着所需的能量更少。BTBT 方法还省去了用较大电容来存储大量的电流,为芯片上更小的电容铺平了道路,从而节省了空间。

研究人员使用 45 纳米商用绝缘硅片晶体管技术对 BTBT 神经元方法进行测试,结果显示这种方法节省了大量的能源和空间。同时,他们宣布了一种新的低功耗 AI 芯片,它可以实现所谓的脉冲神经网络。

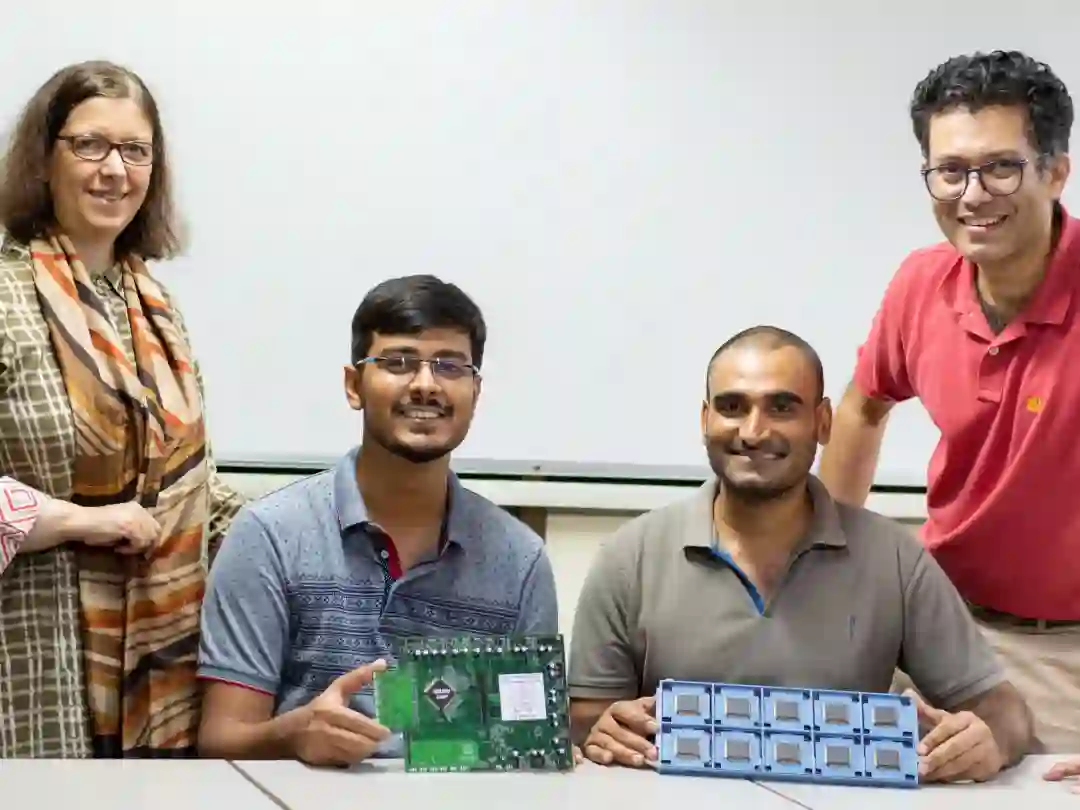

孟买理工学院研究者,包括 Maryam Shojaei Baghini(左一) 和 Udayan Ganguly(右一) 教授

与在硬件脉冲神经网络中实现的 SOTA [人工] 神经元相比,该研究在相似区域实现了 5000 倍的每个脉冲能量降低,并且在相似的区域和每个脉冲的能量降低了 10 倍,Ganguly 解释。

研究人员将 SNN 应用于语音识别模型,该模型使用 20 个人工神经元作为初始输入编码,还额外使用了 36 个人工神经元,该模型能够有效的识别口语,从而验证了该方法在现实世界中的可行性。

这项技术适用于语音活动检测、语音分类、运动模式识别、导航、生物医学信号、分类等等。虽然这些应用程序可以通过当前的服务器和超级计算机完成,但 SNN 可以使这些应用程序与边缘设备一起使用,比如手机和物联网传感器,尤其是在能源紧张的情况下。

Ganguly 表示,他的团队已经展示了 BTBT 方法对特定应用程序(例如关键字检测)有用,他们的目标是创建一个极低功耗的神经突触核心,并开发一种实时片上学习机制,这一技术是实现自主仿生神经网络的关键。

https://spectrum.ieee.org/low-power-ai-spiking-neural-net

https://jishuin.proginn.com/p/763bfbd6cfac

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com