【AAAI2022】不确定性感知的多视角表示学习

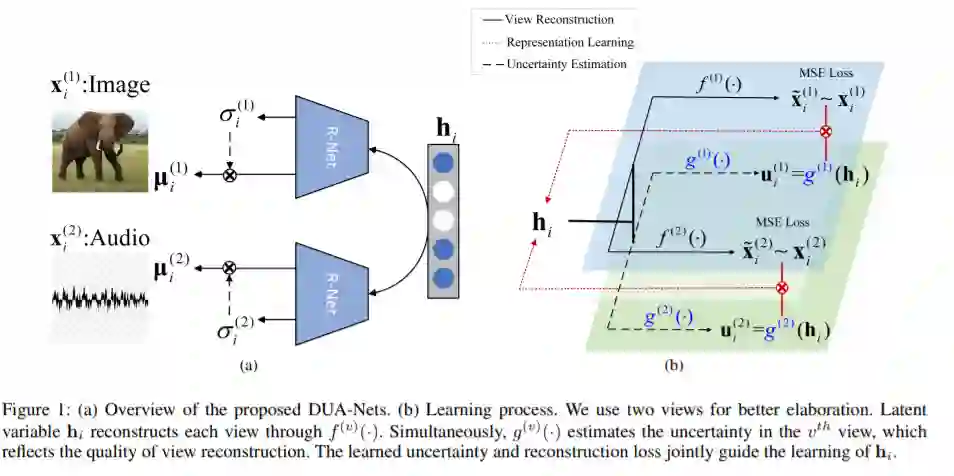

从不同的数据视图中学习,探索它们之间潜在的互补信息,可以使表示具有更强的表达能力。然而,高维特征往往包含噪音,而且,数据的质量通常因不同的样本(甚至不同的视角)而不同,即,一个视图可能对一个样本提供信息,但对另一个样本却不是这样。因此,在无监督的情况下,整合多视角有噪声的数据是非常具有挑战性的。传统的多视角方法要么简单地将每个视角同等重要,要么将不同视图的权重调优为固定值,不足以捕获多视角数据中的动态噪声。在这项工作中,我们设计了一种新的无监督的多视角学习方法,称为动态不确定性感知网络(DUA-Nets)。在生成角度估计数据不确定性的指导下,集成了来自多个视图的固有信息,以获得无噪声表示。在不确定性的帮助下,DUA-Nets根据数据质量对单个样本的每个视图进行权衡,以充分利用高质量的样本(或视图),同时减轻噪声样本(或视图)的影响。我们的模型在大量的实验中取得了优异的性能,并显示了对噪声数据的鲁棒性。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“DUAN” 就可以获取《【AAAI2022】不确定性感知的多视角表示学习》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年4月16日