【专著】神经网络彻底改变 NLP 面貌,但远非终极解决方案

新智元编译

来源:morganclaypool.com

作者: Yoav Goldberg

编译:张易

新智元启动 2017 最新一轮大招聘: COO、总编、主笔、运营总监、视觉总监等8大职位全面开放。

新智元为COO和执行总编提供最高超百万的年薪激励;为骨干员工提供最完整的培训体系、高于业界平均水平的工资和奖金。加盟新智元,与人工智能业界领袖携手改变世界。

简历投递:jobs@aiera.com.cn HR 微信:13552313024

【新智元导读】Bar-Ilan University 计算机科学系的高级讲师 Yoav Goldberg 在他的专著《 NLP 的神经网络方法》中,不仅比较全面细致地介绍了神经网络模型在自然语言处理中的应用情况,并且在详尽梳理之后,明确指出:神经网络方法的引入已经成为 NLP 的变革力量,彻底改变了包括机器翻译在内的多项自然语言处理任务的面貌,但神经网络不是自然语言理解和生成的终极解决方案。虽然比前一代基于统计学的 NLP 技术提高了很多,然而核心问题仍然存在:语言是零散且模糊的,我们对其工作原理的理解并不够,而没有人类的指导,神经网络自身无法学习语言中所有的细微之处。

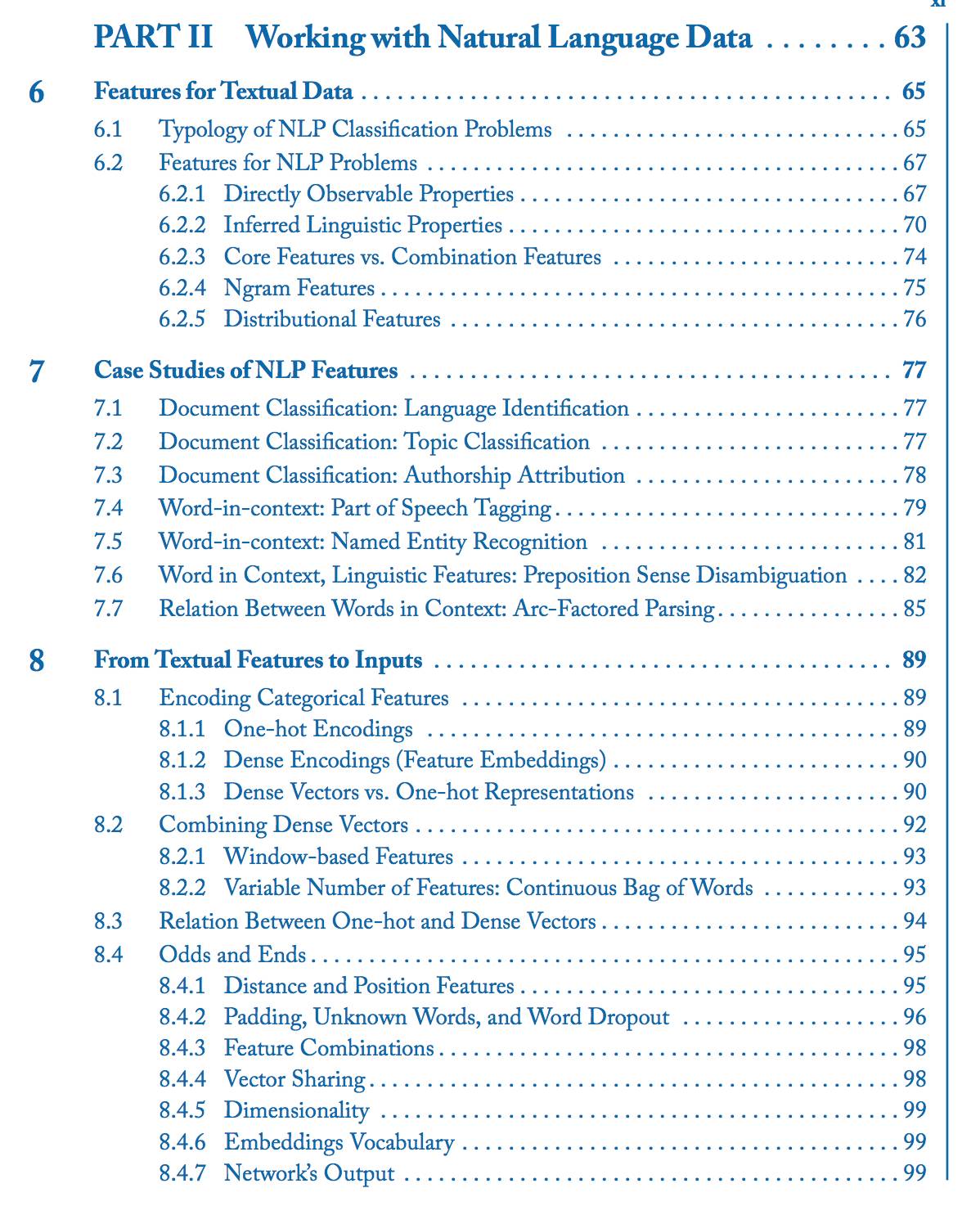

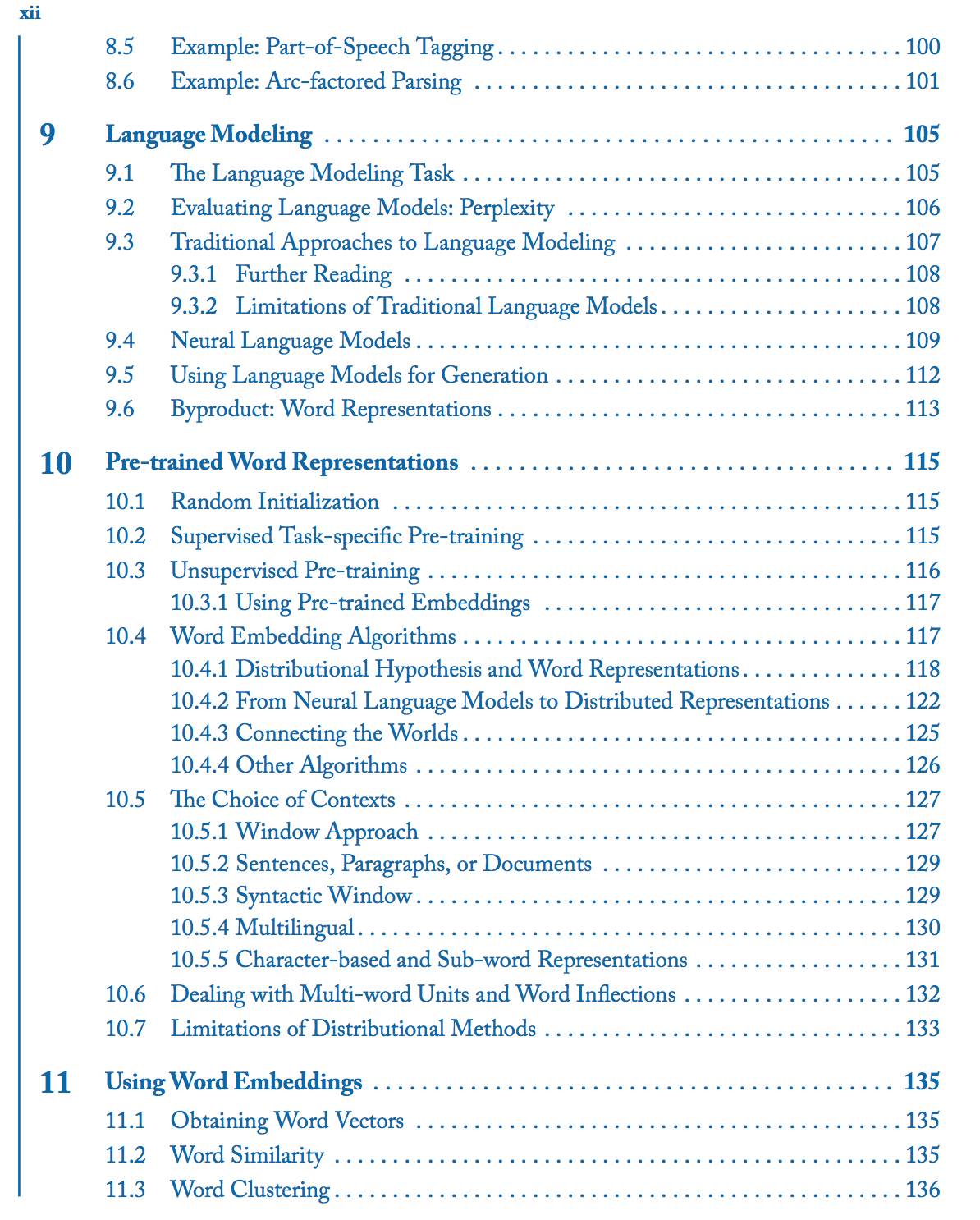

作为以色列 Bar-Ilan University 计算机科学系的高级讲师,Yoav Goldberg 已经专注于 NLP 领域 10 多年了。最近他正式出版了他 309 页的综述专著《 NLP 的神经网络方法》 。我们为您摘译了这本专著开头的“内容简介”和全书结尾“面对的挑战”两部分。最后附上了全书的目录,供您参考。

专著关键词:

自然语言处理,机器学习,有监督学习,深度学习,神经网络,词嵌入,循环神经网络,序列到序列模型

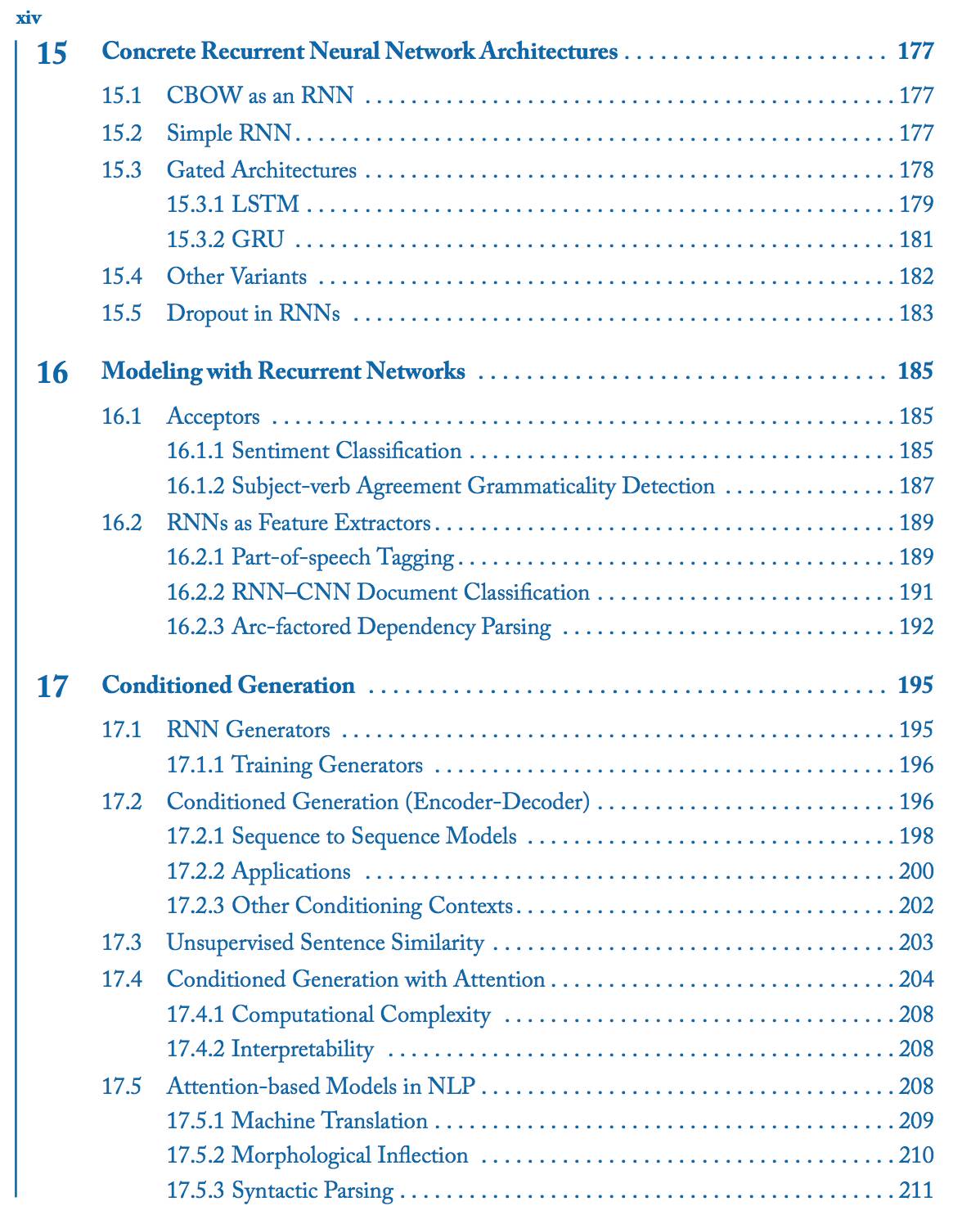

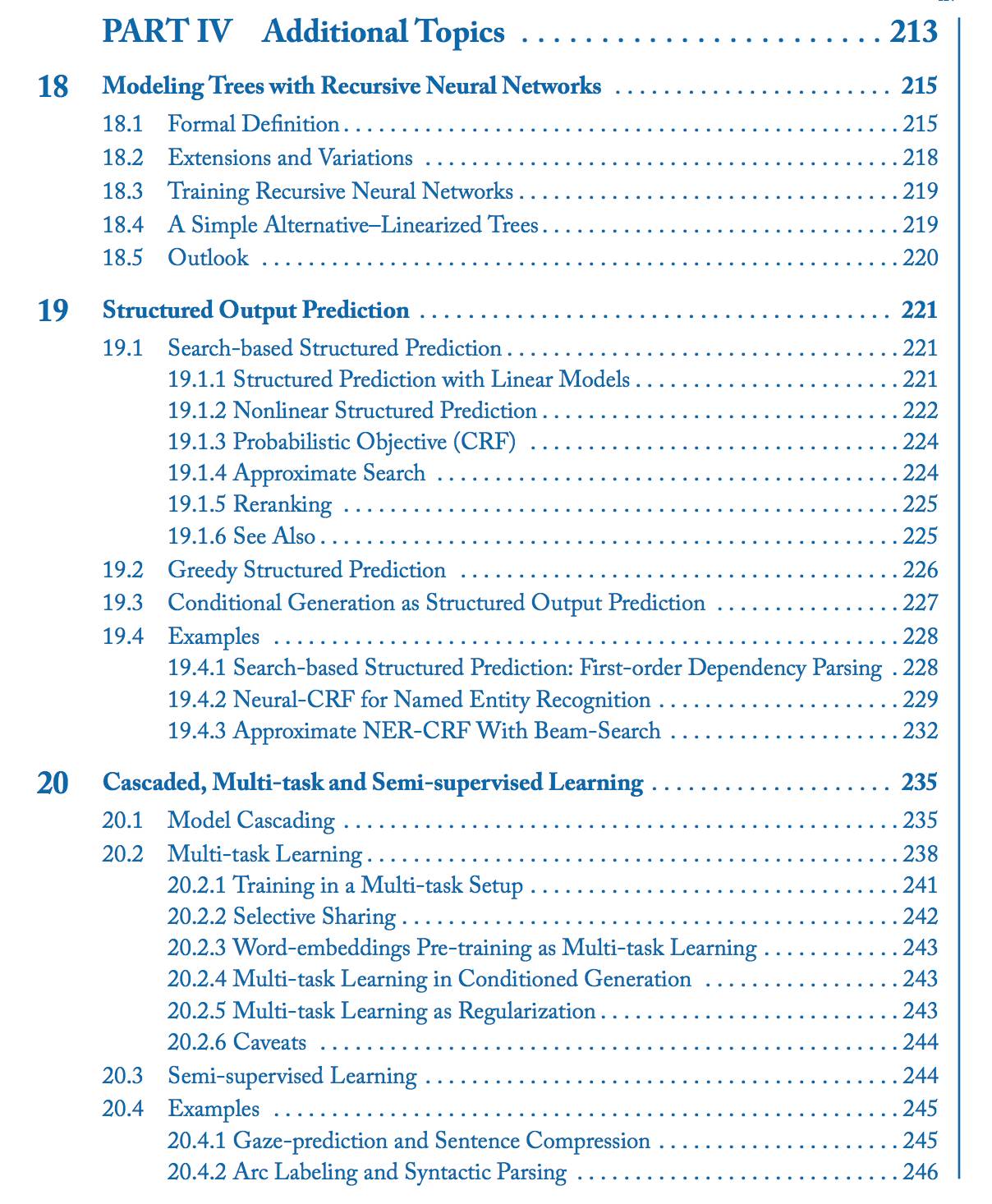

神经网络是机器学习模型中一个强大的家族。本书聚焦神经网络模型在自然语言数据上的应用。前半部分(第一部分和第二部分)涵盖了有监督机器学习和前馈神经网络的基础知识,使用机器学习处理语言数据的基础知识,以及基于向量而非符号的表示的使用,同时也包括了计算图提取,它允许轻松定义和训练任意神经网络,并且是当下神经网络软件库设计的基础。

本书的后半部分(第三部分和第四部分)介绍了更多的专门的神经网络架构,包括 1D 卷积神经网络、循环神经网络、条件生成模型和注意力模型。这些架构和技术是机器翻译、句法分析和其他许多应用程序背后最先进算法的推动力。最后,我们还讨论了树形网络、结构化预测和多任务学习的前景。

神经网络方法的引入已经成为 NLP 的变革力量。它促成了从带有重特征工程(特别是补偿和特征组工程)的线性模型到进行特征组学习的多层感知器的转移(如本书第一部分所述),到像卷积神经网络这样可以识别可泛化 ngrams 和 gappy-ngrams 的架构的转移(如第13 章所述),到像 RNN 和双向 RNN 这样可以识别任意长度序列中微妙模式和规律的架构的转移(第14-16 章),以及到可以表示树的递归神经网络的转移(第18 章)。它们还带来了基于分布相似性的将词编码为向量的方法——这对于半监督学习非常有效(第 10-11 章),以及非马尔可夫语言建模的方法——它为柔性条件语言生成模型铺平了道路(第 17 章),并彻底改变了机器翻译。神经方法也为多任务学习提供了许多机会(第20章)。更重要的是,预神经(pre-neural)结构预测技术可以很容易地适应于基于神经网络的特征提取器和预测器(第 19 章)。

总体来说,这一领域进展迅速,很难预测未来会发生什么。但在我看来,至少有一件事是很清楚的——神经网络不是自然语言理解和生成的终极解决方案。虽然比前一代基于统计学的 NLP 技术提高了很多,但核心问题仍然存在:语言是零散且模糊的,我们对其工作原理的理解并不够,而没有人类的指导,神经网络自身无法学习语言中所有的细微之处。

本书导言中提到的难题在神经技术中同样一直存在,而第 6 章中提到的对语言概念和来源的熟悉度,也始终和设计良好的语言处理系统一样重要。引入神经网络技术后,许多自然语言任务的实际表现——即使只是面对指代模糊和边界模糊这样低水平且似乎简单的问题——也远远称不上完美。设计一个针对这样低水平语言理解任务的学习系统,和引入神经 NLP 方法之前一样,仍然是一个重要的研究挑战。

另一个重要挑战是学习特征的不透明,以及架构和学习算法背后缺乏严谨的理论支撑。研究神经网络表征的可解释性,以及更好地了解各种架构的学习能力和训练过程,对进一步的发展至关重要。

在撰写本书时,神经网络本质上仍然是有监督学习方法,并且需要相对大量的标记训练数据。虽然使用预先训练的词嵌入为半监督学习提供了便利的平台,但我们仍处于有效利用未标记数据、减少对注释样本依赖的初级阶段。请记住,人类通常可以从为数不多的例子中归纳出模式,而神经网络一般需要至少数百个标记样本,才有可能表现良好,即使在最简单的语言任务中也是如此。寻找有效的方式来利用少量的标签数据以及大量未注释的数据,并且做到跨领域的泛化,可能会导致该领域的另一次转变。

最后,本书也简单地谈到了,语言并不是孤立的现象。当人们学习、理解和产生语言时,他们以参考现实世界的方式做到这一点,而话语往往基于现实世界的实体或经验。在环境中学习语言,比如辅以图像、视频、机器人移动控制等方式,或是整合成为智能体的一部分,和真实世界互动并完成实际目标,这可能是另一个比较有前景的研究前沿。

全书目录

文章来源:http://www.morganclaypool.com/doi/pdf/10.2200/S00762ED1V01Y201703HLT037

新智元招聘

职位:总编

职位年薪:30 - 100 万(工资+奖金)

工作地点:北京-海淀区

所属部门:编辑部

汇报对象:CEO

下属人数:9 人

年龄要求:25 岁至 40 岁

性别要求:不限

工作年限:5 年

语 言:英语 + 普通话

学历要求:硕士以上

职位描述:

热爱人工智能和媒体事业;

深入把握国内外 AI 市场竞争格局、技术发展趋势和用户需求;

具有 5 年以上媒体采编经验,在业内有一定影响力及人脉;

英文阅读写作及沟通能力优异;

很强的抗压能力和自驱力,能在竞争激烈的环境下激励团队;

具有创业精神及团队精神,有恒心肯吃苦;

理工科背景优先,有知名企业或知名媒体机构工作经验者优先。

岗位职责:

全权负责包括微信公众号在内的各平台内容策划、生产与运营,对内容质量、阅读体验、数据增长负责。具体负责完成对微信公众号内容定位和规划,策划执行重点选题,建立和维护供稿作者资源;监控公众号各项数据指标变动,并以此为基础改进提升内容质量,增加核心受众群体。管理编辑团队,与其他部门经理协作沟通,配合公司整体业务。

应聘邮箱:jobs@aiera.com.cn

HR微信:13552313024

新智元欢迎有志之士前来面试,更多招聘岗位请点击阅读原文查看。