计算机视觉中深度迁移学习,165页PPT

【导读】国立台大8月13日到16日举办了AI 夏令营,讲解人工智能技术,包括:大规模机器学习的随机优化、影像特征解析、NLP特征抽取、IR最新技术网络模型等等;课程非常丰富。来自台大电机系的王钰强教授讲解了《计算机视觉中的深度迁移学习》,总共165页ppt,讲述了最新计算机视觉深度学习应用进展,以及迁移学习在图像分析中的应用,是学习了解迁移学习在计算机视觉应用很好的材料。

摘要

个人主页:

http://vllab.ee.ntu.edu.tw/members.html

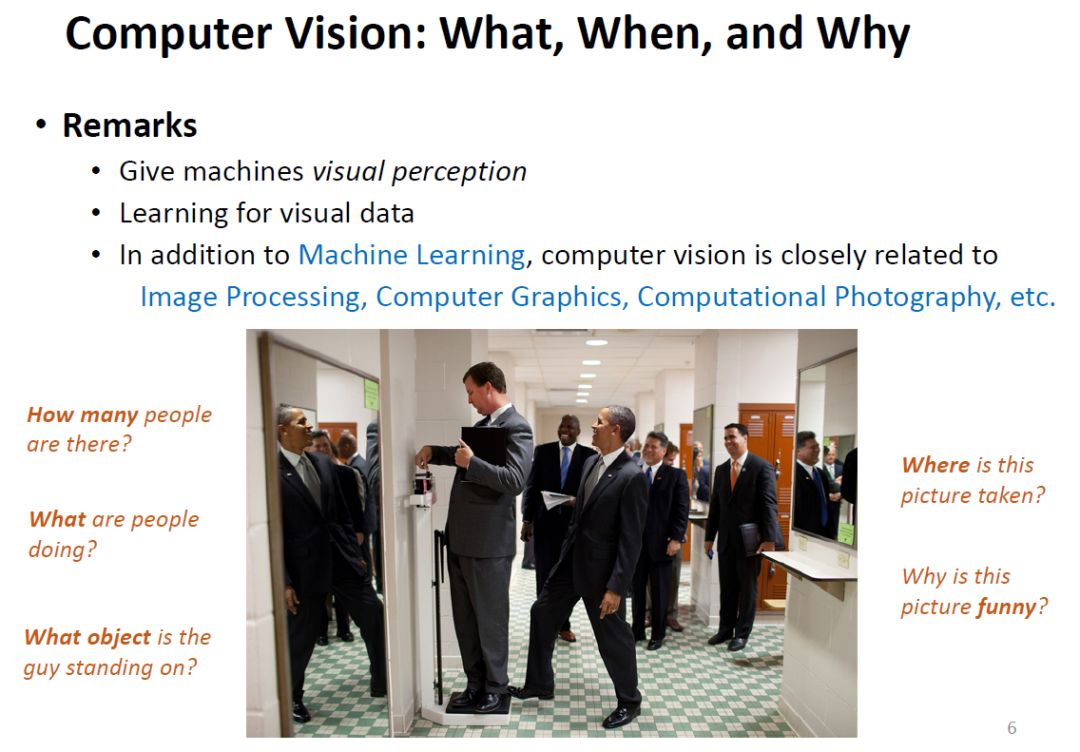

计算机视觉:什么,何时,为什么

计算机视觉应用:

虚拟增强现实

自动驾驶

工业机器人

医疗影像

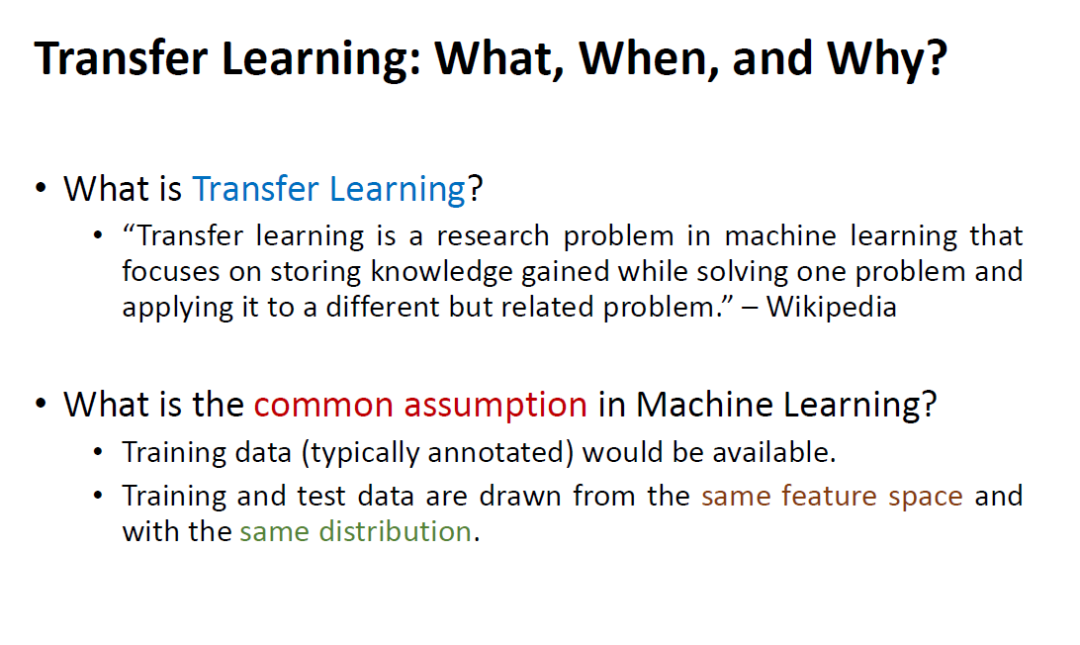

迁移学习:什么,何时,为什么?

机器学习中一般假设:训练数据是能够得到的,训练测试数据来自同一特征空间,并且是同分布,但真实情况却不是这样

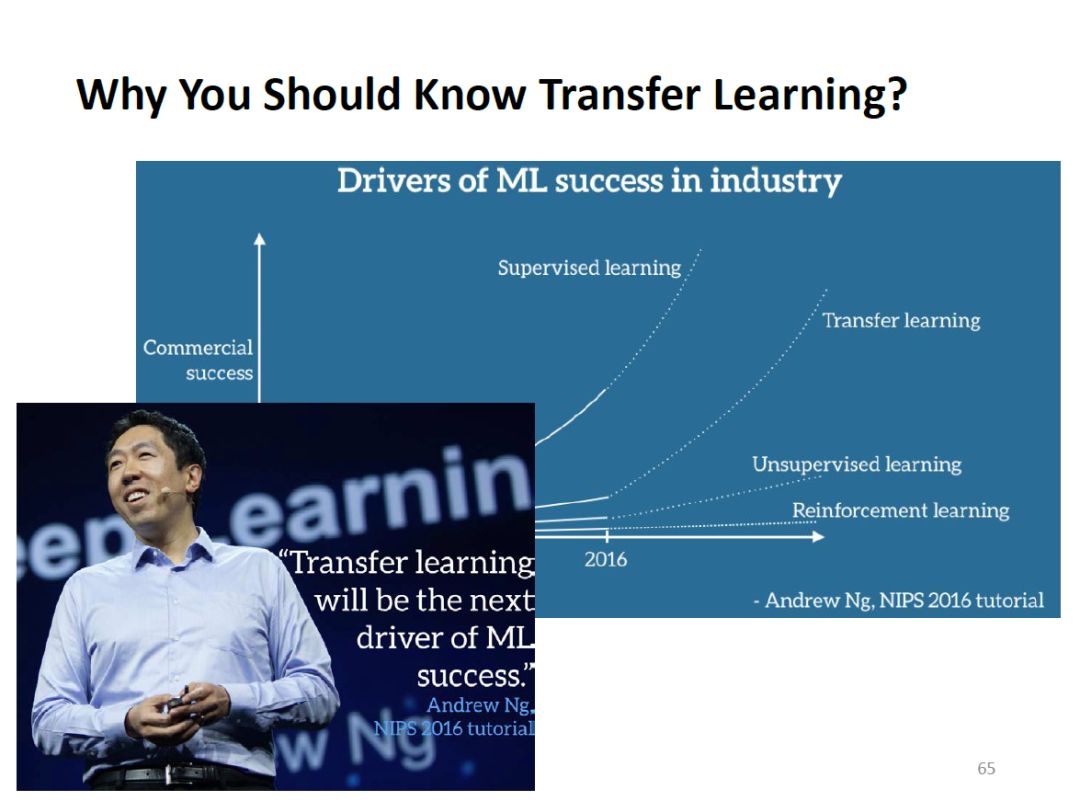

迁移学习,下一个商业成功的爆发点

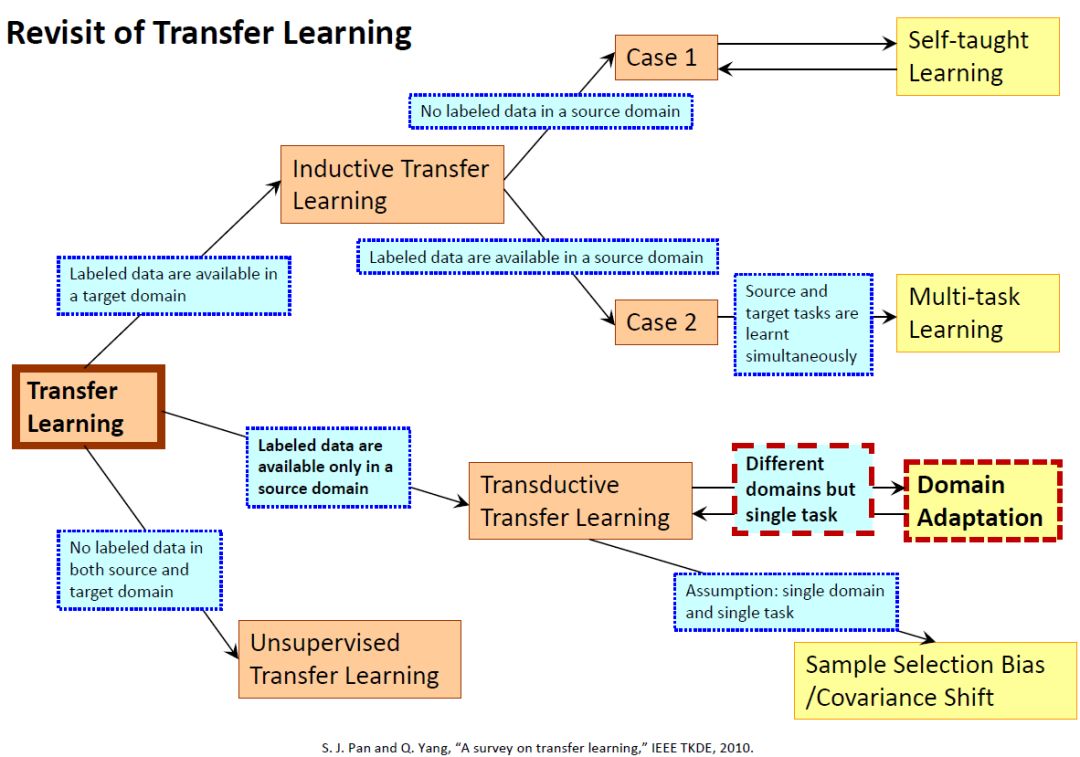

参考下图,根据所使用的传统机器学习算法,迁移学习方法可分类为:

归纳式迁移学习(Inductive Transfer learning):在该场景中,源域和目标域相同,但源任务和目标任务彼此不同。算法尝试利用来自源域的归纳偏差帮助改进目标任务。根据源域中是否包含标记数据,归纳式迁移学习可以进一步分为类似于多任务学习(multitask)和自学习(self-taught)这两类方法。

无监督迁移学习(Unsupervised Transfer Learning):该场景类似于归纳式迁移学习,重点关注目标域中的无监督任务。其中,源域和目标域类似,但是任务不同。在该场景中,任一域都没有可用的标记数据。

直推式迁移学习(Transductive Transfer Learning):在该场景中,源任务和目标任务之间存在一些相似之处,但相应的域不同。源域具有大量标记数据,而目标域没有。根据特征空间或边缘概率的设置不同,直推式迁移学习可进一步分类为多个子类。

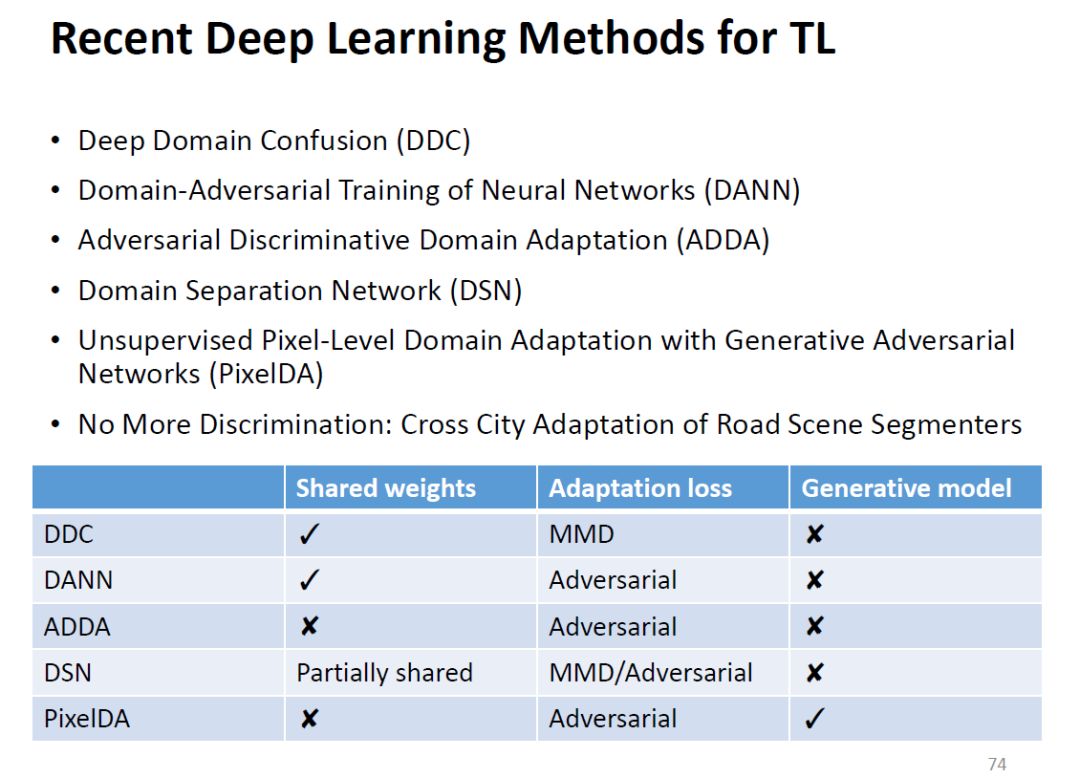

最新深度迁移学习方法:

深度领域混淆

深度对抗训练

对抗判别领域自适应

领域分隔网络

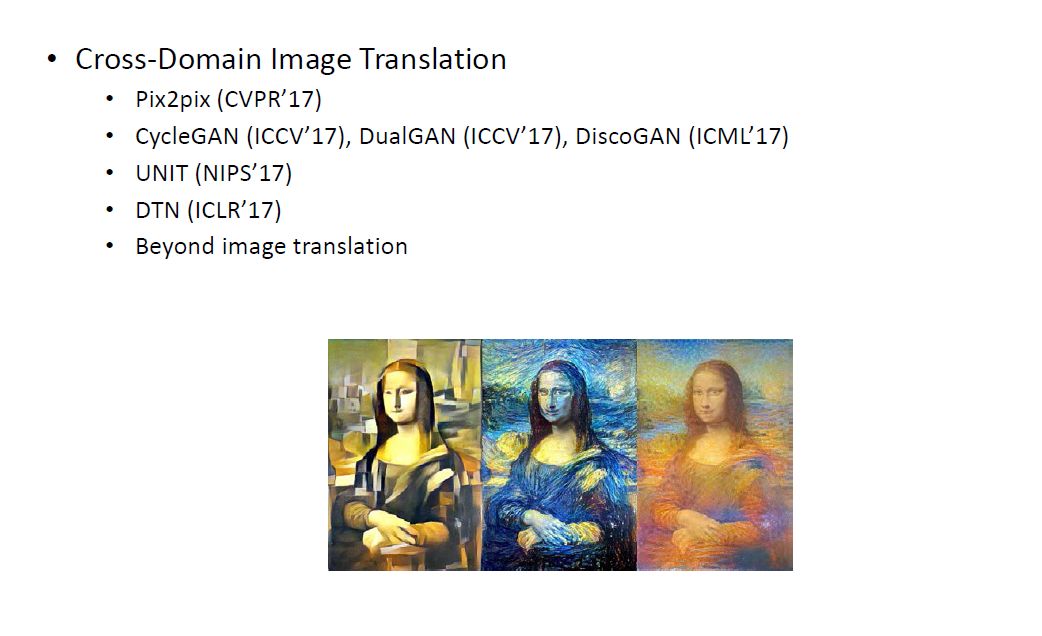

跨领域图像转换

Pix2pix (CVPR’17)

CycleGAN(ICCV’17), DualGAN(ICCV’17), DiscoGAN(ICML’17)

UNIT (NIPS’17)

DTN (ICLR’17)

Beyond image translation

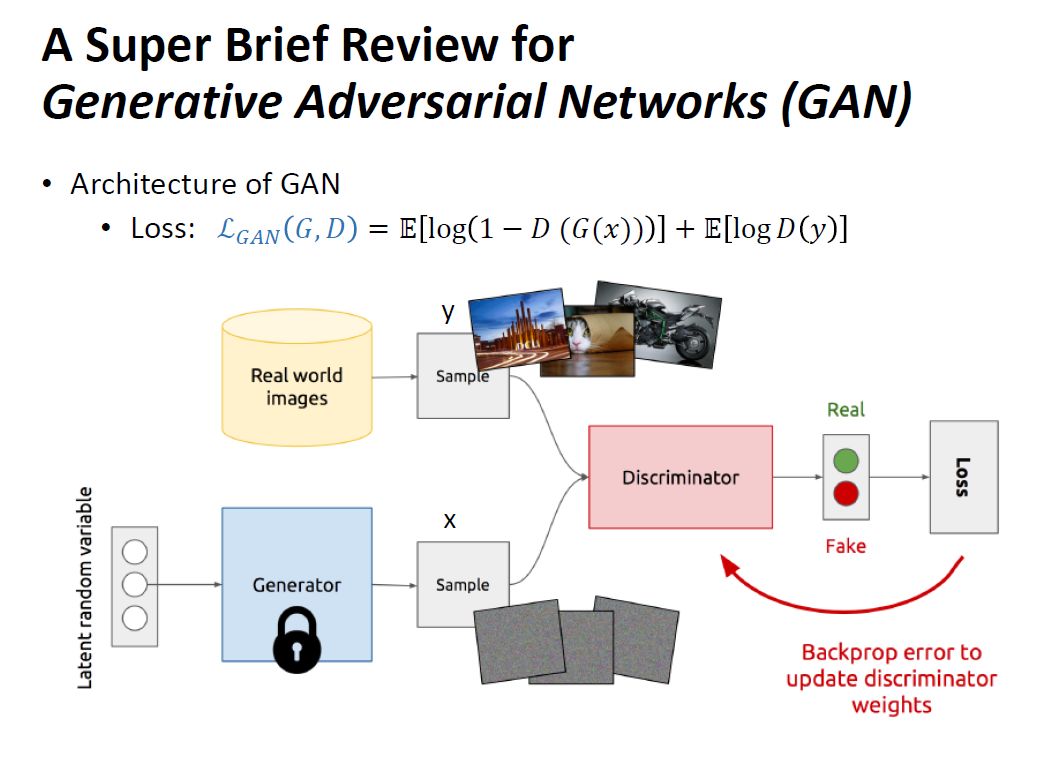

GAN简述

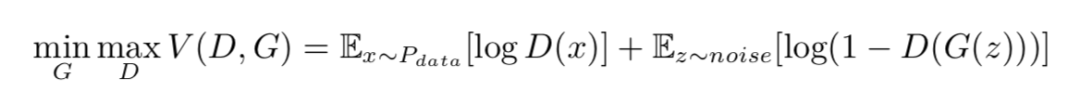

生成对抗网络(Generative Adversarial Nets)是一类新兴的生成模型,由两部分组成:一部分是判别模型(discriminator)D(·),用来判别输入数据是真实数据还是生成出来的数据;另一部分是是生成模型(generator)G(·),由输入的噪声生成目标数据。GAN 的优化问题可以表示为:

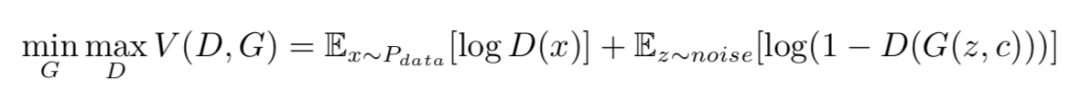

其中 Pdata 是生成样本,noise 是随机噪声。而对于带标签的数据,通常用潜码(latent code)c 来表示这一标签,作为生成模型的一个输入,这样我们有:

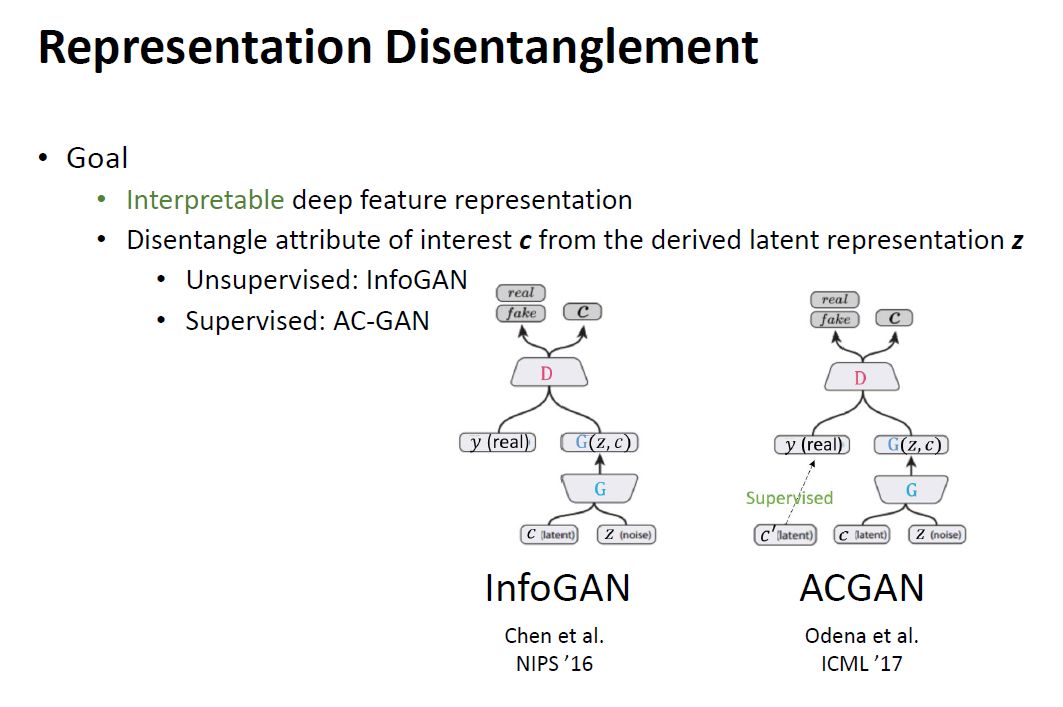

表示解缠

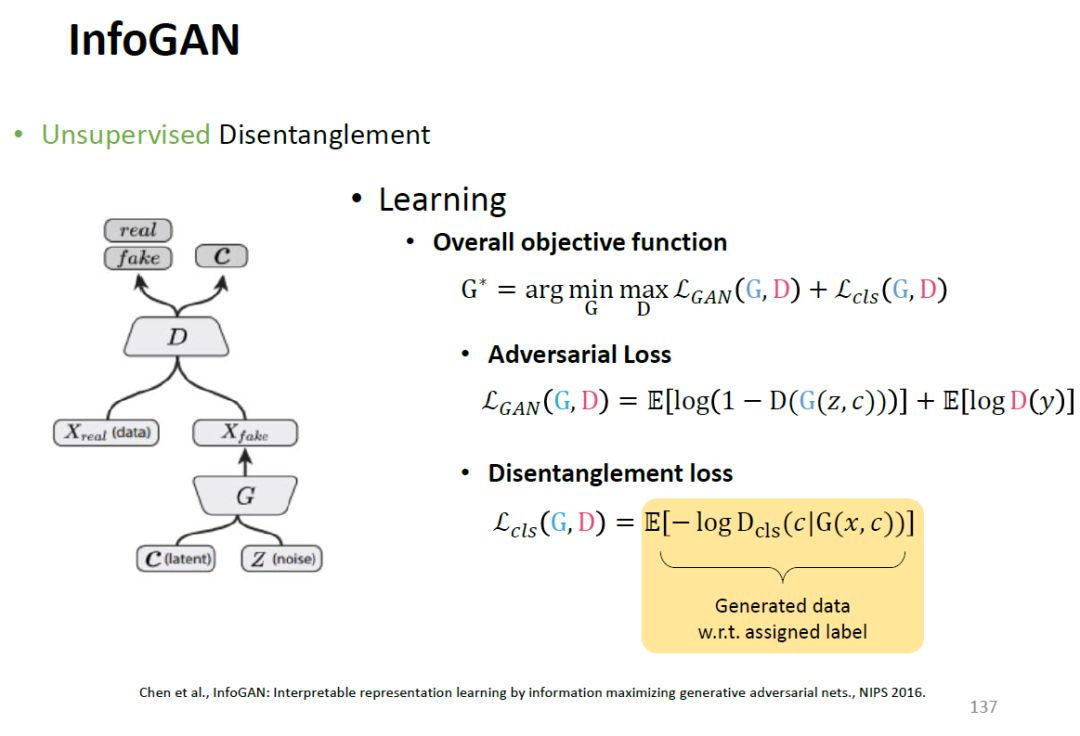

InfoGAN

当我们遇到存在潜在的类别差别而没有标签数据,要使 GAN 能够在这类数据上拥有更好表现,我们就需要一类能够无监督地辨别出这类潜在标签的数据,InfoGAN 就给出了一个较好的解决方案。

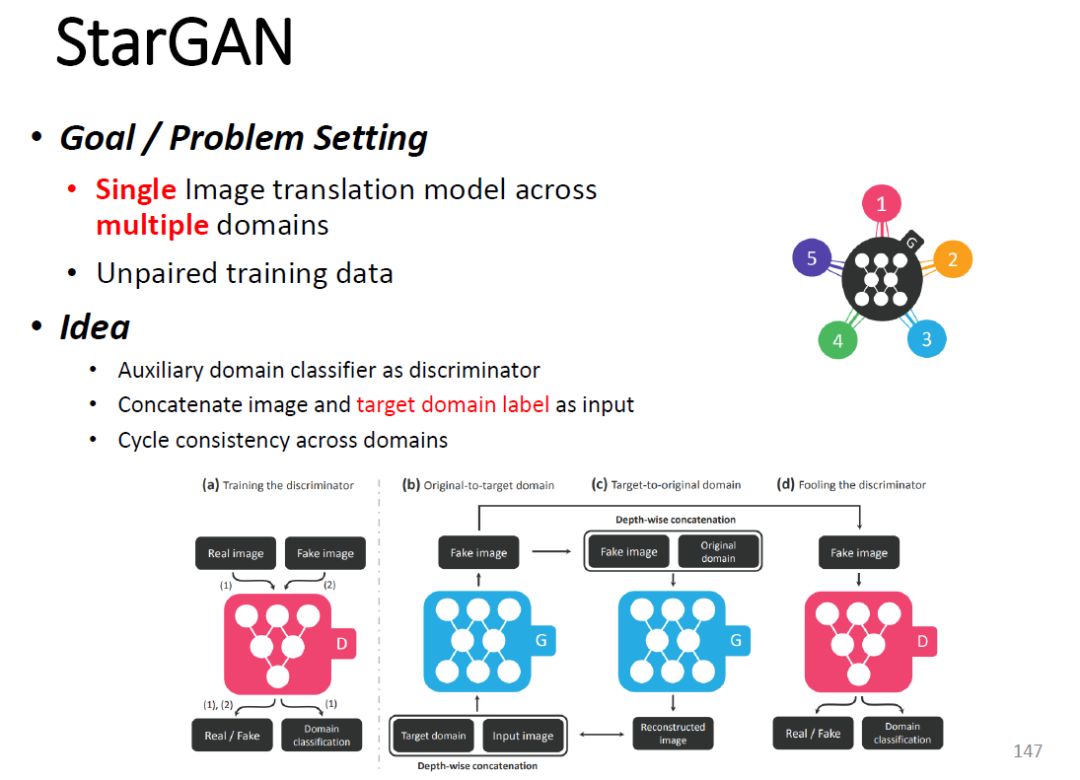

StarGAN

通过输入来自两个不同领域的训练数据,StarGANs模型可以学习将某一个领域的图片转换成为另一个领域。

例如,把一个人的发色(属性)从黑色(属性值)转换成棕色(属性值)。

生成器把图像和目标领域标签作为输入,生成一张非真实的图像.(b)

生成器试图根据所给的原始领域标签,把非真实图像重构为原始图像。

这里,为了生成器能够产生与真实图像难以区分的图像且该图像可以被判别器分类为目标领域,判别器不仅要区分非真实性,而且要对一张图像作出它相应领域的分类。也就是说,生成器将最终学到可以生成对应于所给目标领域的真实图像。(d)

相关资源:

请关注专知公众号(点击上方蓝色专知关注)

后台回复“TLCV” 就可以获取《计算机视觉在深度迁移学习中应用》PPT下载链接~

-END-

专 · 知

专知,专业可信的人工智能知识分发,让认知协作更快更好!欢迎登录www.zhuanzhi.ai,注册登录专知,获取更多AI知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程视频资料和与专家交流咨询!

请加专知小助手微信(扫一扫如下二维码添加),加入专知人工智能主题群,咨询技术商务合作~

专知《深度学习:算法到实战》课程全部完成!560+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程