![]()

作者 | 陈大鑫

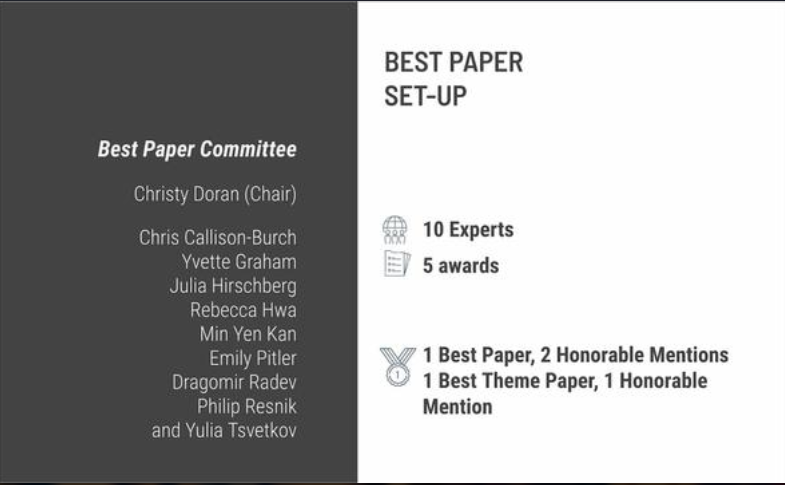

今天,ACL2020的论文奖项已全部出炉,共八篇文章获奖,包含一篇最佳论文、两篇最佳论文荣誉提名、一篇最佳主题论文、一篇主题论文荣誉提名、一篇最佳 Demo 论文、两篇最佳Demo荣誉提名。

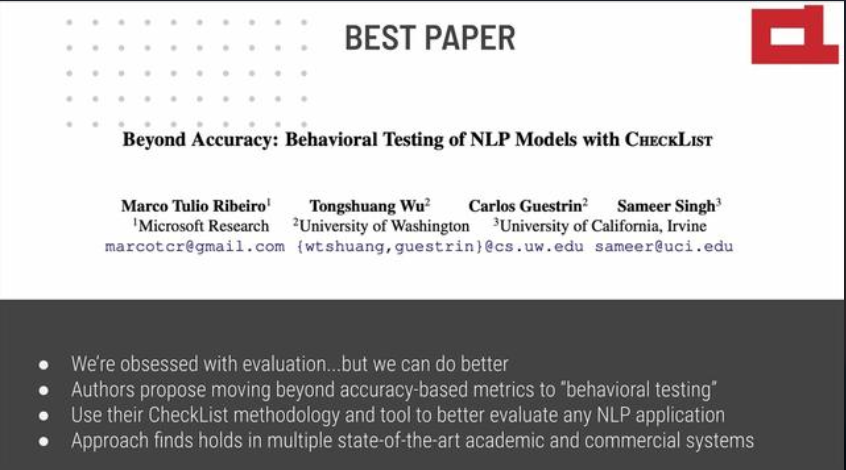

其中拿下最佳论文奖的论文是《Beyond Accuracy: Behavioral Testing of NLP Models with CheckList》,获奖团队来自微软研究院、华盛顿大学、加利福尼亚大学尔湾分校。该论文代码在两个月前就已开源:

最佳论文:《Beyond Accuracy: Behavioral Testing of NLP Models with CheckList》

(超越准确性:NLP模型的CheckList行为测试)

论文地址:https://www.aclweb.org/anthology/2020.acl-main.442/

开源代码:https://github.com/marcotcr/checklist

获奖团队:微软研究院、华盛顿大学、加利福尼亚大学尔湾分校。其中值得一说的是华人学生吴彤霜为论文二作。

虽然度量支持精度是评价泛化的主要方法,但它往往高估了NLP模型的性能,而用于评估模型的替代方法要么侧重于单个任务,要么侧重于特定的行为。受软件工程中行为测试原理的启发,我们介绍了一种用于测试NLP模型的不确定任务的方法。检查表包括一个通用语言能力和测试类型的矩阵,有助于全面的测试构思,以及快速生成一个包含大量不同测试用例的软件工具。我们用三个任务的测试来说明检查表的效用,识别商业和最先进模型中的关键故障。在一项用户研究中,一个负责商业情绪分析模型的团队在一个经过广泛测试的模型中发现了新的、可操作的错误。在另一个用户研究中,使用CheckList的NLP实践者创建了两倍多的测试,发现的bug几乎是没有检查表的用户的三倍。

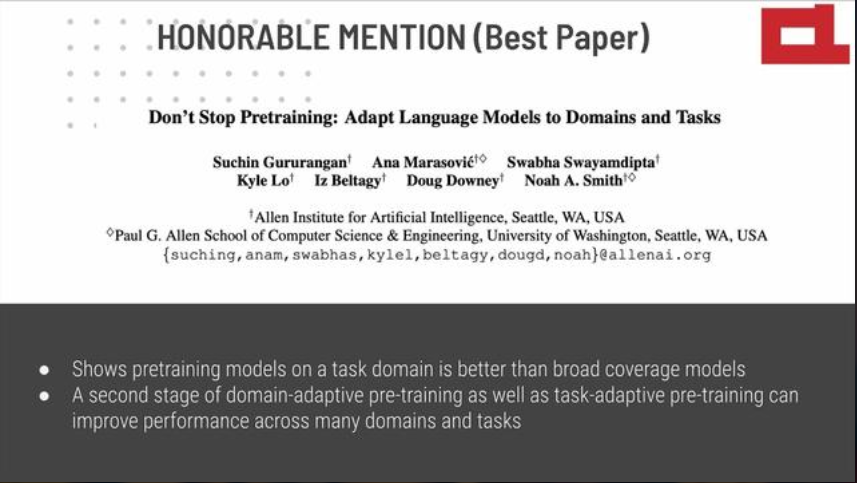

最佳论文荣誉提名一:《Don’t Stop Pretraining: Adapt Language Models to Domains and Tasks》(不要停止预训练:使语言模型适应不同领域和任务)

论文地址:

https://www.aclweb.org/anthology/2020.acl-main.740/

开源代码:

https://github.com/allenai/dont-stop-pretraining

在各种来源的文本上预训练的语言模型是当今NLP的基础。鉴于这些广泛覆盖模型的成功,我们研究定制一个预先训练的模型以适应目标任务的领域是否仍然有帮助。我们提出了一项跨四个领域(生物医学和计算机科学出版物、新闻和评论)和八个分类任务的研究,表明在高资源和低资源环境下,第二阶段的预训练indomain(领域适应性预训练)可以提高性能。此外,适应任务的未标记数据(任务自适应预训练)即使在域自适应预训练之后也能提高性能。最后,我们证明了使用简单的数据选择策略来适应扩充的任务语料库是一种有效的选择,特别是当领域自适应预训练的资源不可用时。总的来说,我们一致地发现多阶段自适应预训练在任务性能上有很大的提高。

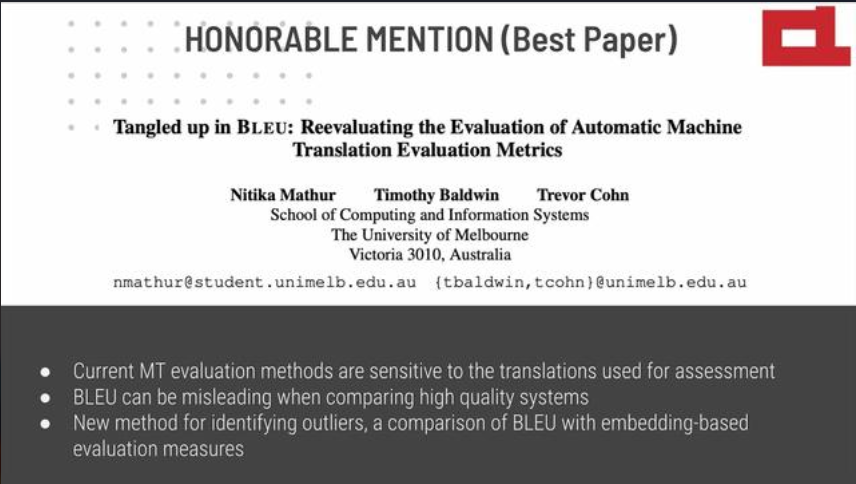

最佳论文荣誉提名二:《Tangled up in BLEU: Reevaluating the Evaluation of Automatic Machine Translation Evaluation Metrics》(深入于BLEU:重新评估自动

机器翻译评

估指标的评估)

论文地址:https://www.aclweb.org/anthology/2020.acl-main.448/

自动指标/度量(Automatic metrics)是机器翻译系统开发和评估的基础。评判自动指标是否以及在多大程度上符合人类评价的黄金标准并不是一个直接的问题。我们发现,目前用于评判指标的方法对用于评估的翻译非常敏感,尤其是存在离群值的时候,这通常会导致对指标的有效性得出错误自大的结论。最后,我们转向成对系统排名,我们开发了一种针对人为判断的自动指标下的性能改进阈值方法,该方法允许量化所产生的I类错误和II类错误,即可接受的系统质量中的不重要的人为差异,以及人类的显著差异。总之这些发现对机器翻译中的指标评估和系统性能评估协议提出了改进建议。

最佳主题论文:《Climbing towards NLU: On Meaning, Form, and Understanding in the Age of Data》(迈向NLU:关于数据时代的意义,形式和理解)

论文地址:https://www.aclweb.org/anthology/2020.acl-main.463/

大型神经语言模型在许多NLP任务上的成功是令人兴奋的。然而,我们发现,这些成功有时会导致炒作,这些模型被描述为“理解”语言或捕捉“意义”。在这篇论文观点中我们认为,一个只训练在形式上的系统在先验上是没有办法学习到意义的。为了与ACL2020主题“回顾过往&展望未来”保持一致,我们认为,对形式和意义之间的区别的清晰理解将有助于引导该领域朝着围绕自然语言理解的方向发展。

最佳主题论文荣誉提名:《How Can We Accelerate Progress Towards Human-like Linguistic Generalization?》(我们怎样才能加速向“类人类”语言泛化的进程?)

论文地址:https://www.aclweb.org/anthology/2020.acl-main.465/

本文描述并批判了预训练前不可知的同分布(PAID)评估范式,它已成为衡量自然语言理解进步的一个核心工具。该范式包括三个阶段:

(2)对表示分类任务的训练集进行微调(迁移学习);

这种范式倾向于简单、低偏差的体系结构,首先,我们可以对其进行扩展以处理大量数据;其次,可以捕获特定数据集的细粒度统计属性,不管这些属性是否可能推广到数据集之外的任务示例。这与人类形成了鲜明对比,人类从比这种评估范式所支持的系统少几个数量级的数据中学习语言,并且以一致的方式推广到新任务。我们提倡用奖励架构的范例来补充或取代PAID,这种架构能像人类一样快速而有力地进行推广。

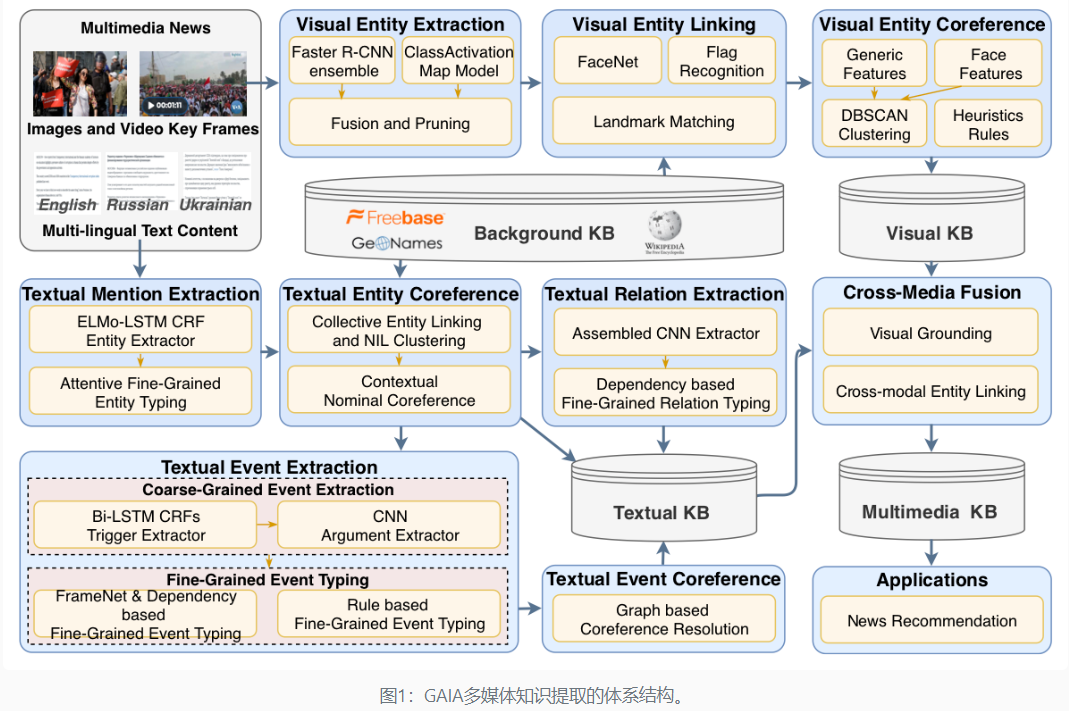

最佳DEMO论文:《GAIA: A Fine-grained Multimedia Knowledge Extraction System》(GAIA: 细粒度多媒体知识提取系统)

论文链接:https://www.aclweb.org/anthology/2020.acl-demos.11/

开源地址:

https://github.com/GAIA-AIDA

我们提出了第一个全面的、开源的多媒体知识提取系统,它以来自不同来源和语言的大量非结构化、异构的多媒体数据流为输入,创建一个连贯的、结构化的知识库、实体、关系和事件,并 循一个丰富的、细粒度的本体。我们的系统GAIA可以无缝搜索复杂的图形查询,并检索多媒体,包括文本、图像和视频。GAIA在最近的NIST TAC SM-KBP2019评估中取得了最佳性能。该系统可在GitHub和DockerHub公开,并提供完整的文档。

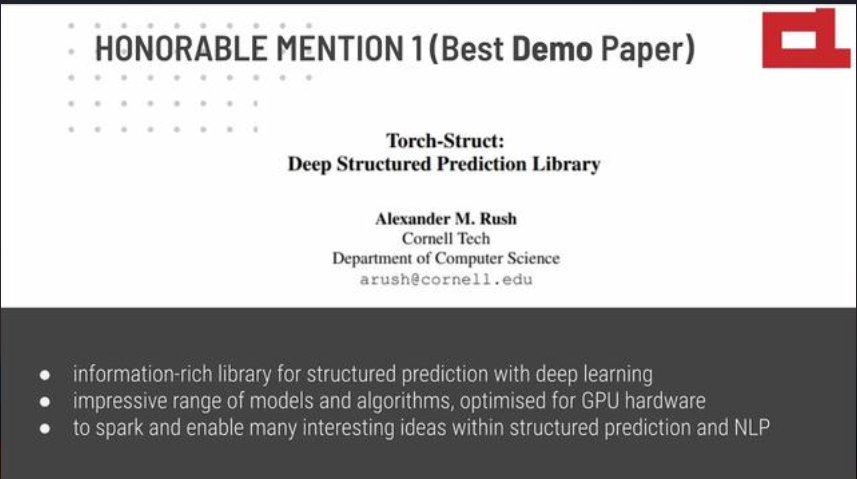

最佳DEMO论文荣誉提名一:《Torch-Struct: Deep Structured Prediction Library》(Torch结构:深层结构预测库)

论文链接:https://www.aclweb.org/anthology/2020.acl-demos.38/

开源代码:https://github.com/harvardnlp/pytorch-struct

面向深度学习的结构化预测信息丰富库

令人印象深刻的模型和算法,为GPU硬件优化

在结构化预测和NLP中激发许多有趣的想法

关于NLP的结构化预测的文献描述了大量关于序列、分段、对齐和树的分布和算法的集合;然而这些算法很难在深度学习框架中使用。我们介绍了Torch Struct,一个用于结构化预测的库,旨在利用和集成矢量化、基于自动微分的框架。TorchStruct包括广泛的概率结构集合,通过一个简单灵活的基于分布式的API访问,该API可连接到任何深度学习模型。该库利用批处理、矢量化的操作,并利用自动微分来生成可读、快速和可测试的代码。在内部,我们还包含一些通用优化,以提供跨算法的效率。实验表明与快速baseline相比,我们的性能显著提高。案例研究证明了库的好处。TorchStruct可在

https://github.com/harvardnlp/pytorch-struct

。

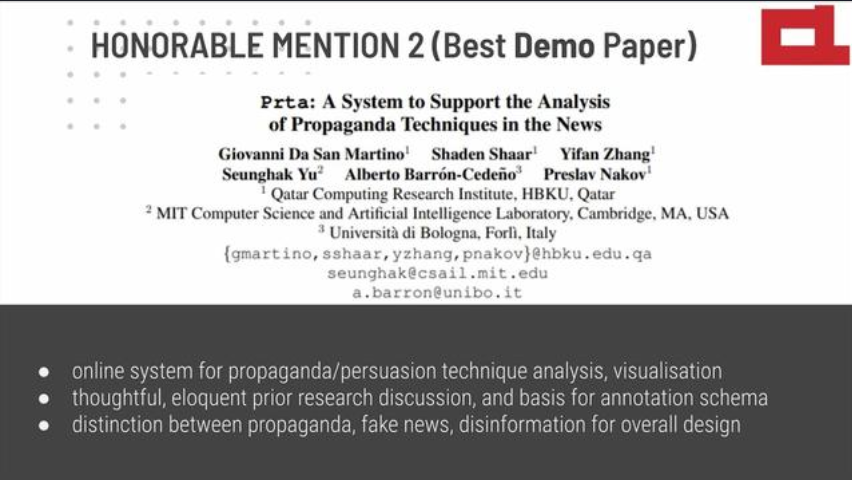

最佳DEMO论文荣誉提名二:Prta: A System to Support the Analysis of Propaganda Techniques in the News(Prta:一个支持分析新闻宣传技术的系统)

论文链接:https://www.aclweb.org/anthology/2020.acl-demos.32/

项目地址:

https://www.tanbih.org/prta

最近发生的事件如2016年美国总统竞选、英国脱欧以及COVID-19“信息传播”等,都让人们看到了网络造谣的危险性。有很多研究集中在事实核查和虚假信息检测上。然而,人们很少注意到用于传达宣传信息的具体修辞和心理技巧。揭示这些技巧的使用有助于提高媒体素养和批判性思维,最终有助于限制“假新闻”和造谣传播的影响。Prta(promotional consulting technologies Analyzer)允许用户通过突出宣传技巧发生的跨度来定期浏览所爬虫的文章,并根据他们使用的宣传技巧进行比较。该系统还根据用户、根据时间间隔、关键字和媒体的政治倾向指定的过滤标准,报告关于这些技术的总体和长期使用的统计数据。此外,它允许用户通过专用接口或API分析任何文本或URL。

在颁奖环节之后,组委会宣布EMNLP 2020为线上进行。

![]()

点击"阅读原文",直达“ECCV 交流小组”了解更多会议信息。