图数据的攻与防:智谱AI和biendata联合组织KDD Cup 2020

查看比赛详情,请点击阅读原文或扫描下图二维码。

在自然界和社会科学中,图结构无处不在,包括分子结构、社交网络、论文引用网络和细胞信号通路等。其中,最早于 1965 年被提出的论文引用网络 [1] 是一种典型的图结构:论文是节点,引用关系是边。研究论文引用网络可以在很多领域得到引用,比如科学影响评估,知识发现,以及技术预见等。

深度学习已经在很多领域获得了成功。最近,研究者发现很多深度学习技术可以用于图数据 [2] 。不过,深度学习模型非常容易受到攻击。一个非常类似原数据的对抗样本,可以极大地拉低分类器的性能 [3]。这种情况在图数据上也会出现。2018 年的 KDD 最佳论文就发现极其轻微的扰动就能让节点分类器的准确率大幅下降 [4]。在论文引用网络中,可能存在多种类型的对抗攻击。例如,预打印论文网站(如 arxiv)中的论文因为无需同行评议,所以存在很多低质量的引用 [5]。另一种是虚假引用(coercive citation)。2019 年,《自然》杂志报道了著名出版商爱思唯尔调查发现数百名研究人员通过操纵同行评议流程,增加自己的论文引用数 [6]。

这些对引文网络的攻击不仅会降低公众对科技行业的信任,也会损害对学术数据进行定量分析的努力。所以,我们组织这次比赛,希望可以研究如何攻击和防御学术图数据。

本次比赛分为两个阶段。

阶段I:攻击组织者的模型

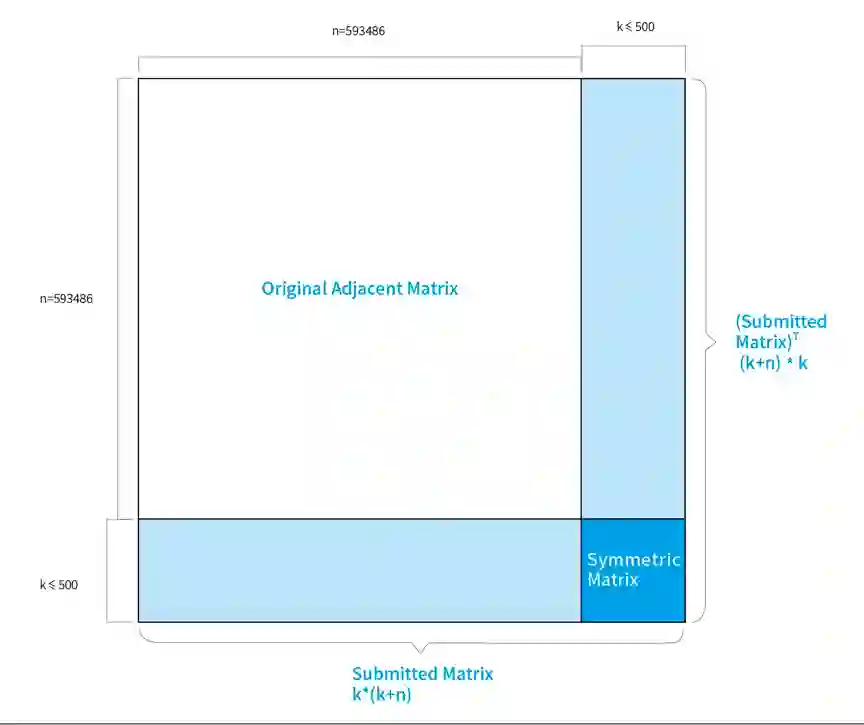

在本次比赛中,参赛队伍需要对组织者提供的图数据进行攻击,并拉低组织者的节点分类器的准确率。已有的图包括 593,486 个节点,每个节点都有一个 100 维的特征。其中 543,486 个节点是训练数据,50,000 个节点是测试数据。组织者在后台提供一个节点分类器,为 50,000 个测试节点进行分类。分类器不会被发布。

参赛选手可以添加不超过 500 个新的节点,达到干扰图数据的结果。每个新的节点最多只能有 100 条边。包含了新节点的图将会干扰分类器,降低分类器的性能。如果降低的幅度越大,干扰的效果就越好。

训阶段II:队伍之间的攻防

在第二阶段,参赛队伍需要根据一个新的图数据集,同时提交攻击和防御器。组织者将在比赛后匹配所有参赛队伍的攻击和防御,计算分数。

AI Time、学术头条

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。