《突击pyspark:数据挖掘的力量倍增器》让码农玩转大数据的利器

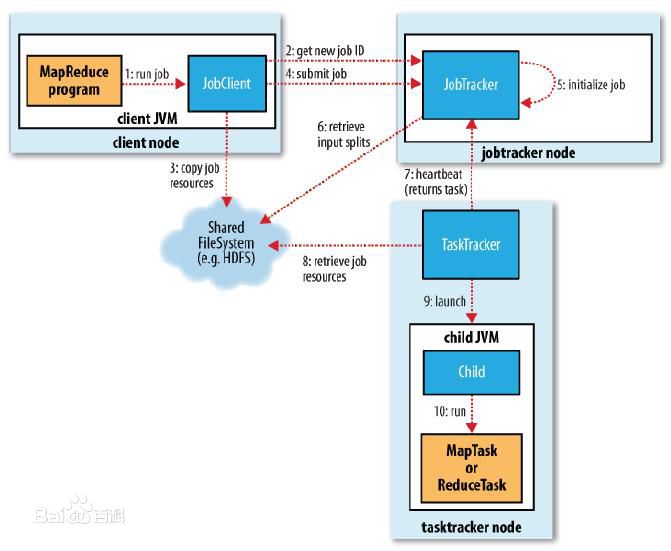

当下是大数据时代,为构建大数据平台,技术人员需要对分布式计算平台有一定深入的理解和应用。Apache Spark 作为MapReduce的新一代继承者。 是对map reduce从性能,易用性和复杂分析优化的强大的开源数据处理引擎。Spark框架支持流式数据处理, 复杂迭代算法,比传统Hadoop MapReduce 程序快100倍。

Python语言时当下数据领域的瑞士军刀,但是作为一门脚本语言python先天只能在一台机器上发展,不适合分析大数据,因此需要其他大数据软件来处理,Spark虽然是由Scala编写,但也提供了Pyspark,让熟悉Python者能够轻易熟悉操作大数据。

本课程将为大家全面而又深入的介绍Spark1.x,2.x 、Hadoop、pyspark平台的构建流程,涉及Spark、Hadoop系统基础知识,概念及架构, pySpark、Hadoop的实战技巧,Spark、Hadoop经典案例等。

通过本课程实践,帮助学员对Spark、Hadoop生态系统有一个清晰明了的认识;理解Spark、Hadoop系统适用的场景;掌握pySpark、Hadoop等初中级应用开发技能,让你的python水平更上层楼。

课程大纲:

第一课.spark介绍

hadoop、spark集群环境搭建

pyspark开发环境搭建

spark 1.x和2.x的对比

第二课.pySpark核心编程模型

RDD、transformation、action

第三课.pySpark核心编程实战

lineage、容错处理、宽依赖与窄依赖

第四课.Spark内核详解剖析

Spark术语解释、集群概览、核心组件、数据本地性

第五课.spark任务调度详解

RDD任务调度(DAGScheduler ,TaskScheduler)、Task细节、广播变量、累加器

第六课.spark工程经验和性能调优

第七课.spark SQL 详解

DataFrame、外部数据源API、与Spark其他组件的交互、

第八课.spark sql编程实战

Catalyst查询优化器 、Tungsten 优化

第九课.spark streaming 开发

Dstream、数据源、 容错

第十课.spark运维技能

授课时间:

课程预计2018年12月29日开课,预计课程持续时间为12周

授课对象:

本课程面向喜欢Python的学员,课程分为spark core、spark sql、spark streaming三个摸块。理论结合实战,让学员真正达到融会贯通、举一反三的效果。并应用到自己的工作环境中。

课程环境:

spark 2.*

收获预期:

1. 掌握Spark核心原理;

2. 了解如何对Spark Job进行性能优化;

3.. 掌握Spark Streaming的原理及使用方式

4. 了解SQL引擎的原理,掌握Spark SQL的使用和优化方式

授课讲师:

pyther,十年IT工作经验,曾就职阿里巴巴、雅虎,现为大数据独立顾问。

点击下方二维码或阅读原文报名课程: