UC 伯克利新研究:机器人有了触觉,一个算法实现多项精细操作

新智元报道

来源:bair.berkeley.edu

编辑:肖琴

【新智元导读】加州大学伯克利分校的新研究提出基于触觉的控制算法-触觉MPC,结合定制的触觉传感器,让机器人能够依靠触觉实现多个控制任务。

打字时用手指盲打,将钥匙插入钥匙孔,这些都依赖我们的触觉。已有研究表明,触觉对于人类的灵巧操作非常重要。

同样,对于许多机器人操作任务来说,只有视觉可能是不够的 —— 视觉很难处理微妙的细节问题,如边缘的精确位置,剪切力度或接触点处的表面纹理,而且机器人的手臂和手指可能阻挡相机与其目标物之间的视线。然而,用这种至关重要的感官能力来增强机器人,仍然是一项有挑战性的任务。

我们的目标是提供一个学习如何执行触觉伺服的框架,这意味着要基于触觉信息精确地重新定位一个物体。

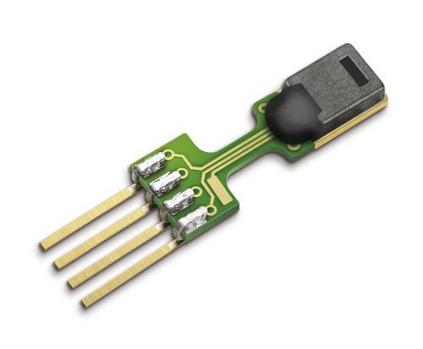

为了给我们的机器人提供触觉反馈,我们使用了一个定制的触觉传感器,其原理与 MIT 开发的 GelSight 传感器类似。传感器由一种可变形的弹性体凝胶组成,有三个彩色 LED 背光,并在凝胶表面提供高分辨率 RGB 接触图像。与其他传感器相比,这种触觉传感器以丰富的视觉信息的形式自然地提供几何信息,从而可以推断出力等属性。使用类似传感器的先前工作已经利用这种触觉传感器来完成诸如学习如何抓取的任务,提高了抓取各种物品的成功率。

下面是一个笔帽在凝胶表面滚动时,传感器的实时输出:

在实验中,我们使用了一个改进的 3 轴数控路由器,在路由器的末端执行器上安装了一个面朝下的触觉传感器。机器人通过改变传感器相对于其工作阶段的 X、Y 和 Z 位置来移动,每个轴由一个单独的步进电机驱动。由于这些电机可以精确控制,我们的设置可以达到约 0.04 毫米的分辨率,有助于在精细的操作任务中细致地移动。

机器人的设置。触觉传感器安装在图像左上角的末端执行器上,面朝下方。

我们通过 3 个代表性的操作任务演示了这一方法:

小球重新定位任务:机器人将一个小金属球轴承移动到传感器表面的目标位置。这个任务是很困难的,因为粗糙的控制往往会对球轴承施加过大的力,导致其滑动从而远离了传感器。

模拟摇杆偏转任务:在玩电子游戏时,我们经常只依靠触觉来操纵游戏控制器上的模拟摇杆。这个任务特别令人感兴趣,因为偏转模拟摇杆通常需要有意断开和返回接触,从而创建一个部分可观测性情况。

模具滚动任务:在这个任务中,机器人将一个 20 面模具从一个面滚到另一个面。在这项任务中,物体从传感器下滑出的风险更大,因此这项任务是三项任务中最难的。另外这个任务的一个优点是,它提供了一个直观的成功指标 —— 当机器人完成操作时,正确的数字应该正面朝上显示。

从左到右:小球重新定位,模拟摇杆和模具滚动的任务。

每一个控制任务都是直接在触觉空间中根据目标图像指定的;也就是说,机器人的目标是操纵物体,使它们在凝胶表面产生特定的印记。这些目标触觉图像可以比诸如物体的 3D 姿势规范或期望的力的方向提供更多信息,也能更自然地指定。

如何利用我们的高维感官信息来完成这些控制任务?这三个操作任务都可以使用相同的基于模型的强化学习算法来解决,我们称之为触觉模型预测控制 (tactile model-predictive control,tactile MPC),建立在视觉预见 (visual foresight) 之上。

需要注意的是,我们可以为每个任务使用相同的超参数集,从而消除了手动超参数调优。

深度触觉模型预测控制的概览

触觉 MPC 算法的工作原理是在自主采集的数据上训练一个动作条件的视觉动态或视频预测模型。该模型从原始的感官数据 (如图像像素) 中学习,并且能够直接对未来图像进行预测,并将其作为输入,作为机器人未来采取的假设动作以及我们称为上下文帧的起始触觉图像。没有指定其他信息,例如末端执行器的绝对位置。

视频预测模型的架构

在触觉 MPC 中,如上图所示,在测试时采集了大量的动作序列,本例中为 200 个动作序列,并且由模型预测得到假设轨迹。选择预测最接近目标的轨迹,并且此序列中的第一个动作被机器人在现实世界中采取。为了在模型出现小误差时进行恢复,每一步都重复规划过程中的轨迹。

这种控制方案以前已经被应用,并成功地使机器人能够拾取和重新排列物体,甚至可以将其推广到以前未见过的物体。如果你有兴趣阅读更多关于这方面的资料,可以查阅这篇论文:https://arxiv.org/abs/1812.00568。

为了训练视频预测模型,我们需要收集各种数据,使机器人能够推广到其从未见过的触觉状态。虽然我们坐在键盘前告诉机器人如何沿着每一个轨迹移动每一步,但让机器人大致了解如何收集数据并允许它这样做会更好。通过一些简单的重置机制,确保台面上的东西不会在数据收集过程中失控,机器人能够通过收集基于随机动作序列的轨迹,以完全自我监督的方式收集数据。在这些轨迹中,机器人记录来自传感器的触觉图像,以及它在每一步采取的随机动作。每一项任务都需要大约 36 小时的数据收集,无需人工监督。

模拟摇杆任务的随机数据收集

对于上述三项任务,我们分别提供了具代表性的计划和示例:

小球滚动任务 - 机器人沿着目标轨迹滚动小球

模拟摇杆任务 - 为了达到目标图像,机器人断开并重建与目标物体的接触。

模具任务 - 机器人将模具从标记为 20 的起始面 (如图中红色边框的预测帧所示,表示输入视频预测模型的上下文帧) 滚动到标记为 2 的面。

从这些示例中可以看出,使用相同的框架和模型设置,触觉 MPC 能够执行各种操作任务。

我们展示了一种基于触觉的控制方法 —— 触觉 MPC。

该方法基于学习高分辨率触觉传感器的前向预测模型,能够根据用户提供的目标重新定位物体。将这种算法和传感器结合起来用于控制是很有前景的,并且使用视觉和触觉结合起来的传感器,可以解决更困难的任务。

然而,我们的控制范围仍然相对较短,只有几十个时间步长,对于我们希望在未来实现的更复杂的操作任务来说,这可能还不够。此外,还需要对指定目标的方法进行重大改进,以支持更复杂的任务,例如通用对象定位或组装。

本文基于将在 2019 年机器人与自动化国际会议上发表的论文:

Manipulation by Feel: Touch-Based Control with Deep Predictive Models

Stephen Tian*, Frederik Ebert*, Dinesh Jayaraman, Mayur Mudigonda, Chelsea Finn, Roberto Calandra, Sergey Levine

https://arxiv.org/abs/1903.04128

更多阅读

【2019新智元 AI 技术峰会精彩回顾】

2019年3月27日,新智元再汇AI之力,在北京泰富酒店举办AI开年盛典——2019新智元AI技术峰会。峰会以“智能云•芯世界“为主题,聚焦智能云和AI芯片的发展,重塑未来AI世界格局。

同时,新智元在峰会现场权威发布若干AI白皮书,聚焦产业链的创新活跃,评述AI独角兽影响力,助力中国在世界级的AI竞争中实现超越。

现场精彩回顾:

爱奇艺(全天):

https://live.iqiyi.com/s/19rsj6q75j.html

头条科技(上午):

m.365yg.com/i6672243313506044680/

头条科技(下午):

m.365yg.com/i6672570058826550030/