易图秒懂の神经网络潜行-CNN前生

【数萃大数据】公众号又开办了一个新栏目,之后我们每周末会为大家分享各种趣闻趣事名人好书。

我们将连续转载史春奇老师高品质的推文。感谢史春奇老师的授权以及对数萃大数据学院的大力支持!

在“易图秒懂の神经网络诞生"里面,简述了神经网络诞生,它诞生后,火爆了, 但后来又被打入了冷宫。 这里开始解释神经网络受冷之后,如何慢慢发展的。

前言

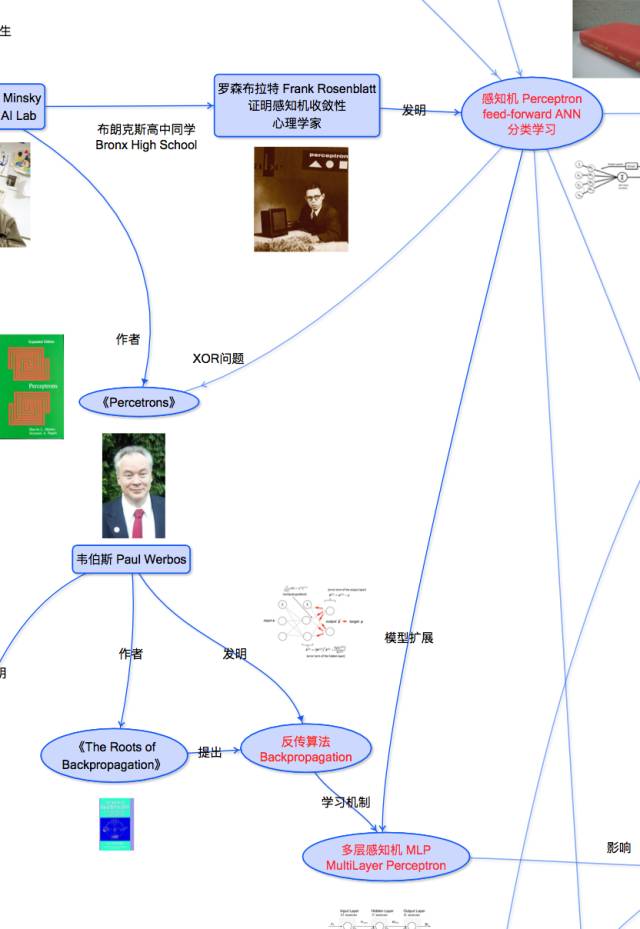

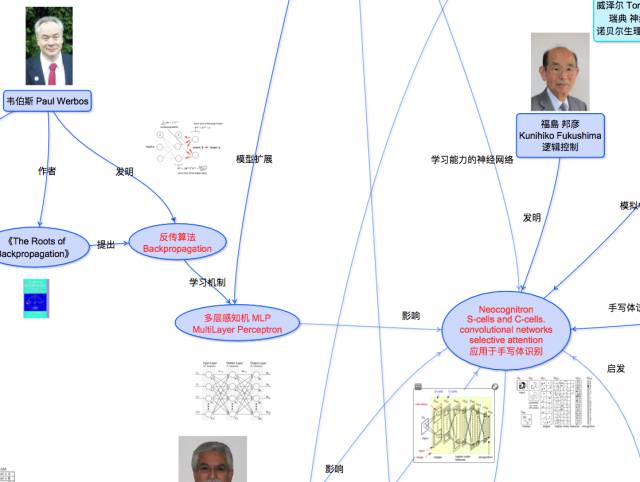

前面我们讲到神经网络诞生, 最早产生了MP静态模型, 然后Hebb学习后有了Perceptron动态模型, 然后XOR问题被打入冷宫, 再后来, 有了BP算法,产生了多层感知机MLP。 于是发展潜行。 但是这时候, 神经网络已经冷下来了, 多层感知机也没有火起来。 但是却深刻影响着后来的网络。

这其中就有现在深度学习很火的网络模型的前生。 现在,深度学习神经网络里面最火的里面有二个最大的类别CNN卷积神经网络, 和RNN递归神经网络。 其中, CNN的前生叫Neocognitron, 而RNN的前生叫Elman Network或者Simple Recurrent Network SRN。 这次先说明下CNN前生, Neocognitron是如何做到的?

一图抵千言

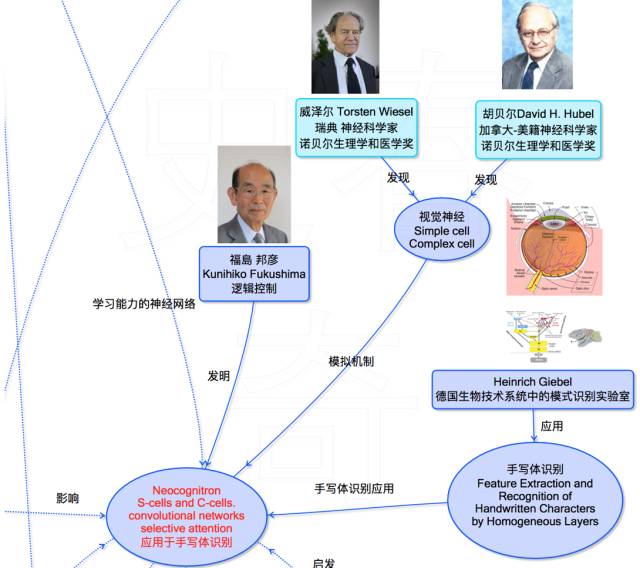

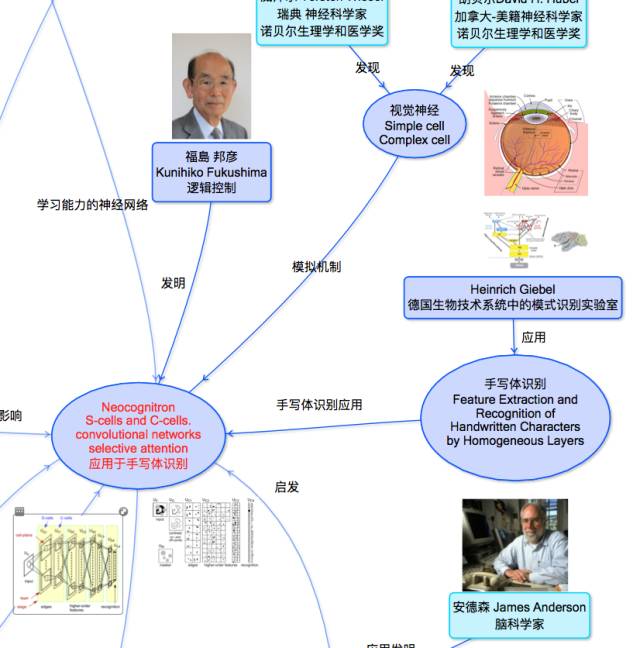

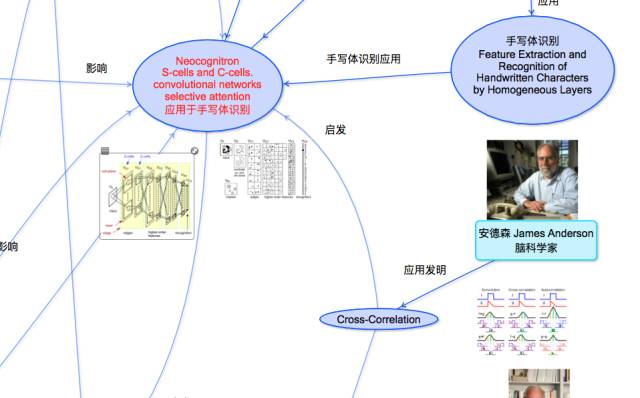

来自日本教授福岛邦彦, 受到感知机的影响, 走上了神经网络的道路。 但是一路走来并不容易。 正是这个Fukushima教授, 发明了Neocognitron网络。 这个网络的发明, 首先,是受到当时视觉神经系统的Hubel-Wiesel模型的影响。

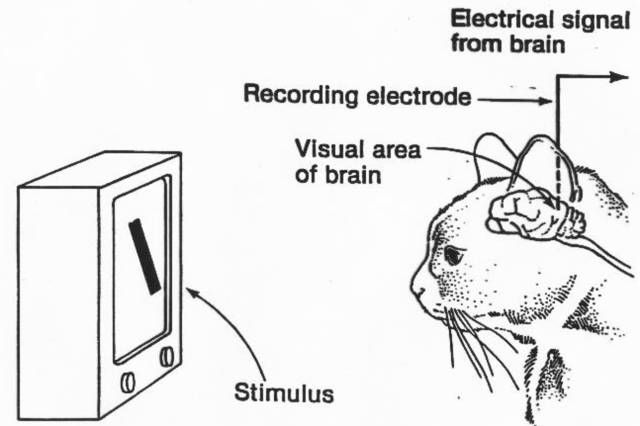

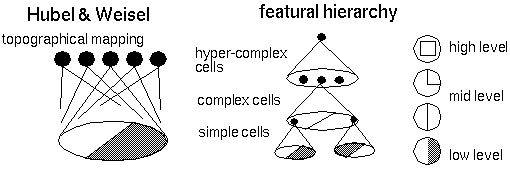

在Hubel-Wiesel模型里面, 通过动物的视觉刺激, 来观察了脑部接受的电信号来提出假设模型。

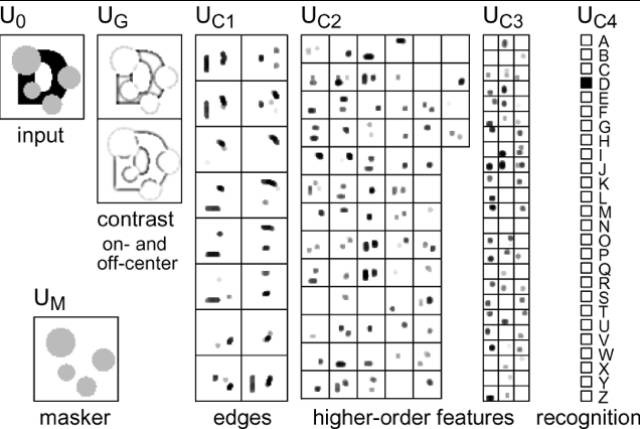

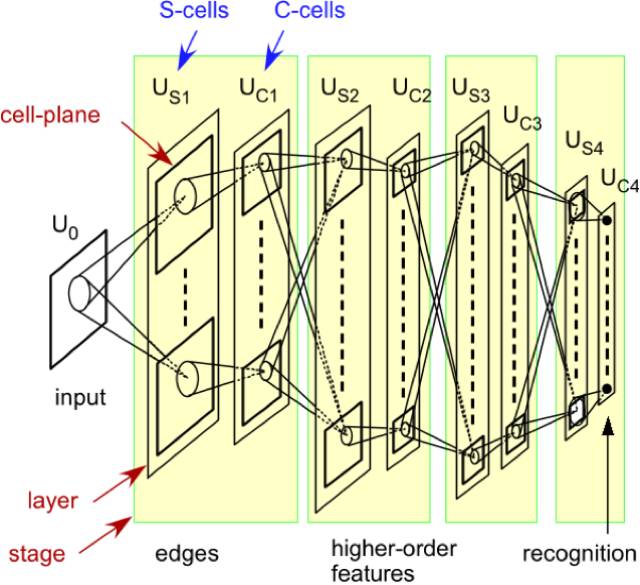

这是一个特征的分层模型, 从简单单元Simple Cell SC到复杂单元Complex Cell CC,然后到超级复杂单元,并且通过交叉映射来实现。

而福岛提出了类似的神经网络模型用来做模式识别的进程。先识别边, 然后识别特征, 然后模式识别。 这不就是我们介绍深度学习里面用的最多的东东?

并且为此构建了网络模型, 是个多层网络模型, 并且命名了简单单元和复杂单元的映射, 作为每个层次识别的层结构。

并且, 还采用了手写数字识别的实验来验证模型! 如果你了解CNN的话, 这是不是就是一个CNN的结构了?那么它受到哪些影响?

多层模型的参考

Neocognitron模型是个多层模型, 这个多层模型就是参考了MLP的多层模型的。 正是福岛意识到多层模型的重要性, 所以才有了Neocognitron的成果!

为什么采用手写体?

其实手写体的应用是德国的Heinrich Giebel最早应用的, 也正是因为Giebel应用里面他提出了特征提取和识别和神经网络的关系,而受到福岛的关注。

如何做到交叉映射的?

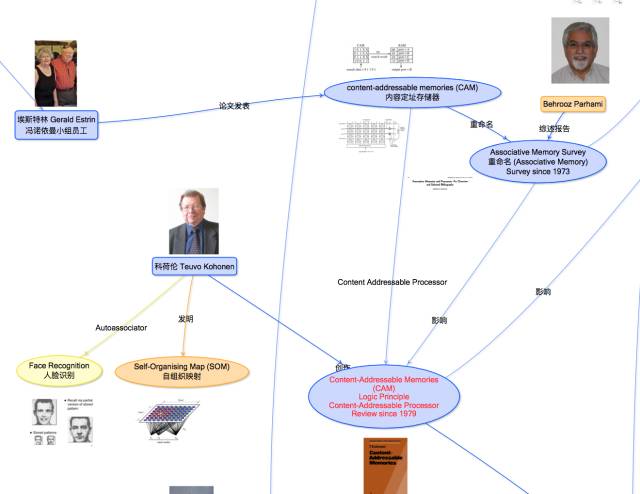

其实这个不是单纯的从生物学直接跳到物理实现的, 而是福岛之前受到两个大的方面的影响, 一个方面是来自Kohonen的关于associate memory发明的熏陶。 学过神经网络的知道,Kohonen最经典的是提出过SOM自组织映射网络。 其实这也是他对associative memory理论深入研究后的成果。 Kohonen早期一直研究发表, 并且出书了Content-Addressable Momories CAM, 这就是一种associate memory。 其实,这是对Estrin的CAM模型的一种带学习的扩展。 而这个Estrin就是冯诺依曼工作小组的员工, 对于内容寻址方面提出了CAM模型。 但是如何自学习这个CAM模型呢?Kohonen做了很多早期的研究和发表, 并且影响力蛮大的。

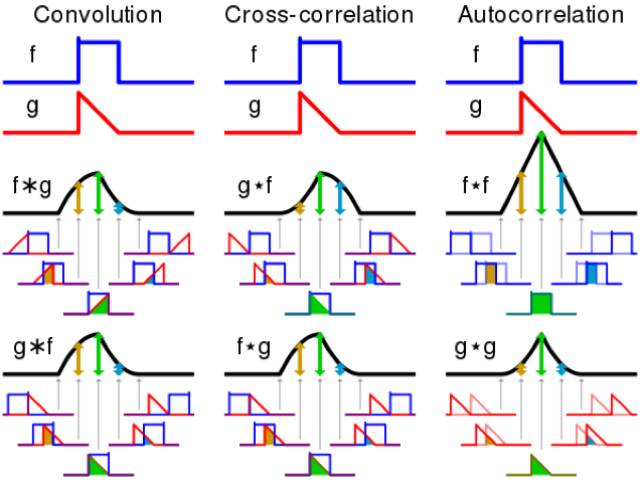

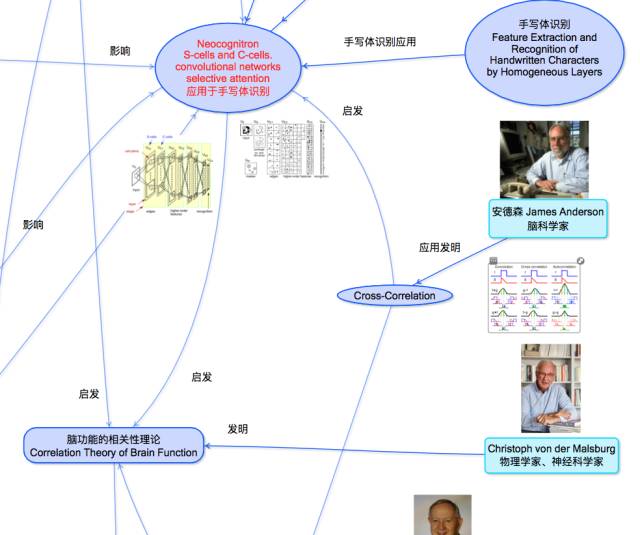

另外一个方面,就是有个叫Anderson的脑科学家, 发明了Cross Correlation的方法, 提出脑功能模型, 也对Neocognitron产生了影响。 而这个Cross Correlation几乎就是卷积的另外一种表达。

并且, Neocognitron的工作影响力巨大, 除了作为CNN的前生, 还对Malsburg的脑功能的相关性理论,和后面记忆模型影响深远 。

小结

这里描述了CNN的前生Neocognitron是在什么样影响下诞生的。 下次介绍RNN的前生。

欢迎参加【杭州站】Python大数据分析培训

8月18日-22日

扫描下方二维码了解更多