![]()

在众多卷积神经网络(CNN)压缩算法中,二值化网络(BNN)作为网络量化的极端情况,一直拥有着高压缩比,高加速比的性能优势,但是 BNN 的精度不高也一直饱受诟病,阻碍了 BNN 在实际场景中的应用。

今天和大家分享一篇 ECCV 2020 上发表的工作 ReActNet: Towards Precise Binary Neural Network with Generalized Activation Functions。是 Bi-Real Net 作者在二值化研究领域的最新成果。该论文用简单的平移激活值分布的操作,就取得了超过等同于实数值 ResNet 的精度,可以说是长久以来对于 BNN 的艰苦探索的里程碑式的工作。

![]()

论文标题:ReActNet:Towards Precise Binary Neural Network with Generalized Activation Functions

论文链接:https://arxiv.org/abs/2003.03488

代码链接:https://github.com/liuzechun/ReActNet

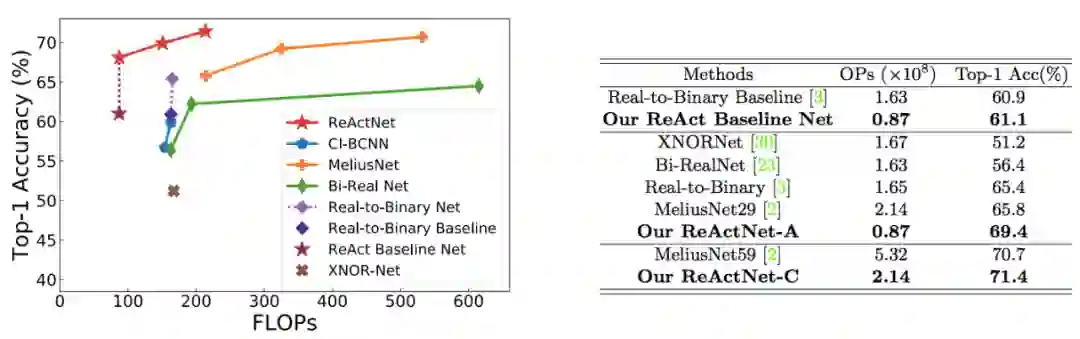

这篇文章通过简单的可学习的参数值,达到优化 Activation 的分布的目的,从而增加 BNN 的中激活值所携带的信息量。仅仅通过这一简单的改进,配合 Distributional Loss,本文 ReActNet,便可压缩 MobileNet V1 至 87M FLOPs,并且取得高达 69.4% 的精度。

这比著名的 XNOR-Net 的结果 51.2% 要高出了 18.2%,而所需的 FLOPs 也几乎仅仅是 XNOR-Net 的 1/2。同时,69.4% 的精度已经超过 69.3% 的实数值 ResNet 精度,这也是首次 BNN 网络能取得和实数值 ResNet 网络同等高的精度,揭示了 BNN 的巨大潜力。

![]()

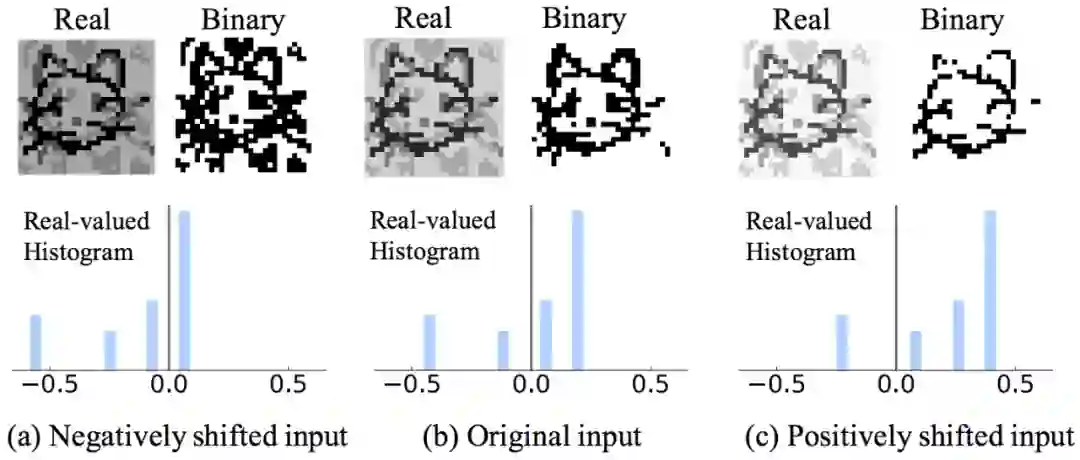

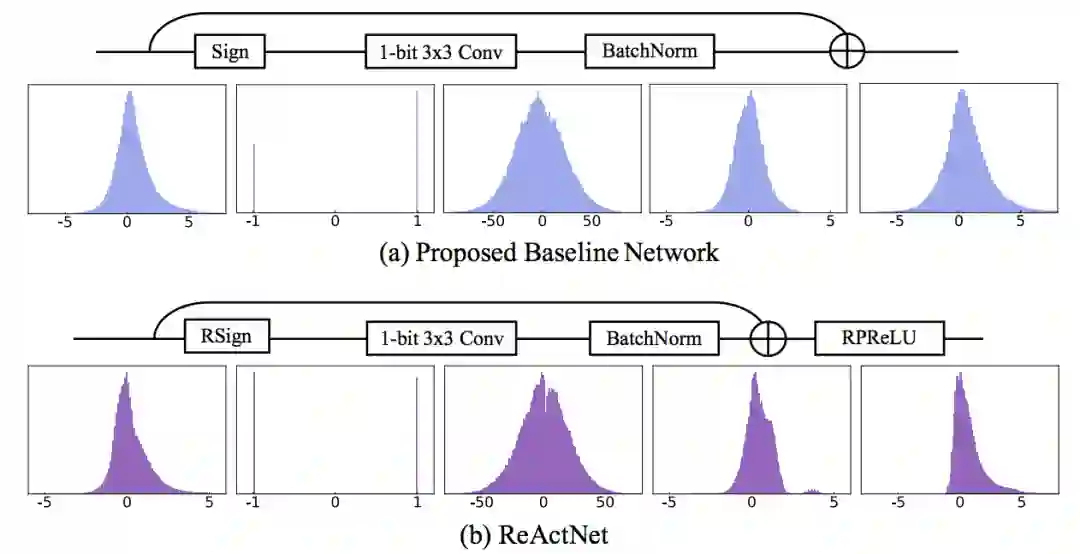

而达成这个高精度的网络 ReActNet 的核心,其实是非常简单直接操作。作者通过实验发现,BNN 卷积输出的特征图很难同时兼顾携带足够的特征信息和保证输出值范围适合下一层二值化操作。即,如果直接对网络中传递的实数值进行取 Sign 操作,可能会遇到由于实数值范围不合适而导致的二值化特征图携带信息量低。如下图所示。

![]()

只有在特征图的取值范围合适的时候(图(b)),所输出的二值化特征图才是包含最多信息量和最容易被网络是别的。

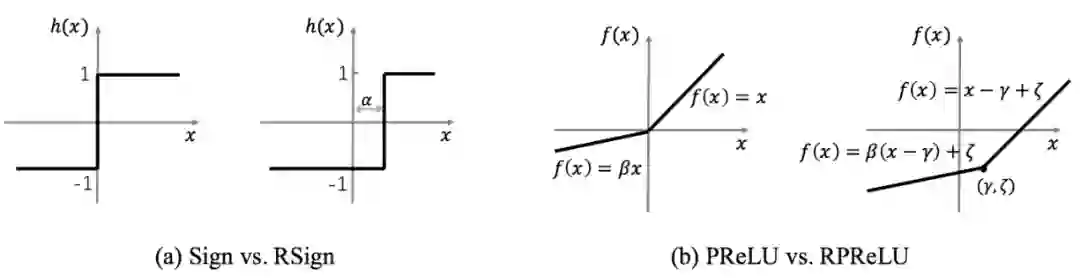

基于这个观察,作者提出了 Generalized Sign 和 PReLU 函数,称之为 RSign (ReAct Sign)和 RPReLU (ReAct PReLU),通过一个可学习的位移量来让网络自动学习最适合的 binary 阈值和 Activation 的分布。

![]()

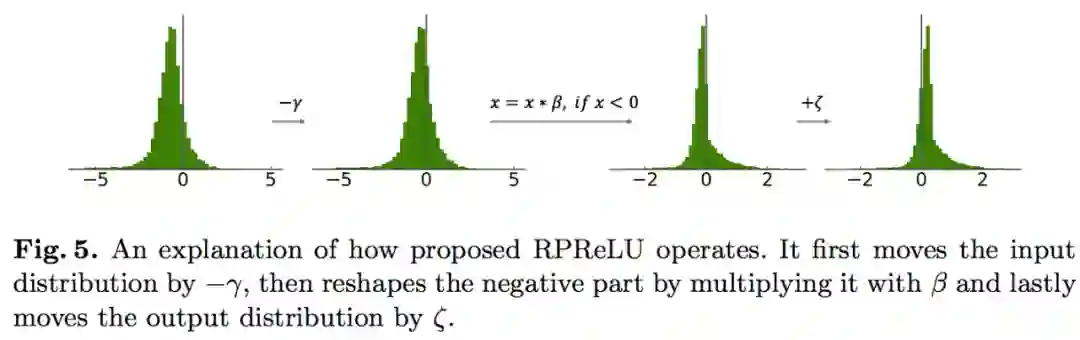

直观的理解,比如 RPReLU 所做的事情就是 Move Activation Distribution,Reshape,Move。移动,重塑,再移动。如下图所示。

![]()

结合 Distributional Loss 和基于 MobileNet V1 的网络改进,用了RSign 和 RPReLU 的 ReActNet 能在 ImageNet 数据集上取得了 69.3% 的 Top-1 Accuracy,超过了 State-of-the-art 的结果。而从网络内部的 Activation 分布中也可以看出,增加了 RSign 和 RPReLU 的 ReActNet 有更强的表达能力,可以捕捉到更精细的 Activation distribution。

![]()

最后,HKUST Vision and System Design Lab 正在招有硬件经验的同学来当博士后,由 Tim CHENG 老师直接指导。如果你曾在 DAC,ICCAD 或同等硬件会议/期刊上发表过一作论文,欢迎发送简历到 zliubq@connect.ust.hk

![]()

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

![]()

![]()