Kaggle最流行NLP方法演化史,从词袋到Transformer

选自Medium

作者:Zelros AI

Kaggle 竞赛史也是实践型 NLP 的历史。

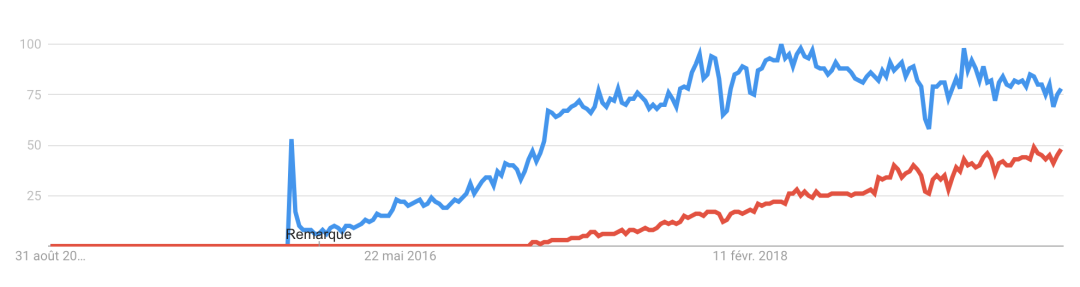

TensorFlow(蓝色)和 PyTorch(红色)的谷歌搜索趋势(来源:Google Trend)

TensorFlow(蓝色)和 PyTorch(红色)的谷歌搜索趋势(来源:Google Trend)

登录查看更多

相关内容

Arxiv

16+阅读 · 2019年5月24日