【CVPR2021】基于Transformers 从序列到序列的角度重新思考语义分割

基于Transformers 从序列到序列的角度重新思考语义分割

Rethinking Semantic Segmentation from a Sequence-to-Sequence Perspective with Transformers

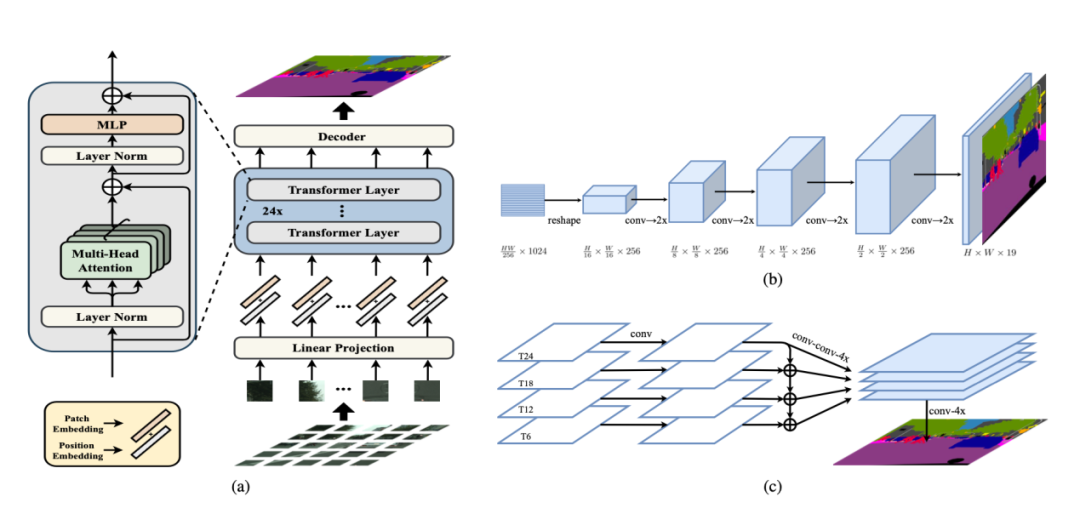

我们希望为语义分割方法提供另一种思路,将语义分割转变为序列到序列的预测任务。在本文中,我们使用transformer(不使用卷积和降低分辨率)将图像编码为一系列patch序列。transformer的每一层都进行了全局的上下文建模,结合常规的Decoder模块,我们得到了一个强大的语义分割模型,称之为Segmentation transformer(SETR)。大量实验表明,SETR在ADE20K(50.28%mIoU),Pascal Context(55.83%mIoU)上达到SOTA,并在Cityscapes上取得了较好结果。

https://www.zhuanzhi.ai/paper/679d8e44fd37dcea6218d8e287c11cae

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“SETR” 就可以获取《【CVPR2021】基于Transformers 从序列到序列的角度重新思考语义分割》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2021年6月21日

Arxiv

0+阅读 · 2021年6月18日

Arxiv

10+阅读 · 2020年12月31日

Arxiv

15+阅读 · 2020年3月31日