加州大学提出:实时实例分割算法YOLACT,可达33 FPS/30mAP!现已开源!

点击上方“CVer”,选择"星标"和“置顶”

重磅干货,第一时间送达

前戏

最近实例分割方向,出了很多paper,CVer也立即跟进报道(点击可访问):

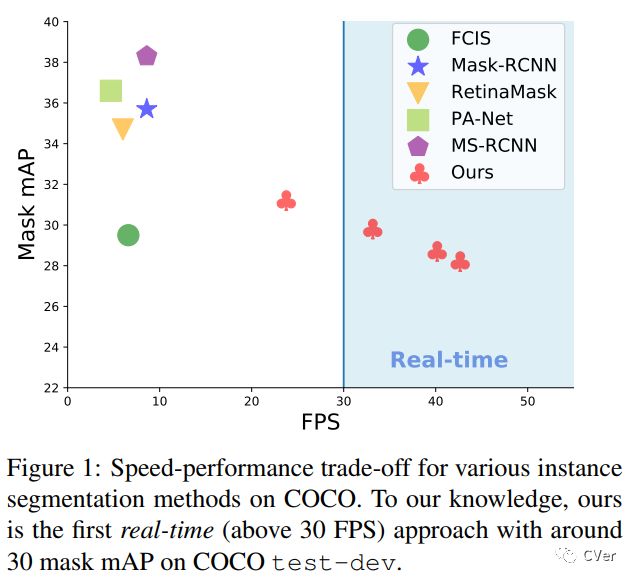

本文要介绍一篇很棒的实时实例分割论文:YOLACT,该论文是由 加利福尼亚大学 提出。截止2019年4月16日,据Amusi所了解,上述MS R-CNN应该是实例分割(Instance Segmentation)mAP 最高的算法;而本文 YOLACT 是实例分割中最快的算法(即FPS最大)。难能可贵都是这两篇paper,都已经开源!

注:YOLACT应该是Amusi了解到的第一个又快又好的实例分割算法,如果你有发现比这两个算法还fancy的paper,欢迎后台留言进行补充。

简介

《YOLACT: Real-time Instance Segmentation》

arXiv: https://arxiv.org/abs/1904.02689

github: https://github.com/dbolya/yolact

作者团队:加利福尼亚大学

注:2019年04月05日刚出炉的paper

Abstract:我们提出了一个用于实时实例分割的简单全卷积模型,在单个Titan Xp上以33 fps在MS COCO上实现了29.8 mAP,这比以前的任何算法都要快得多。此外,我们只在一个GPU上训练后获得此结果。我们通过将实例分割分成两个并行子任务:(1)生成一组原型掩膜(prototype mask);(2)预测每个实例的掩膜系数(mask coefficients)。然后我们通过将原型与掩模系数线性组合来生成实例掩膜(instance masks)。我们发现因为这个过程不依赖于 repooling,所以这种方法可以产生非常高质量的掩模。此外,我们分析了 the emergent behavior of our prototypes,并表明他们学会以 translation variant manner 定位实例,尽管是完全卷积的。最后,我们还提出了快速NMS(Fast NMS),比标准NMS快12 ms,只有一点点性能损失。

正文

背景

先介绍一下为什么叫YOLACT,因为其全称为:You Only Look At CoefficienTs。这里应该是致敬YOLO。

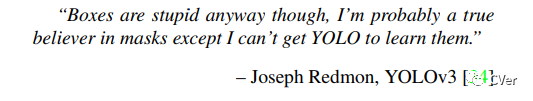

原作者在论文中引用了YOLOv3中的这句话,“Boxes are stupid anyway though, I’m probably a true believer in masks except I can’t get YOLO to learn them.”

注:日常催更,YOLOv4该来了吧!

本文算法(YOLACT)

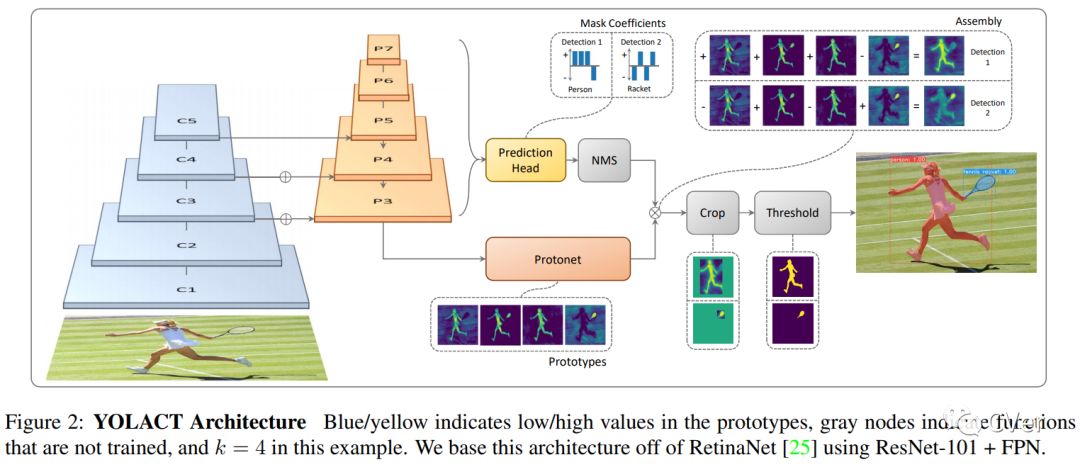

YOLACT的目标是将掩模分支添加到现有的一阶段(one-stage)目标检测模型,其方式与Mask R-CNN对 Faster-CNN 操作相同,但没有明确的定位步骤(如,feature repooling)。 为此,我们将实例分割的复杂任务分解为两个更简单的并行任务,这些任务可以组合以形成最终的掩码。第一个分支使用FCN生成一组图像大小的“原型掩码”(“prototype masks),它们不依赖于任何一个实例。 第二个向目标检测分支添加额外的 head 以预测用于编码原型空间中的实例表示的每个 anchor 的“掩模系数”(“mask coefficients)的向量。最后,对经过NMS后的每个实例,我们通过线性组合这两个分支的工作来为该实例构造掩码。

YOLACT将问题分解为两个并行的部分,利用 fc层(擅长产生语义向量)和 conv层(擅长产生空间相干掩模)来分别产生“掩模系数”和“原型掩模” 。 然后,因为原型和掩模系数可以独立地计算,所以 backbone 检测器的计算开销主要来自合成(assembly)步骤,其可以实现为单个矩阵乘法。 通过这种方式,我们可以在特征空间中保持空间一致性,同时仍然是一阶段和快速的。

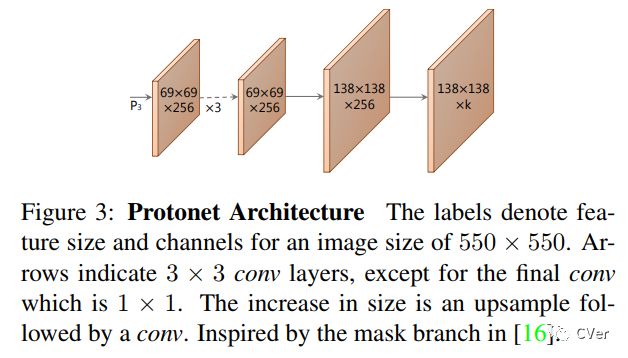

1 原型生成(Prototype Generation)

本文将 protonet 实现为FCN,其最后一层有k个 channels(每个原型一个)并将其附加到 backbone 特征层

2 掩膜系数(Mask Coefficients)

典型的基于Anchor(anchor-based)的目标检测器在其预测 head 中具有两个分支:一个分支用于预测 c 类置信度(confidences),另一个分支用于预测 4 个边界框回归量。对于掩模系数预测,本文简单地添加并行的第三个分支,其预测 k 个掩模系数,一个对应于每个原型。因此,不是每个 anchor 产生4 + c个系数,而是产生4 + c + k。

3 掩膜合成(Mask Assembly)

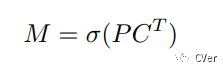

为了生成实例掩码,我们需要将原型分支和掩模系数分支进行合成,使用前者与后者的线性组合作为系数。这个运算可以由单个矩阵相乘完成:

其中,P是 h*w*k 的原型掩膜,C是 n*k 的掩膜系数。

4 YOLACT 检测器(Detector)

Backbone:ResNet-101 + FPN

Image Size:550*550

注:本文其实尝试了ResNet-101和DarkNet-53,这部分很好理解,backbone越轻量级,YOLACT运行速度越快,但mAP越低。不过使用ResNet-101就能达到33 FPS,真的很赞。

4 快速非极大值抑制(Fast NMS)

实验结果

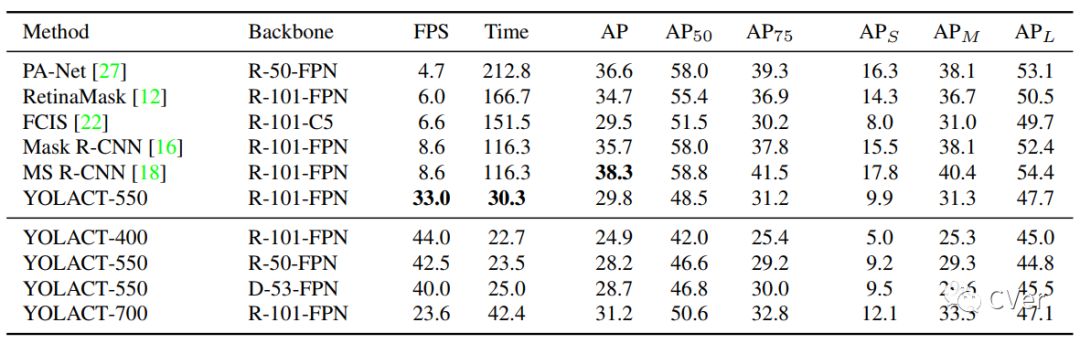

YOLACT在COCO test-dev上的mAP和FPS,其中基于ResNet-101的YOLACT-550 比之前具有相同mAP的算法快了 3.8倍。

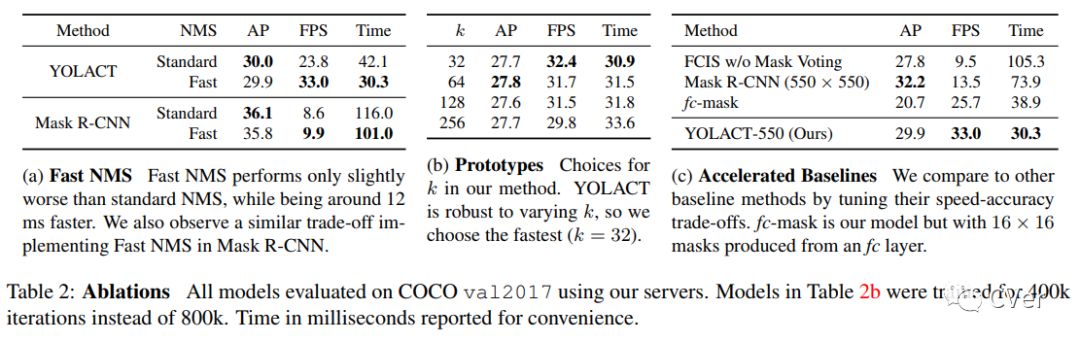

Fast NMS的有效性

YOLACT部分实例分割结果

CVer图像分割交流群

扫码添加CVer助手,可申请加入CVer-图像分割交流群。一定要备注:图像分割+地点+学校/公司+昵称(如图像分割+上海+上交+卡卡)

▲长按加群

这么硬的论文速递,麻烦给我一个在看

▲长按关注我们

麻烦给我一个在看!