ICLR论文作者最后的绝望:DDL最后一小时,评审让提交一份实验

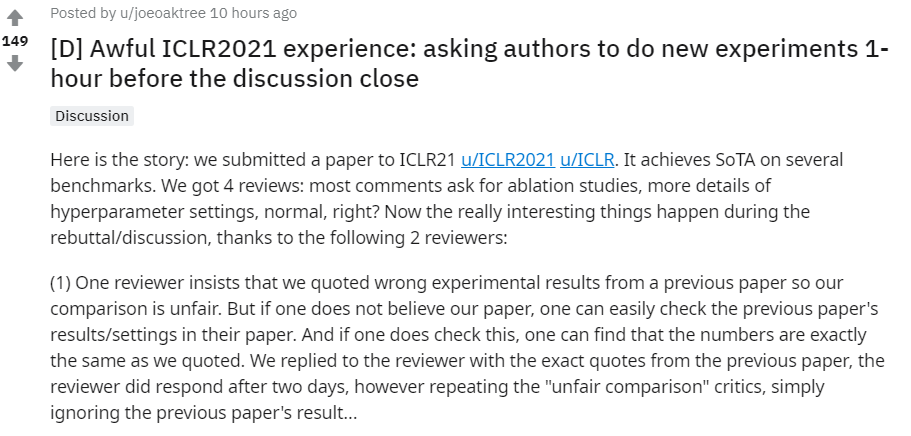

我们有篇论文的研究在几个基准上实现了SOTA,我们向ICLR提交了这篇论文。之后,就收到了4个评审意见,大部分意见要求进行消融研究,以及关于超参数设置的细节询问。这些意见非常正常,一点毛病都没有,真正有趣的事情发生在Rebuttal阶段:

1.有一位审稿人坚持认为我们引用了前一篇论文的错误实验结果,因此,表示论文中的比较是不公平的。如果审稿人相信我们,他完全可以查看前一篇论文的结果和设置,如果仔细点,这位审稿人就会发现,我们引用的数字和那篇论文中有的完全一样。也即并没有引用错误实验。

随后,我们用“前一篇”论文的原话回复了评审,评审给出的回复仍然是:“不公平的比较”。显然,评审忽略了前一篇论文的结果。

2.另一位评审要求我们进行消融实验,并和不使用A技术基线进行比较。我们照做了。此外,我们还增加了10个变体的消融研究。然而,在Rebuttal阶段结束的前一个小时,这位审稿人又提出了新的要求:做一次基线 + A - B比较,理由是:我们附加的消融研究涵盖了去除技术B的情况。 通常来说,做一个消融实验往往需要一天的时间,审稿人或许也知道1个小时是不可能完成实验的。所以,我认为这只是他拒绝我们论文的借口。退一步看,即使我们完成了实验,这位审稿人可能还要我们进行2^10个变体实验,然后让我们继续比较。这有什么意义呢?

我非常生气,我参加过许多AI/ML Confs、ICML、NeurIPS等会议,这次的ICLR是最糟糕的一次。虽然,我也明白当前AI顶会大多数评审的情况,但是4个评委里有两个能提出这样的求...... ICLR不值得,我以后不会再往这个会议中投递论文了,大家也把好的研究投递到真正“值得”的顶会吧。

另一个“Rebuttal”现场:reddit

赶快给领域主席发邮件!越快越好!

作者回复:

我们已经反馈了,我明白领域主席非常忙,毕竟现在他们有非常多的意见要看。

另一位网友附和:

没用的,主席站在评审那边。

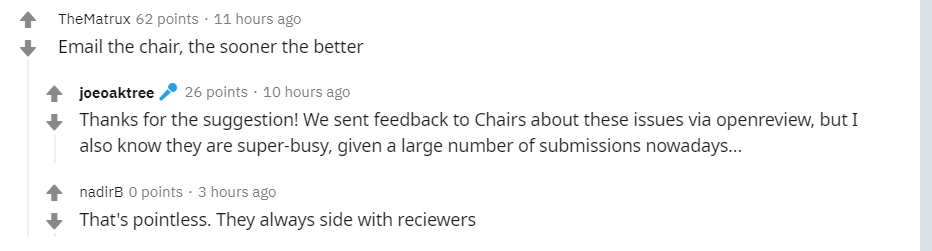

还有网友称,作者可能误会评审的意见了,或者评审没有清晰的表达自己的意思。另外,评审确实比较忙,他们需要在ICLR上审核其他几篇论文,还有全职工作要做,可能回复不会很及时。再者,SOTA在科学上也不是一个有趣的结果。实际上,你必须发现一些有趣的、可概括的、有影响力的东西,才能让你的论文值得发表。

1.自五天前的第二次答复之外,我们再也没收到评审的答复。 2.完全同意SOTA不够有趣的观点,但我们的论文提出了一种从来没有研究过的新方法啊!再者,评估所用的基准是这个问题最常用的基准。

ICLR并不是头一次这么干,你并不孤单。

作者回复:

上线事实核查或反驳进度跟踪工具非常有必要。

我的审稿人在截止日期前5小时给了我回复,并给出了一个不正确的反例,贬低了我论文中推导和证明。我早料到他/她会这样做,所以能给他/她一个详细的回复,“论证”他/她的胡说八道。另外,我还在考虑给领域主席们发邮件,告发他们这种行为。

吐槽大会

“CCF-NLP走进高校”是由中国计算机学会自然语言处理专业委员会(CCF-NLP)发起,联合AI研习社及各个知名高校开展的一系列高校NLP研究分享活动。

“CCF-NLP走进高校”第四期将走进“新疆大学”,一起聆听新疆大学NLP的前沿研究分享。本次活动邀请的嘉宾有哈尔滨工业大学(深圳)教授徐睿峰、清华大学计算机系长聘副教授黄民烈、天津大学教授熊德意、复旦大学教授黄萱菁、新疆大学教授汪烈军、西湖大学特聘研究员张岳。敬请期待!

点击阅读原文,直达直播页面

登录查看更多

相关内容

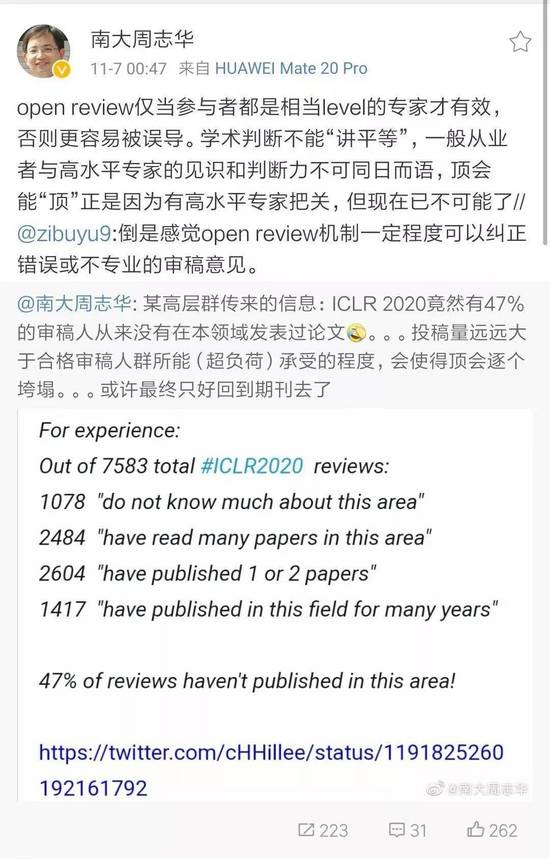

ICLR,全称为「International Conference on Learning Representations」(国际学习表征会议),2013 年才刚刚成立了第一届。这个一年一度的会议虽然今年才办到第五届,但已经被学术研究者们广泛认可,被认为「深度学习的顶级会议」。

ICLR由位列深度学习三大巨头之二的 Yoshua Bengio 和 Yann LeCun 牵头创办。

ICLR 希望能为深度学习提供一个专业化的交流平台。但实际上 ICLR 不同于其它国际会议,得到好评的真正原因,并不只是他们二位所自带的名人光环,而在于它推行的 Open Review 评审制度。

Arxiv

0+阅读 · 2021年1月29日

Arxiv

0+阅读 · 2021年1月29日

Arxiv

5+阅读 · 2018年12月15日