AI 模仿人脑究竟靠不靠谱?

【CSDN编者按】8月23日,李彦宏在首届中国国际智能产业博览会上,曾发言称,“通过研究人脑工作,来让机器像人一样思考,是行不通的”。

那么,人类究竟是否可以,把AI训练得像人一样思考和积累经验呢?今天这篇文章,将会通过几个小实验,来研究下AI模仿人类行为的能力,到底可以达到什么地步。一起往下看吧!

许多人认为人工智能(AI)是个“黑盒子”,其实这么说也没错。AI的最大问题之一,就是我们很难理解它解释数据的方式。

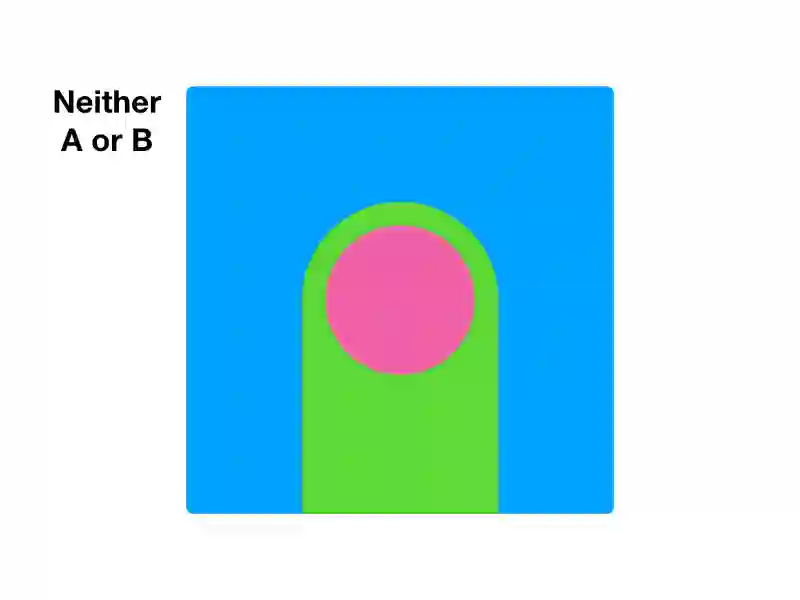

一个小游戏

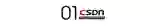

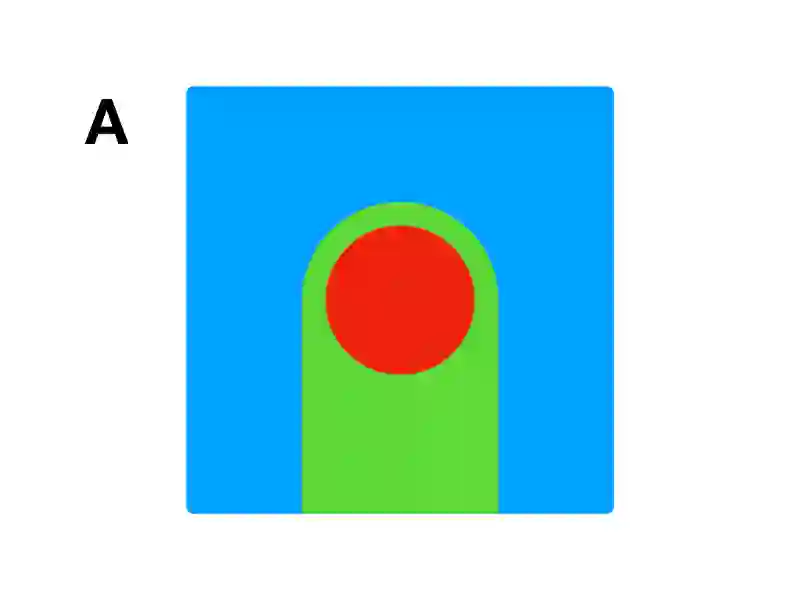

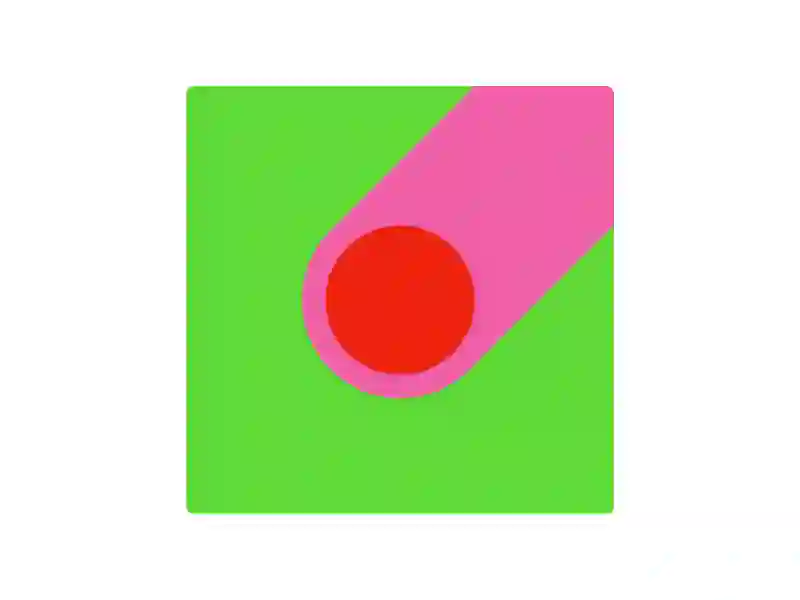

在进一步研究之前,让我们先来做个小游戏。我给你展示一系列抽象的图片,它们属于分类A或B中的某个。

你认为下面的图像属于分类A还是分类B?提示:没有分类C。

我们稍后再说结果。我们来看看更多的例子。

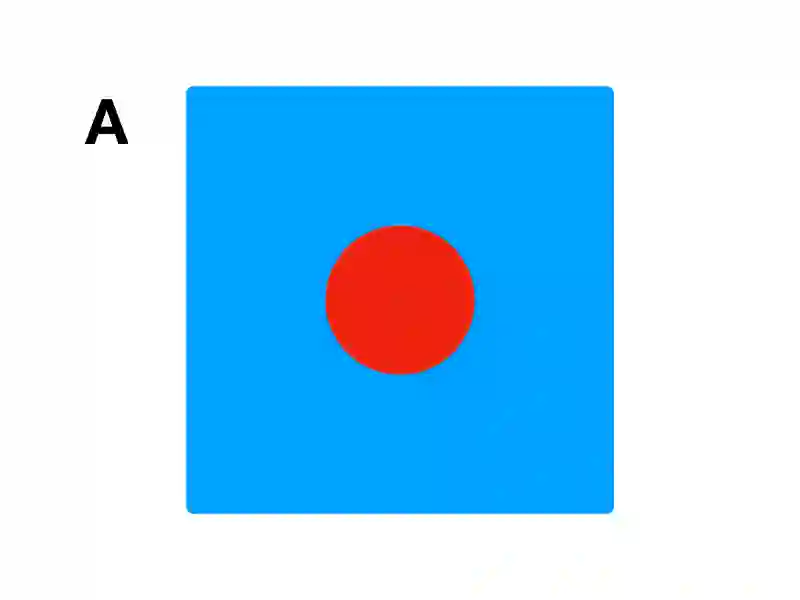

现在你能判断它属于A还是B了吗?

答案是……A!

选了B也不要难过,你不是唯一一个,选择了B的人。我问了整个屋子里所有的工程师和开发者,答案大概是一半一半。所以……为什么答案是A?

因为我说了答案是A。

答案就是A,不用跟我抬杠,但如果你不同意,那就说明我这个训练师当得不好。

作为训练师,我知道A代表红圈。所以任何中间有红圈的都是A。我也知道B是橙色的圈。其他的图像都是无关的。所以,只需要找到一组图像中的特征,但非常难。

在AI系统中,我没办法把组成A的图像的规则,用语言描述出来。我只能给它提供大量图片,期待它能发现规律。

而你,作为人工智能,也没办法,告诉我为什么你选了B。我只能不断地给你数据,直到你给出正确结果。

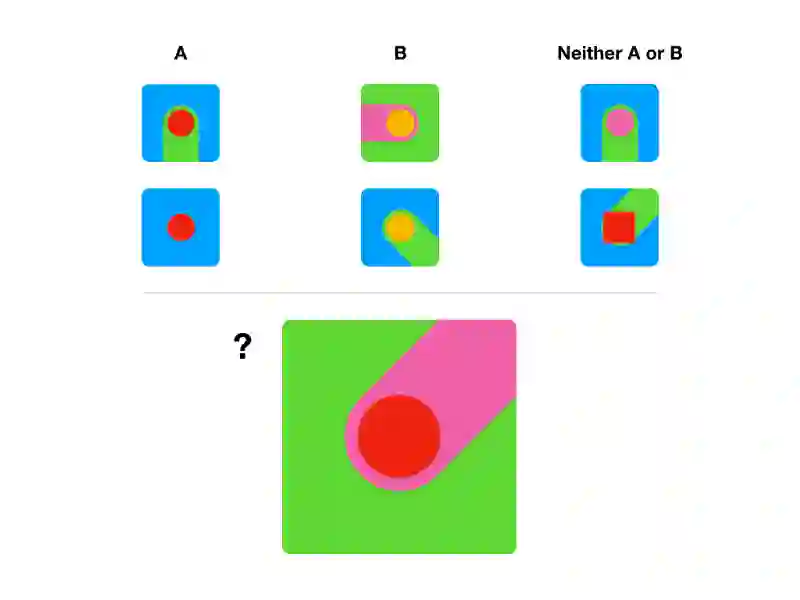

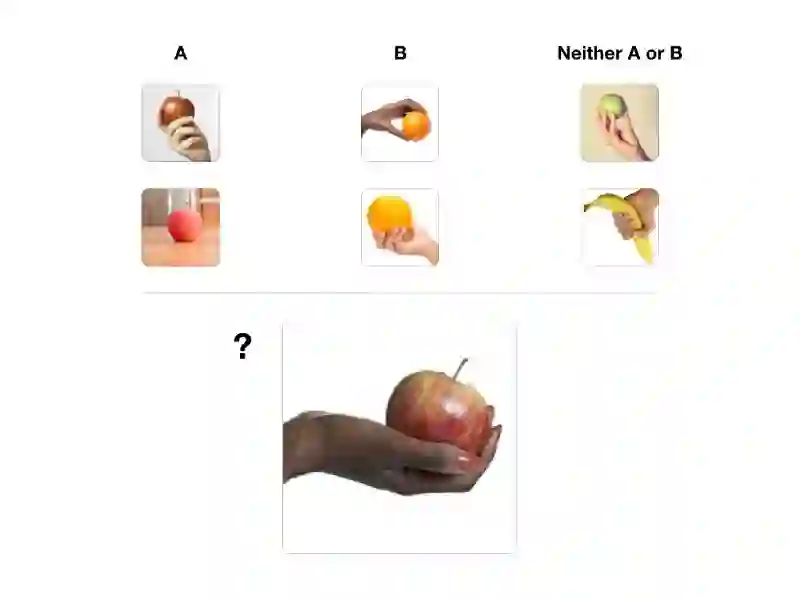

苹果还是橙子?

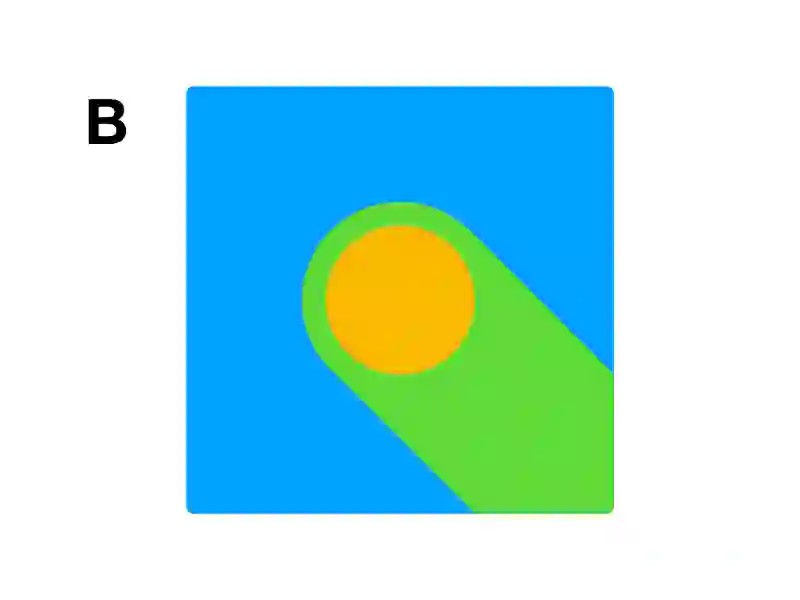

下面是同样的一组图片,只不过没那么抽象了。如果我问你同样的问题,任何人都会立即回答,A是苹果而B是橙子。

这个问题太过简单,许多人甚至认为是脑筋急转弯。我们都知道,手和背景中的一切,都是无关信息,因为我们人类从出生开始,就在学习这些东西。但人工智能并不知道。对于它来说,图像都是抽象的,它并不知道你关注的是什么。

我们来看另一个场景,这个场景能演示,我们可能给了AI系统错误的信号。我们有一些橡树的样例(我住的地方有点阴天)。

下面是一些棕榈树(这些是在阳光明媚的沙滩上的)。

下面这张图是棕榈树,但光照环境与橡树图片更相似。那么,我们该关注哪些因素?光照?还是树的形状?模型很难做出判断。

Confidence:

- Palm 0.75

- Oak 0.60

从这个例子中可以明显看出,我们无意间给AI,留了另一种模式去学习。但实际情况远没有这个例子明显。

我们怎样才能知道AI关注了什么?

我们可以在图片上,放一个矩形框,然后记录下自信值的变化。如果自信值降低,那么遮住的那片,很可能是重要区域。

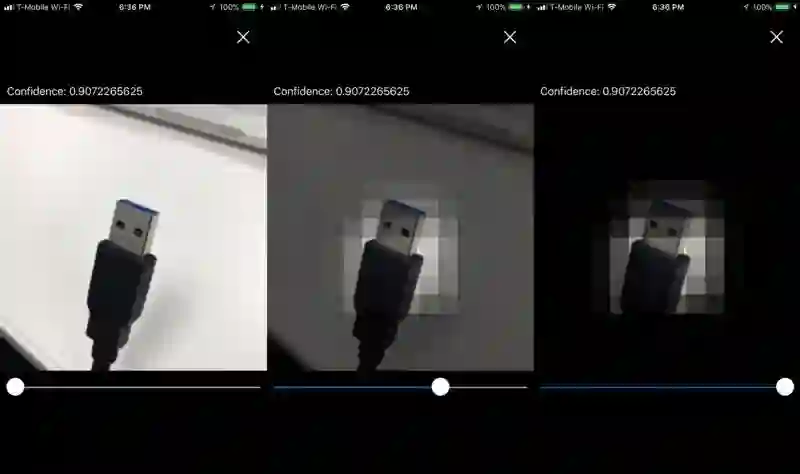

哪张图更能猜出这根线是USB线?

第一张图完全盖住了接口,因此几乎没办法猜出,所以我们认为矩形框盖住的部分是重要的。但在第二张途中,矩形框完全没有影响我们,猜测线缆类型的能力。因此,可以安全地标记这片区域,为不重要的。

我们可以继续在图片上放置矩形,来建立图片重要性的热区图。

可以看出,模型关注的是接口的尖端,这很好。它关注了我们希望它关注的部分。

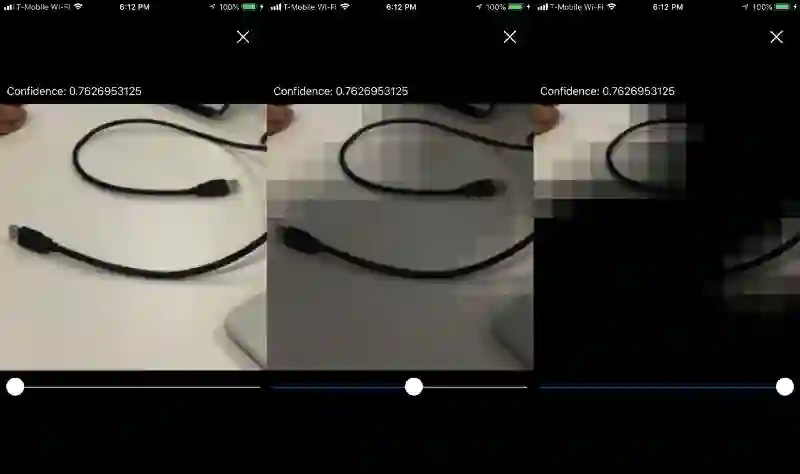

我们来看看一个训练得不太好的模型。

Confidence:

- USB 0.76

模型正确地预测出,线缆是USB,自信值为0.76。这个结果可以接受,特别是在照片距离较远、质量也不高的情况下。

但是,仔细检查后发现,模型似乎关注了错误的地方,而不是我们希望的线缆一端。

模型似乎过分关注了线缆本身和手指。为了提高准确度,我们可以提供更多线缆和手的图片,作为反面训练集。

我们不需要大量的通用数据,来训练模型直到模型变好。利用这些信息作为辅助,可以省下大量时间和金钱。

实验感想

哇,这太棒了!但我不想花精力去实现。但好消息是,你可以在我的GitHub上,找到完整的iOS应用(https://github.com/bourdakos1/visual-recognition-with-coreml)。

建立自己的模型很容易,但建好模型并不代表工作结束了。机器学习最重要的部分永远是输出好的数据。

我们可以让基础的底线,采用类似的姿态、光照条件,并采用稳定的照片对模型进行训练,得到好的模型。之后,可以使用工具和直觉,看看AI的思考过程。

原文:https://hackernoon.com/understanding-what-artificial-intelligence-actually-sees-7d4e5b9e648e

作者:Nick Bourdakos,IBM Watson的计算机视觉专家。

译者:弯月,责编:胡巍巍