打开你的脑洞:NER如何进行数据增强 ?

文 | JayLou娄杰

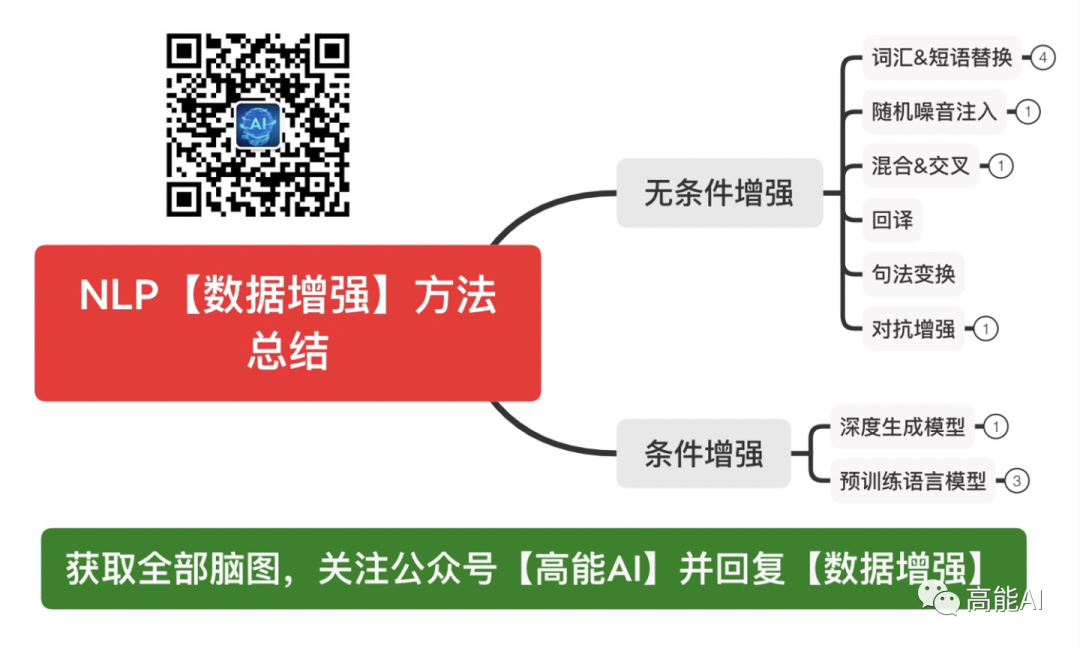

本文首先介绍传统的数据增强在NER任务中的表现,然后介绍一种单独适配于NER的数据增强方法,这种方法生成的数据更具丰富性、数据质量更高。

前言

-

COLING20:《 An Analysis of Simple Data Augmentation for Named Entity Recognition 》 -

EMNLP20:《 DAGA: Data Augmentation with a Generation Approach for Low-resource Tagging Tasks 》

1

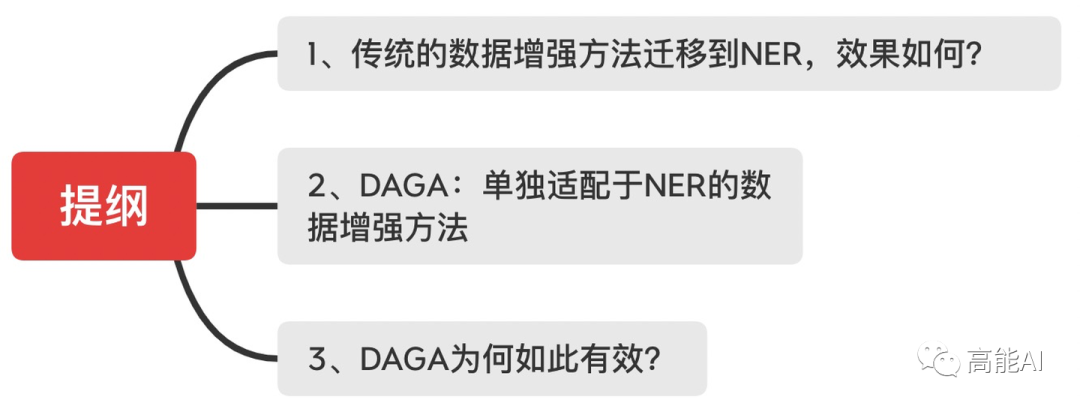

传统的数据增强方法迁移到NER,效果如何?

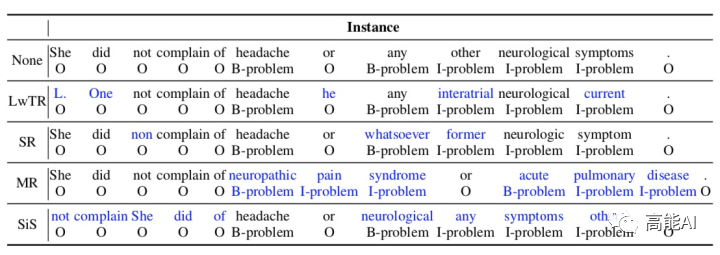

Label-wise token replacement (LwTR) :即同标签token替换,对于每一token通过二项分布来选择是否被替换;如果被替换,则从训练集中选择相同的token进行替换。

Synonym replacement (SR) :即同义词替换,利用WordNet查询同义词,然后根据二项分布随机替换。如果替换的同义词大于1个token,那就依次延展BIO标签。

Mention replacement (MR) :即实体提及替换,与同义词方法类似,利用训练集中的相同实体类型进行替换,如果替换的mention大于1个token,那就依次延展BIO标签,如上图:「headache」替换为「neuropathic pain syndrome」,依次延展BIO标签。

Shuffle within segments (SiS) :按照mention来切分句子,然后再对每个切分后的片段进行shuffle。如上图,共分为5个片段: [She did not complain of], [headache], [or], [any other neurological symptoms], [.]. 。也是通过二项分布判断是否被shuffle(mention片段不会被shuffle),如果shuffle,则打乱片段中的token顺序。

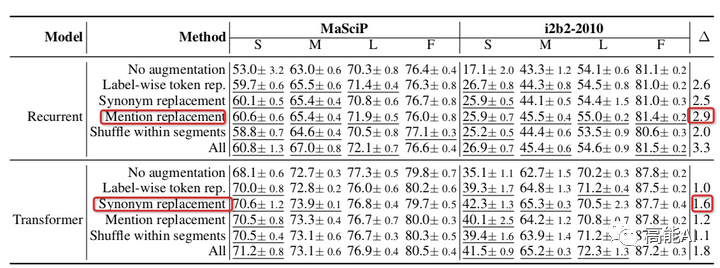

Small(S):包含50个训练样本;

Medium (M):包含150个训练样本;

Large (L):包含500个训练样本;

Full (F):包含全量训练集;

各种数据增强方法都超过不使用任何增强时的baseline效果。

对于RNN网络,实体提及替换优于其他方法;对于Transformer网络,同义词替换最优。

总体上看,所有增强方法一起使用(ALL)会由于单独的增强方法。

低资源条件下,数据增强效果增益更加明显;

充分数据条件下,数据增强可能会带来噪声,甚至导致指标下降;

2

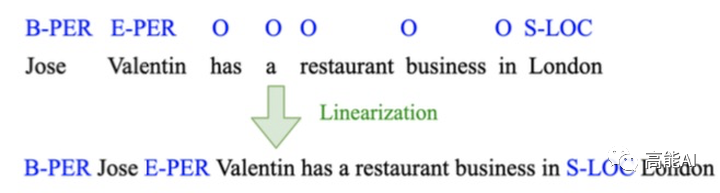

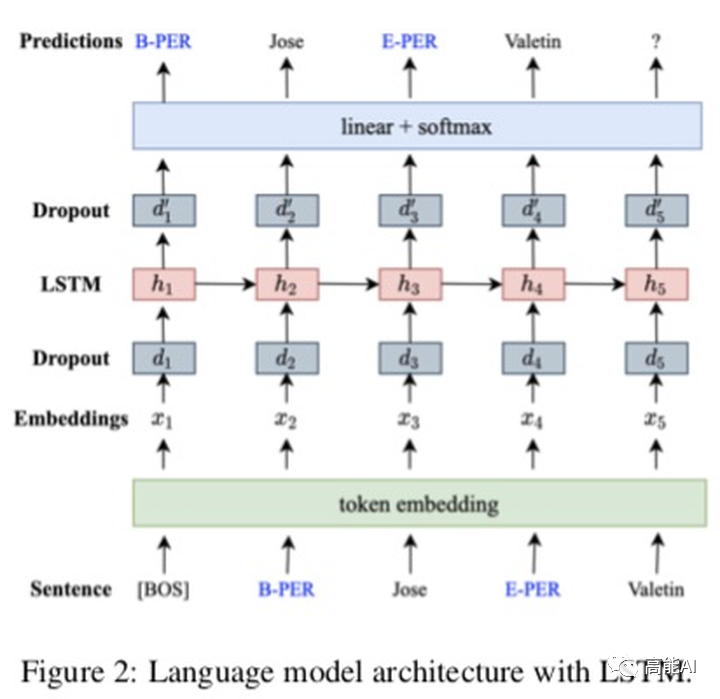

DAGA:单独适配于NER的数据增强方法

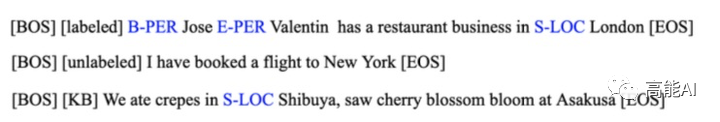

对于标注语料,用[labeled]在句首作为条件标记;

对于无标注语料,用[unlabeled]在句首作为条件标记;

对于知识库,对无标注语料进行词典匹配后(正向最大匹配),用[KB]在句首作为条件标记;

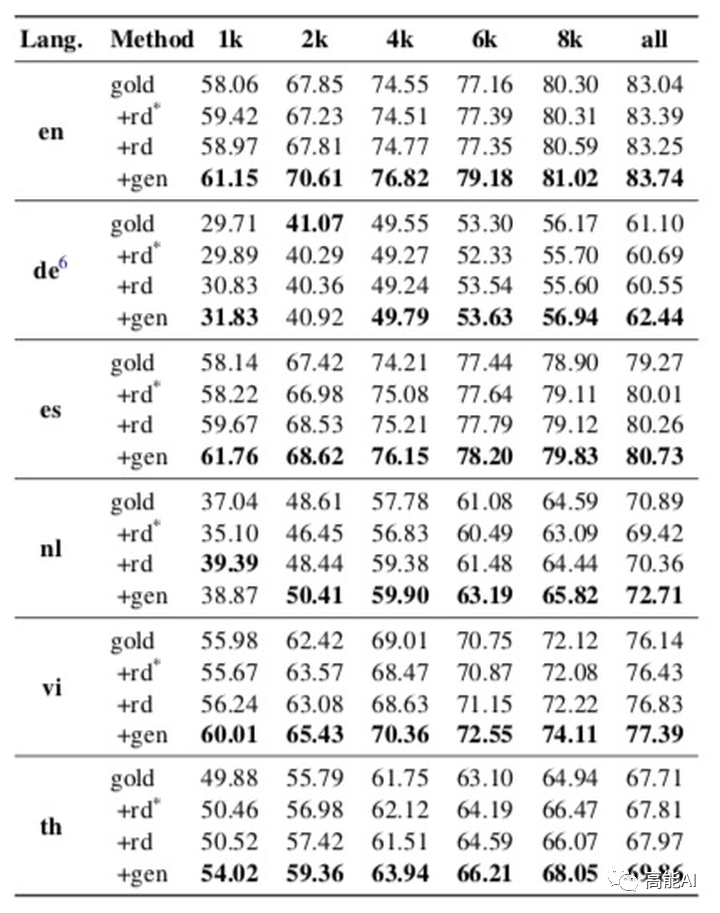

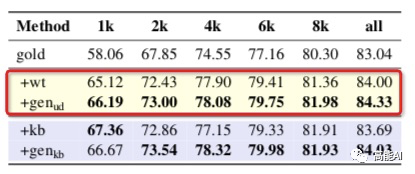

gold:通过标注语料进行NER训练

gen:即DAGA,1)通过标注语料进行语言模型训练、生成新的数据:2) 过采样标注语料; 3)新数据+过采样标注语料,最后一同训练NER;

rd:1)通过随机删除进行数据增强; 2)过采样标注语料;3)新数据+过采样标注语料,最后一同训练NER;

rd*:同rd,只是不过采样标注语料。

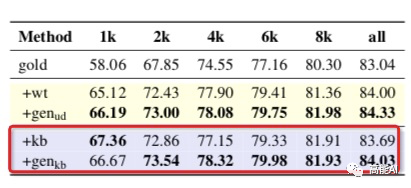

gold:通过标注语料进行NER训练;

wt:即弱监督方法,采用标注语料训练好一个NER模型,然后通过NER模型对无标注语料伪标生成新数据,然后再重新训练一个NER模型;

gen-ud:通过标注和无标注语料共同进行语言模型训练、生成新数据,然后再训练NER模型;

gold:通过标注语料进行NER训练;

kb:从全量训练集中积累实体词典(实体要在训练集上中至少出现2次),然后用实体词典匹配标注无标注语料、生成新数据,最后再训练NER模型;

gen-kb:与kb类似,将kb生成的新数据训练语言模型,语言模型生成数据后、再训练NER模型;

3

DAGA为何如此有效?

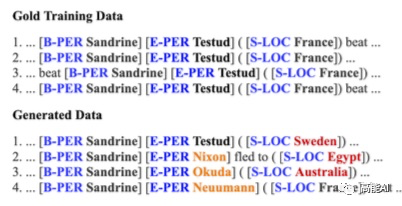

如上图所示,在原始的训练集中「Sandrine」只会和「Testud」构成一个实体span,而DAGA生成的数据中,「Sandrine」会和更丰富的token构成一个实体。

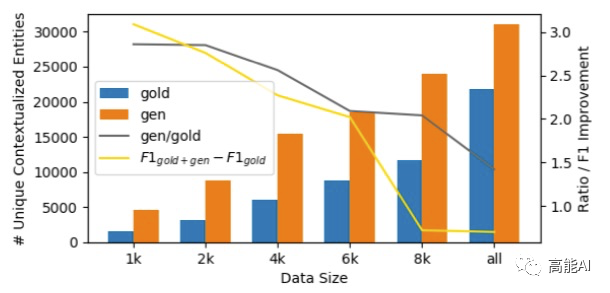

此外,DAGA会生成更丰富的实体上下文,论文以相同实体mention的1-gram作为评估指标进行了统计。如下图所示,桔色代表DAGA生成的实体上下文,比原始的训练集会有更丰富的上下文。

4

总结

虽然传统的数据增强方法也可用于NER中,不过,JayJay认为:传统的数据增强方法应用到NER任务时,需要外部资源,且数据增强的丰富性不足、噪音可能较大。

基于语言生成的DAGA方法是NER数据增强的一种新兴方式,再不利用外部资源时会有较好的丰富性、数据质量较好。

由于微信平台算法改版,公号内容将不再以时间排序展示,如果大家想第一时间看到我们的推送,强烈建议星标我们和给我们多点点【在看】。星标具体步骤为:

(1)点击页面最上方"AINLP",进入公众号主页。

(2)点击右上角的小点点,在弹出页面点击“设为星标”,就可以啦。

感谢支持,比心

推荐阅读

征稿启示| 200元稿费+5000DBC(价值20个小时GPU算力)

完结撒花!李宏毅老师深度学习与人类语言处理课程视频及课件(附下载)

模型压缩实践系列之——bert-of-theseus,一个非常亲民的bert压缩方法

文本自动摘要任务的“不完全”心得总结番外篇——submodular函数优化

斯坦福大学NLP组Python深度学习自然语言处理工具Stanza试用

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLPer(id:ainlper),备注工作/研究方向+加群目的。

阅读至此了,分享、点赞、在看三选一吧🙏