SIGIR2021 | 基于特征交互学习的门控增强多任务神经网络用于CTR预测

| 作者:YEN

| 研究方向:推荐系统、计算广告

深度神经网络(DNN)模型已被广泛应用于在线广告点击率(CTR)预测。CTR训练框架通常由嵌入层和多层感知机(MLP)组成。在百度搜索广告系统中(又名凤巢,Phoenix Nest[1]),新一代的CTR训练平台变成了PaddleBox,一个基于GPU的参数服务器系统。

在这篇论文中,作者介绍了百度最近更新的CTR训练框架,称为门控增强的多任务神经网络(GemNN)。特别地,他们开发了一种基于神经网络的多任务学习模型用于CTR预估,它以粗粒度到细粒度的方式逐步减少候选广告,并允许上游任务与下游任务之间的参数进行共享,从而提高训练效率。此外,作者还在嵌入层和MLP之间引入了门控机制,用于学习特征交互和控制传递到MLP层的信息流。

作者在百度PaddleBox平台部署了该模型方案,并观察到在离线和在线评估方面都有相当大的改进,它现在已经是百度广告系统的一部分。

本文结构:

广告系统背景

提出的GemNN模型

基于多任务的模型 Multi-task Neural Network based model

门控增强的多任务模型 Gate-enhanced Multi-task NN model

实验效果

离线实验

在线实验

消融实验

广告系统背景

工业广告系统通常从数以百万计的候选广告中选择和排序广告。一个常见的做法(如百度的MOBIUS[2])是利用多层漏斗形结构,在几个阶段交付广告:通常包括候选广告生成阶段和重排序阶段。候选生成阶段将语料库从数百万缩减到数千或数百,重排序阶段估计候选广告的ctr和cpm,并向用户提供排名靠前的广告。

值得注意的是,在工业广告系统中,重排序通常有几个子步骤,其中每个子步骤都有一个神经网络模型来减少候选广告。例如,我们可以首先根据用户查询(user quer)和广告特征(ad features)对广告进行排序,然后结合广告素材类型(ad material types)和可能的排序信息对广告进行重新排序,最后向用户提供一些排名靠前的广告。

工业环境中存在着众所周知的挑战。

-

首先,用户、广告和广告素材类型通常包含较大的规模的类别特征,由于稀疏特征嵌入,将导致模型参数数量巨大。 -

其次,有效的特征交互对CTR模型的成功至关重要,因为它们提供了单个特征之外的额外交互信息。

许多模型被提出来进行特征交互建模,但是很少有人在实际工业生产环境下研究它的计算和延迟限制。

在这篇论文中,作者介绍了百度最新的CTR预测框架,称为Gate-enhanced Multi-task Neural Networks (GemNN)。具体地说,他们提出了一种基于神经网络的多任务学习模型,以粗粒度到细粒度的方式进行广告排序,它允许上层任务与下层任务之间的参数共享,提高训练效率。

与普通多任务神经网络模型在任务间共享中间层的方式不同,GemNN方法利用上游和下游任务之间的共性来共享参数,避免了的复杂计算。此外,作者在嵌入层与MLP之间引入了门控机制模拟特征的真实交互,并学习对MLP输入的比特级特征的重要性(bit-wise level feature importance)。

提出的GemNN模型

给定用户的查询(query)和检索阶段的相关候选广告,作者的目标是设计一个框架为用户提供几个高排名的广告,包括排序和它们对应的素材类型(material types, 缩写为mt),例如大小、位置、表示等 (size, position, representation)。虽然在检索阶段之后,我们的候选广告空间变小了很多(从百万到几千或几百了),但广告、排序和素材类型的组合空间仍然很大。

基于多任务的模型 Multi-task Neural Network based model

为了在实际生产环境下,在计算量和延迟限制的约束下得到一个可行的解,作者将重排序过程粗略地分解为三个任务。

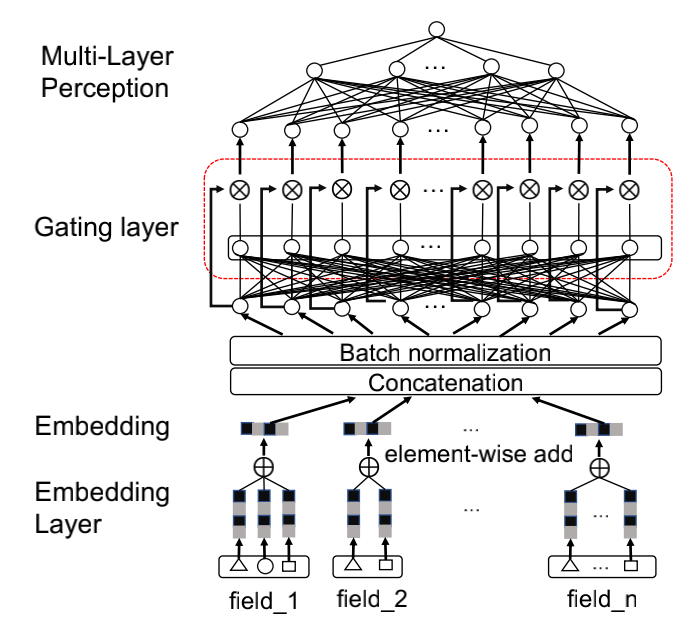

对于每个任务,GemNN都从一个嵌入层开始,然后是一个门控层,该门控层为显式特征交互建模,并选择显著的特征信息。同时,GemNN允许从粗(上游)任务到细(下游)任务的参数共享。接下来首先介绍这三个任务,然后下一小节描述如何将门控机制引入其中。

-

User-ad ranking (UAR):这是一个粗粒度的任务,它从检索阶段(retrieval stage)获取到用户查询和广告候选项生成更短的广告列表(例如<20)。作者将其转化为一个二分类问题,并使用交叉熵损失,这是学习二分类标签(例如,是否点击)任务的常用方法。由于这个任务只使用广告的粗略特征,如id和竞价词(ids and bidding words),因此该任务仍然作为一个检索模型(retrieval model),以减少广告空间。

-

Ad-mt matching (AMM):根据查询-广告排序任务(query-ad ranking task)中排名靠前的广告候选,AMM为每个筛选出来的广告选择素材类型,以便使得它将有更高的被点击的概率。作者采用双塔式DNN模型匹配广告和所有可能的素材类型。使用双塔模型的原因是,素材类型特征嵌入可以预先计算和索引,这将在广告服务节省大量的时间。同样,作者也将这个任务转换为一个二分类问题。被点击广告的那个素材类型的是正样本,未点击广告的素材类型是负例。

-

User-ad-mt ranking (UAMR):通过查询广告排序(query-ad ranking)获得更短的广告列表,并从Ad-mt(ad-mt matching)匹配中选择出的素材类型,UAMR利用所有可用的特征,根据预估的cpm,生成带有素材类型信息的最终top广告。这个任务是最细粒度的,它根据所有可能显示的广告队列来估计点击率和CPM。与前两个任务类似,作者也将其转换为一个二分类问题。

从上面的描述中,我们发现这三个任务实际上在用户和广告之间有许多共同的特征。为了避免对这些特征的重复建模,可以从粗粒度任务到细粒度任务进行参数共享。提出的共享模型如下图所示:

具体的,作者利用用户和广告的共同特征构建UAR模型(最左边),然后将第一层MLP从UAR及其预测的CTR (pCTR)值共享给AMM任务(中间)和UAMR任务(最右边)。特别的,共享参数被连接到嵌入层在AMM(左广告塔)和UAMR作为暖启动的特征。在训练过程中,作者联合优化这三个任务,并在冻结共享pCTR特征的同时从UAR更新了共享的MLP层。这样的设计将三个任务无缝连接起来,允许从上游任务到下游任务的参数共享。

门控增强的多任务模型 Gate-enhanced Multi-task NN model

许多知名的深度模型 (e.g. LSTM, GRU, MMoE)中都使用了门控机制。如下图所示,这篇文章也使用门控机制来控制流向下游层的信息流(门控网络在各个任务中是不共享的):

代表element-wise product.

实验效果

作者从百度搜索广告系统收集了一段时间的用户点击历史日志进行评估,并进行了在线和离线实验。

离线实验

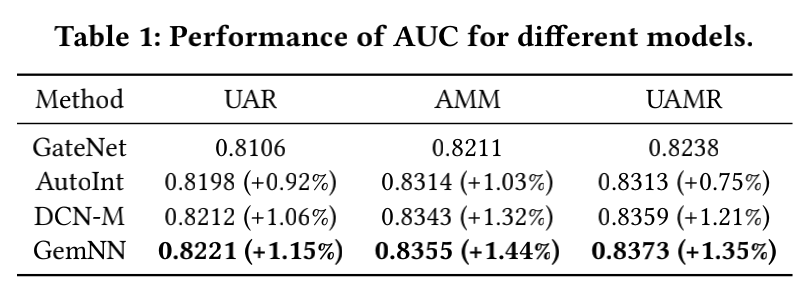

下表是各个任务与Baseline的AUC对比:我们可以观察到,提出的GemNN在AUC离线评测中表现最好。

在线实验

-

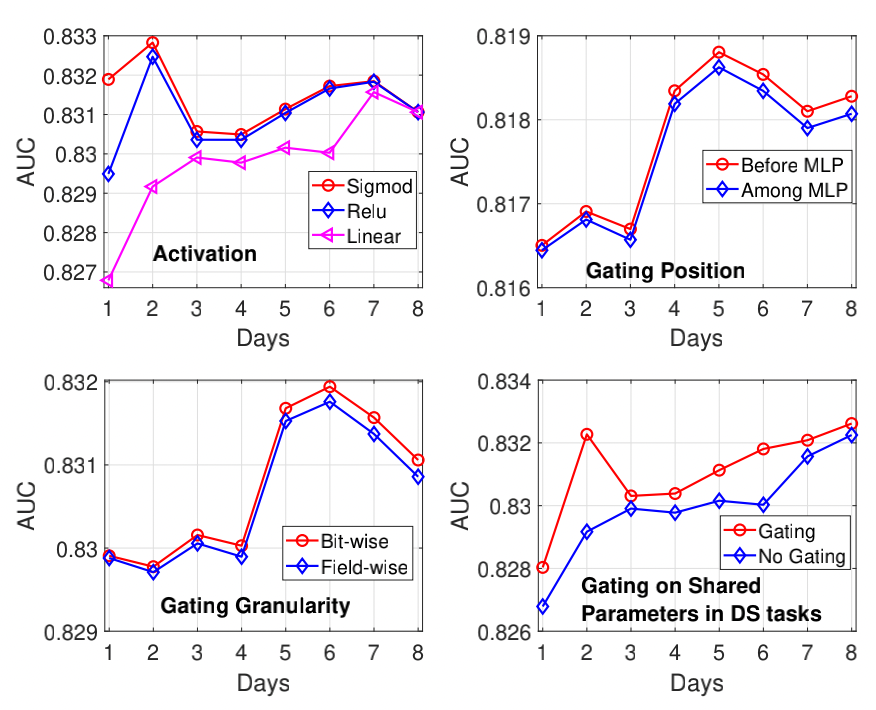

不同的激活函数:ReLu优于线性函数,对门控层的最佳激活函数为Sigmoid。 -

门控层位置研究:我们观察到嵌入层和MLP之间的门控机制有助于GemNN更有效地捕捉隐式高阶特征交互。 -

门控粒度研究:我们发现bit-wise的门控比field-wise的门控表现更好。 -

是否在任务共享参数上使用门控网络:使用门控网络后效果更好。

消融实验

下表研究每个成分对GemNN模型的贡献。

参考资料

www.paddlepaddle.org.cn: .

[2]MOBIUS Towards the Next Generation of Query-Ad Matching in Baidus Sponsored Search: KDD,2019.