开启无人驾驶的“上帝视角”

【转自】雷锋网(公众号:雷锋网)按:本文作者徐超(微云车联CEO,佐智汽车联合CEO) 及 李林峰(武汉海微CEO)。雷锋网独家约稿文章。

“横看成岭侧成峰,远近高低各不同。不识庐山真面目,只缘身在此山中。”东坡居士《题西林壁》近千年前就点出无人驾驶的现状。

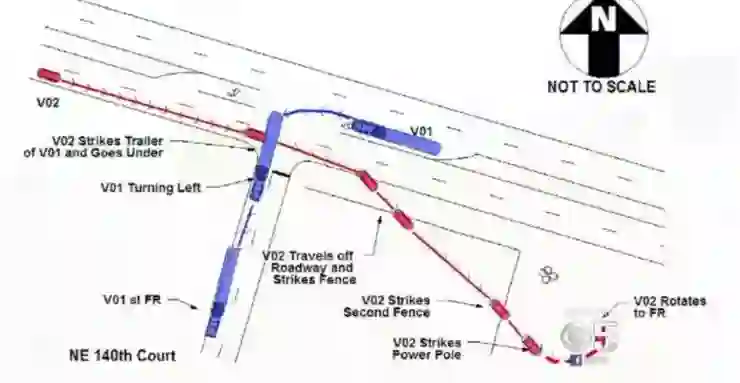

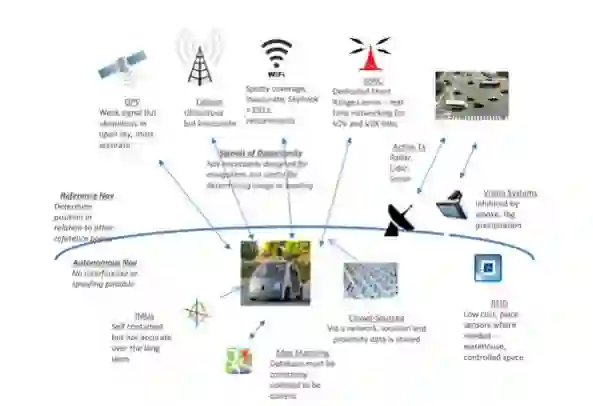

图1:特斯拉Autopilot致命事故现场示意图

图2:事故车照片

2016年5月7日美国佛罗里达州发生一起开启Autopilot模式的Tesla Model S致死事故,车主约苏亚·布朗(Joshua D. Brown)命丧当场,布朗生前是一名狂热的特斯拉自动驾驶爱好者,在YouTube上有若干Autopilot系统的路测视频。愿逝者安息。

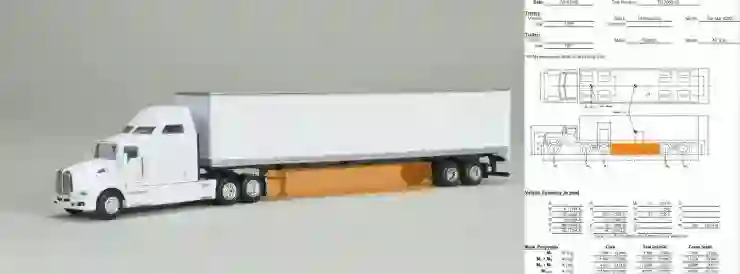

图3:V01大拖车外形及尺寸参考

参考尺寸中,拖头后轴和拖车前轴距离是9.85米减去两个车轮半径即为拖车底部空间(橙色部分)的长度8.85米/高度约1.2米,而估算拖车宽约3.5米。

图4:特斯拉尺寸参考

特斯拉Model S高1.45米/宽2.2米/长4.98米,橙色为事故中被拖车削掉的部分。

网上已有一大波此事相关的文章、评论和专题,其中不乏专业人士的悉心解读,而在NHTSA的调查报告出来之前,基于有限的信息却很难得到准确的结论。但不可否认,这些评论、解读、讨论甚至争论,不管正确与否、专业程度如何,都将为智能网联汽车这个行业带来前所未有的思考和进步。

“无人驾驶,不考虑安全等于谋杀,不考虑舒适则是耍流氓”这是老查(徐超)的观点。借此次特斯拉事件,拉上好兄弟峰哥(李林峰)一起来谈谈“开启无人驾驶的上帝视角”。

大多数的第一人称射击(FPS)和运动模拟(SPG)游戏都是主观的“人类视角”

图5:CoD现代战争 和NFS极品飞车的人类视角

而即时战略(RTS)、塔防(TDS)和模拟建设(SIM)游戏,如:红警、魔兽、DotA等几乎都是“上帝视角”

图6:红色警戒2和 模拟城市的上帝视角

介于两者之间,还有个Bird View鸟览追随视角,常用到小区域的增强现实,例如ADAS环视系统:

图7:NFS极品飞车和神庙逃亡的追随视角

图8:FPS游戏中的鹰眼视图

第一人称人类视角的体验最接近现实,但整体感知力最弱,这也是为何在大部分FPS类型的游戏中,会在屏幕角落增加一个Eagle View鹰眼视图,让玩家宏观的掌控全局。

同样,本文开头那幅现场示意图,将整个事故场景简单清晰的还原,这也是那段分析视频一夜疯转16万vv的主要原因。而随后的照片虽做到“有图有真相”却完全无法让各位知道事故的全貌。所以,还原真相还需“上帝视角”才能浅显易懂。

既然各位都要以上帝视角方能迅速理解整体状况,又怎能要求比人“笨得多”的机器只站在第一人称的人类视角来学习和处理数据,并迅速准确的识别和决策呢?所以,仅从人类视角考虑未来的无人驾驶,传感器不够就拼命加,角度和精度不够就玩命升级,加之深度学习和人工智能算法和软硬件平台的不断演进和运算性能不断提升来推动无人驾驶的发展,这条路真的对么?

无论城市规划、军事调度等宏观控制还是具体的导弹制导、飞机自动驾驶的实际执行,几乎都把人类视角采集数据实时处理排除在主要手段之外,有些甚至连辅助都谈不上。

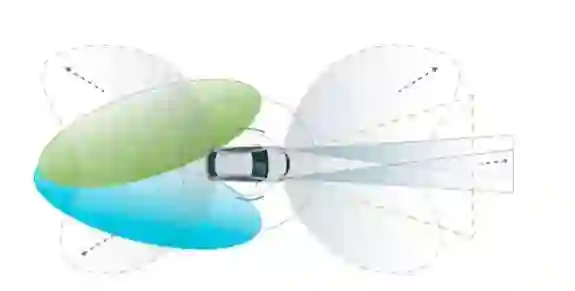

图9:单体感知的传感器配置

即便NVidia Drive PX2的250W牛掰功耗,NXP BlueBox的2xAPEX2CL+4xA53+GC3000+8xA57的顶级配置或者Mobileye EyeQ5的12Tera/s的碉堡运算能力,配上成本数万到数十万不等的感知前端统统装车,观察和感知甚至运算处理能力全面达到或超越人类,却由于交通参与者的行为的不可完全预知性,处在人类视角的这些“次世代超级计算机”们总归还是会有不小的概率出现漏判或误判。无人驾驶的感知和决策并非儿戏,任何一次失效,无论是感知、融合、决策部分出问题都人命关天。低端不够用,高端极贵却也不能完全保证准确可靠。单成本一项,已很难将有效的无人驾驶普及到每辆车,更不用说全部交通参与者。

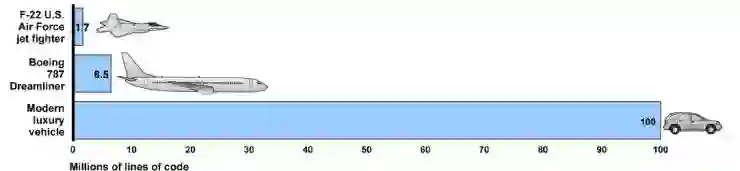

图10:F22/B787/豪华车代码量对比

而大量设计冗余带来的代码量和成本急剧增加,以及伴随而来的系统复杂度大幅提升整体可靠性下降,也是不容忽视的问题。

图11:2013年度Euro NCAP AEP评测结果

峰哥(李林峰)某日驾Golf 7顶配携全家老幼出游,兴奋开启AEB功能,准备炫耀一番,怎奈频繁“无故”急刹,两位公子嚎啕大哭,最后被峰嫂骂到狗血淋头收场,无奈之下只好关掉此功能且自此未再开启。作为Euro NCAP评测得分2.2 Good的车型,如此安全性是足矣,但保守的策略却严重牺牲了舒适性。当然,有人说,比起丢命,舒适与否不重要。老查(徐超)则问:这种枉顾用户感受系统要来作甚?

每个无人驾驶的系统架构师和编写策略的程序员都想做个好人,但在单体感知和单体智能的路径下,却成天在成为“杀人犯”或者“强奸犯”的选择上左右摇摆。站在单纯的人类视角,任何人都不敢肯定自己的感知和决策的实现“准确而完美”,现在不敢,将来也一样不敢。

除非,从下面几个角度来开启“无人驾驶的上帝视角”:

宏观的层面和角度观察和感知交通的整体状况

当前的无人驾驶,主要靠安装在车辆上的视觉、毫米波/超声波雷达和激光LiDAR等传感器来感知周边环境状况,用智能决策和执行单元来控制车辆的行为。

而在上帝视角的无人驾驶环境,可以考虑将原本安装在车上的感知系统作为固定基础设施部署在交通环境复杂的路段,成为路侧感知单元RSSU(Road Side Sensors Unit),而通行率低的乡间路段可以依赖现有的车载感知模式作为驾驶辅助,或则暂不允许无人驾驶模式。如此可以解决很多当前的实际问题:

感知系统和决策系统成本不会落到车辆终端;

新的感知设备和算法可以统一规划统一升级;

可以立法规定哪些是“无人驾驶”路段,哪些不是;

路侧的感知及相关电子设备的可靠性和成本级别将从“车载”降到“工控”;

此处有人会说,这是L3而不是L4,不是完整意义的无人驾驶。那咱们从驾驶行为、核心目的和普及成本来分析,只要车载无人驾驶系统有成本存在,就会有人选择不安装,要走到法律强制全部安装的程度,成本差异必需降到某个极低的程度。若真如此,那么作为基础设施部署的成本同样会大幅降低。

具体场景以多种感知和模式匹配来做移动物体的识别

车载单体感知决策系统要用不断升级硬件和深度学习、人工智能算法及系统来适应“全部”可能的场景,即使该车99%的时间都在某个区域道路行驶,只有1%甚至0.001%的机会去陌生的地方,那么系统也要为此做100%的准备,不容许一点错误,这种冗余是必要但不经济的。

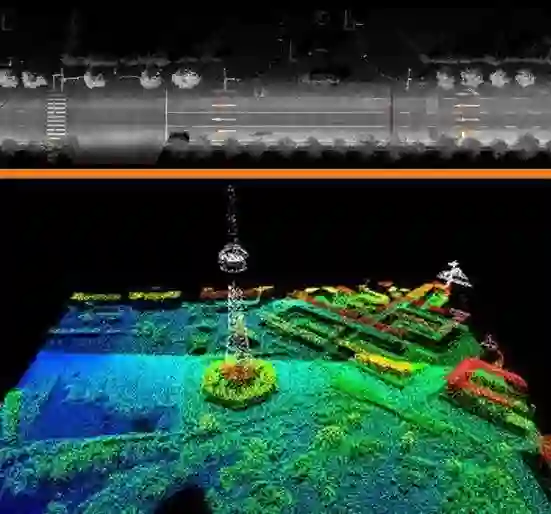

图12:用LiDAR测绘的道路和城市点云

而在上帝视角下,LiDAR、视觉系统和毫米波雷达是安装在类似路灯的位置,每组传感系统根据其负责的200m~1km道路的具体情况,可有不同成本的配置。感知和识别部分只需做固定点云为基础的差分图像处理,兼顾地理和气候环境的变化即可,例如加入雨雪路面湿滑、风向、能见度以及动物迁徙等参数,这些辅助信息比较容易实现。

在熟悉的静态环境中感知识别动态的物体,相较于所有周边环境陌生去做同样的事情,无论效率还是准确性都会提升不止一个数量级。

交通参与者上报精确的位置、状态信息以及行动意图

在此前的文章之中,老查提到发展无人驾驶,不能只注重单体感知和单体智能,交通是多方参与的。此次逝去的布朗先生,在2016年4月10日的一段视频中也拍摄了一辆大货车疯狂并线时特斯拉Autopilot系统的无奈和无助,而5月份流传网上的那个特斯拉ACC加速追尾故障大客车的视频也历历在目。“只要自己足够聪明,周边全是傻逼也无所谓”的观念是完全错误的。

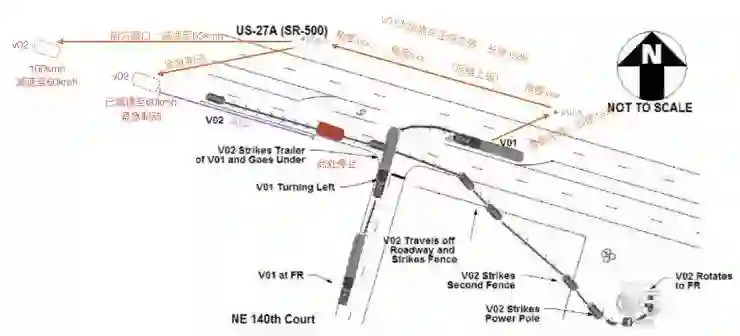

除了路侧RSSU的感知和处理,从车辆到未来的行人甚至阿猫阿狗,都可以装上高精度的定位单元和V2I/V2V通信单元,放在路侧的这些设备,其技术稳定性(可以几十年不变)和成本,相对车载系统来说亟具优势。譬如说此次事件中V02 Tesla Model S上有差分或者星基地基增强的GNSS和V2I/V2V模块,而V01长拖车的拖头Tractor有一个GNSS增强模块,拖车Trailer有两个,就能在定位其准确位置的同时实时获取车身姿态。

图13:包含GNSS和网联系统的V01和V02

配合一个或者多个路侧通信单元RSCU和路侧感知单元RSSU,由V01提前向RSU-A上报自己的转弯意图并提交自身的形态信息,那么该RSU-A则可在V01开始转弯之前通知临近的几个RSU,例如RSU-B,并不断报告V01的位置和姿态以及道路占用情况,临近RSU的在数公里以外就通知所有可能会受影响的车辆包括V02,而RSU-B即使没有来自RSU-A转发的V01信息,也可提前通知V02“前方有交岔路口,降速运行”,如此本次事件可完全避免。

宏观感知的结果做融合分析,制定并不断完善调度策略和安全边界

有RSSU的感知以及RSCU的通知,那如何来做决策,这就是以前文章中提到过的,分布式信息处理机制。每个RSCU/RSSU都要负责自己区块的决策并通知相邻区块,对于各种不同的事件级别,相邻区块根据“总体策略矩阵Global Policy Matrix”来选择对车辆的通知,接收到通知的车辆,可以或必须将车速迅速控制在安全边界范围之内,进入紧急区块后,可按指令全部强制自动安全停靠。区域中央控制节点RCCU,则负责基于大数据分析、学习后的策略矩阵优化、下发以及全区紧急事件的通知。

图14:完整的智能网联汽车的信息图

要做到上帝视角,还需要实现如下几个关键技术:

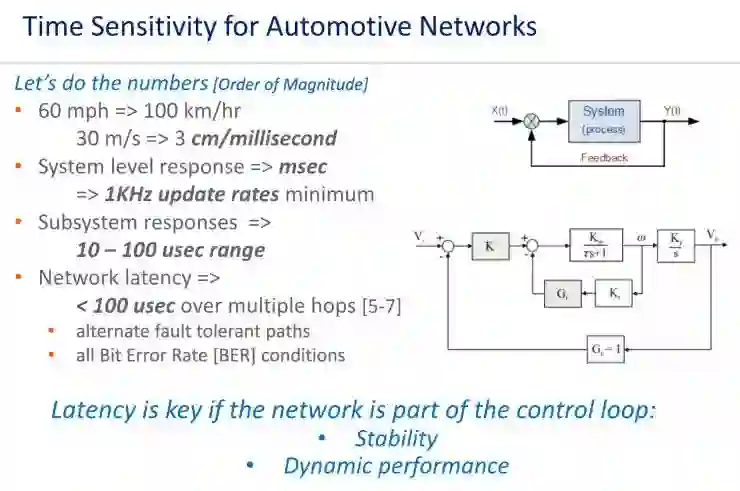

1、能提前对RSU报告自身后续行为意图及尺寸、状态等信息,V2V/V2I通信、感知决策、执行低延迟

图15:Spectracom计算的纯通信模式无人驾驶所需的网联延迟

通常情况,802.11p 技术的延迟为 50ms,使用 LTE-A 技术的延迟约 42ms,而使用 5G/LTE-V的延迟为 1ms,新一代5.9GHz DSRC可做到0.2ms。可见即使5G和5.9GHz的DSRC也无法独立的完成无人驾驶。但上帝视角有两个核心关键词“宏观”和“预判”,所以对于实时性反而没有人类视角那么高的要求。上帝视角中的网联部分V2V/V2I和I2X技术已经可以做到“超感知距”,跨越一个RSCU/RSSU不行,就两个,两个不行就n个,RSCU之间的通信延迟是固定的,多组联动,则可用来处理事件的安全距离和冗余时间大大增加。而RSSU除了监控道路,也可以监控道路外侧的一些潜在和其他交通参与者的行为和路径,其中包括准备穿越道路的麋鹿、灰熊等大型动物或者蟾蜍群等小型动物群。

当然,涉及到网联系统,就存在网络信息安全问题。首先,这个网必须是专网;其次从立法的角度,攻击银行的网络系统,叫做金融信息犯罪。而攻击智能网联汽车和相关设施,则应以谋杀论处。

2、高精度的坐标定位及运动追踪系统

传统的GPS/GNSS系统10米级别精度,显然是不够用的。动态状况下综合考虑部署成本和实用性的亚米甚至厘米级别的定位系统,是开启以宏观指挥调度为基础的上帝视角无人驾驶的必要条件。

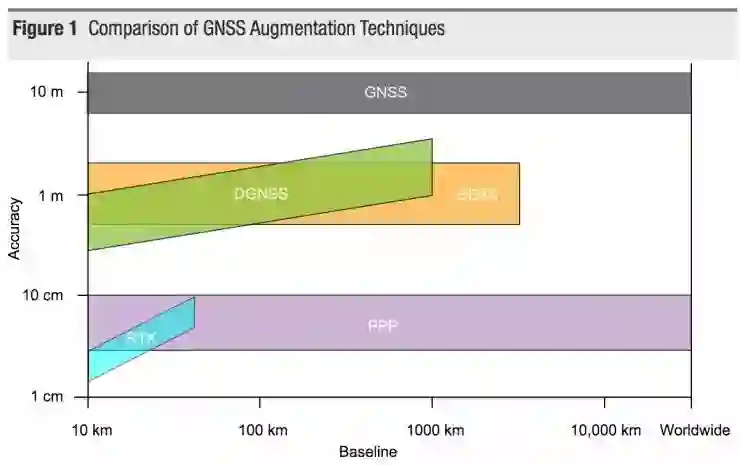

图16:GNSS及各种增强系统的精度对比

由上图(出自《Precise Positioning with NovAtel CORRECT Including Performance Analysis》)可知。传统GNSS系统无论在怎样的基线范围,其精度都只能达到10米级,而SBAS星基增强系统能达到5000km基线下的米级精度,差分DGNSS在1000km基线内提供亚米级到米级的精度,而基于RTK模型的PPP以及实际广域应用的CORS连续运行参考站,已经可以达到全球覆盖范围内的2~10cm级别精度。

在低成本的CORS+SBAS配合下,以本地IMU惯性测量单元做数据密度的辅助填充,使得数据输出从Hz提高到100Hz以上级。完全能达到“车道线级”定位及10ms时间片姿态/位置上报的需求。

那么上帝角度的潜在问题以及应对方法是什么?

覆盖成本较为高昂。应对:让主机厂们把准备投入无人驾驶车辆单体部分的成本拿出一定比例交给政府做基础设施建设,在道路建设改造时将无人驾驶相关设施设备和规范强制实施。

不按意图和预测运动的交通参与者。应对:对于突然转向的电动车和突然闪出的老太太,仍需本地感知智能系统和司机本身来处理。当然,立法角度也可将违规者定为过失方。

网联信息安全问题。应对:魔高一尺道高一丈+苛以重罪。

上帝也疯狂!各节点进入疯狂AlphaGo模式,准备消灭人类。应对:每个城市应标配一个威尔·斯密斯或者基努·里维斯。

图17:上帝也疯狂,Rushing or Crash

开启无人驾驶的上帝视角,听起来美好,但单体感知和智能化至少目前来看还非常重要。一来,毕竟人类聪明一些,上帝也轻松一些,二来,上帝视角所需的基础设施的架构、标准和部署都远远不够。只是综合、宏观和长远的考量,不能也没必要无节制的提升单体能力,搞单车系统的“军备竞赛”。

传统汽车数百年的积淀和底蕴,很多层面并非简单以IT系统和“互联网理念”所能颠覆,而主机厂和大型Tier1们严谨的流程,虽然感觉让某些新生事物事情进展不那么飞速,但总体来说稳定可靠。

传统厂商要向新玩家学习新的理念和视角,而新玩家必须对传统有“敬畏之心”,少说“颠覆”。无论是从业者还是用户,既要肯定特斯拉和相关供应商的勇气和对行业的促进,中肯客观地看待其在宏观改善驾驶体验降低事故和事故死亡率方面的努力,也要深刻的认知到新技术的过度宣传和误导将给用户甚至产业造成的无法弥补的损失和伤害。

Elon Musk只是一个人,是媒体和资本把他包装成神,这样的疯狂造神运动下,带来对产业的严重伤害,而布朗先生只是这种伤害下一个具体的牺牲者。然而从另一个角度,如果没有资本的加持,特斯拉和各个互联网造车企业都很难走到今天。资本市场快速套利的劣根性则注定了这场悲剧的发生。反观Google也好Musk也罢,却都在布局“上帝视角”,无论Space X降低轨道卫星的发射成本,还是Google X的低空气球卫星通讯覆盖计划,让低成本布局自主可控的广域数据链,摆脱多年来传统运营商对通讯系统的把持和禁锢成为可能。

曾和一些资本圈子的朋友深度交流他们对汽车产业投资的看法,其中一种真实的观点:“汽车产业虽然资本体量大,但是周期长,涉及环节多,时间风险大,不像TMT行业,试错成本低,速度快。既然资本不缺乏TMT等行业的项目,那么对于汽车行业大多只能以观望为主。”

老查(徐超)则认为,只要不过分急功近利,智能网联汽车相关领域的投资大有可为,从本文开启无人驾驶上帝视角的实现需求来看,至少有几个方向值得深度关注:低成本高精度定位、自主可控的ECU及执行单元和相关系统、中短距低延迟通讯系统(包括DSRC/WAVE、LoRA和Li-Fi)、广域物联通信(LTE-V、LTE Cat-0/M1/M2)、深度学习、大数据、乘员状态监控、新型HMI系统、AR系统在交通领域的应用、低成本传感器及融合系统及其相关SoC片上系统设计等。

回到无人驾驶的发展路线本身,一个深邃的疑问让大家共同思考:“是否有上帝视角无法实现而只有人类视角才能实现的无人驾驶功能或场景?”

附作者介绍:

徐超:互联网、集成电路起家,车联网、汽车电子、智能网联汽车创业,既能与专家学者谈笑鸿儒,亦能和奸商土豪山寨佬们推杯换盏。目前作为佐智汽车(JointWyse Automotive)的战略投资人和联合CEO,在智能网联汽车评测评估、场地建设、咨询和运营方向快马加鞭;作为微云车联(WayWings)的创始人及CEO,则在智能网联平台和云服务领域全力布局。

李林峰:武汉海微 CEO。汽车电子、总线、地图导航、空间地理、测绘学专家,有史以来(可能是)厨艺最好的产品架构师。目前作为海微科技(Highway Tech)的创始人及CEO,在ADAS、高精度定位导航、下一代HMI系统上极速前行。