©PaperWeekly 原创 · 作者|黄飘

学校|华中科技大学硕士生

研究方向|多目标跟踪

最近一年里,随着 Tracktor++ 这类集成检测和多目标跟踪算法框架的出现,涌现了很多相关的多目标跟踪算法变种,基本都位列 MOT Challenge 榜单前列,包括刚刚开源的榜首 CenterTrack。这里我就对集成检测和跟踪的框架进行分析 ,相关 MOT 和数据关联的基础知识可以去我的专栏查看,后期我也会针对基于深度学习的数据关联、ReID2MOT 和 SOT2MOT 等进行专题介绍。

D&T

论文标题: Detect to Track and Track to Detect

论文作者: Christoph Feichtenhofer, Axel Pinz, Andrew Zisserman

备注信息: ICCV 2017

论文链接: https://arxiv.org/abs/1710.03958

代码链接: https://github.com/feichtenhofer/Detect-Track

当前的多目标跟踪算法主流是基于检测的框架,即 Detection based Tracking (DBT),所以检测的质量对于跟踪的性能影响是很大的。

那么在 MOT Challenge 上也分别设置了两种赛道,一种是采用官方提供的几种公共检测器的结果,即 public 赛道,一种是允许参赛者使用自己的检测器,即 private 赛道。

这篇 D&T 就属于 private 类跟踪框架,并初步将检测与跟踪框架进行了结合:

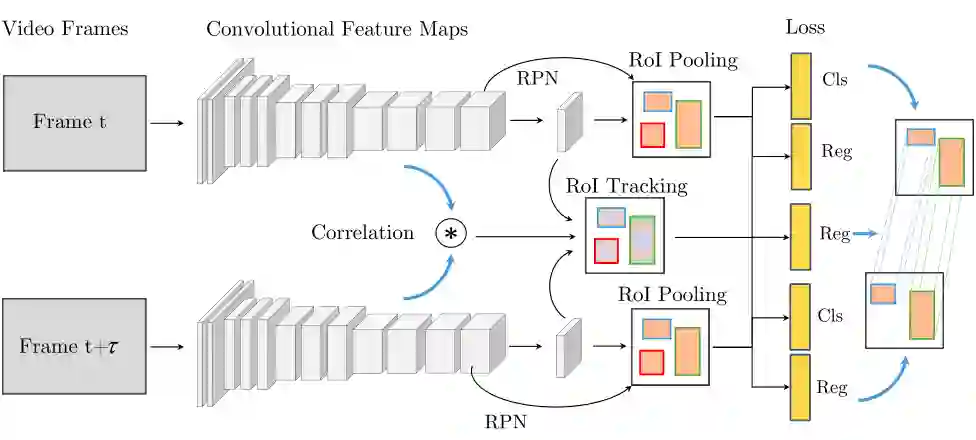

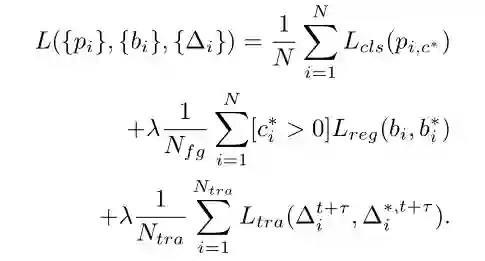

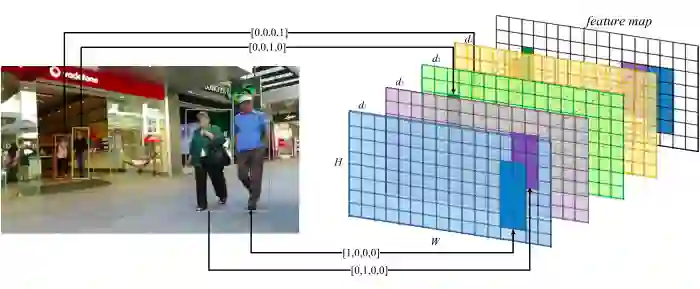

从图中可以清晰看到,作者通过改进版的 R-FCN 检测网络实现了主线的检测任务,然后基于两阶段目标检测的特点,将第一阶段所获得的多尺度特征图进行交互。

这种方式借鉴了单目标跟踪中经典的 Siamese 网络框架,不同之处在于原本的 Siamese 网络做的是 1:1 的相关滤波,而 D&T 框架做的是 n:n 的相关滤波。

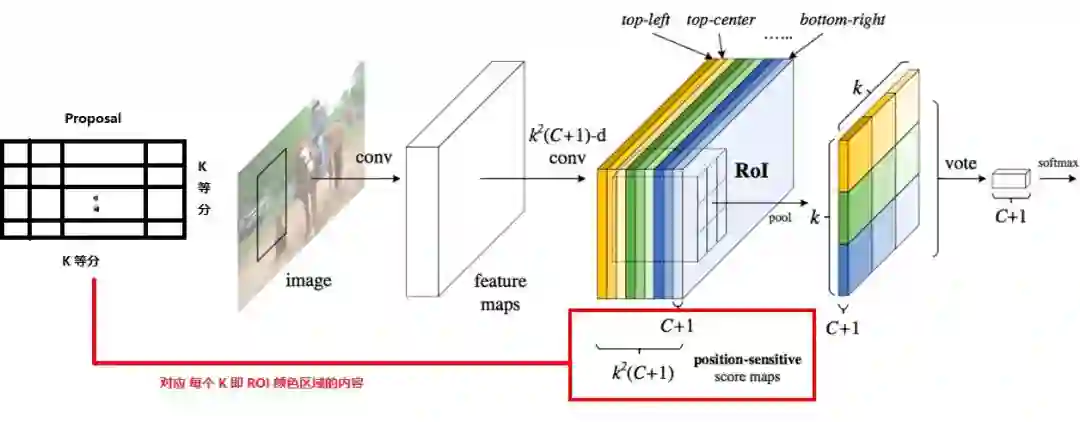

其中两个分支中所包含的目标数量也是不定的,那么为什么作者要用 R-FCN 网络呢,可以发现,R-FCN 的网络结构起到了很好的作用,正是因为其独特的 position-sensitive ROI Pooling 模块:

不同于传统两阶段目标检测框架利用全连接网络分支预测分类和回归的情况,R-FCN 通过全卷积的方式将分类得分转化到特征图通道上,使得特征图保持了一定的平移不变性(这个可以看我之前的博客),有利于跟踪任务的相关滤波。

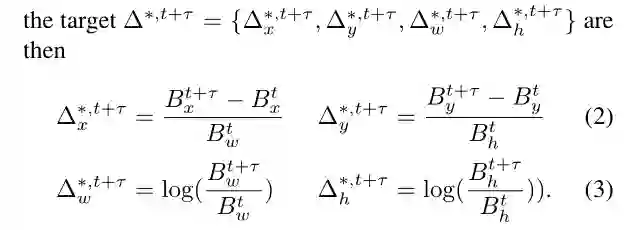

那么这里 D&T 在传统目标检测的分类和回归任务上,增加了一个跟踪分支,作者巧妙地将跟踪任务转化成了预测相邻两帧各目标位置相对偏移量的回归任务。

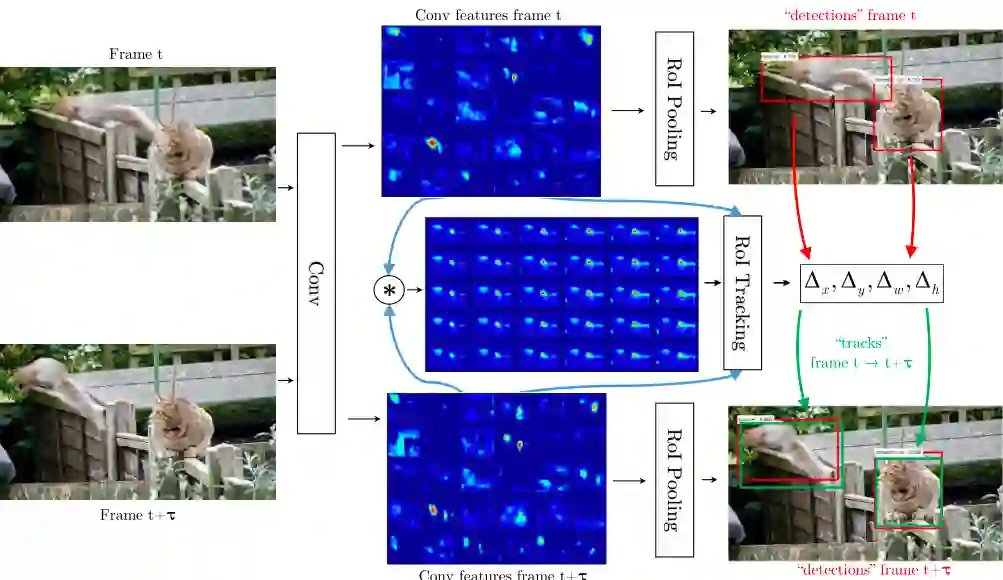

当然,跟踪分支只考虑与 gt 的 IOU>0.5 的预测框,并且目标要同时出现在这两帧。多任务损失函数如下:

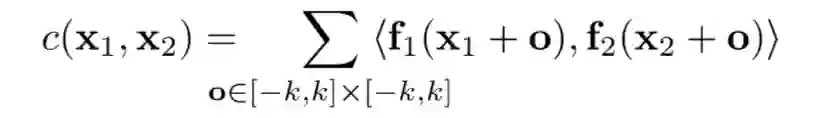

最后我们谈一下最重要的一点,如何做 ROI Tracking,即在不丢失相对位置关系的前提下,执行多个区域的相关滤波:

提到相关滤波,我们可能容易想到单目标跟踪中的 CF 类传统方法,比如 KCF(详细原理可以看我的解析)。KCF 算法中就是通过循环移位的方式,利用相关滤波估计目标在图像中的位置变化。

但是这种方式并不适合多目标的相关滤波,我们基于相邻两帧变化幅度不大的假设,更希望的是每块局部区域单独做类似于循环移位之类的操作。

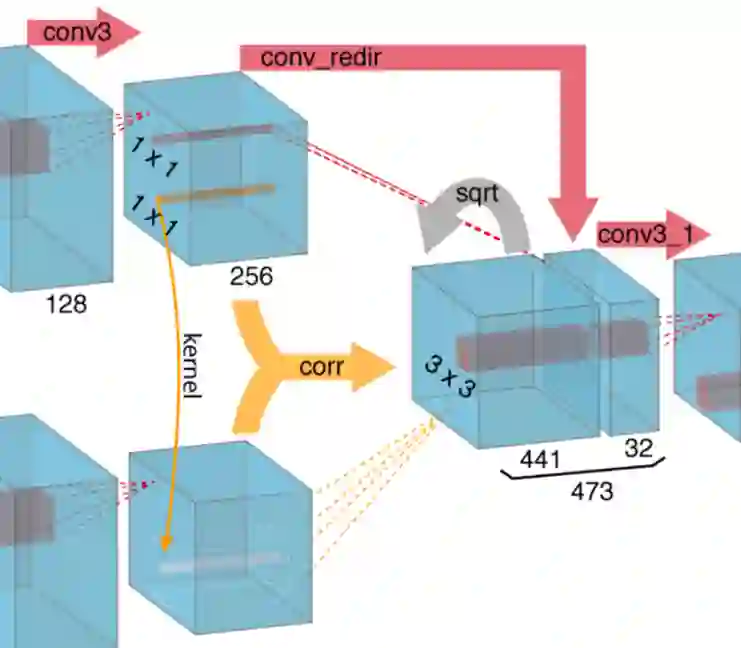

对此,作者借鉴了 FlowNet 的 Corr 操作,因为光流任务也是估计相邻帧像素的偏移量,所以用在这里很合适。

可以看到,这里的滤波不是对卷积核的,而是将两幅特征图的多个 kxk 的区域分别做相关滤波,从而保持了相对位置。

最后对于多目标跟踪的部分,作者对于两个目标的连接代价设置如下:

其中 p 表示的相邻两帧的检测置信度,最后一项指的是相邻两帧的目标框与预测到的位置的 IOU>0.5 时为 1,否则为 0。至此我们就可以得到跟踪预测位置和代价矩阵了,后面就是常规的多目标跟踪算法操作了。

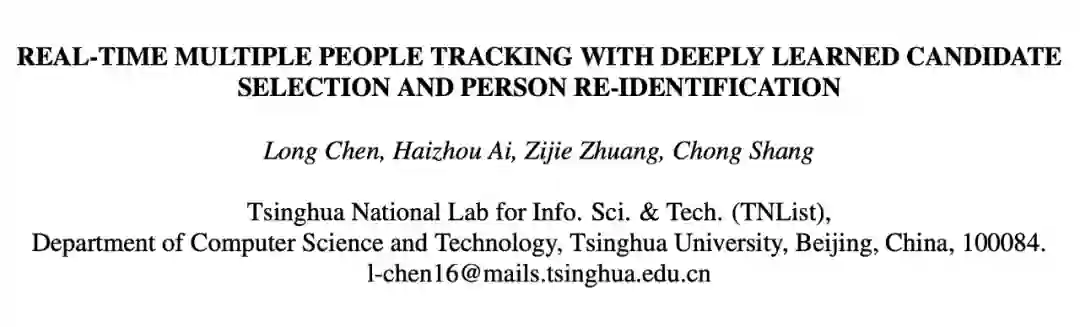

MOTDT

论文标题: Real-Time Multiple People Tracking with Deeply Learned Candidate Selection and Person Re-Identification

论文作者: Long Chen, Haizhou Ai, Zijie Zhuang, Chong Shang

备注信息: ICME 2018

论文链接: https://arxiv.org/abs/1809.04427

代码链接: https://github.com/longcw/MOTDT

这篇论文表面看上基于 R-FCN 检测框架的 private 多目标跟踪算法,不过与上一篇不同的是,作者只利用 R-FCN 对观测框进行进一步的前景/背景分类,即用于目标框的分类过滤,而且 MOTDT 将检测和跟踪框架分离了。

作者的框架也是由现在多目标跟踪算法的通用模块组成的,即检测、外观模型和运动模型。这里我们就只关注他的算法流程:

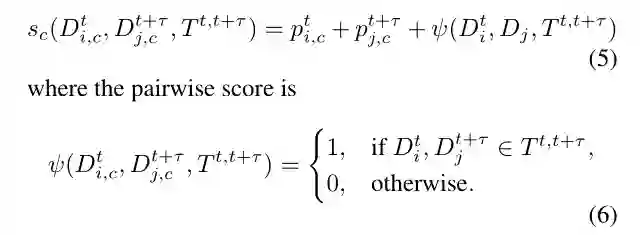

从算法流程可以清晰地看到,MOTDT 的流程是:

利用 Kalman Filter 完成目标的运动估计;

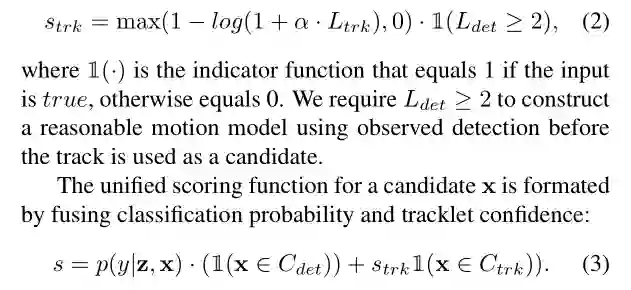

将观测框和跟踪框合并,并做 NMS 操作,其中每个目标框的置信度得到了修正:

这里面 L 表示的长度,通过上面两个公式,作者将检测置信度和跟踪轨迹置信度结合在一起了。

提取 ReID 特征,先基于 ReID 相似度进行匹配,再对剩余的利用 IOU 进行关联。

MOTDT 这个算法框架很经典,对于后续的一些多目标跟踪算法也起到了启发作用。

Tracktor++

论文标题: Tracking Without Bells and Whistles

论文作者: Philipp Bergmann,Tim Meinhardt,Laura Leal-Taixe

备注信息: ICCV2019,MOT15~17: 46.6, 56.2. 56.3 MOTA (public)

论文链接: https://arxiv.org/abs/1903.05625

代码链接: https://github.com/phil-bergmann/tracking_wo_bnw

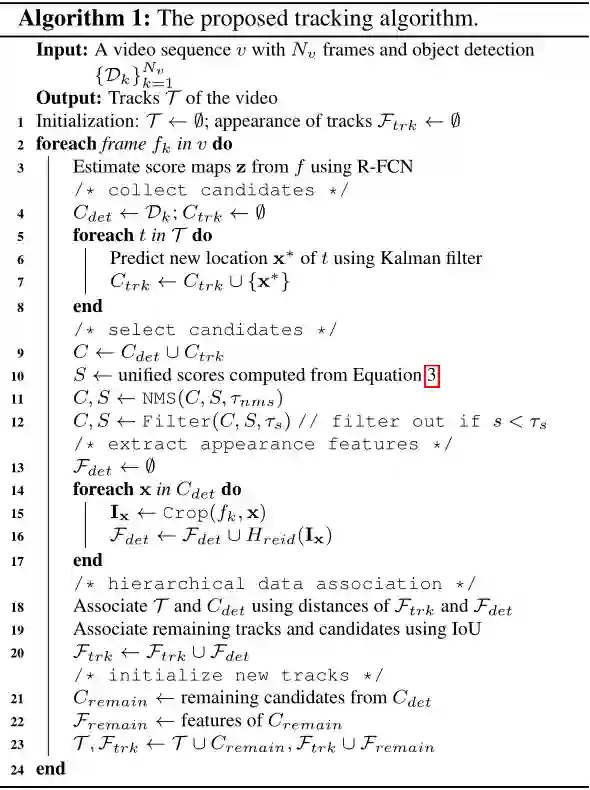

Tracktor++ 算法是去年出现的一类全新的联合检测和跟踪的框架,这类框架与 MOTDT 框架最大的不同在于,检测部分不仅仅用于前景和背景的进一步分类,还利用回归对目标进行了进一步修正。

因此关于这类框架属于 public 还是 private 得争论也存在,这里我们就不做过多的讨论了。

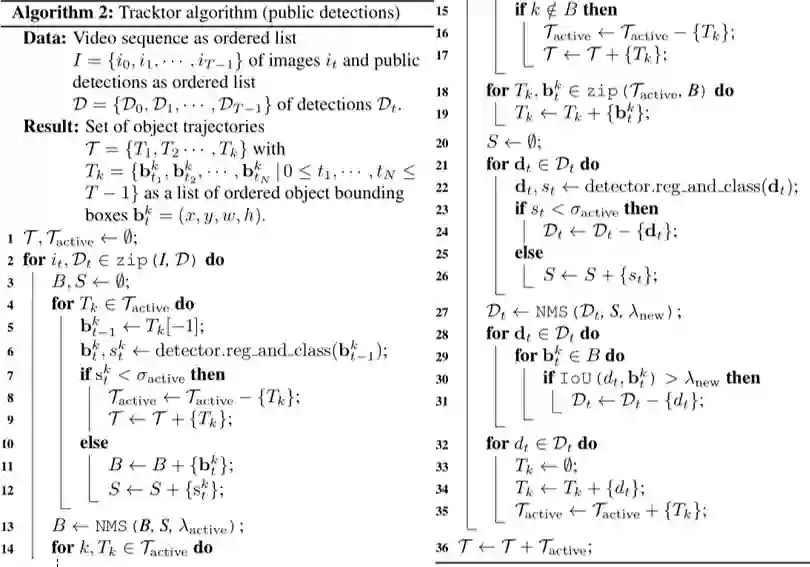

只要熟悉两阶段目标检测算法的应该都能理解这个算法,其核心在于利用跟踪框和观测框代替原有的 RPN 模块,从而得到真正的观测框,最后利用数据关联实现跟踪框和观测框的匹配。 流程图如下:

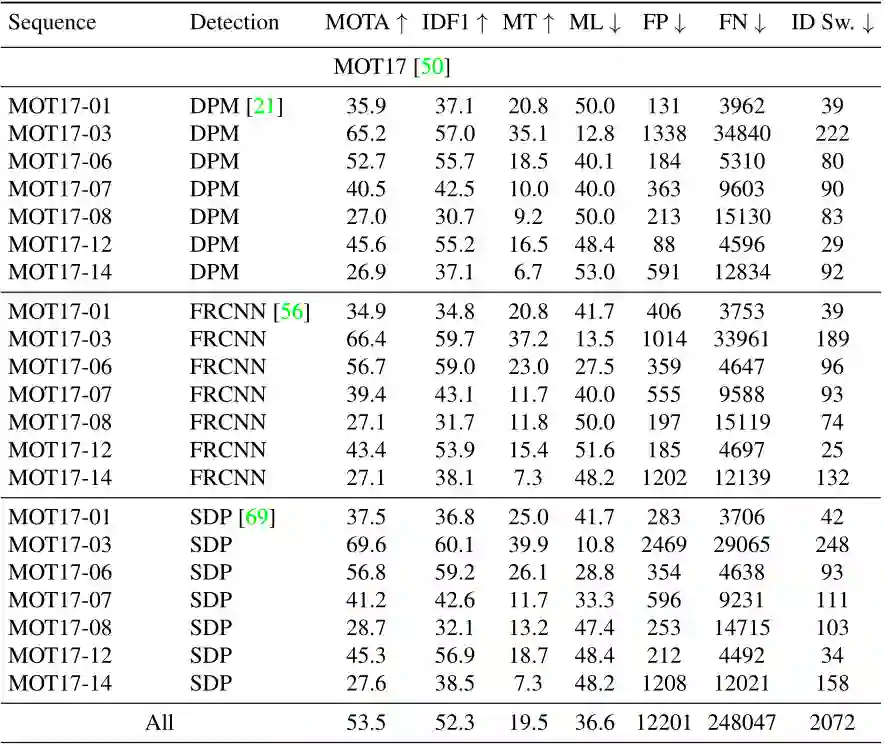

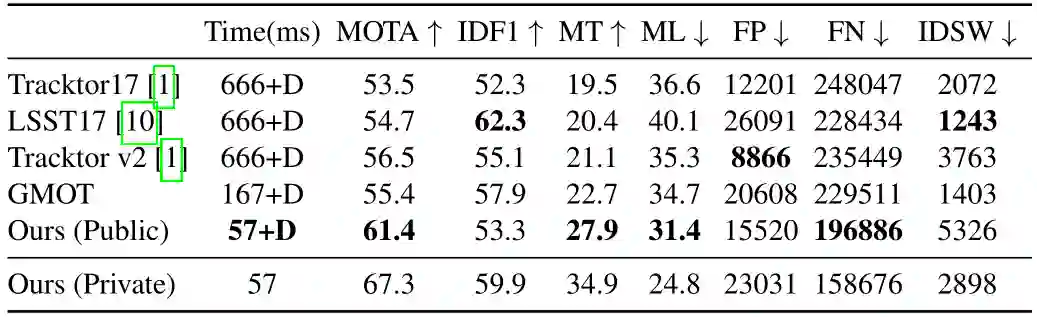

有了检测模块的加持,自然对于检测质量进行了增强,所以效果也得到了大幅提升:

可以看到,DPM、FRCNN 和 SDP 三种检测器输入下的性能差距不大,然而 DPM 检测器的性能是很差的,所以 Tracktor++ 这类算法对于平衡检测输入的效果提升很大。

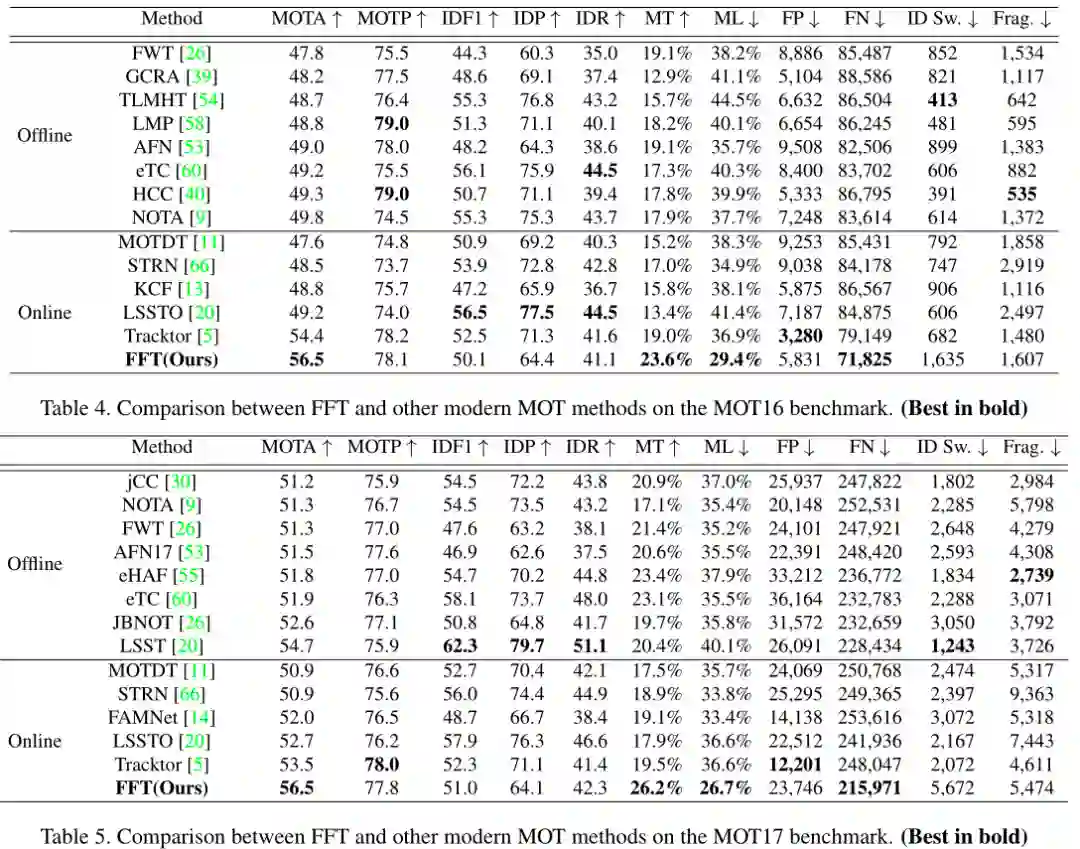

FFT

论文标题: Multiple Object Tracking by Flowing and Fusing

论文作者: Jimuyang Zhang, Sanping Zhou, Xin Chang, Fangbin Wan, Jinjun Wang, Yang Wu, Dong Huang

备注信息: MOT15~17: 46.3, 56.5. 56.5 MOTA (public)

论文链接: https://arxiv.org/abs/2001.11180

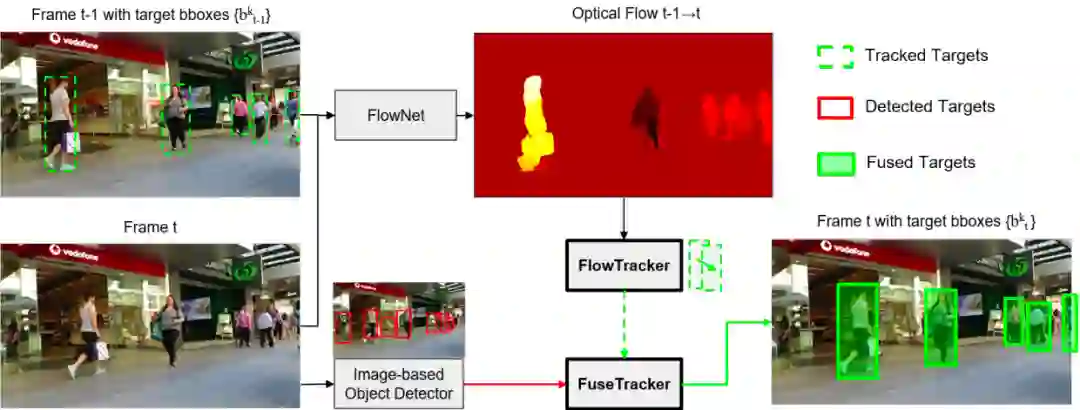

这篇文章也是基于 Tracktor++ 的模式,做了很直接的一步操作,即直接增加一个光流预测分支,将 Tracktor++ 中的 跟踪框+观测框 变成了 光流预测框+观测框

不过好处在于光流网络和 Faster RCNN 可以联合训练,在训练的时候 RPN 保留,不过从论文来看光流部分好像是固定权重的,其效果相对来说的确更好了:

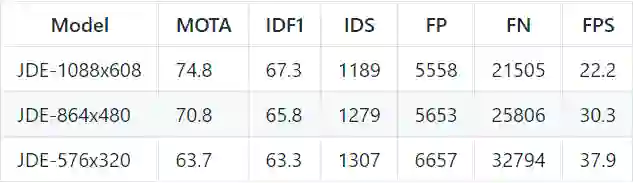

JDE

论文标题: Towards Real-Time Multi-Object Tracking

论文作者: Zhongdao Wang, Liang Zheng, Yixuan Liu, Shengjin Wang

备注信息: MOT16 74.8 MOTA (private), 22FPS!!

论文链接: https://arxiv.org/abs/1909.12605

代码链接: https://github.com/Zhongdao/Towards-Realtime-MOT

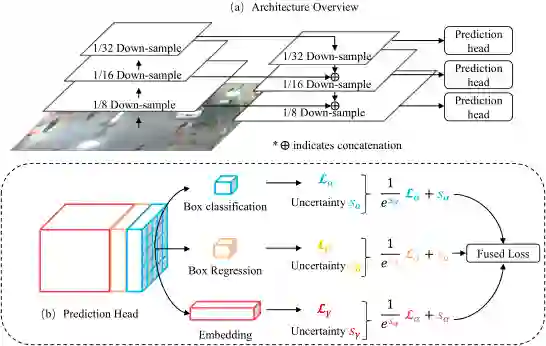

JDE 这篇跟这次的主题不是很相符,但是考虑到这也是近期比较热门的实时多目标跟踪算法,我们也一起讲。它的框架出发点是为了增加特征的复用性,基于检测算法(作者采用的是 YOLOv3),在原本的分类和回归分支上增加了一个表观特征提取的分支。

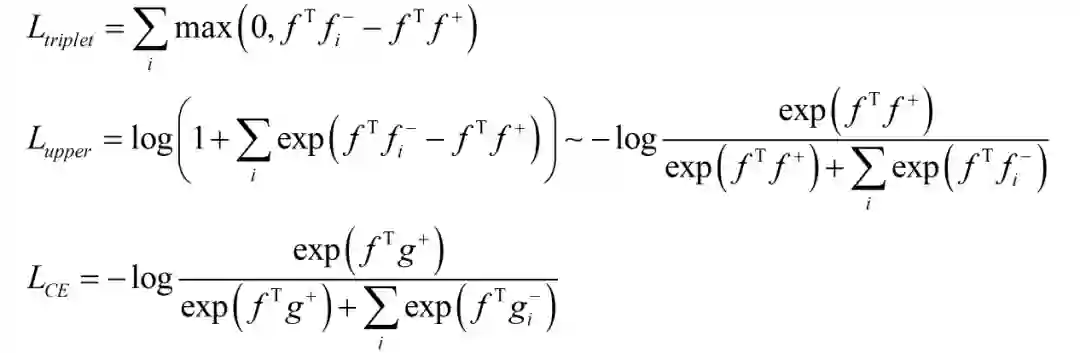

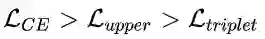

文中作者重点介绍了多任务网络框架的训练方式,首先分析了三种 Loss:

对于 triplet loss,这个在表观模型的 metric learning 任务中很常见,作者采用了 batch hard 模式,并提出了 triplet loss 的上界,推导很简单,关键在于多的那个

1

。为了更好地跟交叉熵损失函数进行比较,作者将上界进行了平滑。

那么区别就在于

g

,g 表示的正负样本的权重。在交叉熵损失函数中,所有的负样本都会参与计算,然而在 triplet loss 中,负样本是采样出来的,所以:

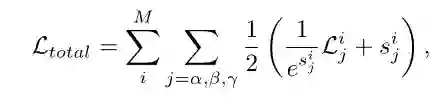

作者通过实验也论证了上面的结论,所以在 metric learning 中作者采用了交叉熵损失函数。最后关于各个任务的损失函数的权重,作者提出了一种自适应平衡的加权方式:

其中的 s 是一种度量不同任务下个体损失的不确定性因子,详细的原理可参见 CVPR 2018 的 Multi-task learning using uncertainty to weigh losses for scene geometry and semantics

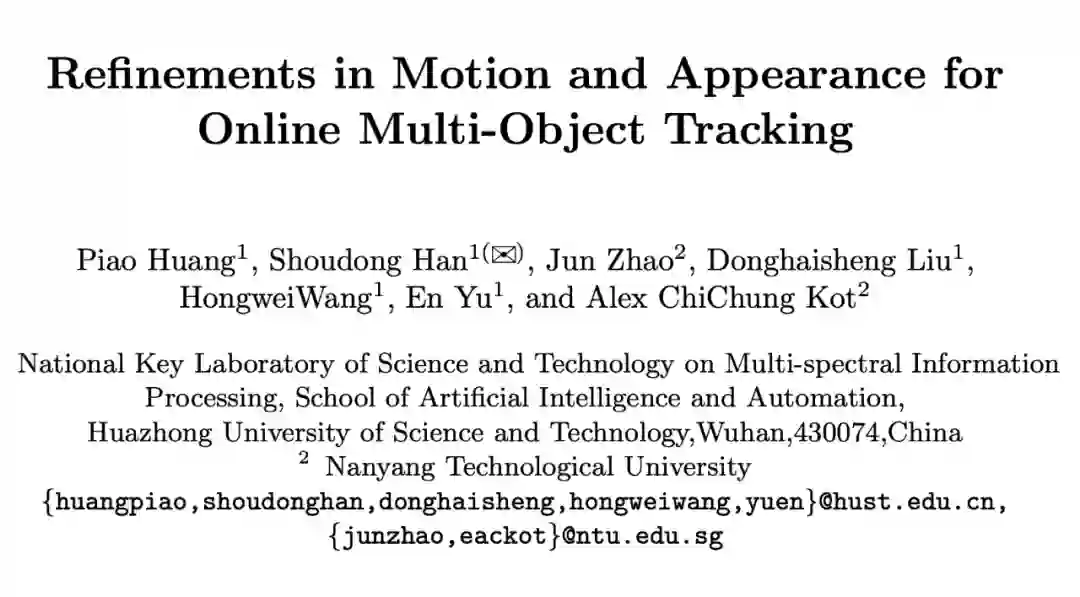

论文标题: Refinements in Motion and Appearance for Online Multi-Object Tracking

论文作者: Piao Huang, Shoudong Han, Jun Zhao, Donghaisheng Liu, HongweiWang, En Yu, and Alex ChiChung Kot

备注信息: MOT15~17: 60.1, 60.4, 48.1 MOTA (public)

论文链接: https://arxiv.org/abs/2003.07177

代码链接: https://github.com/nightmaredimple/libmot

这篇也是我们团队基于 Tracktor++ 框架做的一个框架,主要关注的是运动模型、表观模型和数据关联部分的改进,由于某些原因,我这里不能细讲。代码会慢慢开源,暂时没有完全开源。

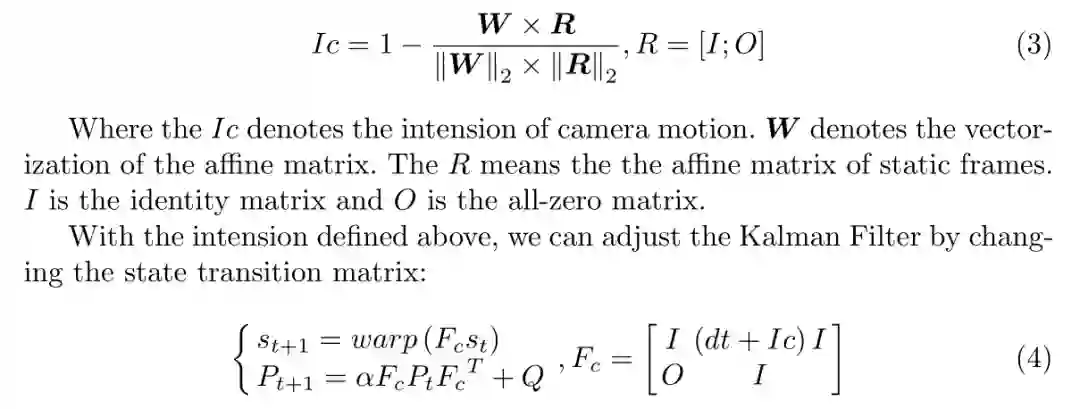

其中对于运动模型部分,我们将 Kalman 和 ECC 模型集成在一起,而不是将 Kalman 和 ECC 模型独立执行,实验证明融合的版本比分开的提升了 1.4 MOTA。

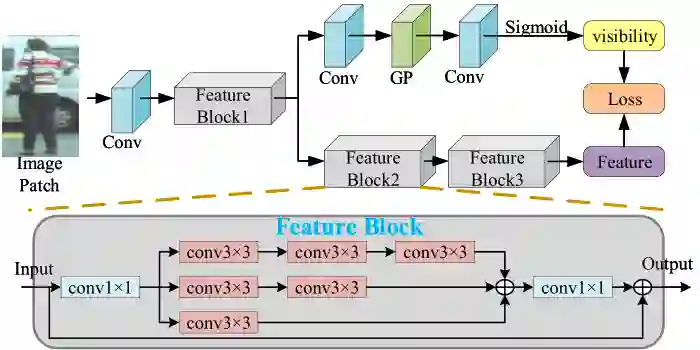

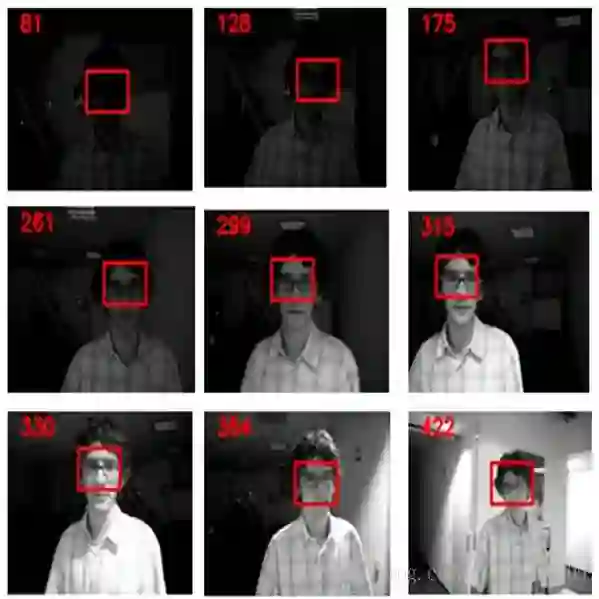

对于表观模型,我们考虑到特征对齐的因素,做了一点小改进,结合可视度预测设计了多任务的表观模型:

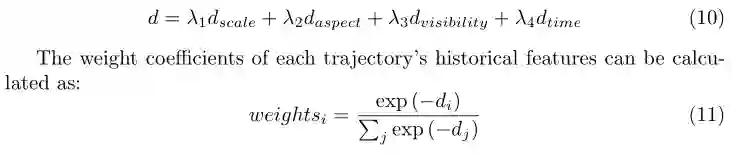

并在观测框和跟踪轨迹特征比对的时候,考虑了跟踪轨迹历史信息,来进行自适应加权:

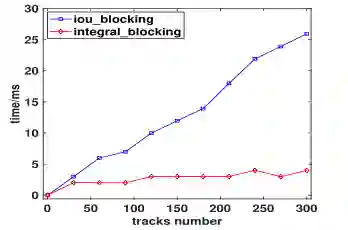

通过上面的分析,我们可以知道的是,数据关联部分的特征相似度计算,不仅要进行 n:m 的 Kalman 更新过程(为了求马氏距离),还要进行 m:(nxk) 的表观特征比对,这个过程很耗时。所以我们利用 3-D integral image 快速将空间区域分配,使得特征相似度计算过程的复杂度降至 O(m+n)。

方法很巧妙,就是将每个观测框利用 one-hot 编码映射到特征图,这种方式比基于 iou 的要快很多:

我后期又做了一些实验,效果比论文中的更好一些,MOT15~17: 48.1、60.4、60.1 MOTA (public)。

CenterTrack

论文标题: Tracking Objects as Points

论文作者: Xingyi Zhou (CenterNet 的作者), Vladlen Koltun, and Philipp Krähenbühl

备注信息: 同时实现了 2D/3D 多目标跟踪,包含人和车辆,MOT17:61.4(public)、67.3(private) MOTA, 22FPS!!!

KITTI: 89.4MOTA

论文链接: http://arxiv.org/abs/2004.01177

代码链接: https://github.com/xingyizhou/CenterTrack

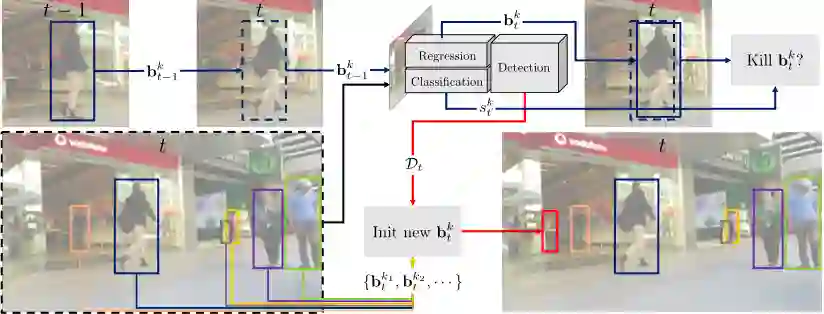

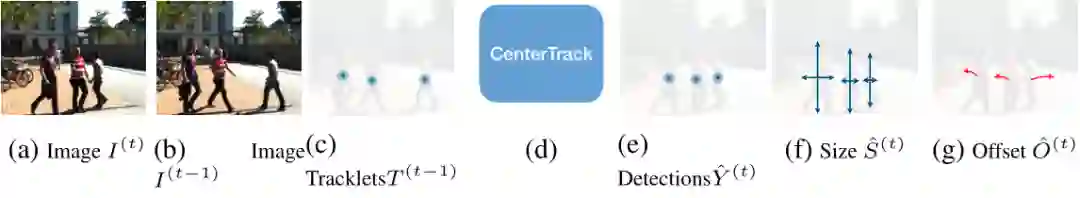

CenterTrack 是 CenterNet 作者基于 Tracktor++ 这类跟踪机制,通过将 Faster RCNN 换成 CenterNet 实现的一种多目标跟踪框架,因此跟踪框也就变成了跟踪中心点。

通过上图我们可以大致分析出算法框架,除了对相邻两帧利用 CenterNet 进行检测之外,还利用了上文中提到的 D&T 框架的策略,预测同时存在于两帧中目标的相对位移,由此进行跟踪预测。

对于提供的观测框,作者通过将这些观测框的中心点映射到一张单通道的 heatmap 上,然后利用高斯模糊的方式将点的附近区域也考虑进去。

因此 CenterTrack 相对于 CenterNet 的不同之处在于,输入维度增加了(两幅3维图像和一张观测位置 heatmap),输出变成了两张图像的目标中心位置、大小和相对偏移。

对于测试环节的数据关联部分,作者直接通过中心点的距离来判断是否匹配,是一种贪婪的方式,并非匈牙利算法那种全局的数据关联优化。在训练过程中,作者并非只用相邻帧进行训练,允许跨 3 帧。

CenterTrack 在 MOT、KITTI 和 nuScenes 等数据集上的 2D/3D 多行人/车辆跟踪任务上均取得了 SOTA 的成绩。

参考文献

[1] Feichtenhofer C, Pinz A, Zisserman A. Detect to track and track to detect[C]. in: Proceedings of the IEEE International Conference on Computer Vision. 2017. 3038-3046.

[2] Chen L, Ai H, Zhuang Z, et al. Real-time multiple people tracking with deeply learned candidate selection and person re-identification[C]. in: 2018 IEEE International Conference on Multimedia and Expo (ICME). IEEE, 2018. 1-6.

[3] Bergmann P, Meinhardt T, Leal-Taixe L. Tracking without bells and whistles[C]. in: Proceedings of the IEEE International Conference on Computer Vision. 2019. 941-951.

[4] Multiple Object Tracking by Flowing and Fusing

[5] Towards Real-Time Multi-Object Tracking

[6] Refinements in Motion and Appearance for Online Multi-Object Tracking

[7] Tracking Objects as Points

点击以下标题查看更多往期内容:

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读 ,也可以是学习心得 或技术干货 。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品 ,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱: hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」 也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」 订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」 ,小助手将把你带入 PaperWeekly 的交流群里。