AI女性界的“扛把子”,凭一己之力迫使NIPS改名

作者 | 琥珀

出品 | AI科技大本营

“计算机领域其实没有歧视,只是存在性别比例的差异罢了……”如果这种事件不放在台面上说,可能大家就这么想当然的认为了。

或许当你津津有味阅读某篇论文时,你可能很少会关注论文背后是否潜藏着的种族、女性歧视等话题,甚至会做出“何不食肉糜”的疑问。

近日,当美国多数商业公司员工开始尽情享受难得的圣诞节假休息日时,Twitter 上却迎来了人工智能界的“扛把子”Anima Anandkumar 的连篇炮轰。她在其最新的推文中指出 Yann LeCun 存在性别歧视,Moshe Vardi 取关她并且涉嫌种族主义。

编译:@Yan LeCun 自从你对我恶语相向后,它直接致使很多人在Twitter上甚至是发邮件骂我。对你鼓励性别歧视、性骚扰的做法表示非常失望。

@Moshe Vardi 在 Facebook上表现地对我很不友好,我在一条帖子上对他发表的种族主义言论做出评论,认为非常可耻。相反,他非但删除了我的评论,还继续为其他人进行辩护。“Black in AI”组织为此做出了很多努力,她们不为种族主义做辩护。

要知道,Yann LeCun 不仅是 Facebook 人工智能研究院院长兼纽约大学教授,他同样还被誉为“卷积神经网络之父”、深度学习运动的领军人物;而作为 Netta 首席科学家的 Moshe Vardi,同时还是美国科学院院士、美国工程院、欧洲科学院等五院院士。

除了怒怼两位计算机领域赫赫有名的教授外,我们再来看看 Anima Anandkumar 之前的一些战绩:

人工智能领域的年度活动——神经信息处理系统会议的英文缩写 NIPS 于今年改名为 NeurlPS,而这次更名的改变恰恰源自于她。资料显示,多年以来原先的英文缩写名称引发了许多有关性别歧视和冒犯的争议:“NIPS 既是对日本人的贬低性诽谤,也是对女性乳头的性俚语。”

2017 年 NIPS 大会刚刚闭幕,就有人爆出明尼苏达州大学生物统计系主任 Brad Carlin 公然谈论性骚扰话题的不当言论。受此影响,一位学术圈的女性勇敢地站出来指出了该大牛对其进行进行性骚扰的事件,并呼吁女性科研工作者拒绝沉默。

甚至 Google AI 负责人 Jeff Dean 也发推文说,“现在这个名字让人感到不舒服。”当他们发布了一项针对 2000 多名与会者(大多数是男性)的调查,结果发现大多数人都对此有所了解。

于是当 Anandkumar 看到该会议的名称作为性别歧视笑料的话题愈演愈烈时,便开始了 ProtestNIPS 活动希望更改大会名称,并起草了一份有超过 200 个签名的请愿书。最终,会议组委会做出了退步。

尽管从目前来看只是包容性的小举措,但足以证明在很长一段时间内女性在计算机尤其是人工智能学术圈的地位正逐步得到提升。

也或许正因如此,2018 NeurlPS 会议现场,不少参会者特意提到:“机器学习领域的女性从业者开始逐渐增多。”

2018 年 9 月,在辞去亚马逊 AWS 首席科学家的职位之后,Anandkumar 以 NVIDIA 机器学习主任的身份公开亮相,与此同时她还是加州理工学院的教授。

性别歧视的物化——算法

人工智能无疑将成为未来几年计算机科学最重要的研究领域之一。但上述挑战反映出来的是科技行业更加缺乏多元化。

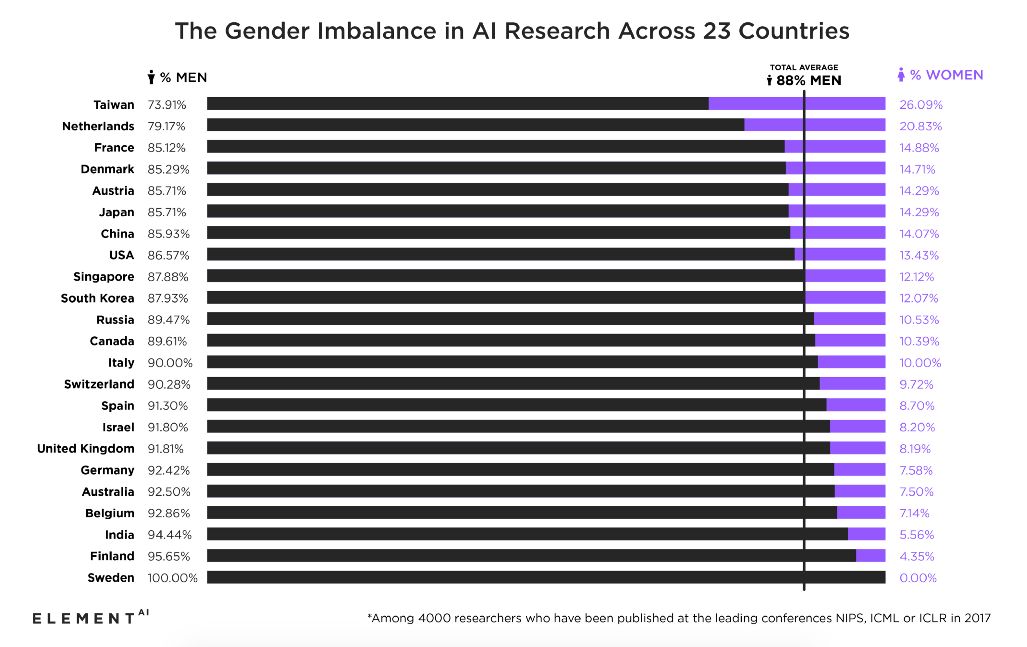

在主要的科技公司,女性占工程和计算机岗位的 20% 甚至不到。而这种性别失衡的现象放在人工智能领域则更为严重,据创业孵化器 Element AI 的一项估计显示,在美国的人工智能领域,仅有 13%为女性研究人员,而且该领域的黑人和拉丁裔的高管数量正在逐渐减少。

当然,这种问题可能不只是在人类本身,算法作为智能学习的一种“物化”,将性别歧视的问题以技术的方式进行了放大。

今年 10 月,亚马逊 AI 招聘工具被曝出性别歧视,检测到女性就打低分的问题。尽管后来工程师发现了算法在数据源上存在的漏洞问题并修改了算法,不再通过检索关键词来推断应聘者的性别。但这还是没能解决实际问题,AI 算法已经形成了这样的认知,而且更确切的来讲,男多女少,是目前整个科技行业的现实情况。

据了解,麻省理工学院媒体实验室的研究员 Joy Buolamwini,同样也是 Algorithmic Justice League 的发起人,该组织致力于抗争具备算法偏见的“编码注释”(coded gaze)。她和谷歌研究员、Black in AI 组织联合发起人 Timnit Gebru,共同发布了一项研究,该研究显示:三种领先的面部识别算法在识别较暗的面部时要比较亮的面部准确率要差得多,同时,在识别女性与男性面部特征时,前者的准确率也更差些。

该项研究敲响了试图构建算法模型的顶尖科技公司的警钟,这也被认为是人工智能领域需要具备多样化元素的证据。

为 AI 与责任作出贡献的百位女性

“盲目相信算法的一个主要问题是,我们可以在不承认具备任何意图的情况下传播这种带有歧视性的模型。”

在这样一个充满挑战性的人工智能时代,AI 算法和杀手机器人的偏见普遍存在,所有这些问题都需要公开讨论并立即采取行动进行解决。这也同时诞生了一门叫做“AI 伦理与责任”的学科,涉及了当今人类面临的从种族/性别不平等的算法到机器人是否应该拥有权利的关键问题。学术研究人员、伦理学家、政策制定者、法律专家、数据科学家、隐私倡导者、遗传学家以及非技术学科人员都为此提供了有意义的见解。

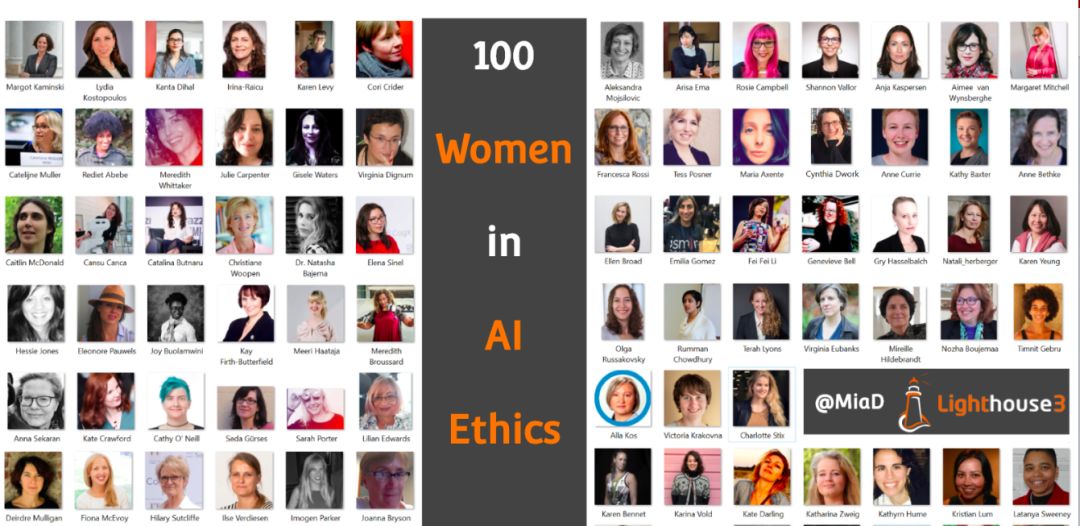

人工智能领域的女性研究员本来就稀缺,专门推出“AI 伦理与责任”的女性更是寥寥无几。因此,我们也专门找到了 Lighthouse 创始人 Mia Dand 为这个领域做出过杰出贡献的 100 位女性。

标准:

A)自我认同为女性。

B)主要关注人工智能的伦理学,特别是涉及机器人和其他人工生物/系统。

C)作为个人或大型组织的一部分,以个人或专业身份积极推动道德/责任人工智能事业。

查看完整榜单请移步:https://becominghuman.ai/100-brilliant-women-in-ai-ethics-to-follow-in-2019-and-beyond-92f467aa6232

写在最后

研究人工智能只需要了解算法模型吗?是的这很重要,但并不代表你仅需要关注这一点。正如上学时老师会灌输给你知识,但你毕业后才发现原来你更需要的是课堂之外的人文教育。不然,你不会懂得研发的这套算法是否伤害到了别人。

再需要提一句的是,目前在科技行业男多女少的现象或许根本无法避免,为什么理工科的女性就偏少,而从事传媒、教育、艺术等领域的女性工作者会更多?这是值得我们思考的问题。

(*本文为AI科技大本营原创文章,转载请联系作者)

公开课预告

◆

推荐系统

◆

本次分享带你揭开个性化推荐的神秘面纱,从推荐算法到大型系统架构进行全面剖析。

添加小助手微信csdnai2,回复:推荐系统,加入课程交流群,课程回放以及PPT将在群内分享。

推荐阅读