解决机器学习最大弊病?马普所联合Google再探「因果学习」

新智元报道

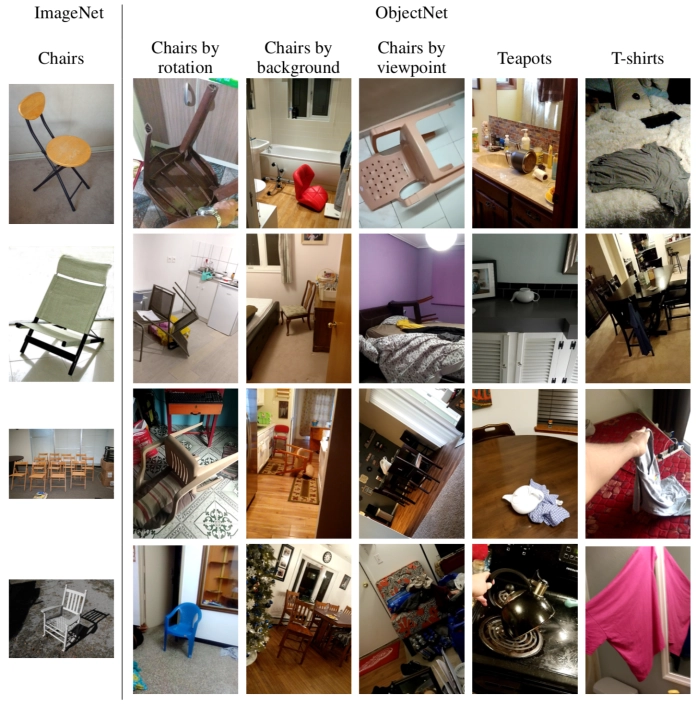

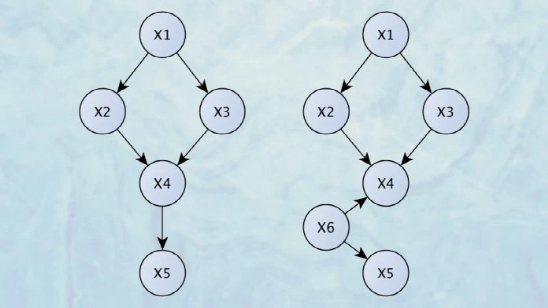

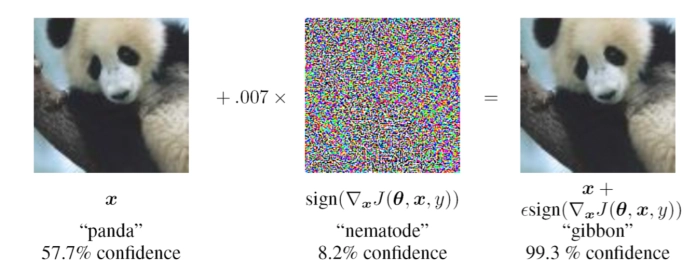

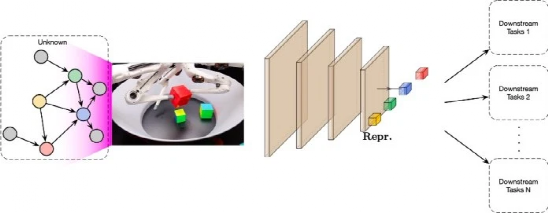

【新智元导读】对于机器学习算法来说,因果关系的推理仍然是一个大的挑战。近日,在一篇题为「因果表示学习「的文章中, 来自马普所、蒙特利尔研究所和Google Research的研究人员讨论了缺乏因果表示所带来的挑战,并提供了创建可以学习因果表示AI系统的方向。

登录查看更多

相关内容

Arxiv

0+阅读 · 2021年6月23日

Arxiv

0+阅读 · 2021年6月23日