11节麻省理工学院的通用人工智能课程大放送

讲师阵容超豪华:谷歌技术总监Kurzweil、特斯拉AI总监Andrej Karpathy、波士顿动力CEO Marc Raibert、OpenAI的联合创始人Ilya Sutskever等。课程将介绍以下内容:目前学界对计算智能的理解;以及从深度学习、强化学习、计算神经科学、机器人学、认知建模、心理学等学科中获得见解以达到强人工智能的方法。

第一讲:《通用人工智能》

讲师:Lex Fridman

Lex Fridman是麻省理工学院的博士后,致力于在半自主车辆、驾驶员状态感知、场景感知、运动控制和规划方面的深度学习。

讲义:http://bit.ly/2nAQLsK

视频:https://www.youtube.com/watch?v=-GV_A9Js2nM&feature=youtu.be

讲座1: 《计算认识科学》

讲师:Josh Tenenbaum

Josh Tenenbaum是麻省理工学院脑和认知科学系教授。

讲座2: 《如何创造一个大脑》

讲师:Ray Kurzweil

Ray Kurzweil是谷歌技术总监。

讲座3: 《情绪创造》

讲师:Lisa Feldman Barrett

Lisa Feldman Barrett是美国东北大学心理学教授,曾因对大脑情绪的开创性研究获奖。

讲座4: 《认知建模》

讲师:Nate Derbinsky

Nate Derbinsky是美国东北大学副教授,研究兴趣包括人工智能,优化,机器学习和数据库系统。

讲座5: 《深度学习》

讲师:Andrej Karpathy

Andrej Karpathy是特斯拉人工智能总监。

讲座6: 《基于知识的编程》

讲师:Stephen Wolfram

Stephen Wolfram是Mathematica,Wolfram | Alpha和Wolfram语言的创建者,也是Wolfram Research的创始人兼首席执行官。

讲座7: 《人工智能安全性和自主武器系统》

讲师:Richard Moyes

Richard Moyes是NGO Article 36的共同创始人。他是制定“2017年禁止核武器条约”的首席战略家。他对DeepMind潜在风险进行研究和分析。

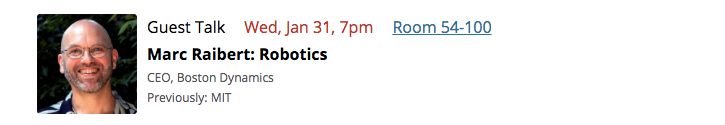

讲座8: 《机器人学》

讲师:Marc Raibert

Marc Raibert是波士顿动力的CEO。

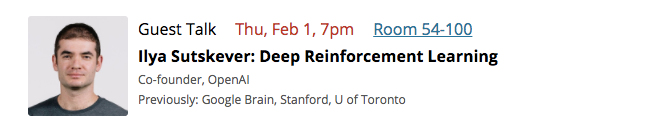

嘉宾讲座9: 《深度强化学习》

讲师:Ilya Sutskever

Ilya Sutskever是OpenAI的联合创始人。

第二讲:《以人为本的人工智能》

讲师:Lex Fridman

讲义:http://bit.ly/2EiL0t8

如果你对这门课程感兴趣,可以:在网站上注册一个帐户以获取最新信息。(https://agi.mit.edu/register/)课程材料免费向公众开放。如果您是麻省理工学院的学生,想要获得学分,请在此注册。(http://web.mit.edu/registrar/reg/prereg_info_iap.html)

或点击“阅读原文”,查看详情