深度学习弯道超车,领先行业不止一点点

深度学习技术的应用,已经完全具备了弯道超车的条件和可能。随着持续的重视和投入,已经领先了行业不止一点点。

在开始探索深度学习的道路上,很多人都曾问过自己,深度学习为什么那么难入门?

深度学习真的有那么难吗?这个,还真没有。不信?听我来和你侃侃。看完,你也会觉得没那么难了。

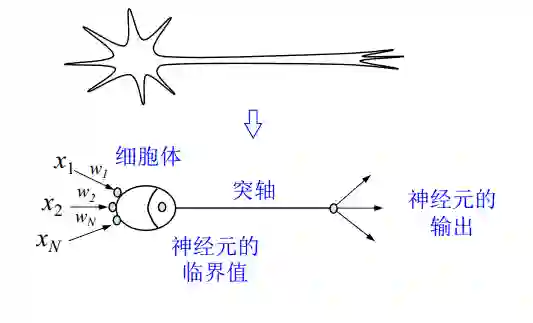

我们知道,深度学习是采用神经网络,用于解决线性不可分的问题。就像形成我们大脑基本元素的神经元一样,神经元形成神经网络的基本结构。想象一下,当我们得到新信息时我们该怎么做。当我们获取信息时,我们一般会处理它,然后生成一个输出。类似地,在神经网络的情况下,神经元接收输入,处理它并产生输出,而这个输出被发送到其他神经元用于进一步处理,或者作为最终输出进行输出。

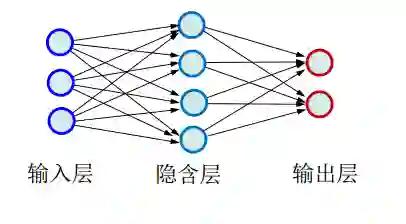

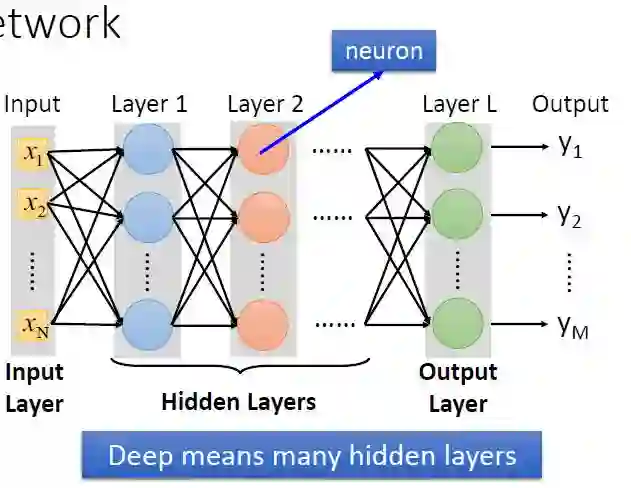

神经网络由若干神经元结点互联而成,通过训练,找到合适的权值;经过训练后,对于输入信号,获得有意义的输出结果。

所谓深度学习,就是具有很多个隐层的神经网络。

训练深度神经网络,其实就是一个不断磨合的过程,刚开始定义一个标准参数(这些是经验值。就好比情人节和生日必须送女票花❀一样),然后不断地修正,得出图中每个节点间的权重。为什么要这样磨合?试想一下,我们假设深度学习是一个小孩,我们怎么教他看图识字?肯定得先把图片给他看,并且告诉他正确的答案,需要很多图片,不断地教他,训练他,这个训练的过程,其实就类似于求解神经网络权重的过程。以后测试的时候,你只要给他图片,他就知道图里面有什么了。

所以训练集,其实就是给小孩看的,带有正确答案的图片,对于深度学习而言,训练集就是用来求解神经网络的权重的,最后形成模型;而测试集,就是用来验证模型的准确度的。

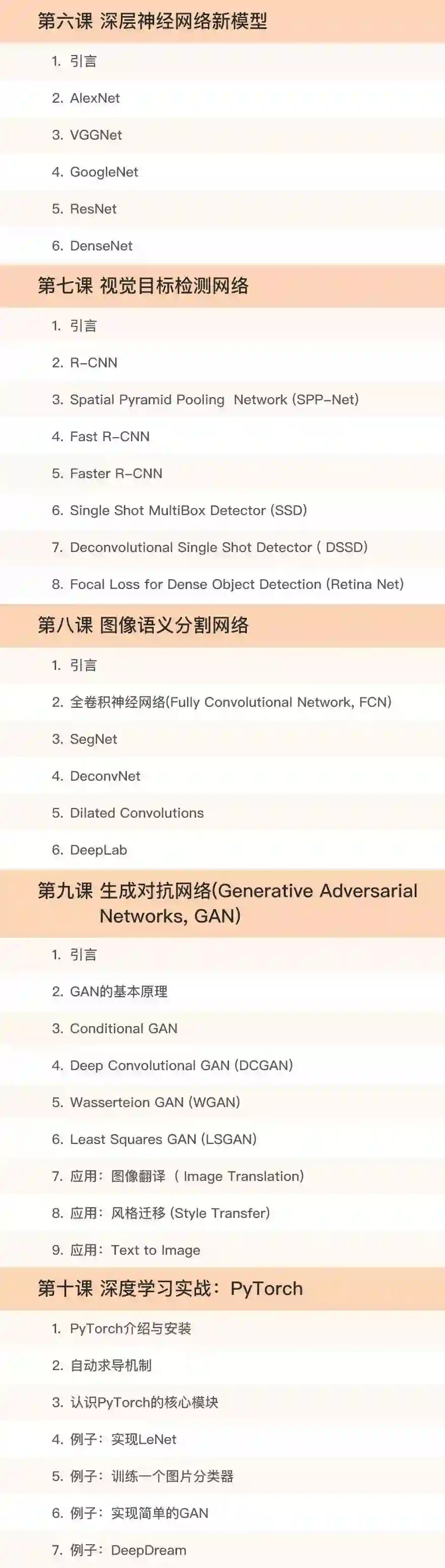

如果你已经看到这里了,你对深度学习应该有了一个初步的了解,那么如何定义最初始的网络模型和参数?如何搭建一个神经网络来对图像进行分类,检测出所需要的目标呢?现在,给你一个和中科院学生师出同门的机会!我们来跟随向老师一起学习深度学习基础模型:自编码机,卷积神经网络,循环神经网络;探索几种经典的卷积神经网络模型:AlexNet, VGG Net, GoogleNet,ResNet等;讨论深度学习方法在目标检测和语义分割中的演进。

主讲老师

向世明

中科院自动化所模式识别国家重点实验室研究员

中国科学院大学兼职教授、博士生导师

模式识别与机器学习领域近十年教学经验

为硕士生或博士生主讲《模式识别》和《机器学习导论》等课程,在高水平国际期刊或主流会议上发表论文100余篇以第一作者在 IJCV、IEEE T-PAMI、IEEE T-IP、IEEE T-NNLS、IEEE- T-KDE、IEEET-SMC-B、IEEE T-MM 和 PR 上发表论文十余篇。

孟高峰

中科院自动化所模式识别国家重点实验室副研究员

研究方向包括图像处理、计算机视觉和机器学习等

丰富的教学经验,为硕士生主讲《机器学习导论》等课程

在高水平国际期刊或主流会议上发表论文50余篇。以第一作者在 IJCV、IEEE T-PAMI、IEEE T-IP、ICCV、CVPR ECCV 等顶级国际杂志和国际会议发表论文十余篇。

课程大纲

开课时间:8月16日

课程详情,请点击【阅读原文】