机器学习能够分析和解释大量数据、识别模式并做出高保真决策,这在过去可能是不可行的,因此在众多不同领域都具有重要意义。机器学习在战术领域也有丰富的应用,例如识别数据中与可疑活动或行为相对应的异常模式(这可能预示着潜在的安全威胁或漏洞),以及通过分析来自传感器、情报报告和态势感知平台等多个来源的数据来协助实时决策。

深度学习是机器学习的一个分支,它利用人工神经网络从大量数据中学习并执行复杂的任务[1]。与传统机器学习算法通常利用领域知识手动设计相关特征进行操作不同,深度学习模型旨在直接从原始数据中自动学习特征或表征,无需特征工程。这是深度学习的主要优势之一,特别是对于涉及图像、音频和文本等高维数据的任务。为此,深度学习的应用涉及计算机视觉、自然语言处理、语音识别和网络安全等多个领域。

尽管深度学习模型好处多多,但也容易受到各种攻击和利用。对抗式机器学习是一个新兴领域,研究机器学习模型的漏洞和保护它们的机制[2]。在这种情况下,对手可以利用机器学习系统在设计、训练过程或部署方面的弱点来操纵它们的行为或损害它们的性能。其中一个主要的安全问题是围绕对抗(规避)攻击展开的,这种攻击涉及通过向输入数据添加微小扰动,在模型中引入偏差或漏洞,从而恶意欺骗或降低模型的性能。在本文中,首先讨论了深度学习在战术领域的应用领域。接下来,将对抗式机器学习作为一种新兴的攻击载体,并讨论对抗式攻击对深度学习性能的影响。最后,讨论了可用于抵御这些攻击的潜在防御方法。

战术网络深度学习

深度学习是机器学习的一个子领域,通过对输入数据进行非线性变换来提取模式并执行回归或分类任务。深度学习在战术网络领域有多种应用,包括

- 目标检测和识别: 深度学习算法可用于卫星图像、空中监控和地面摄像机中的实时物体检测和识别。这有助于识别敌方车辆、设备和人员,支持情报、监视和侦察(ISR)工作。此外,自动目标识别(ATR)系统可用于实时自动识别和跟踪潜在目标。

- 自主导航: 深度学习算法可促进无人驾驶飞行器的自主导航,使其能够独立地在复杂的环境中航行。这减少了对持续人工干预的需求,提高了侦察和监视行动的效率。

- 自主车辆和无人机: 深度学习有助于开发用于侦察和监视目的的自主车辆和无人机。这些系统可以根据视觉数据进行导航和决策,最大限度地减少人类的参与和风险。

- 自然语言处理(NLP):NLP 可用于从大量文本数据(包括情报报告、社交媒体和通信截获内容)中分析和提取有价值的信息。这有助于了解和预测敌人的意图。

- 预测分析: 深度学习模型可以分析历史数据,预测潜在威胁并提出最佳策略。这包括预测敌人的动向、识别叛乱活动的模式以及预测潜在冲突。

- 网络安全: 深度学习可用于网络流量的异常检测和模式识别。它有助于识别和减轻网络威胁、确保通信渠道安全和保护敏感军事信息。

- 语音识别: 语音识别技术对军事通信和指挥系统很有价值。它可以实现免提操作和高效语音命令,增强在挑战性环境中的通信能力。

- 模拟和培训: 深度学习可用于创建逼真的模拟训练。这包括模拟战场场景、敌人行为和各种环境条件,以有效培训军事人员。

- 健康监测和预测性维护: 深度学习模型可用于监测军事装备的健康状况和性能。预测性维护有助于防止意外故障,确保关键资产处于最佳状态。

- 决策支持系统: 深度学习可通过提供实时分析和可操作的见解来协助军事指挥官进行决策。这包括评估风险、优化资源分配和制定战略计划。

- 射频(RF)环境理解: 深度学习可用于解读射频环境,包括友方和敌方射频发射器(如雷达、干扰器或通信设备)的检测和分类。这种理解可为战术决策提供依据,并增强战场上的态势感知。

通过在这些应用领域利用深度学习,战术系统可以从增强的性能、弹性和适应性中获益,最终支持军事行动的任务目标。

深度学习在战术领域面临的挑战

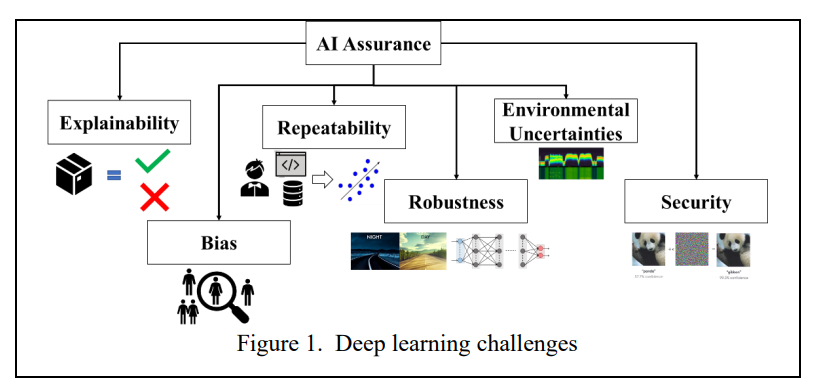

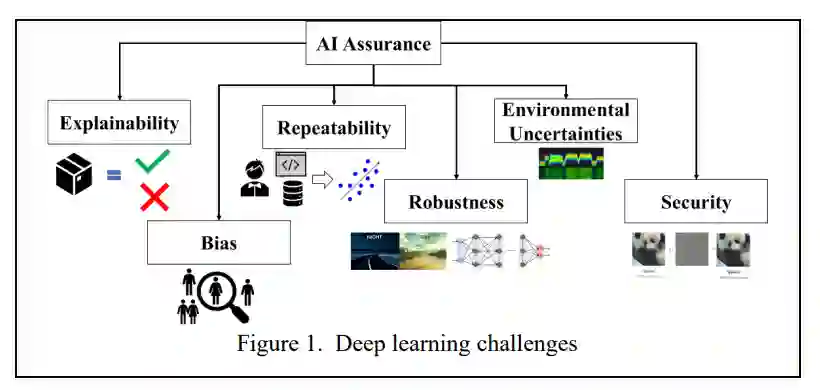

在战术领域成功部署深度学习模型的一个关键步骤是确保所开发算法的可靠性、安全性、公平性、透明度和责任性。在战术行动中,深度学习系统必须在具有挑战性的动态条件下可靠运行,如恶劣的环境、有限的通信带宽和对抗性威胁。人工智能保障涉及支持人工智能系统(如基于深度学习模型的系统)满足严格的性能要求,包括准确性、鲁棒性和响应性,以支持目标识别、威胁检测和决策支持等关键任务。图 1 说明了影响深度学习模型信任度的一些因素,即环境不确定性、可重复性、偏差、可解释性、稳健性和安全性。

可解释性对于在深度学习应用中建立信任、提高透明度、减少偏差和促进知情决策至关重要。可解释的机器学习模型通过为模型预测和决策提供理由,支持监管合规性和问责制要求。通过了解模型是如何得出预测或建议的,军事人员可以获得对作战背景、任务目标和潜在威胁的宝贵见解,从而提高对态势的认识和决策能力。

偏差是指深度学习模型在预测或决策时出现的系统误差或不准确,原因是模型无法代表输入特征与目标变量之间的真实潜在关系。偏差可能来自不同方面,如算法偏差、标签偏差或特征偏差。传感器数据、情报报告或态势感知数据中的偏差可能会导致错误的模型预测,或在动态和不确定的战场条件下做出次优决策。通过解决战术领域深度学习中的偏差问题,军事组织可以提高自动决策支持系统的公平性、有效性和可信度。

可重复性是深度学习研究和应用的完整性、可信度和进步的基础。当模型和实验具有可重复性时,战术领域的不同利益相关者就可以对研究过程中使用的方法、假设和多领域数据进行评估,从而提高对报告结果和结论的信任度。

深度学习的鲁棒性指的是模型在不同和具有挑战性的条件下保持性能和稳定性的能力,这些条件包括数据分布、环境变化和攻击的变化,这些在现代战场上经常会遇到。

环境的不确定性会降低从各种来源收集到的数据的质量。此外,根据特定环境中的数据训练的机器学习模型可能难以泛化到具有不同特征的新环境或未见过的环境中。这对受制于动态战场条件和未知敌方影响的战术行动构成了重大挑战。由于与数据驱动系统相关的潜在漏洞和风险,机器学习的安全性至关重要。敌人可能会试图利用深度学习模型中的漏洞来欺骗或操纵它们,从而导致决策失误和任务失败。

应采取安全措施,帮助保护这些数据免遭未经授权的访问,确保战术行动中传递的关键信息的机密性和完整性。

在本文的其余部分,将重点介绍机器学习的安全性,解释不同的攻击类型,讨论它们如何影响深度学习算法的性能,并回顾潜在的防御技术。

对抗式机器学习

对抗式机器学习指的是研究如何理解和缓解机器/深度学习模型中的漏洞,在这种情况下,对抗者会利用模型设计、训练过程或测试时输入数据中的弱点来操纵或欺骗模型。对抗式机器学习包括各种攻击,包括探索式攻击、对抗式攻击(规避)、中毒攻击和后门(木马)攻击 [6]-[10]。

-

在探索式攻击中,对手使用基于探测的策略,通过提交精心制作的查询或输入样本来询问深度学习模型。这些查询旨在揭示模型的内部运作信息,例如其决策边界、特征表征或敌方操纵的弱点。

-

对抗(规避)攻击精心设计输入样本,以规避检测或在操作过程中误导模型的预测。对抗者可能会利用模型架构或特征表示中的漏洞来生成最终被错误分类的输入。逆向输入通常涉及对输入数据进行微小、不易察觉的修改,从而导致模型输出发生重大变化。

-

模型中毒攻击涉及注入恶意数据或操纵训练数据集,以损害深度学习模型的性能或完整性。攻击者可能会在训练数据中插入有偏见或误导性的样本,以影响模型的行为,或者引入后门,使未经授权的访问或控制成为可能。

-

后门(木马)攻击涉及在训练数据中插入恶意制作的输入,以操纵机器学习模型的行为。

这些输入包含微妙的改动,在正常运行时并不明显,但在推理过程中会触发模型的特定响应或错误分类。这种操纵会损害模型的完整性和可靠性。

隐私攻击也可以通过成员推理和模型提取攻击应用于深度学习算法。

-

成员推理攻击旨在确定深度学习模型的训练数据集中是否使用了特定的数据样本。攻击者利用模型输出中的信息泄露来推断训练数据中是否存在特定样本,从而损害敏感信息的隐私性和保密性。

-

模型提取攻击涉及对深度学习模型进行逆向工程,以提取模型参数中嵌入的敏感信息或专有知识。攻击者可能会使用黑盒查询、模型反转技术或成员推理攻击来推断模型架构、训练数据或决策边界的细节。

在深度学习中,攻击也可以根据攻击者对目标模型及其内部运作的了解程度进行分类。主要分为白盒攻击、黑盒攻击和灰盒攻击三大类。

-

在白盒攻击中,攻击者完全了解目标模型,包括其架构、参数和训练数据。攻击者可以直接访问模型的内部表示、梯度和决策边界,这使他们在制作对抗性样本时非常有效。

-

在黑盒攻击中,攻击者对目标模型内部参数或梯度的访问有限或根本无法访问。攻击者只能通过查询输入样本和观察相应输出来与目标模型交互。尽管缺乏对目标模型的详细了解,黑盒攻击者仍会利用可转移性等技术精心制作对抗样本,将在替代模型上生成的对抗性样本用于攻击目标模型。

-

灰盒攻击介于白盒攻击和黑盒攻击之间,攻击者对目标模型有部分了解。在灰盒攻击中,攻击者可以获取目标模型的部分信息,如其架构或输出预测,但无法获取其内部参数或梯度。

在防御深度学习系统中的对抗性威胁时,每种类型的攻击都会带来独特的挑战和注意事项。下一节,我们将深入探讨对抗性攻击,并讨论它们如何影响深度学习性能。

对抗性攻击

对抗性攻击的目的是在测试时操纵输入数据,使深度学习模型做出错误的决定。文献中提出了许多发动对抗性攻击的方法 [11]。我们重点分析快速梯度符号法(Fast Gradient Sign Method,FGSM)和投射梯度下降法(Projected Gradient Descent,PGD)。

-

FGSM 是制作对抗样本最简单、最有效的技术之一。它的工作原理是在模型损失函数相对于输入特征的梯度方向上扰动输入数据,同时保持在一定的扰动值(ε)之下。FGSM 攻击速度快、计算效率高,只需一次梯度计算即可生成对抗样本。然而,FGSM 生成的对抗样本可能缺乏鲁棒性,无法转移到其他模型或防御方法中。

-

PGD 是一种迭代方法,用于确定可能误导模型的扰动。换句话说,PGD 攻击对输入数据及其特征稍加处理,就会导致模型出错。如果输入数据足够敏感,尤其是对微小变化足够敏感,那么 PGD 攻击导致模型分类错误的几率就会更高。与 FGSM 相比,PGD 攻击的计算量更大,因为它涉及梯度下降的多次迭代。不过,PGD 生成的对抗样本通常更有效、更稳健,因为迭代优化过程能更彻底地探索损失景观的局部几何形状。

为了说明对抗性攻击的影响,考虑了针对 ImageNet 数据集 ResNet-50 模型的 FGSM 和 PGD 攻击[14]。该数据集横跨 1000 个对象类别,包含 1,281,167 张训练图像、50,000 张验证图像和 100,000 张测试图像 [15]。ResNet-50 是一种卷积神经网络(CNN)架构,由 50 层组成,包括卷积层、池化层、批处理归一化层和全连接层。ResNet-50 在包括 ImageNet 在内的各种基准数据集上取得了最先进的性能,并被广泛用作各种计算机视觉任务(包括图像分类、物体检测、图像分割和图像生成)中的特征提取器或骨干架构。图 2 显示了随着扰动水平(我们称之为ε)的增加,FGSM 方法的分类器准确率的攻击性能结果。对抗性机器学习攻击可分为非目标攻击和目标攻击。非目标攻击的特点是试图扰乱输入数据,使机器学习模型做出错误的预测,而不指定任何特定的目标类别或结果。另一方面,有针对性的攻击旨在操纵模型的行为,使其朝着特定类别或决策的方向发展。在我们的实施中,我们主要关注非目标攻击。最初,在发动任何攻击之前,分类器的准确率为 87.5%。随着ε值的增加,准确率下降到 0%。与 FGSM 相比,PGD 方法能更有效地降低分类器的性能。另一方面,作为一种迭代方法,PGD 的计算时间较长。图 3 显示了 PGD 攻击下分类器准确率随迭代次数的变化情况。我们观察到,随着迭代次数的增加,分类器的准确率持续下降,在 13 次迭代后下降到 0%。

防御对抗性机器学习攻击

随着深度学习在战术行动中的应用越来越广泛,对抗性机器学习攻击将继续成为一项挑战。不过,重要的是要考虑防御策略,并采取积极措施来缓解这些问题。缓解深度学习中的对抗性攻击需要强大而有弹性的防御机制。一种特殊的防御机制是对抗性训练,即用对抗性样本来增强训练数据集,以提高模型的鲁棒性和对对抗性攻击的抵御能力。通过在训练过程中将模型暴露在对抗性扰动下,深度学习系统可以学会更好地泛化,并在对抗性操作面前变得更加稳健。集合学习是另一种可用作防御机制的方法。集合方法结合多个深度学习模型进行预测,提高了模型的鲁棒性和抵御对抗性攻击的能力。通过利用不同的模型架构和训练策略,集合方法可以帮助更有效地检测和缓解对抗性实例。

开发实时检测和防御对抗性攻击的技术有助于保护基于深度学习的战术系统免受恶意操纵。异常检测、离群点检测和对抗性鲁棒性认证等对抗性检测方法有助于在对抗性输入对系统造成危害之前识别并减轻其影响。总之,对抗式机器学习是一个重要的研究领域,重点在于了解和缓解深度学习系统中的漏洞。通过开发强大的防御机制和弹性模型架构,研究人员和从业人员可以在对抗性威胁面前提高深度学习驱动系统的安全性、可靠性和可信度。

结论

深度学习为各种军事和国防应用中的战术行动提供了重要优势。在本文中,我们首先探讨了深度学习可用于提高任务性能的一些应用领域。然后,我们强调了深度学习算法容易受到对抗性威胁的影响,对抗性威胁可以修改输入数据,迫使深度学习模型做出错误的决策。我们讨论了可对深度学习模型实施的不同攻击类型,并展示了这些攻击如何导致模型准确性大幅下降,即使对数据的扰动很小。最后,我们重点介绍了一些防御方法,这些方法可以用来检测和尽量减少这些攻击对深度学习算法的影响。