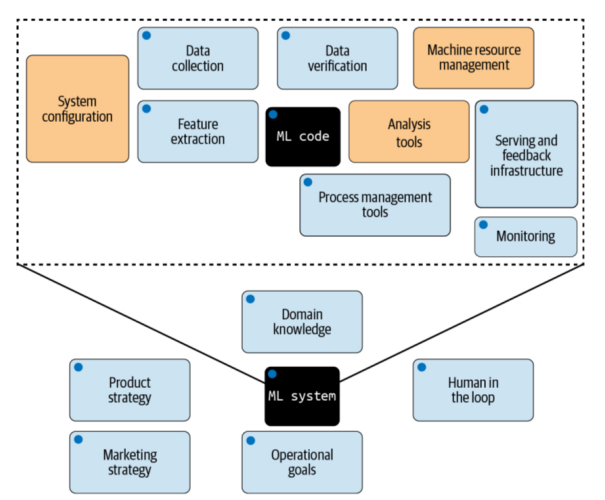

红队测试已从军事应用起源发展为网络安全与人工智能领域广泛采用的方法论。本文批判性审视人工智能红队测试实践,认为尽管其在当前人工智能治理中备受关注,但红队测试作为批判性思维训练的本质意图与生成式人工智能背景下聚焦模型层面缺陷的狭隘应用之间存在显著差距。当前人工智能红队测试主要关注个体模型漏洞,却忽视了更广泛的社会技术系统以及模型、用户与环境复杂交互产生的涌现行为。为弥补此缺陷,我们提出一个在人工智能系统实施红队测试的综合性框架,包含两个层级:贯穿整个人工智能开发生命周期的宏观系统级红队测试,与微观模型级红队测试。借鉴网络安全经验与系统理论,我们进一步提出系列建议,强调有效的人工智能红队测试需要多功能团队审查涌现风险、系统脆弱性及技术社会因素间的相互作用。

近期,“红队测试”一词在关于人工智能的多元讨论中获得显著关注,被视为发现并应对生成式人工智能(genAI)系统安全、可靠性与可靠性问题的潜在解决方案。当ChatGPT于2022年11月问世时,除曾有军事或网络安全背景者外,人工智能领域鲜有人知红队测试。不足一年后,DEFCON顶级黑客会议组织了史上最大规模的人工智能红队测试演练[3,7]。时至今日,处于(所谓的)生成式人工智能革命中心的我们,可见人工智能红队测试主导着学术界[20,21]、智库建议[27,45]与大众媒体文章[4,6,35]的讨论。红队测试理念被吹捧为解决人工智能诸多问题的万能药,其应用于生成式人工智能系统已被且持续被鼓励作为实践举措。尽管这并非坏事——因红队测试无疑是解决人工智能安全与可靠性问题的一部分——但它仅是应被采用的更完整工具集中的一小部分。红队测试是一种批判性思维训练,助于判定应对复杂挑战的拟议方案的适用性与稳健性。从军事兵棋推演演进至网络安全实践,再至当前揭示人工智能安全漏洞与危害,红队测试超越了技术人员的手动或自动化测试。它不仅测试技术组件——硬件、软件、网络与模型——更延伸至审视治理结构并挑战设计从最初构想的基础假设。因此,红队测试不仅是技术练习,更是非技术人员(如管理、法律与风险管理团队)可采用的思维过程,用以制定治理指南并与技术团队就未预见的部署后挑战进行有意义对话。对安全、安保、隐私、对齐与伦理要求差异的敏感性,以及将此方法应用于硬件、软件、网络、数据及最关键的人力所构成的人工智能整体生态系统,对成功至关重要。网络安全领域丰富的技术基础与行业最佳实践同当前人工智能红队测试方法存在严重脱节。尽管安全领域历经数十年研究与教育,当今人工智能红队测试仍狭隘聚焦于生成式人工智能模型(或如ChatGPT与Claude的模型驱动通用系统)的技术漏洞。此缺失环节否定了在人工智能与网络安全实践社群间建立桥梁所能实现的巨大效益,该桥梁本可最终引领我们找到实现稳健有效的人工智能治理及更紧密遵循负责任人工智能原则的解决方案。为在人工智能开发生命周期等社会技术系统中有效实施红队测试,需拓展视野超越当前主导讨论的狭隘技术焦点。红队测试起源于战略思维训练,指定团队不仅模拟对抗行动,更挑战假设并识别盲点,作为明确项目审批流程的一部分。当前许多人工智能公司采用的对已构建物进行测试的方法[2,12],错过了红队测试原旨在提供的先发与主动批判分析要义。

实施人工智能红队测试的组织应建立清晰流程,将发现转化为可执行的改进措施。包括追踪已识别问题、根据风险评估确定优先级、实施缓解措施并验证修复未引入新问题。无此反馈循环,红队测试仅成表演性练习而非有意义的批判实践。多方面,红队测试类似软件开发中的验收测试。众所周知,任何部署前测试无法预见所有潜在问题。经红队测试的系统运行于动态环境,面临持续演变的威胁与用户行为。此现实需要持续监控、不断评估与自适应响应能力,远超越初始红队测试练习。在定义人工智能治理与风险管理实践时,组织应牢记人工智能红队测试的目标广于仅确保人工智能模型安全可靠的行为,其手段深于渗透测试或模糊测试等狭隘技术方法。本文余下部分,我们主张并将红队测试设计为一种集体批判思维方法论,若在整个开发生命周期中恰当应用,可大幅最大化人工智能系统效用并最小化其风险。