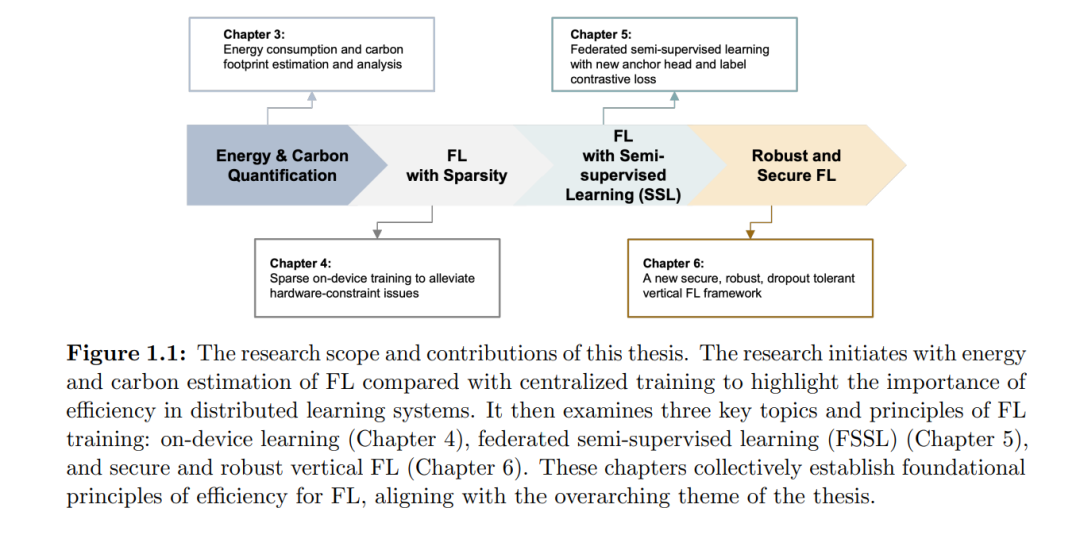

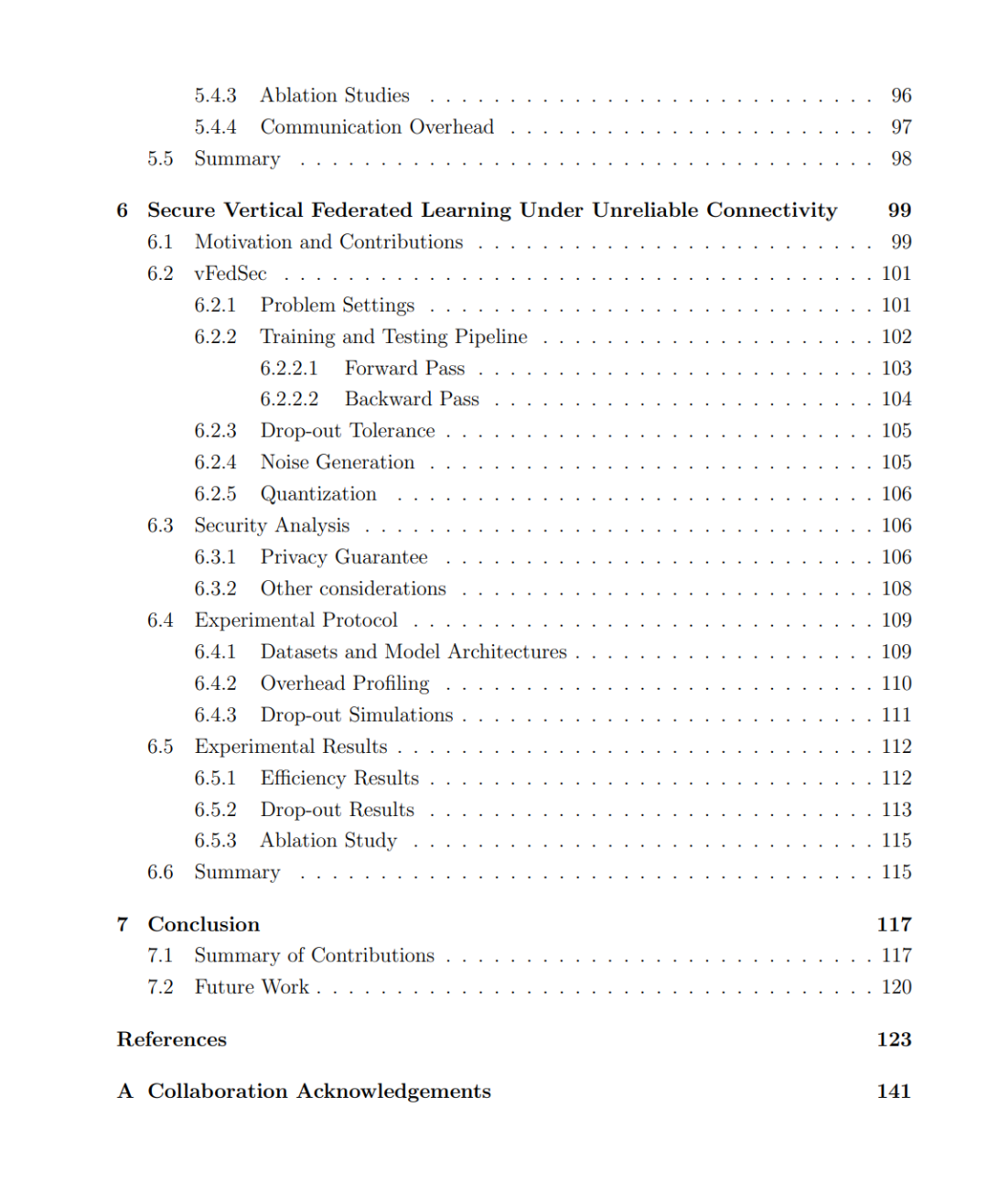

近年来,技术的快速进步引发了前所未有的数据激增,数据来源涵盖手机、物联网(IoT)设备、自动驾驶车辆、平板电脑及其他边缘计算技术。在这一背景下,联邦学习(Federated Learning, FL) 作为一种关键的机器学习范式应运而生,使得不同机构或设备能够在无需共享原始敏感数据的情况下协同训练模型。在当下语境中,这种方法尤为重要,因为诸如个人医疗记录和个体行为等敏感信息的处理,日益受到诸如《通用数据保护条例(GDPR)》等严格数据保护法规的约束。这些法规凸显了跨境数据传输的挑战,使集中式训练模型的可行性大大降低。FL 的显著优势在于,它能够使全球近 70 亿台 IoT 设备和 30 亿部智能手机安全高效地参与科研与开发。该范式在确保隐私的同时,充分利用海量数据与计算能力,成为不可或缺的解决方案,尤其是在医疗等亟需隐私保护的大规模研究领域。FL 的重要性在于它能够调动这一全球化设备网络,在日益严峻的隐私保护与监管挑战下,提供一种可扩展、安全且高效的数据利用方式。然而,尽管 FL 具有诸多优势,仍亟需正视并研究其内在挑战,尤其是在优化与效率层面。 本论文聚焦于提升 FL 系统效率的核心挑战,提出了一系列有原则性的解决方案,以在不降低模型性能的前提下减少碳排放、通信开销与计算负担。全文围绕实现高效联邦学习的四大原则展开:最小化通信排放、利用训练稀疏性、通过锚点对齐表征、以及集成安全层以增强掉线容忍性。 论文的第一部分提出了一种严格的方法学,用于量化 FL 的能耗与碳足迹,并揭示出在不同配置下,FL 的能耗可能显著高于集中式训练,凸显了面向能效的 FL 设计的必要性。在此基础上,论文提出 ZeroFL,一种新颖的稀疏化框架,可在设备端 FL 中同时降低计算与通信成本,并在高稀疏水平下提升模型精度。随后,论文提出 FedAnchor,一种联邦优化方法,通过服务器端锚点数据和对比损失来对齐客户端潜在表征,从而在半监督学习场景中实现更快收敛和更强鲁棒性。最后,论文提出 vFedSec,首个高效的、具备掉线容忍性与隐私保护能力的纵向 FL 协议,与基于同态加密的方法相比显著加速,同时确保在客户端连接不稳定的情况下实现安全训练。 综上所述,这些贡献通过系统性地解决 FL 的关键效率瓶颈,推动了该领域的最新进展。本文不仅提出了具体的算法与实证验证,还提供了一套可推广的原则性框架,可为未来研究与应用部署提供指导。通过融合优化、能效意识与隐私保护,本研究为在真实场景中实现可扩展、安全、可持续的联邦学习奠定了基础。