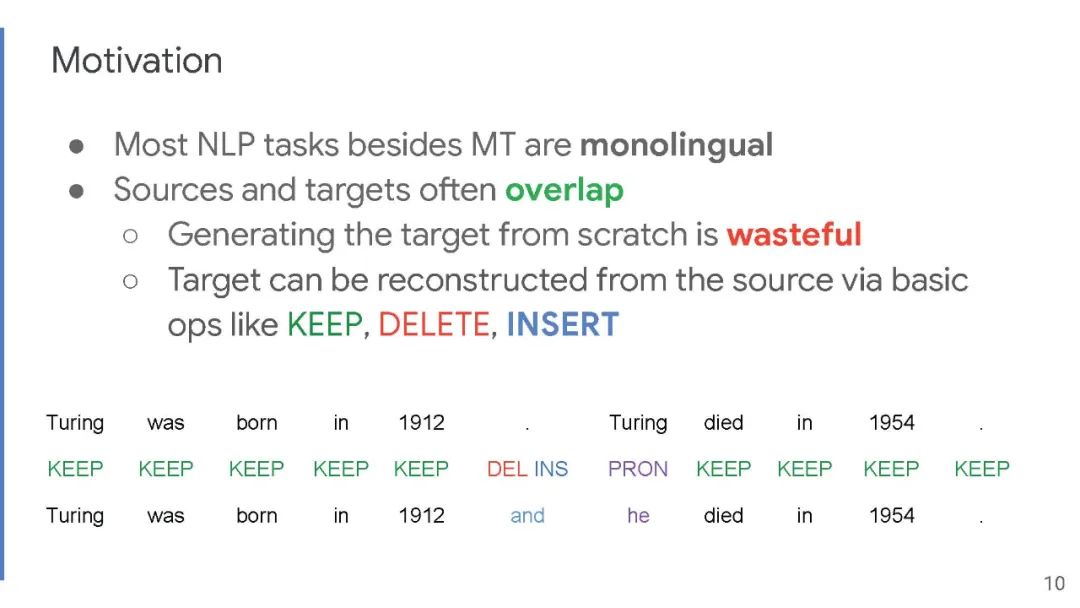

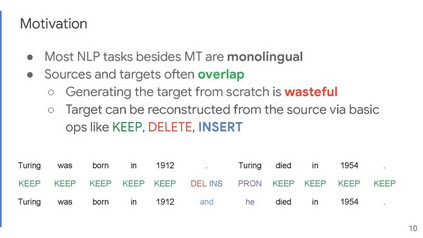

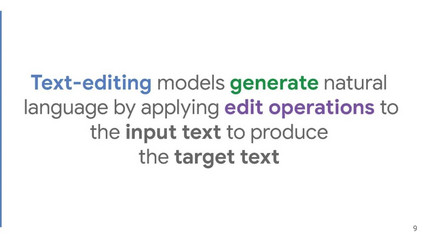

近期,文本编辑模型已成为单语文本生成任务的重要替代,如语法错误修正、文本简化和风格转换。这些任务有一个共同的特点 - 它们在源文本和目标文本之间显示出大量的文本重叠。

文本编辑模型利用这一观察结果,学习通过预测对源序列应用的编辑操作来生成输出。相比之下,seq2seq模型从头开始逐词生成输出,这使得它们在推理时很慢。文本编辑模型相对于seq2seq模型提供了若干优势,包括更快的推理速度、更高的样本效率,以及更好的输出控制和解释性。

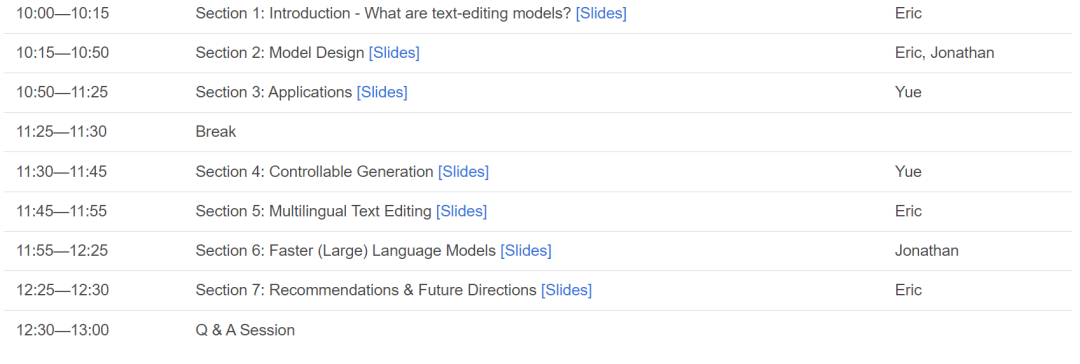

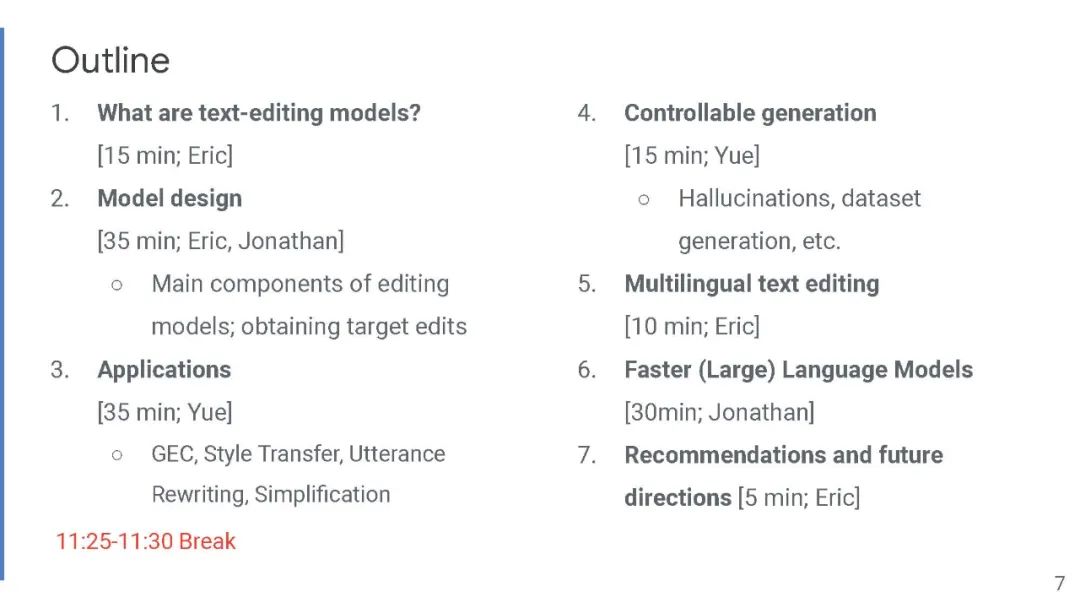

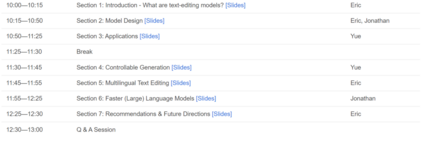

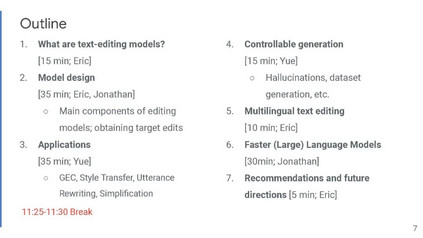

本教程提供了基于文本编辑的模型和当前最先进方法的全面概述,并分析了它们的优缺点。我们讨论了与部署相关的挑战,以及这些模型如何有助于减轻幻觉和偏见,这两个都是文本生成领域的迫切挑战。 目录内容:

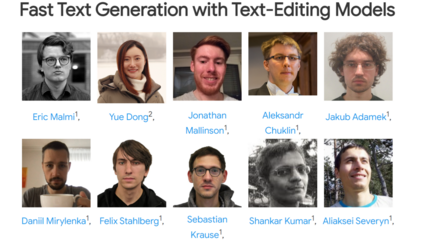

讲者:

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2023年9月26日