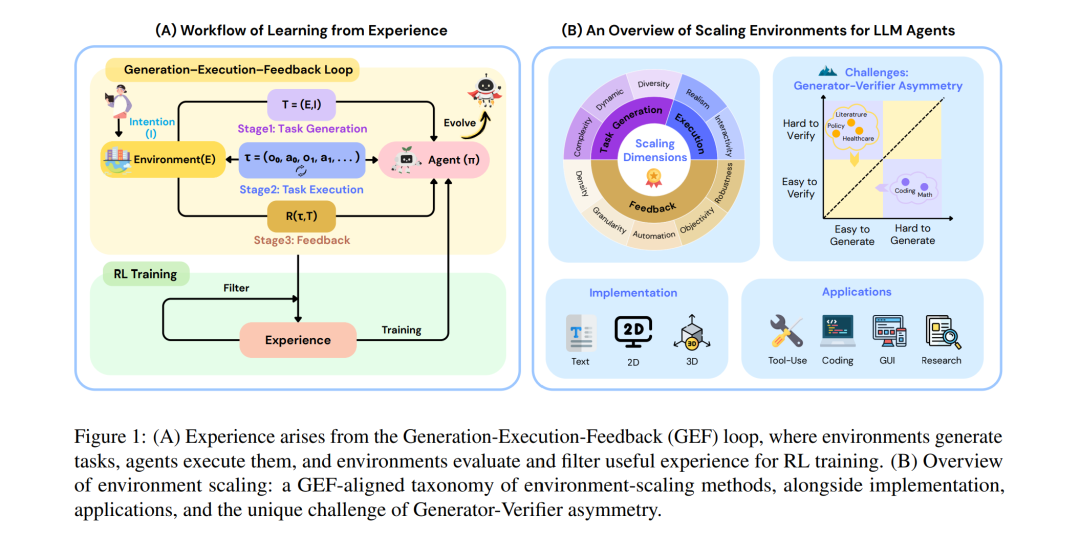

基于大语言模型(LLM)的智能体已经能够在多个领域自主完成复杂任务。然而,若要进一步培养其自适应行为与长期决策等能力,仅依赖基于人类知识构建的静态数据集仍远远不够。这类数据集不仅构建成本高昂,还缺乏动态性与真实性。越来越多的共识认为,智能体应直接与环境交互,并通过强化学习从经验中学习。 我们将这一迭代过程形式化为 生成–执行–反馈(Generation–Execution–Feedback, GEF)循环:其中,环境通过生成任务来挑战智能体;智能体在任务执行过程中采取行动,环境据此返回观测;环境随后对智能体的轨迹提供评估性反馈,支持其后续学习。在该范式下,环境成为经验数据不可或缺的生产者,因此亟需朝着更高的复杂度、真实性与交互性方向扩展规模。

在本综述中,我们从开创性的“环境中心”视角出发,对环境扩展的代表性方法进行系统性回顾,并按 GEF 循环的三个阶段——任务生成、任务执行与任务反馈——进行梳理。此外,我们还分析了相关基准、实现策略与应用场景,以整合当前零散的进展,并展望智能体智能未来的发展方向。

1 引言

大语言模型(LLM)的快速发展正在推动人工智能领域的范式性转变,催生了大量关于基于 LLM 的智能体研究(Luo et al., 2025b; Xi et al., 2025)。此类智能体继承了基础模型强大的推理与任务分解能力,并在配备工具使用、记忆等模块后,能够执行动作、与真实或模拟环境交互、随时间积累经验,并不断改进自身行为。这一设计已在多个领域取得显著进展,包括自动化编程(Qwen Team, 2025; Anthropic, 2025)、交互式网页导航(OpenAI, 2025a; He et al., 2025)、工具使用(Zhang et al., 2025e; Anthropic, 2024)以及深度研究(Tongyi DeepResearch Team, 2025; OpenAI, 2025b; Google DeepMind, 2024)。

然而,随着智能体能力的不断提升,仅依靠在静态数据集上对预训练模型进行监督微调(SFT),已经难以实现超越人类水平的智能(Huang et al., 2025a; Su et al., 2025a; Zhao et al., 2025)。这类数据集通常由人工标注或在人工监督下构建,因此不仅成本高、难以规模化生产,而且天然受限于人类知识水平,缺乏真实性与适应性。相比之下,强化学习提供了一种更契合的训练范式(Tao et al., 2024; Zhang et al., 2025a),使智能体能够在环境中探索、积累经验,并最终获得新的知识或技能。

我们将这一交互式过程形式化为 生成–执行–反馈(Generation–Execution–Feedback, GEF)循环,如图 1(A) 所示。在每一轮迭代中,环境首先生成多样化的任务;随后智能体在环境中执行任务并产生动作–观测轨迹;接着环境对这些轨迹进行评估,并保留有价值的经验用于后续训练。持续迭代可逐步优化策略并扩展智能体能力。值得注意的是,与先前研究(Gao et al., 2025)不同,我们对“环境”采用了更广泛的定义:智能体外部的一切,包括状态空间、可执行动作空间、用于交互与评估的反馈设计、以及用户与其他智能体的活动,都被视为环境的一部分。在此背景下,环境不再是智能体活动的被动容器,而是体验数据的主动生产者,这凸显了将环境扩展至更加复杂、真实且交互丰富世界的重要性(CAMEL-AI, 2025)。

近期研究从多个角度拥抱了这一环境扩展趋势。例如,AgentGen(Hu et al., 2025c)、AgentGym(Xi et al., 2024)与 GEM(Liu et al., 2025b)构建了异质化环境以提升任务生成的多样性;RZero(Huang et al., 2025a)提出了挑战者–求解者框架,可自主生成难度不断提升的任务;RandomWorld(Sullivan et al., 2025)通过程序化生成大量工具来提升智能体可用工具的交互性;ARE(Andrews et al., 2025)开发了事件驱动环境,支持环境与智能体之间的异步交互,从而扩展更符合现实的环境动态。然而,这些研究方向之间仍缺乏系统性的关联分析。

为此,我们全面梳理当前的环境扩展方法,并提出与 GEF 循环阶段相一致的统一分类体系,从一个开创性的“环境中心”视角出发。在任务生成阶段,我们将环境扩展方法划分为复杂度扩展、动态性扩展与多样性扩展,这三者共同描述了环境持续生成具挑战性、自适应且多样化任务的能力。在任务执行阶段,我们重点关注交互性与真实性,因为这些属性决定了智能体学习所依赖的交互数据的丰富性与逼真度。在反馈阶段,我们从密度、粒度、自动化程度、客观性与鲁棒性五个维度对评估信号的扩展进行分类。 在上述分类体系之外,我们还分析了当前的评测基准、实现框架、应用场景以及未来研究方向。图 1(B) 展示了环境扩展的总体概览,代表性工作如图 2 所示。

本文结构安排如下:我们首先在第 §2 和附录 §A 中介绍背景与概念框架;随后基于三阶段分类体系分别讨论任务生成(§3)、任务执行(§4)与反馈(§5);接着在附录 §B 讨论评测基准,在第 §6 介绍实现框架,并在附录 §C 中讨论应用场景;最后在 §7 展望未来研究方向。