在线持续学习(OCL)是机器学习中的一个关键领域,旨在使模型能够在实时适应不断变化的数据流的同时,解决诸如灾难性遗忘和稳定性-可塑性权衡等挑战。本研究对在线持续学习(OCL)进行了首次全面的系统性文献综述(SLR),分析了81种方法,提取了超过1000个特征(这些方法所解决的具体任务),并识别出了超过500个组件(方法中的子模型,包括算法和工具)。我们还回顾了83个数据集,涵盖了图像分类、目标检测和多模态视觉-语言任务等应用领域。我们的研究结果突出了关键挑战,包括减少计算开销、开发领域无关的解决方案,以及在资源受限的环境中提高可扩展性。此外,我们还识别出一些有前景的未来研究方向,例如利用自监督学习处理多模态和序列数据,设计集成稀疏检索和生成回放的自适应记忆机制,以及为处理噪声或不断变化的任务边界的真实世界应用创建高效的框架。通过对当前在线持续学习(OCL)领域的严格而结构化的综述,本研究为推动该领域的发展,解决其关键挑战和机会提供了宝贵的资源。完整的系统性文献综述方法步骤和提取的数据可以通过以下链接公开访问: https://github.com/kiyan-rezaee/Systematic-Literature-Review-on-Online-Continual-Learning 关键词:在线持续学习、灾难性遗忘、增量学习、终身学习、稳定性-可塑性权衡

1 引言

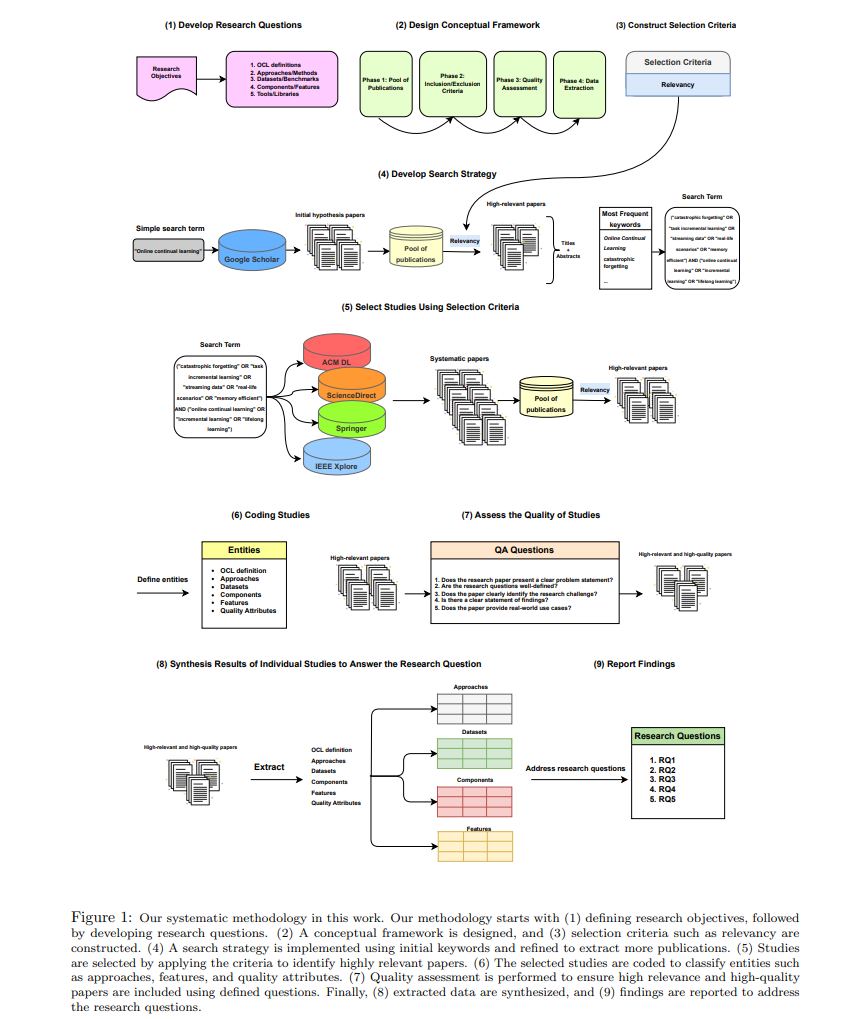

人工智能(AI)在各行各业的日益融合凸显了需要能够适应动态和不断发展的环境的模型。持续学习(CL)是机器学习的一个子领域,旨在使模型能够从连续的数据流中逐步学习并更新其知识[2, 48–51]。持续学习模型的能力对于开发能够适应和恢复的模型至关重要,这些模型能够在不断变化的环境中运行,同时避免丧失以前学到的知识,这一挑战通常被称为灾难性遗忘[1, 47, 113]。 在线持续学习(OCL)在持续学习的基础上,强调能够从实时数据流中学习的能力[46, 62]。这种方法与人类认知过程相似,因为它是随着时间的推移逐渐获得并完善知识。OCL在解决动态和不可预测环境中的现实挑战方面表现出色,例如自动驾驶、端到端语音处理和机器人技术[40, 41]。与持续学习类似,OCL模型的一个关键挑战是解决灾难性遗忘问题。为了解决这一问题,研究人员提出了各种方法。经验回放方法[39]保存并回顾过去的数据,以强化先前学到的知识。知识蒸馏[68]也有助于通过将旧模型的知识传递给更新的模型,从而支持在早期任务中的性能保持。 近年来,OCL的研究兴趣大幅增长,相关文献数量不断增加。然而,尽管如此,仍然缺乏一项全面的研究,提供对该领域所有提议方法的清晰和全面的概述。尽管已有一些关于OCL的综述性研究,但它们的重点仍相对狭窄。Parisi等人[88]提供了OCL中基础概念的全面概述,例如灾难性遗忘和稳定性-可塑性权衡。他们还讨论了受生物启发的策略,这些策略汲取了大脑如何随着时间的推移学习和适应的见解。为了解决由顺序、非独立同分布(non-i.i.d.)数据所带来的挑战,他们将现有方法分为三类:基于突触的方法,专注于通过突触正则化等技术保护重要参数;结构适应策略,涉及动态调整网络架构,如添加或修剪神经元和连接;以及自组织神经网络模型,这些模型受到生物网络的启发,专注于在响应新数据时组织和调整其结构。同样,Hayes等人[89]研究了受限设备下的OCL,重点关注内存和计算限制,并评估了各种CNN架构中的样本效率和推理方法。Mai等人[110]对OCL技术进行了实证分析,强调了在类和领域增量设置中的遗忘管理,并讨论了准确性和知识转移等关键指标。 虽然这些综述研究提供了宝贵的见解,但它们的范围有限,更多聚焦于特定方法或类别,而不是对OCL的全面概述。为了解决这一空白,我们进行了首次OCL的系统性文献综述(SLR),遵循Newman的指南[45],确保对当前领域状态的严格和结构化综合分析。我们的方法提供了对现有研究的全面且无偏的综述,重点明确的纳入标准、数据提取协议和质量评估[43, 44]。 在我们的研究中,我们分析了81种独特的OCL方法,识别出了500多个组件,包括模块化子模型、算法和工具,并提取了超过1,000个特征,这些特征涵盖了任务设置和应对OCL特定挑战的策略。此外,我们还编制了一份详尽的83个数据集清单,突出显示了OCL方法在多个领域中的广泛应用。这份详细的综述为未来的研究奠定了坚实的基础,并为推进OCL理解提供了宝贵的见解。 我们的贡献总结如下: 1. 我们进行了首次OCL的系统性文献综述(SLR),严格遵循Newman的指南。我们的结构化SLR方法确保了无偏和全面的分析,使我们能够识别未解决的挑战,提出未来的研究方向,并突出该领域的进展机会。 1. 我们对81种OCL方法进行了深入分析,识别出了超过500个组件,并提取了超过1,000个特征,涵盖了任务设置和应对OCL特定挑战的策略。 1. 我们编制了一个详尽的83个数据集清单,提供了一个宝贵的资源,供研究人员在多个领域的OCL应用中使用,从图像分类到自动化系统和机器人等专门领域。

本文的其余部分组织如下:第2节概述了系统化的方法论,包括研究问题的制定、选择标准和数据提取程序。第3节全面分析了OCL方法、数据集和评估指标,重点介绍了方法的策略分类以及关键组件和挑战的识别。在第4节中,我们回答了研究问题,讨论了未解决的挑战,提出了未来的研究方向,并提供了推进OCL研究的宝贵资源。