提示调优

·

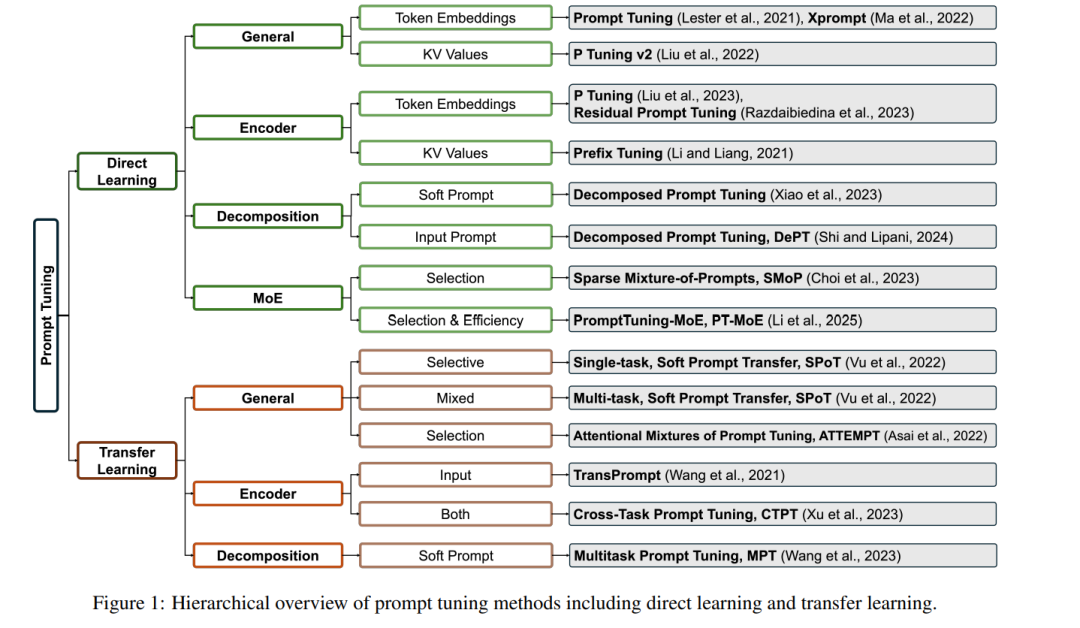

本综述回顾了提示调优(prompt tuning)这一参数高效的语言模型适配方法。该方法通过在模型输入前添加可训练的连续向量,并保持预训练语言模型本体冻结,从而实现模型在下游任务上的快速适应。 我们将现有方法归类为两大类:直接提示学习与迁移学习。 * 直接提示学习方法包括:通用优化策略、基于编码器的方法、分解策略,以及专家混合框架(mixture-of-experts frameworks)。 * 迁移学习方法包括:通用迁移策略、基于编码器的方法,以及分解策略。

对于每类方法,本文从方法设计、创新点、核心洞察、优缺点等方面进行了系统分析,并通过可视化图示比较不同提示调优框架。 此外,我们识别出该领域在计算效率与训练稳定性方面所面临的挑战,并讨论了未来在提升训练鲁棒性与拓展应用范围方向的研究前景。

成为VIP会员查看完整内容

相关内容

Arxiv

86+阅读 · 2023年4月4日