未来人类会关注可解释性吗?

人工智能,深度学习,大家都在抱怨现在的深度神经元算法和结果的不可解释性,是个黑盒子。

原因大概几种:

没有可解释性,研究方向不明确。

没有可解释性,研究结果不能以理服人。

没有可解释性,出了问题没法debug。

没有可解释性,问题看着修复了,其实不知道是否真的修复了。

等等。

那么,什么是可解释性呢?

可解释性指在人类需要了解决一个问题的时候,可以获得所需要的足够的可以理解的信息。比如在调试bug的时候,需要通过变量审查和日志信息定位到问题出在哪里。比如在科学研究中面临一个新问题的研究时,需要查阅一些资料来了解这个新问题的基本概念和研究现状,以获得对研究方向的正确认识。可解释性,一个定义:“Interpretation is the process of giving explanations to Human”,总结一下就是“说人话”。

所以,一个研究方向就是让深度学习的算法具有可解释性。比如把知识图谱和神经元网络结合起来,让结果能通过知识图谱解释。

但是,可解释性真的是个问题吗?未来人类还会关注可解释性吗?

尤瓦尔·赫拉利在《今日简史》中对这个有深度的论述,基本的观点是,随着算法的准确度的提高,比如,三个9,四个9的准确率,那是,人类就会选择相信算法本身,而不是算法后面的原理和可解释性。或者说,算法本身就是一个解释。

这个,和人类的进化是一脉相传的。人类很多的情况下,会是相信直觉,而不是深度思维。卡尼曼在《思维,快与慢》中就对直觉思维有深度的论述,人类,由于在进化的过程中为了躲避危险,很多情况下就是直觉判断,来不及深度思考。这种进化结构,一直延续到现在。鉴于人类还是习惯花最少的能量干最多的活,这种方式还将延续下去。既然这样,可以预见在未来,人类会简单的相信算法的决策,而不会去关注算法后面的逻辑。这就是说,如果大家都公认某个算法,那么,算法的结果本身就是对要解决问题的一种解释或是证据。谁还会去关注证据后面的证据,解释后面的解释,推理后面的推理。习惯成自然。

从现在的观察来看,人类很多的决定,也不是一定要求解释性。大人叫小孩去干啥,老师叫学生去干啥,老板叫员工去做啥,很多时候都是没有解释,不问理由就去执行。在很多人的生活中,遇到一个事情为啥要这么做时,很多的人可能会说,“我爸妈告诉我这样做的”,“老师这么说的”,“老板这么交代的”,“专家这么讲的”,“领导这么吩咐的”。还有,很多文档,大量引经据典,大概也是这种情况。家长,老师,老板,专家,领导,名人,经典,等,他们就相当与正确(很大程度上正确)的算法,如果这个算法建立了一定的声誉,谁还会去关注算法本身,只会关注算法的结论,按照算法的结果执行就好了。看看,现在,很多人的投资逻辑,就是听信小道消息,听信“专家”,听信“朋友”,甚至是从众,完全没有自己的独立思考(可解释性),这种趋势,有增无减。很多情况下,没有对错,做的人多了,可能就被认为是真理了。谎话重复一千遍就可能成为真理。人性使然。

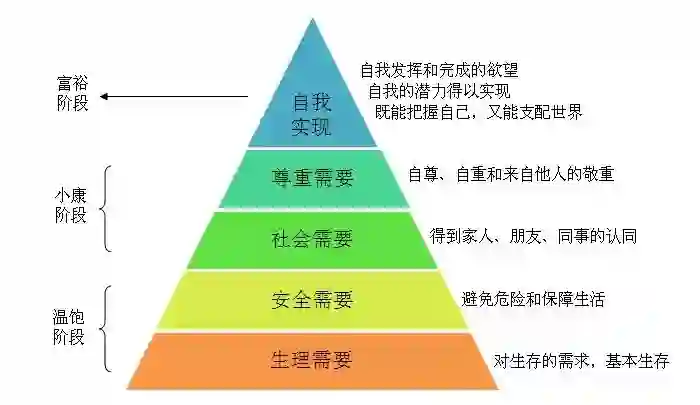

可解释性,“说人话”,很大的一个原因,是满足人类心理安全的需求。马斯洛需求理论中的需求金字塔中的安全需求。然而,当某种需求已经大面积被满足,而且成为一种utility的时候,就像网络,水,点,空气,那么这种需求就不再是一种人们能主动提出的需求,因为默认就是。当人们已经想不起这个可解释性的需求的时候,那深度学习算法的可解释性也就无足轻重了。

再者,就算有了可解释性,来满足人类的心理需求。这种可解释性,在很多情形下,其实也不是100%的正确,毕竟,各种意外情况层出不穷,黑天鹅事件,人类见得和经历过不少了。那么,缺少可解释性,到底会有多大的障碍呢,多大的影响呢,现实证明,好像不大。

当然,不可解释同样也意味着危险,事实上很多领域对深度学习模型应用的顾虑除了模型本身无法给出足够的信息之外,也有或多或少关于安全性的考虑。但是,比如,自动驾驶,相对人驾驶,可能已经安全多了。最后,这个可能也不是人类特别在意的问题了。毕竟,世界上没有绝对的安全。

也许,未来人类会选择相信算法,而不是去纠结后面的可解释性了。