计算基础设施的发展一直是近年来机器学习(Machine Learning, ML)重大突破的关键驱动力。如今,每年在 ML 软件与硬件基础设施上的投资高达数千亿美元,机器学习系统的效率比以往任何时候都更加重要。 目前,有两大趋势正在塑造 ML 系统的演进。

首先,现代 AI 系统正变得越来越复杂,往往集成了超出模型本身的多个组件——向量数据系统在其中发挥着关键作用。一个典型例子是检索增强生成(Retrieval-Augmented Generation, RAG),它不仅融合了多个模型组件,还结合了基于向量数据库的向量检索系统。系统组件(模型与向量数据系统)以及底层硬件(用于模型的 ML 加速器与用于检索的异构硬件)的异质性,使得这些工作负载与传统的模型推理与训练有显著不同。

其次,随着摩尔定律的终结,具备专用或异构硬件的计算机系统日益普及。多样化硬件组件的存在——其计算能力、内存层次结构及互连架构各不相同——带来了新的挑战:如果不充分考虑硬件格局的快速演变,实现高系统效率已不再可行。 基于上述两点观察,本论文围绕机器学习系统效率提出了三个关键研究问题: 1. 如何为新兴且复杂的 ML 工作负载(如 RAG 推理服务)设计高效的系统? 1. 如何开发更高效的向量数据系统与硬件? 1. 在后摩尔时代,如何在算法、系统与硬件之间实现协同优化?

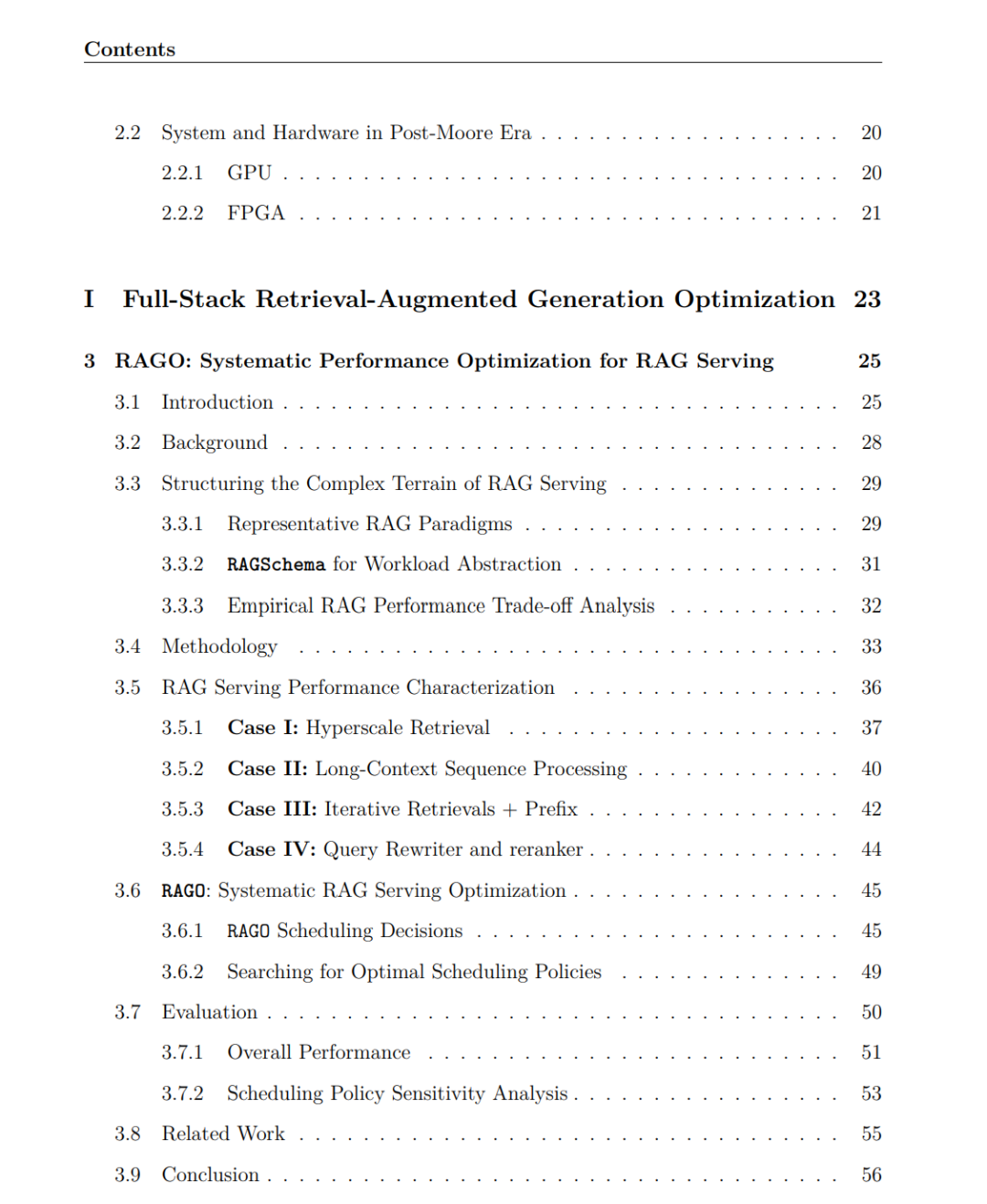

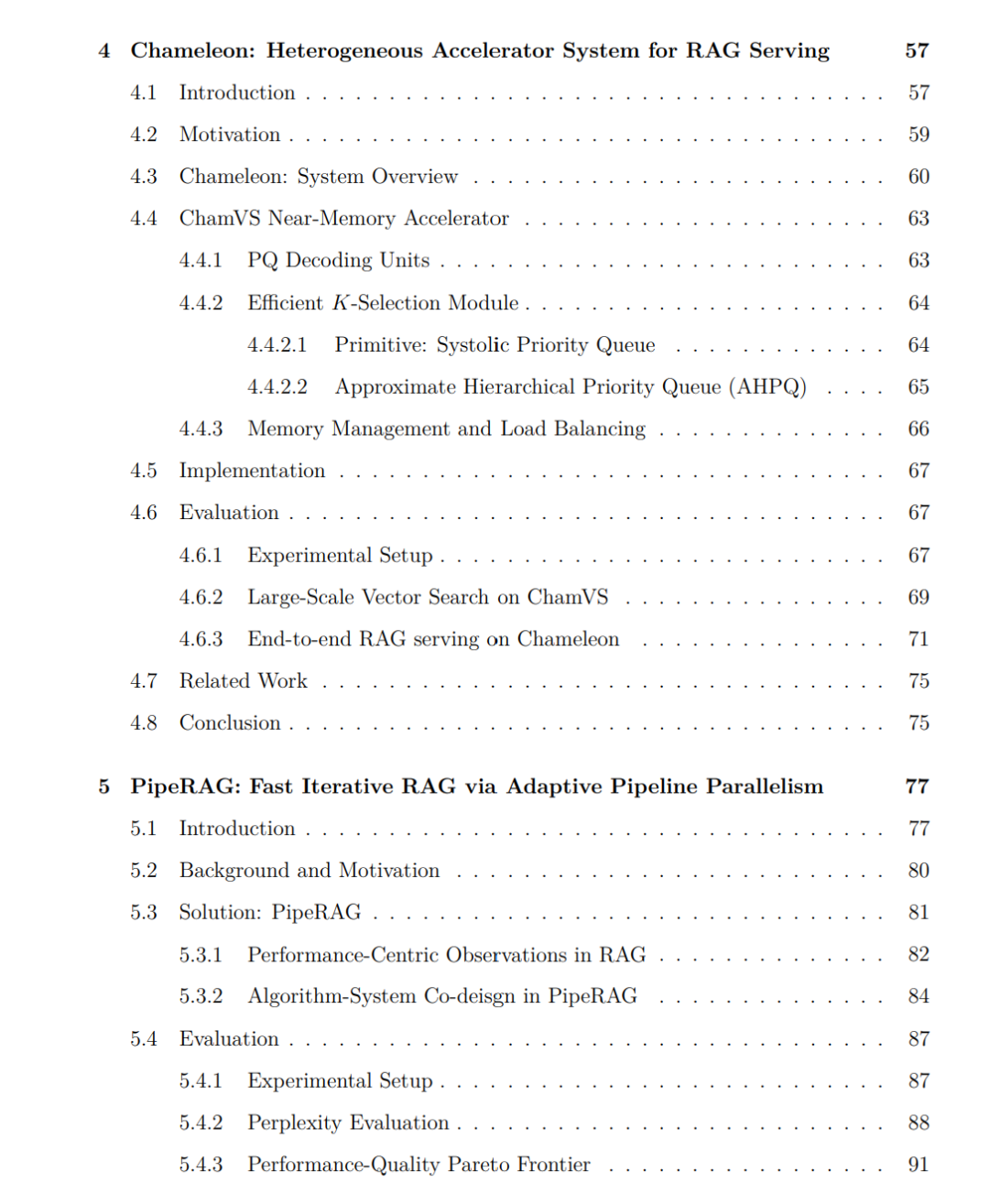

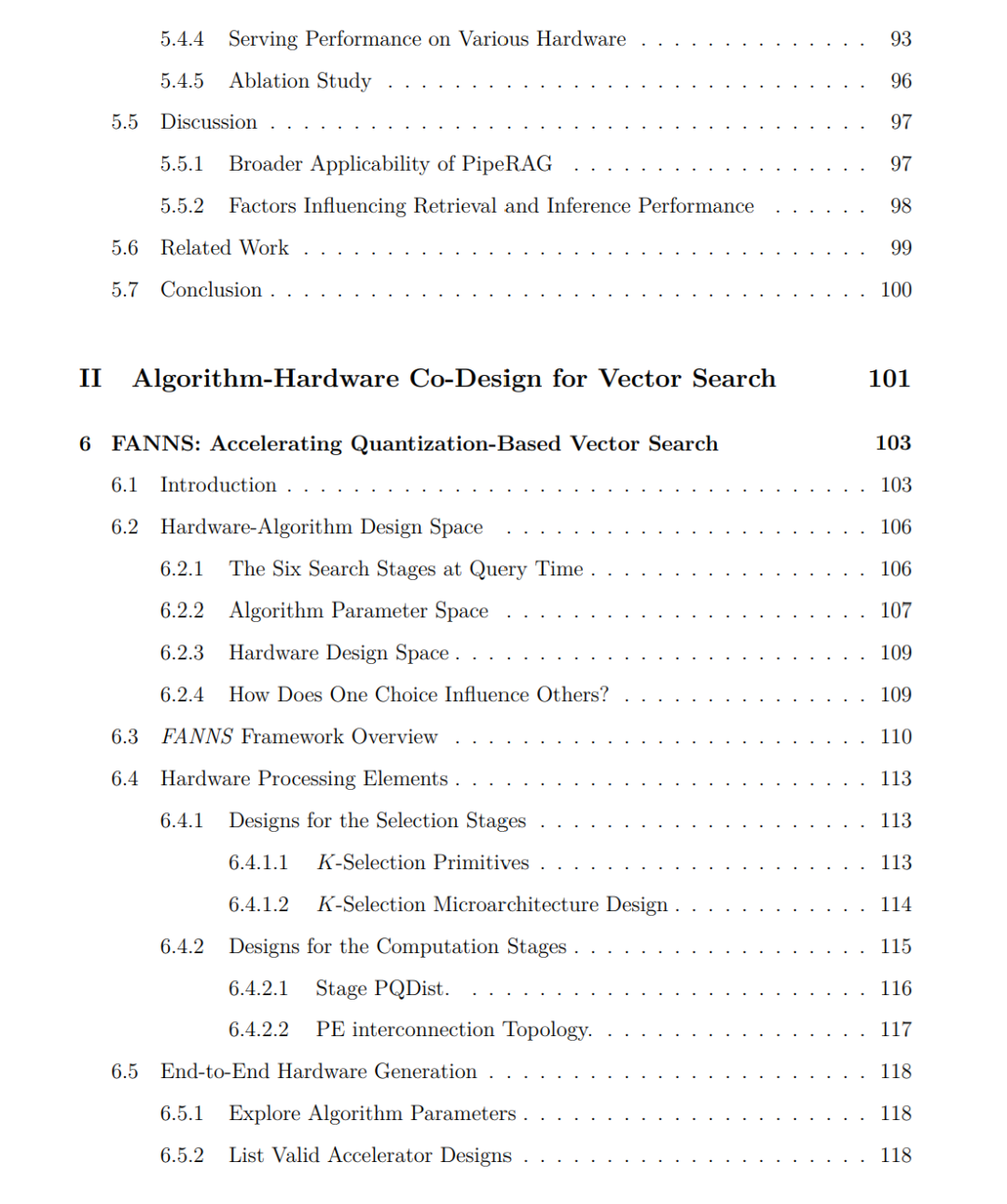

为解答这些问题,本论文采用了跨栈(cross-stack)方法,并在提升 ML 系统效率方面做出了三大主要贡献,涵盖算法、系统与硬件三个层面。 首先,针对 RAG 推理服务在整个计算栈的效率问题,本论文提出了多项开创性工作:PipeRAG 聚焦算法层面的改进,RAGO 引入系统层优化,Chameleon 探索在 RAG 中使用异构加速器系统的方案。 其次,本论文研究了面向向量检索的算法-硬件协同设计,这不仅是 RAG 系统的核心环节,也在搜索引擎、推荐系统等领域具有重要意义。具体而言,FANNS 与 Falcon 分别优化了基于量化和基于图的两类最流行检索算法范式。 第三,本论文关注推荐系统的推理效率——这也是向量中心型(vector-centric)ML 系统的另一典型案例。在推荐模型中,对嵌入向量表的内存密集型查找操作常常是主要性能瓶颈。MicroRec 与 FleetRec 分别在硬件与系统层面提出解决方案,同时优化数据传输与计算,从而提升大规模推荐模型的效率。 本论文的研究工作并非一次性成果,而是迈向 ML 基础设施持续演进的奠基之作。它强调了两点重要性:(a) 优化现代 ML 流水线中的向量数据系统;(b) 在整个计算栈上追求性能优化。本文提出的思想将为下一代 ML 系统的设计与实现提供坚实基础。