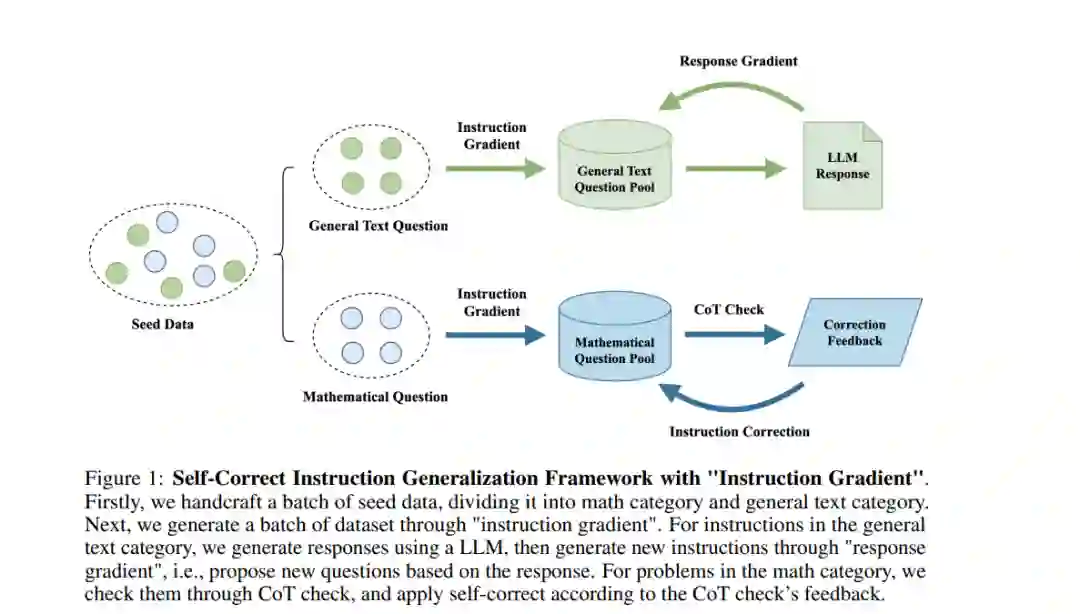

随着大型语言模型 (LLMs) 在处理复杂任务方面变得越来越娴熟,评估集也必须跟上这些进展,以确保其具有足够的区分度。广泛应用于教育评估中的项目区分度 (ID) 理论衡量的是单个测试项目区分高低表现者的能力。受该理论的启发,我们提出了一种基于项目区分度的提示生成框架,用于评估 LLMs,确保评估集能够根据模型能力不断更新和改进。我们的数据生成框架既重视广度又重视特异性,能够生成全面评估 LLMs 能力的提示,同时揭示模型之间有意义的性能差异,从而有效区分它们在各类任务和领域中的相对强项和弱项。 为了生成高质量数据,我们在泛化框架中引入了自我修正机制,并开发了两个模型来预测提示的区分度和难度评分,以便促进我们的数据生成框架,为评估数据生成研究贡献了有价值的工具。我们将生成的数据应用于评估五个现今最先进的模型。我们的数据平均得分为 51.92,方差为 10.06。相比之下,之前的工作(如 SELF-INSTRUCT 和 WizardLM)平均得分超过 67,方差低于 3.2。结果表明,我们框架生成的数据相比之前的工作更加具有挑战性和区分度。我们将发布包含超过 3,000 个精心设计的提示的数据集,以促进 LLMs 评估研究的发展。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日