本论文评估了大语言模型(LLMs)在不同模型规模和架构下的多语言事件提取能力,以探索使用生成模型进行多语言事件提取的可行性。论文使用了一个由翻译成 18 种语言的抗议事件文章合成生成的数据集,评估了来自四个不同系列(Phi-3、Qwen 2.5、Gemma 2 和 Mistral)的 12 个模型在三个规模层级上的表现。研究采用了一种生成式提取方法,在所有模型中使用单一提示,从描述抗议事件的新闻文章中提取四个关键部分:参与者、目标、地点和日期。该研究使用相同的方法将事件分为五类:暴乱、示威、阻挠、罢工或抵制。结果表明,较大的模型都能实现一致的多语言性能,其中 Gemma 2 和 Qwen 2.5 表现尤为出色。性能模式表明,不同领域的提取难度存在系统性差异,结构化信息(日期、地点)和分类(类型)比语义元素(行为者、目标)更容易处理。这项研究有助于了解 LLMs 在信息提取和分类方面的多语言能力,对分析大量多语言新闻源(如开源情报、信息环境中的行动或政治事件分析)具有重要意义。

随着军事和情报机构在处理大量多语言信息方面面临越来越多的挑战,自动提取和分类跨语言事件的能力对于态势感知和决策变得至关重要。本论文评估了生成式大语言模型(LLMs)从新闻源中提取信息的多语言能力,以探索使用生成式模型进行多语言政治事件提取的可行性。

该研究仅限于抗议事件,抗议事件是政治事件的一个子集,通常包含旨在政治变革的集体行动,有时可能是政治动乱或冲突的前兆。这项研究既有助于从理论上理解 LLM 的能力,也有助于多语言信息提取系统的实际应用,可直接应用于信息环境中的行动(OIE)、军事情报和全球局势监测。研究结果表明,即使是相对较小的、开放式的模型也能有效处理多语言信息,从而有可能在不久的将来改变军事组织管理各级外语情报的方式。

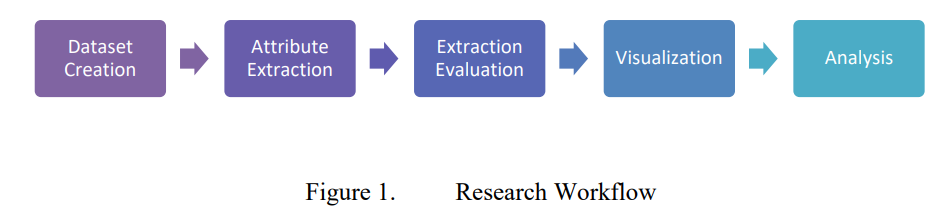

研究方法

本研究评估了四个模型系列(Gemma2、Qwen 2.5、Mistral 和 Phi-3)和三个规模层级的 12 个开放式 LLMs 在 19 种语言中提取关键事件信息(行为者、目标、地点、日期)和对抗议事件类型(暴乱、示威、阻挠、罢工或抵制)进行分类的能力。我们设计了一个新颖的评估框架,使用合成新闻文章作为基本事实,并通过语义相似性和精确匹配等各种指标来衡量提取的准确性。

主要发现

主要研究结果表明,与原始参数数量相比,模型架构和预训练方法对多语种性能的影响可能更大。较小的、专门设计的模型在不同语言中的表现可以与较大的模型相媲美,甚至超过后者。结构化信息(日期、地点、事件类型)的提取比语义信息(参与者、目标)更准确,这表明定义明确的提取任务在实际应用中更可靠。

通过成功改进现有的抗议活动数据集,还展示了一项实际应用。通过基于 LLM 的分类,数据集的质量得到了显著提高,正确分类抗议事件的比例从 39% 提高到 66%。这一改进证明了 LLM 在政治事件分析应用中提高数据质量的直接实用性。

研究结果与情报和信息部队特别相关。例如,在监测整个中东地区的抗议运动时,情报分析师可以使用 LLMs 同时快速处理阿拉伯语、波斯语和希伯来语新闻来源,对结构化信息的提取具有很高的信心,同时对更细微的行为者分析保持人工监督。

研究结果还表明,LLMs 可以衡量所使用的信息部队能力的有效性,从而为 OIE 做出贡献。在动用信息部队应对地区动乱时,部队可利用这些模型快速处理当地语言媒体,跟踪信息环境如何随其行动而变化。例如,在抗议活动期间反击对手的言论时,OIE 单位可以监控多种语言的报道,以发现当地媒体如何描述事件的变化。这种近乎实时的反馈使各单位能够评估行动效果,调整 OIE 战略,并验证其行动是否达到预期效果。

建议

1.军队应探索在 OIE 中使用 LLMs 进行作战决策,特别是快速处理多语言信息来源

2.为支持这一努力,应开发 LLM 评估的稳健方法

3.小型、高性能模型有利于本地部署,因此应优先考虑

4.结构化信息提取和分类显示出最高的可靠性,因此最初应将工作重点放在此类任务上。