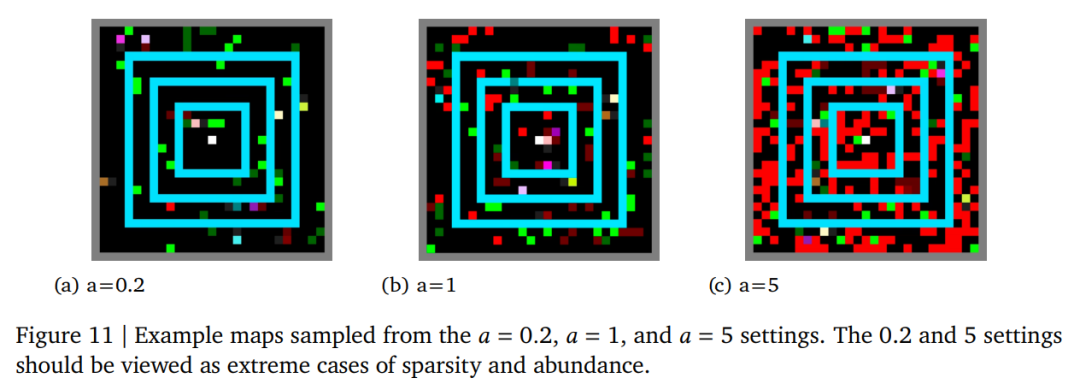

DeepMind最新114页报告《多智能体强化学习中的新兴易货贸易行为》

专知便捷查看

便捷下载,请关注专知人工智能公众号(点击上方蓝色专知关注)

后台回复“RL114” 就可以获取《DeepMind最新114页报告《多智能体强化学习中的新兴易货贸易行为》》专知下载链接

登录查看更多

专知便捷查看

便捷下载,请关注专知人工智能公众号(点击上方蓝色专知关注)

后台回复“RL114” 就可以获取《DeepMind最新114页报告《多智能体强化学习中的新兴易货贸易行为》》专知下载链接