因果推理是人类智能的基石,也是人工智能系统实现高级理解与决策能力的关键能力。

本论文深入探讨了大型语言模型(LLMs)在因果推理与因果理解方面的多个维度。内容涵盖一系列研究,探索 LLMs 的因果推理能力、其表现机制,以及因果与反因果学习在自然语言处理(NLP)任务中的意义。此外,论文还考察了因果推理在基于文本的计算社会科学中的应用,特别聚焦于政治决策过程以及通过引文评估科研影响力两个方面。 通过构建新型数据集、基准任务和方法框架,本研究识别出当前提升 LLMs 因果能力所面临的关键挑战与潜在机遇,为该领域的未来研究提供了系统性基础。

1.1 概述

因果性是人类认知与智能的基本要素,支撑着我们理解世界和做出决策的能力。

在自然语言处理(Natural Language Processing, NLP)领域,推断和推理因果关系的能力正日益被视为智能系统的关键组成部分。 尽管近年来大型语言模型(Large Language Models, LLMs)取得了显著进展(Radford 等,2019;Devlin 等,2019;Brown 等,2020;Zhang 等,2022;OpenAI,2023;Ignat 等,2024,等),但一个核心问题仍未解决:这些模型是否真正理解并具备因果推理能力?

这是在将 AI 智能体应用于实际决策系统之前必须掌握的关键技能。同时,即使 LLMs 在某些推理任务上取得了成功,它们的决策过程仍然缺乏透明性,这引发了对模型可解释性的强烈需求(Luo 和 Specia,2024;Räuker 等,2023;Zou 等,2023)。 为弥合这一差距,本论文系统地探讨了 LLMs 中的因果推理多个面向。我们提出了一系列研究工作,涵盖以下四部分: * LLM 的因果推理能力(第一部分); * 模型决策机制的因果理解(第二部分); * 学习变量间的因果关系(第三部分); * NLP 与因果推理在社会问题中的结合(第四部分)。

以下为各部分及其章节内容的简要介绍:

1.1.1 LLM 的因果推理能力(第一部分)

第一部分聚焦于 LLM 所具备的两种形式化因果推理技能:因果发现(第2章)和因果效应推理(第3章),这两者目前仍是现有模型难以胜任的任务。我们提出了不依赖经验知识的纯推理任务,并构建了具有符号语义支撑的数据集。在此基础上,我们评估模型的原始表现、微调提升效果,并提出通过“思维链(Chain-of-Thought, CoT)”提示使推理步骤形式化。 * 第2章:LLM 中的因果发现

智能系统能否区分相关性与因果性是因果智能的核心。我们提出了 Corr2Cause 基准数据集,用于测试 LLMs 的因果发现能力。该任务要求模型从一组相关语句中判断因果关系。我们用超过 20 万个样本评估了 17 个主流模型,发现它们的表现接近随机猜测,说明在因果推理方面存在根本性缺陷。即使通过微调有所提升,模型仍缺乏泛化能力,仅在训练分布内表现良好,在分布外任务上失败。该研究揭示了提升 LLM 纯推理能力与泛化能力的研究挑战。 * 第3章:LLM 中的因果效应推理

受 Pearl 和 Mackenzie(2018)提出的“因果推理引擎”概念启发,我们构建了包含 1 万个由因果图生成并转化为自然语言的样本。使用该数据集评估 LLM,并引入了链式思维提示策略 CausalCoT。结果表明,LLM 在因果效应推理方面面临诸多挑战,进一步阐明其局限性并为未来改进提供方向。

1.1.2 理解 LLM 的因果机制(第二部分)

除了探究模型是否具备因果推理能力,下一步自然是解释模型如何做出决策。第二部分我们研究两类可解释性方法: * 内在可解释性(Intrinsic Interpretability)(第4章) * 行为可解释性(Behavioral Interpretability)(第5章) * 第4章:内在可解释性

我们提出一种新框架以理解 LLM 的内部机制。大多数研究关注单一机制(如模型如何复制知识),我们则提出“机制竞争”新概念,聚焦多个机制之间的博弈过程,并使用 logit 检查与注意力修改方法揭示不同机制在模型内部的竞争轨迹及其主导预测输出的方式。 * 第5章:行为可解释性

与传统启发式行为测试不同,我们提出系统性框架,通过比较期望因果机制与模型学到的机制之间的偏差来评估行为可解释性。我们以数学推理任务为例,使用因果图分析输入因子(如题干、操作数、运算符)对模型输出的因果效应。研究发现模型鲁棒性不一定随模型规模增长,但 GPT-3 Davinci(175B)在鲁棒性和敏感性上表现优越。结果表明,更深入理解因果机制仍是提升 LLM 泛化能力的关键。

1.1.3 学习变量间的因果关系(第三部分)

在第三部分,我们探讨 NLP 任务中输入输出变量之间的因果结构,旨在提供对模型设计与评估的因果视角。 * 第6章:NLP 中因果与反因果学习的意义

我们将 独立因果机制(ICM) 原则引入 NLP 研究,基于因果方向对任务分类:输入变量引起输出(因果)、输出变量决定输入(反因果)、或混合。对130多篇文献的元分析表明:数据采集的因果方向显著影响学习结果。这是 ICM 首次系统应用于 NLP,并对模型设计提出因果启发建议。 * 第7章:情感分析中的因果与反因果发现

进一步探索变量关系不明确的任务,如情感分析(Sentiment Analysis)。我们结合心理学中的“峰终定律”重构 SA 任务:用因果发现方法区分是评论内容引导情感判断还是相反。研究发现,当预测方向与数据的因果方向一致时,模型性能显著提高。我们还构建了与因果图一致的提示语,显著提升了模型效果,凸显因果机制在 SA 中的重要性。

1.1.4 NLP 与社会科学的因果结合(第四部分)

最后,第四部分将因果推理应用于基于文本的计算社会科学,探讨其在现实世界问题中的作用,具体涵盖: * 第8章:政策决策的因果分析

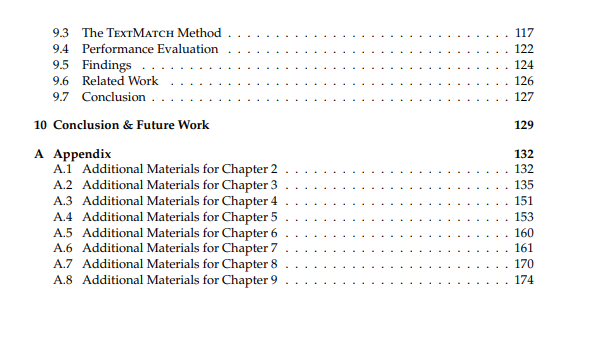

分析 COVID-19 期间社交媒体上的公众舆论如何影响政策制定。控制变量(如确诊增长率、失业率)后,使用推文文本进行因果推理,揭示舆情与政治行为之间的动态关系。 * 第9章:论文引文的因果分析

提出通过因果影响度量科学论文影响力的新方法。使用文本嵌入适配的因果推理方法 TextMatch 评估论文对后续研究的因果影响,提供了比传统计数更准确的科学影响评价方式。

1.2 论文结构

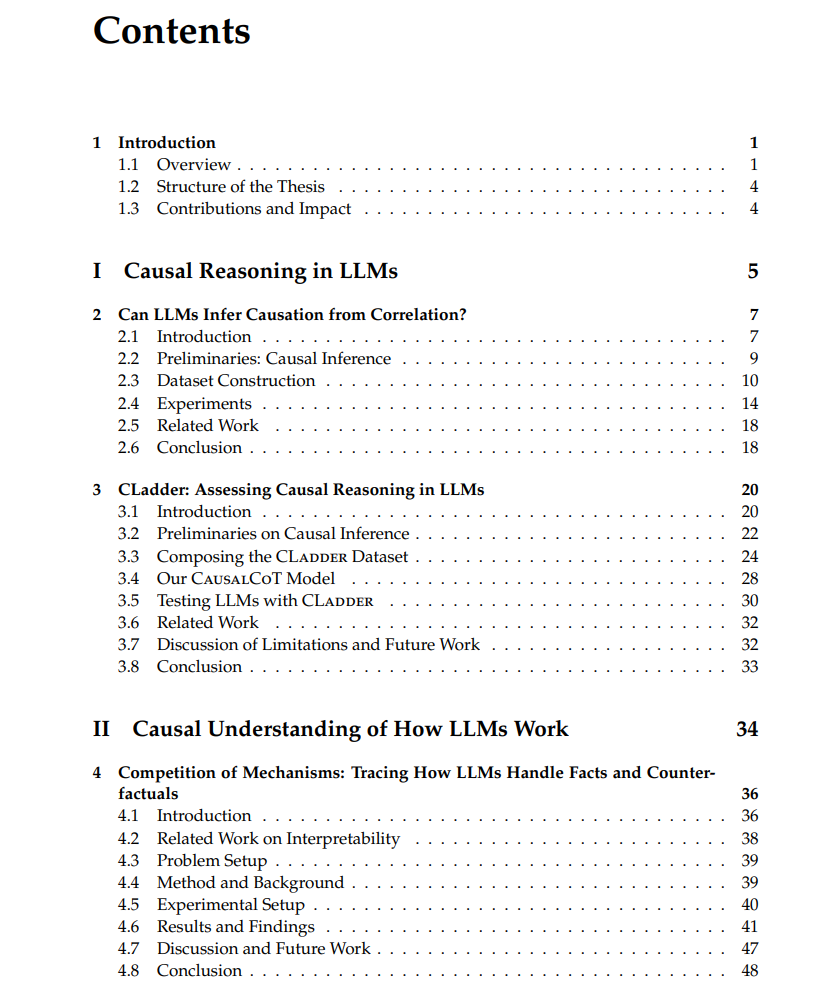

本论文共分为四大部分,对应前述四个主题领域。每一部分包含具体研究、方法与发现,为 NLP 中的因果推理方法提供系统视角: 1. 第一部分:LLM 中的因果推理

构建形式化基准任务,评估 LLM 的因果推理能力,并通过链式思维与微调提升其表现。 1. 第二部分:理解 LLM 的因果机制

利用因果干预与中介分析方法揭示模型内部机制与鲁棒性。 1. 第三部分:学习变量间的因果关系

探索 NLP 任务中输入与输出变量的因果方向,提供建模与评估新视角。 1. 第四部分:文本驱动的社会科学因果分析

将 NLP 与因果推理结合,解决政治决策与科学影响等社会问题。

1.3 贡献与影响

本研究在机器学习因果推理领域作出了以下重要贡献: * 系统评估了 LLM 在因果推理方面的能力与局限; * 提出了基于因果方法的模型干预策略,推动构建更鲁棒且可解释的 AI 系统; * 在计算社会科学中成功应用文本因果推理方法,拓展了 NLP 在社会问题中的研究边界,为理解复杂社会现象提供了新工具与新视角。