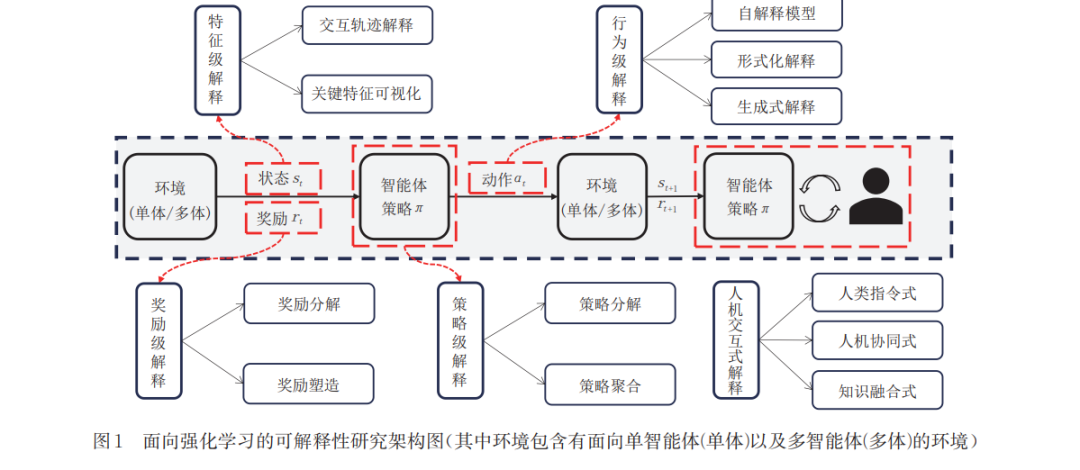

强化学习作为机器学习的一种范式,因其强大的策略试错学习能力,受到关注 .随着深度学习的融入,强 化学习方法在许多复杂的控制任务中取得了巨大成功.然而,深度强化学习网络作为黑盒模型,其缺乏可解释性所 带来的不安全、不可控及难理解等问题限制了强化学习在诸如自动驾驶、智慧医疗等关键领域中的发展.为了解决 这一问题,科研人员开展了对强化学习可解释性的研究 .然而,这些研究开展相对较晚,且缺少针对多智能体强化 学习可解释性方法的系统性总结,同时,可解释性的定义存在人为主观性,导致系统性面向强化学习过程的可解释 性研究较为困难.本文对当前强化学习的可解释性研究工作进行了全面的整理与总结.首先,对强化学习的可解释 性进行定义并总结了相关评估方法.随后,基于马尔可夫决策过程,划分了行为级解释、特征级解释、奖励级解释及 策略级解释四个类别 .此外,在每个类别中,分析了单智能体及多智能体的策略解释方法,并特别关注可解释性研 究中的人为因素,描述了人机交互式的解释方法.最后,对当前强化学习可解释性研究面临的挑战以及未来的研究 方向进行总结与展望.

成为VIP会员查看完整内容

相关内容

强化学习(RL)是机器学习的一个领域,与软件代理应如何在环境中采取行动以最大化累积奖励的概念有关。除了监督学习和非监督学习外,强化学习是三种基本的机器学习范式之一。

强化学习与监督学习的不同之处在于,不需要呈现带标签的输入/输出对,也不需要显式纠正次优动作。相反,重点是在探索(未知领域)和利用(当前知识)之间找到平衡。

该环境通常以马尔可夫决策过程(MDP)的形式陈述,因为针对这种情况的许多强化学习算法都使用动态编程技术。经典动态规划方法和强化学习算法之间的主要区别在于,后者不假设MDP的确切数学模型,并且针对无法采用精确方法的大型MDP。

Arxiv

223+阅读 · 2023年4月7日

Arxiv

152+阅读 · 2023年3月29日