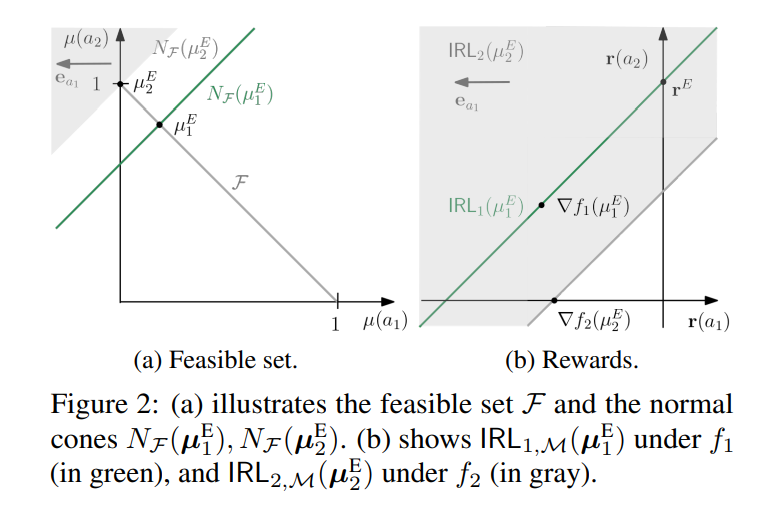

强化学习(RL)的两个主要挑战是设计适当的奖励函数和确保学习策略的安全性。为解决这些挑战,我们提出了一个用于受限马尔可夫决策过程中的反向强化学习(IRL)的理论框架。从凸分析的角度出发,我们扩展了关于奖励可识别性和泛化性的先前结果,使其适用于受限环境和更一般的正则化类。特别地,我们表明,相对于潜在塑造(Cao等人,2021)的可识别性是熵正则化的结果,并且在其他正则化或安全性约束存在时,一般可能不再适用。我们还表明,为了确保对新的转移法则和约束的泛化能力,必须识别出真实奖励到一个常数。此外,我们得出了学习奖励次优性的有限样本保证,并在网格世界环境中验证了我们的结果。

https://www.zhuanzhi.ai/paper/d27fc0061d173d3b14cabaa7060943eb

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2023年7月25日

Arxiv

0+阅读 · 2023年7月25日

Arxiv

0+阅读 · 2023年7月22日

Arxiv

0+阅读 · 2023年7月21日