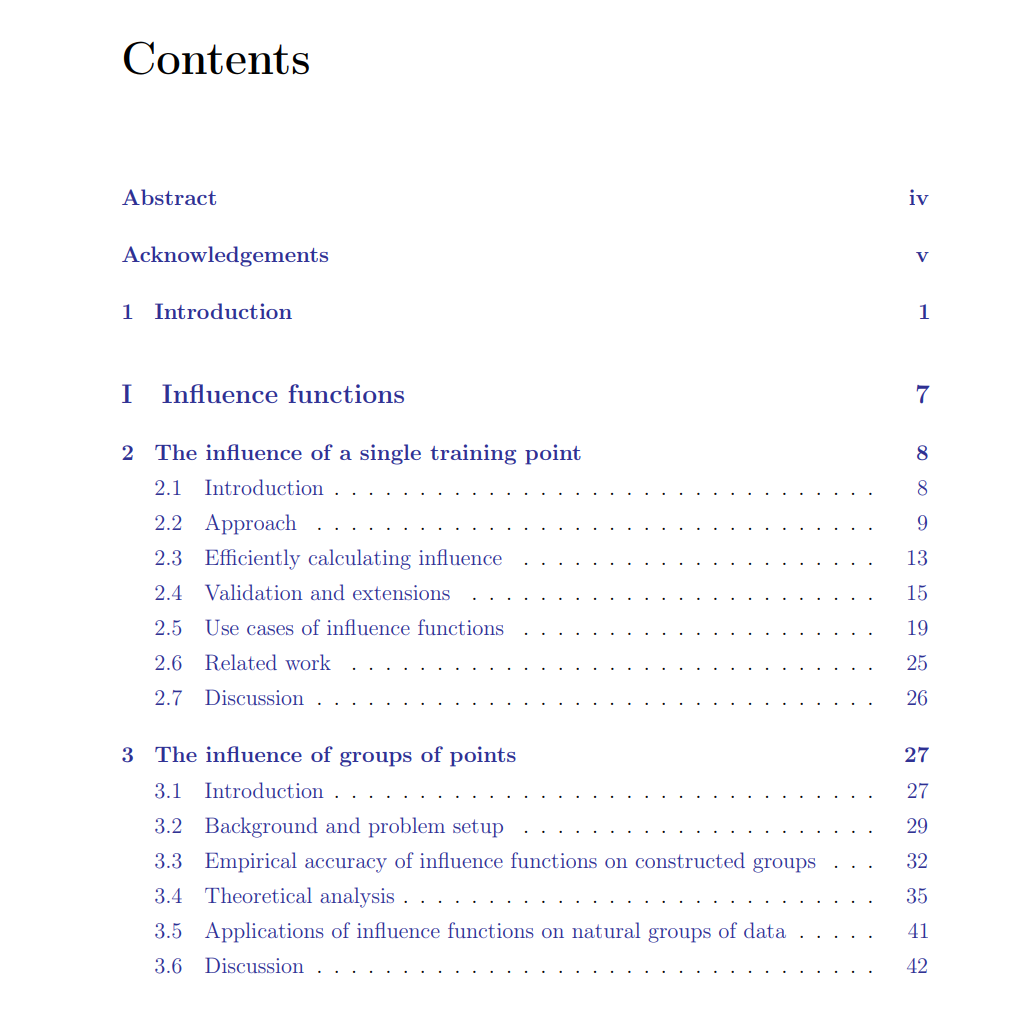

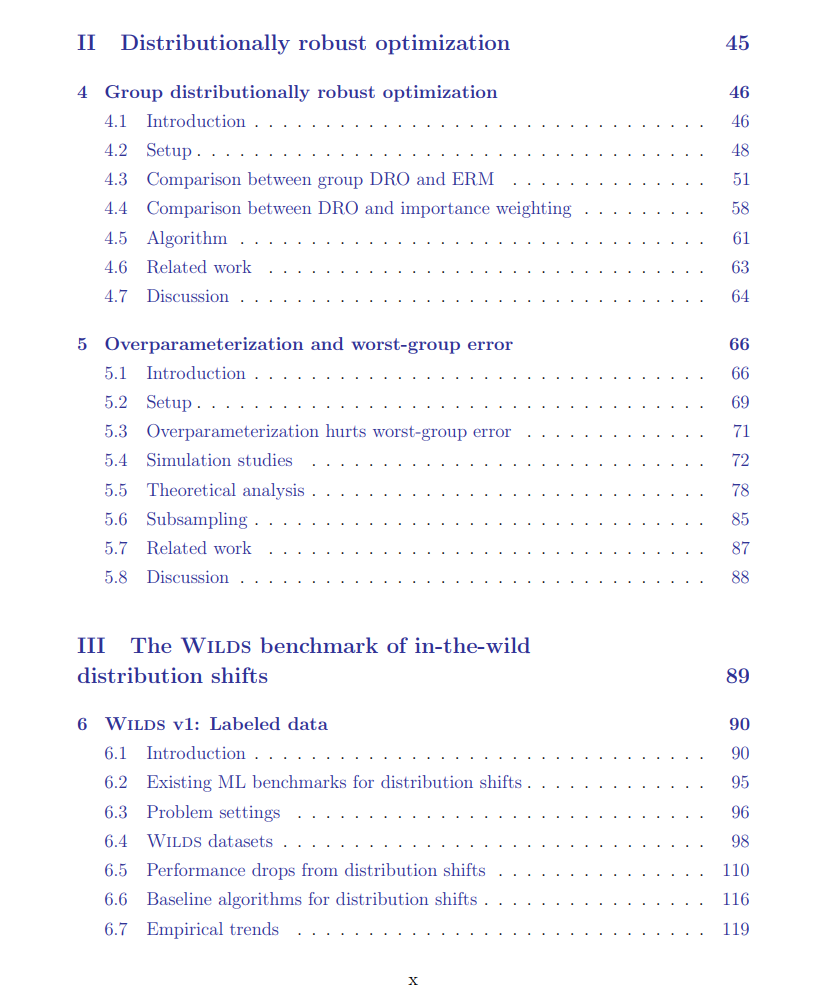

现今的机器学习系统已被广泛部署,但并不可靠:它们在某些环境下可能表现良好,但在其他环境下可能会失败,带来严重后果。例如,人脸识别模型在平均情况下可能表现良好,但在特定的人口子群体上可能失败;医疗模型在其训练的医院中可能表现良好,但在其他医院中可能会失败。这篇论文研究了构建对这些失败具有鲁棒性的可靠机器学习系统的三个方面。首先,我们介绍了一种用于检查模型并理解它们为何会失败的工具。由于训练数据是任何机器学习模型的关键成分,我们基于经典的影响函数概念来量化每个训练样本对模型预测的影响,使我们能够将错误追溯到训练数据,并更好地理解如何纠正它们。

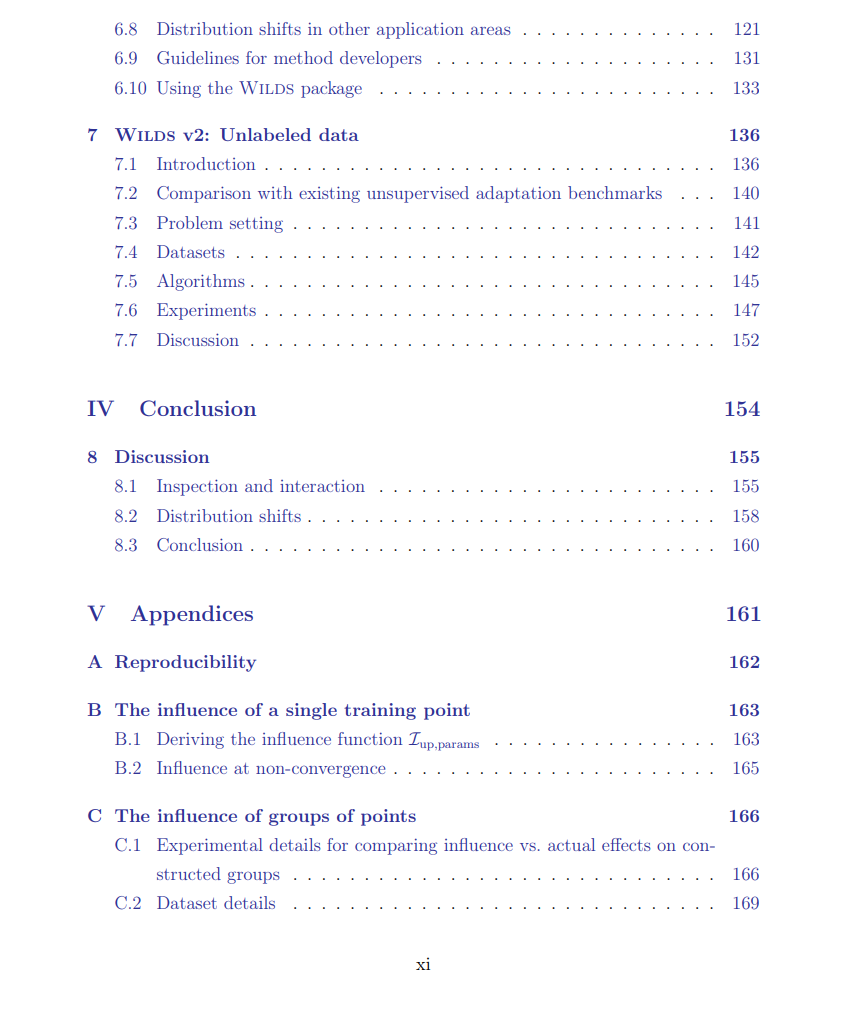

其次,我们开发了一种分布鲁棒优化(DRO)方法,用于直接训练模型在不同子群体中表现良好。这些子群体的变化出现在许多重要的应用中,从上面的面部识别示例,到医疗应用(有不同的患者子群体),以及到遥感应用(有不同的地理子区域)。第三,我们更一般地讨论了分布变化的基准;这包括子群体变化,以及不同环境(例如,不同的医院)之间的变化。我们介绍了Wilds——一个涵盖了如病理学、保护、遥感和药物发现等应用的实际分布变化基准——并展示了如何在合成变化上表现良好的最先进方法,在这些真实世界的变化上失败。我们的结果强调了将方法的开发和评估植根于实际应用环境的迫切需要。

现今的机器学习系统已被广泛部署,并深深地嵌入到我们的生活中——它们是支持我们手机和相机中无处不在的面部识别系统的核心;它们驱动我们道路上的自动驾驶汽车;并且在我们的医院中被用于诊断、预警和治疗建议。这些系统强大而有力,但并不可靠:它们可能在某些环境下工作得很好,但在其他环境下意外地失败,带来严重的后果。例如,当前的面部识别系统在特定的人口子群体中可能表现不佳[Buolamwini和Gebru,2018];当用于警察工作时,这些错误导致了错误的逮捕,并加剧了种族不平等[Hill,2020]。在不同地理区域部署时,自动驾驶汽车中使用的车辆和行人探测器可能会失败[Wang等人,2020c];首次记录的涉及自动驾驶汽车的致命事故部分原因,是由于在照明条件差的情况下,车载行人探测器的失效[NTSB,2019]。并且,医疗模型在不同的医院中部署时可能会失败[Zech等人,2018,Tellez等人,2019];医疗公司Epic的脓毒症早期警告系统已在数百家医院中部署,最近发现其性能比最初报告的要差得多,尽管对18%的住院患者产生了预警,但67%的时间未能发现脓毒症,大部分预警都是误报[Wong等人,2021]。

对于一个机器学习系统来说,要想可靠,它必须在所有实际部署的条件和环境中表现良好。这与机器学习研究通常关注的标准基准,如计算机视觉中的ImageNet [Russakovsky等人,2015],或自然语言处理中的GLUE [Wang等人,2019b],有所不同,这些基准在理想化的实验室环境中测量模型的平均性能。在实际环境中——即在机器学习系统为某一应用服务并部署的条件下——这些理想化设置的底层假设通常被打破,导致上述的失败。在实际环境中,训练数据分布和我们希望测量性能的数据分布之间几乎总是存在自然的分布变化[Quiñonero-Candela等人,2009]:在面部识别的例子中,我们不仅关心模型的平均性能,还关心在特定子群体上的性能,在自动驾驶车辆和医疗的例子中,我们关心的是模型实际部署的环境(地理区域和医院)的性能。在所有这些例子中,原始模型在训练数据分布(保留样本)上表现良好,但分布变化使它们在部署期间失败[Sagawa等人,2020a,Wang等人,2020c,Wong等人,2021]。分布的变化甚至可能是由寻求通过污染训练数据[Barreno等人,2010]或测试数据[Szegedy等人,2014]来操纵模型行为的对手引发的。此外,机器学习模型通常作为涉及人类最终用户的更大系统的一部分部署;因此,除了测量模型性能外,我们还需要考虑人类因素,比如模型输出可能如何影响整体人类决策[Bansal等人,2021],或者它们是否可以被其最终用户轻易地检查和信任[Lipton,2018]。

要构建可靠的机器学习系统,我们需要三个关键要素。第一个要素是对机器学习系统被部署的应用和环境有深刻的理解,这可以告诉我们如何适当地衡量可靠性,以及我们有哪些结构假设和手段可以应对这个问题。因此,这个努力本质上是跨学科的;相应地,这篇论文的工作是与自然语言处理、计算机视觉、机器人技术、人机交互、药物发现、人口遗传学、功能基因组学、发育生物学、病理学、农业和保护学的研究者合作的结果。第二个要素是严谨的统计基础:对我们的算法有理论上的理解可以在特定条件下为我们提供可靠性保证,揭示失败模式,并照亮改进我们模型的新途径。第三个要素是仔细的实证研究。现实世界中的模型、数据和用例往往过于复杂,无法完全通过理论来描述。通过研究我们的模型在实际设置中的实际行为,我们可以检查我们的理论假设是否是对现实的合理近似,以及发现新的现象进行分析研究。我们在这篇论文中的工作努力将这些要素的元素结合起来。我们关注构建可靠机器学习系统的三个方面。我们从第一部分的模型检查开始。在第二部分,我们转向处理子群体变化的方法;然后,在第三部分,我们更一般地讨论分布变化的基准,包括子群体和环境之间的变化。