解释一直是交流的一部分,人类使用语言来阐明彼此并传递关于事件机制的信息。已有众多研究探讨了解释的结构及其对人类的实用性。

同时,解释涉及自然语言处理(以及更广泛的计算机视觉和机器学习)中的一系列研究方向,研究人员开发计算方法来解释(通常是深度神经网络)模型。解释性研究受到了越来越多的关注。

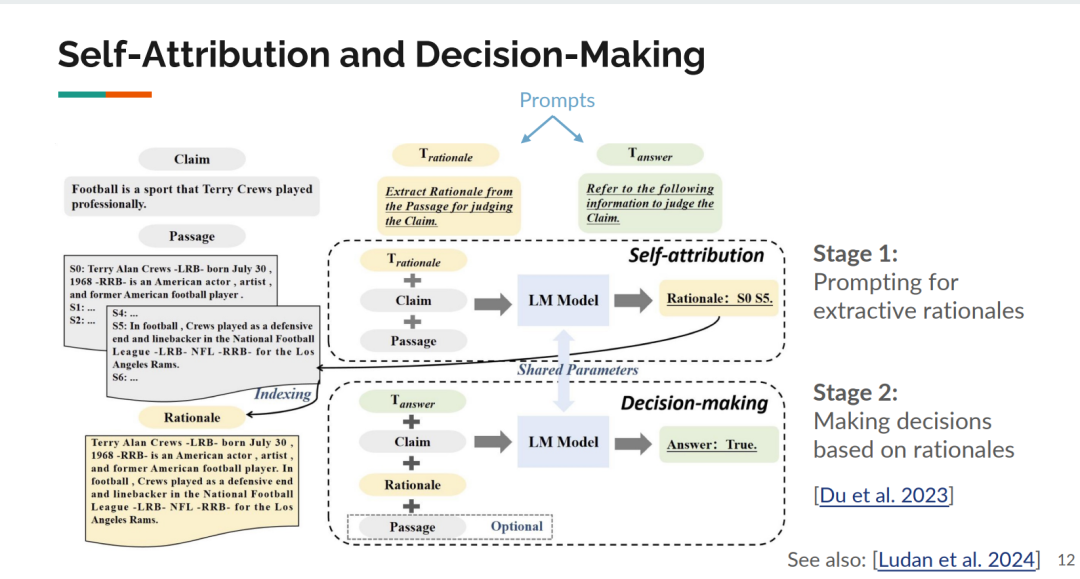

近几个月来,大语言模型(LLMs)的进步提供了前所未有的机会来利用其推理能力,既可以作为生成解释的工具,也可以作为解释分析的对象。另一方面,LLMs的巨大规模和不透明性质对解释方法提出了挑战。在本教程中,我们旨在回顾LLMs时代解释的这些机会和挑战,连接之前由不同研究组研究的一些内容,并希望能激发新的研究方向的思考。

https://explanation-llm.github.io/

成为VIP会员查看完整内容

相关内容

Arxiv

149+阅读 · 2023年4月7日