人工智能(AI)是公认的先进技术,可帮助决策过程实现高精度和高准确性。然而,由于依赖于复杂的推理机制,许多人工智能模型通常被评价为黑盒。 人类用户往往无法理解这些人工智能模型是如何以及为何做出决策的,从而担心其决策的可接受性。以往的研究表明,由于缺乏人类可理解的相关解释,最终用户无法接受这些决策。在此,可解释人工智能(XAI)研究领域提供了一系列方法,其共同主题是研究人工智能模型如何做出决策或解释决策。这些解释方法旨在提高决策支持系统(DSS)的透明度,这在道路安全(RS)和空中交通流量管理(ATFM)等安全关键领域尤为重要。尽管决策支持系统在不断发展,但在安全关键型应用中仍处于演变阶段。在 XAI 的推动下,透明度的提高已成为使这些系统在实际应用中切实可行、解决可接受性和信任问题的关键因素。此外,根据欧盟委员会目前的 “解释权 ”授权和全球各组织的类似指令,认证机构不太可能批准这些系统用于一般用途。这种将解释渗透到现有系统中的冲动,为 XAI 与 DSS 相结合的研究铺平了道路。

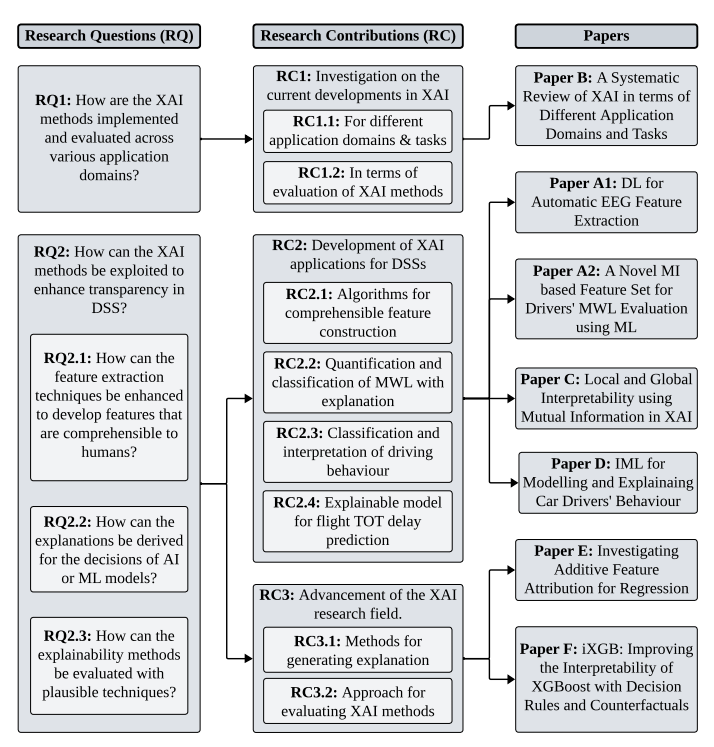

为此,本论文主要为 RS 和 ATFM 应用领域开发了可解释模型。特别是,通过分类和回归任务,开发了用于评估驾驶员车内心理工作量和驾驶行为的可解释模型。此外,还提出了一种利用互信息(MI)从车辆和脑电图(EEG)信号生成混合特征集的新方法。该特征集的使用成功地减少了复杂的脑电图特征提取计算所需的工作量。互信息(MI)的概念被进一步用于生成人类可理解的心理工作量分类解释。在 ATFM 领域,本论文开发并展示了一个可解释的模型,用于从历史飞行数据中预测航班起飞时间延误。通过开发和评估这两个领域的可解释应用所获得的启示强调了进一步研究 XAI 方法的必要性。

在本博士论文的研究中,DSS 的可解释应用是通过加法特征归因(AFA)方法开发的,该方法是当前 XAI 研究中流行的一类 XAI 方法。尽管如此,仍有一些文献断言,特征归因方法通常会产生不一致的结果,需要进行合理的评估。然而,关于评估技术的现有文献仍不成熟,提出了许多建议方法,却未就其在各种场景中的最佳应用达成标准化共识。为了解决这个问题,我们还根据 XAI 文献的建议,为 AFA 方法制定了全面的评估标准。建议的评估流程考虑了数据的基本特征,并利用了基于案例推理的加法形式,即 AddCBR。本论文提出了 AddCBR,并将其作为评估流程的补充进行演示,以此作为比较 AFA 方法生成的特征归因的基线。iXGB 生成决策规则和反事实,以支持 XGBoost 模型的输出,从而提高其可解释性。通过功能评估,iXGB 展示了用于解释任意树状集合方法的潜力。

从本质上讲,这篇博士论文最初有助于为两个不同的安全关键领域开发经过理想评估的可解释模型。其目的是提高相应 DSS 的透明度。此外,论文还引入了新颖的方法,以不同的形式生成更易于理解的解释,超越了现有的方法。论文还展示了 XAI 方法的稳健评估方法。

图 1.1: 研究课题、研究贡献和收录论文的一般映射。