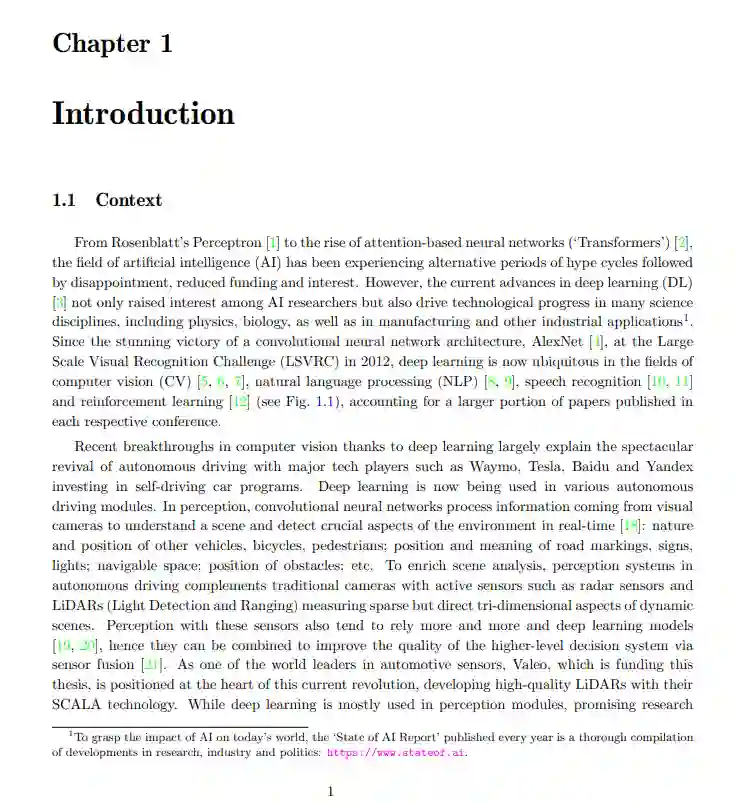

过去十年在人工智能和硬件开发方面的研究对自动驾驶的发展产生了重大影响。然而,在高风险环境中部署此类系统时,安全性仍然是一个主要问题。现代神经网络已被证明很难正确识别自己的错误,并在面对看不清的情况时提供过度自信的预测,而不是放弃。在这些问题上取得进展,不仅对获得交通主管部门的认证至关重要,而且对激发用户的热情也至关重要。

本论文的目的是开发为深度神经网络提供可靠的不确定性估计的方法工具。特别是,我们的目标是改进测试时错误预测和异常的检测。首先,我们引入了一种新的模型置信度目标准则——真类概率(TCP)。在故障预测任务中,TCP比当前的不确定性度量提供了更好的性能。由于真正的类在测试时本质上是未知的,我们提出使用辅助模型(知己网)从数据中学习TCP准则,并引入了一种适合这种情况的特定学习方案。在图像分类和语义分割数据集上验证了所提方法的相关性,证明了在故障预测方面强不确定性量化基线的优越性。

然后,我们将学习过的置信度方法扩展到语义分割的领域适应任务中。一种流行的策略是自训练,它依赖于在未标记的数据上选择预测,并用这些伪标签重新训练模型。这种被称为ConDA的自适应方法通过提供用于选择伪标签的有效置信度估计改进了自我训练方法。为了应对领域适应的挑战,我们为辅助模型配备了多尺度的置信度体系结构,并用对抗训练方案补充置信度损失,以加强源域和目标域的置信度映射之间的对齐。最后,我们考虑了异常的存在,并解决了联合检测错误分类和非分布样本的最终实际目标。为此,我们引入了一种基于证据模型并定义在类概率单形上的不确定性测度KLoS。通过保留完整的分布信息,KLoS既捕获了由于类别混乱而产生的不确定性,又捕获了与分布不均样本相关的知识缺乏。通过使用辅助模型和学习置信方法,我们进一步提高了不同图像分类数据集的性能。