【导读】作为计算机视觉领域三大会议之一,European Conference on Computer Vision(欧洲计算机视觉大会,ECCV)备受全球领域众多专业人士关注。几天前,ECCV 2020官方发布接收论文,本次大会共有5025篇投稿,1361篇被接收,接受率27%。ECCV 2020 已经于8月23日-28日Online方式进行。论文列表已经放出,小编发现少样本学习方向火热,录用了好多篇相关paper,为此专知小编整理了七篇 ECCV 2020 少样本学习(Few-Shot Learning,FSL) 相关论文供大家参考——跨域少样本学习、胶囊注意力原型网络、负间隔损失、任务自适应特征学习、自监督

ECCV 2020 接受论文列表和下载地址: https://eccv2020.eu/accepted-papers/ https://www.ecva.net/papers.php

ECCV2020ReID、ECCV2020OD、ICML2020GNN_Part1、KDD2020GNN_Part1、CVPR2020SGNN、CVPR2020GNN_Part2、CVPR2020GNN_Part1、

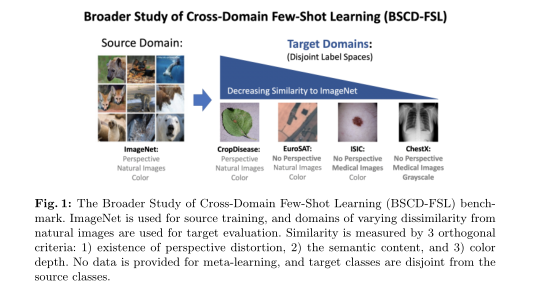

1、A Broader Study of Cross-Domain Few-Shot Learning

作者:Yunhui Guo, Noel C. Codella, Leonid Karlinsky, James V. Codella, John R. Smith, Kate Saenko, Tajana Rosing, Rogerio Feris

摘要:最近在少样本学习方面的进展很大程度上依赖于元学习的标注数据:与新类别相同的域中采样其基类。然而,在许多应用中,为元学习收集数据是不可行或不可能的。这导致了跨域的少样本学习问题,其中在基域和新类别域之间存在很大的Gap。虽然对跨域少样本场景的研究已经存在,但这些工作仅限于视觉相似度很高的自然图像。目前还没有在真实世界场景中看到的不同成像方法(如航空成像和医学成像)之间进行少样本学习的研究。在本文中,我们提出了更广泛的跨域少样本学习(BSCD-FSL)基准研究,该基准由来自各种图像获取方法的图像数据组成。这些图像数据包括自然图像,如作物病害图像,还有那些与自然图像有很大不同的图像,如卫星图像、皮肤病图像和放射学图像。我们在所提出的基准上进行了大量的实验,以评估最新的元学习方法、迁移学习方法和较新的跨域少样本学习方法。结果表明,最新的元学习方法的表现优于早期的元学习方法,并且所有的元学习方法的表现都比简单的精调在平均准确率上要差12.8%。在某些情况下,元学习甚至不如具有随机权重的网络。在这个更具挑战性的基准测试中,以前使用专门用于跨域、少样本学习的方法的性能提升消失得无影无踪。最后,所有方法的准确性往往与数据集与自然图像的相似性相关,我们验证了基准的价值,从而能够更好地代表真实场景数据的多样性,并指导未来的研究。

代码:

https://github.com/IBM/cdfsl-benchmark

网址:

https://www.ecva.net/papers.php

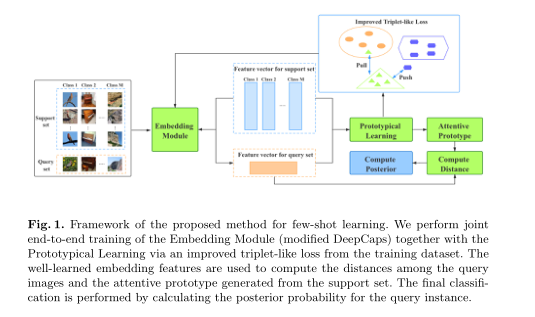

2、Attentive Prototype Few-shot Learning with Capsule Network-based Embedding

作者:Fangyu Wu, Jeremy S.Smith, Wenjin Lu, Chaoyi Pang, Bailing Zhang

摘要:用很少的训练样本识别新的类别的少样本学习,是机器学习研究中一个极具挑战性的领域。传统的深度学习方法需要大量的训练数据来调整数量庞大的参数,这往往是不切实际的,而且容易过拟合。在这项工作中,我们进一步研究了被称为原型网络的少样本学习方法,以获得更好的性能。我们的贡献包括:(1)一种新的嵌入结构,通过应用胶囊网络(capsule network)来编码特征之间的相对空间关系;(2)设计了一种新的三元组损失来增强语义特征的嵌入性,即相似样本之间距离较近,而不同样本之间的距离较远;以及(3)一种有效的非参数分类器,称为注意力原型,取代了目前少样本学习中的简单原型。我们提出的注意力原型聚合了支持类中的所有实例,这些实例根据它们的重要性(由给定查询的重构误差定义)进行加权。重构误差允许估计对应于分类置信度分数的分类后验概率。在三个基准数据集上的大量实验表明,该方法对于少样本分类任务是有效的。

网址:

https://www.ecva.net/papers.php

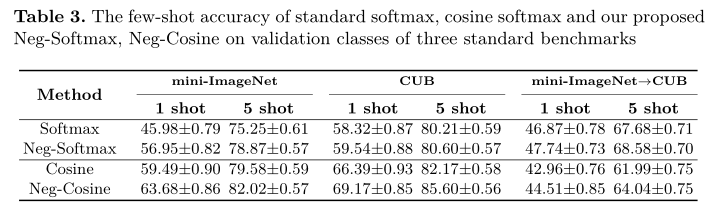

3、Negative Margin Matters: Understanding Margin in Few-shot Classification

作者:Bin Liu1, Yue Cao, Yutong Lin, Qi Li, Zheng Zhang, Mingsheng Long, Han Hu

摘要:本文介绍了一种基于度量学习的负边距损失(negative margin loss)的少样本学习方法。负边距损失的表现明显优于常规的Softmax损失,并且在三个标准的少样本分类基准上实现了最先进的精确度。这些结果与度量学习领域的通常做法(差值为零或正)相反。为了理解为什么负边距损失在少样本分类中表现良好,我们从经验和理论上分析了训练类和新类中不同边缘的学习特征的可区分性。我们发现,虽然负边距降低了训练类的特征可区分性,但也可以避免将同一新类的样本错误映射到多个峰或簇,从而有利于对新类的区分。

代码:

https://github.com/bl0/negative-margin.few-shot

网址:

https://www.ecva.net/papers.php

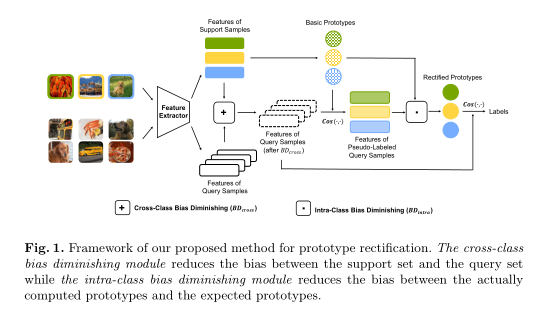

4、Prototype Rectification for Few-Shot Learning

作者:Jinlu Liu, Liang Song, Yongqiang Qin

摘要:少样本学习要求识别具有稀缺标签数据的新类。原型网络(prototypical network)在现有的研究中是有用的,然而,对稀缺数据进行窄尺寸分布(narrow-size distribution)的训练往往会得到有偏差的原型。在本文中,我们找出了这一过程的两个关键影响因素:类内偏差和跨类偏差。然后,我们提出了一种简单而有效的方法,用于转导设置(transductive setting)下的原型校正。该方法利用标签传播(label propagation)来减小类内偏差,利用特征迁移来减小跨类偏差。我们还进行了理论分析,推导出其合理性以及性能的下界。在三个少样本基准上的有效性显示,我们的方法在miniImageNet(1-shot 70.31%, 5-shot 81.89%)和tieredImageNet(1-shot 78.74%,5-shot 86.92%)上都获得了最先进的性能。

网址:

https://www.ecva.net/papers.php

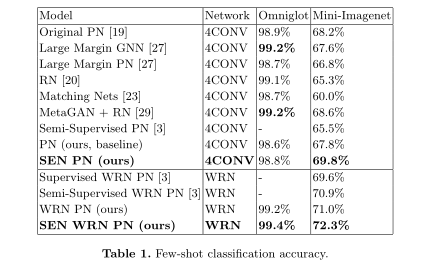

5、SEN: A Novel Feature Normalization Dissimilarity Measure for Prototypical Few-Shot Learning Networks

作者:Van Nhan Nguyen, Sigurd Løkse, Kristoffer Wickstrøm, Michael Kampffmeyer, Davide Roverso, Robert Jenssen

摘要:在这篇文章中,我们给原型网络(PNS)配备了一种新的相异度度量,以实现少样本学习的区分特征归一化。嵌入到超球面上不需要直接归一化,易于优化。我们理论分析表明,所提出的欧几里德距离平方根和范数距离(SEN)的相异度测度迫使嵌入点被吸引到其正确的原型上,而排斥所有其他原型,保持所有点的范数相同。所得到的SEN PN在没有附加参数的情况下以相当大的幅度优于常规PN,并且计算开销可以忽略不计。

网址:

https://www.ecva.net/papers.php

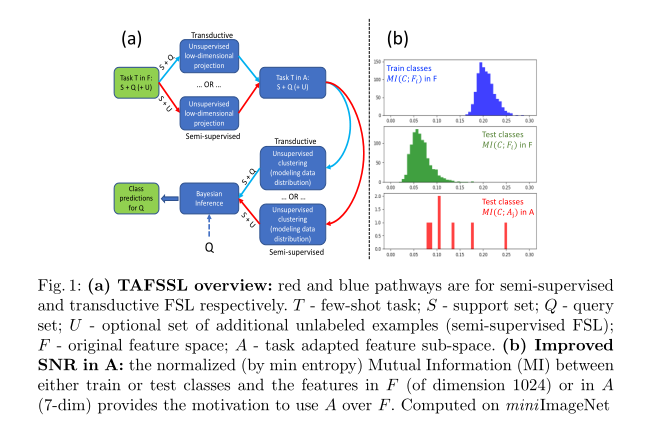

6、TAFSSL: Task-Adaptive Feature Sub-Space Learning for few-shot classification

作者:Moshe Lichtenstein, Prasanna Sattigeri, Rogerio Feris, Raja Giryes, Leonid Karlinsky

摘要:近来,少样本学习(FSL),即从非常少的(通常是1到5个)的例子中学习一个新的类别(在训练时候不存在),得到了很多关注和显著的性能进步。虽然已经为FSL提出了许多技术,但有几个因素已经成为影响FSL性能的最重要因素,即使是最简单的技术也可以授予SOTA。它们是:骨干架构(越大越好),预训练类型(元训练与多类别),基类的数量和多样性(越多越好),以及使用辅助自监督任务(增加多样性的代理)。在本文中,我们提出了TAFSSL,这是一种简单的技术,可以在伴随着一些额外的未标记数据的少样本任务中提高少样本性能。TAFSSL的直觉是基于减少预训练期间未见过的由新类别组成的少样本任务所固有的特征和采样噪声。具体地说,在具有挑战性的miniImageNet和tieredImageNet基准测试中,TAFSSL可以将当前最先进的转导和半监督FSL设置提高5%以上,同时将在FSL中使用未标记数据的性能提高到10%以上。

网址:

https://www.ecva.net/papers.php

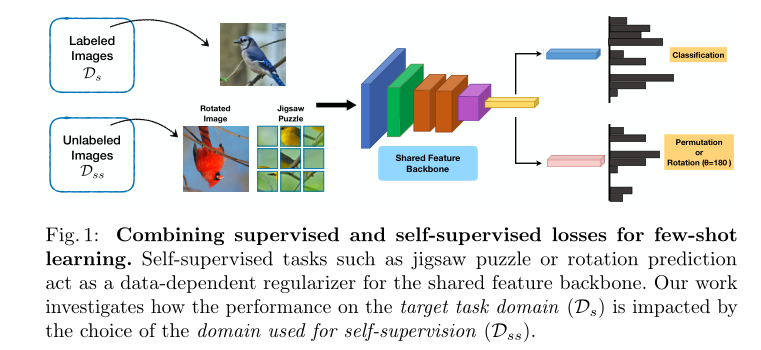

7、When Does Self-supervision Improve Few-shot Learning?

作者:Jong-Chyi Su, Subhransu Maji, Bharath Hariharan

摘要:我们研究了自监督学习(SSL)在少样本学习环境中的作用。虽然最近的研究已经显示了SSL在大型未标记数据集上的好处,但它在小型数据集上的实用性相对来说还没有被探索过。我们发现,SSL将少样本元学习的相对错误率降低了4%-27%,即使当数据集很小并且只使用数据集中的图像时也是如此。当训练集越小或任务越具挑战性时,改进效果越大。虽然SSL的好处可能会随着训练集的增加而增加,但我们观察到,当用于元学习的图像的分布与SSL不同时,SSL会损害性能。我们通过改变域转移的程度和分析几个元学习在多个领域上的表现来进行系统的研究。基于这一分析,我们提出了一种技术,该技术可以从给定数据集的大型通用未标记图像池中自动选择用于SSL的图像,从而提供进一步的改进。