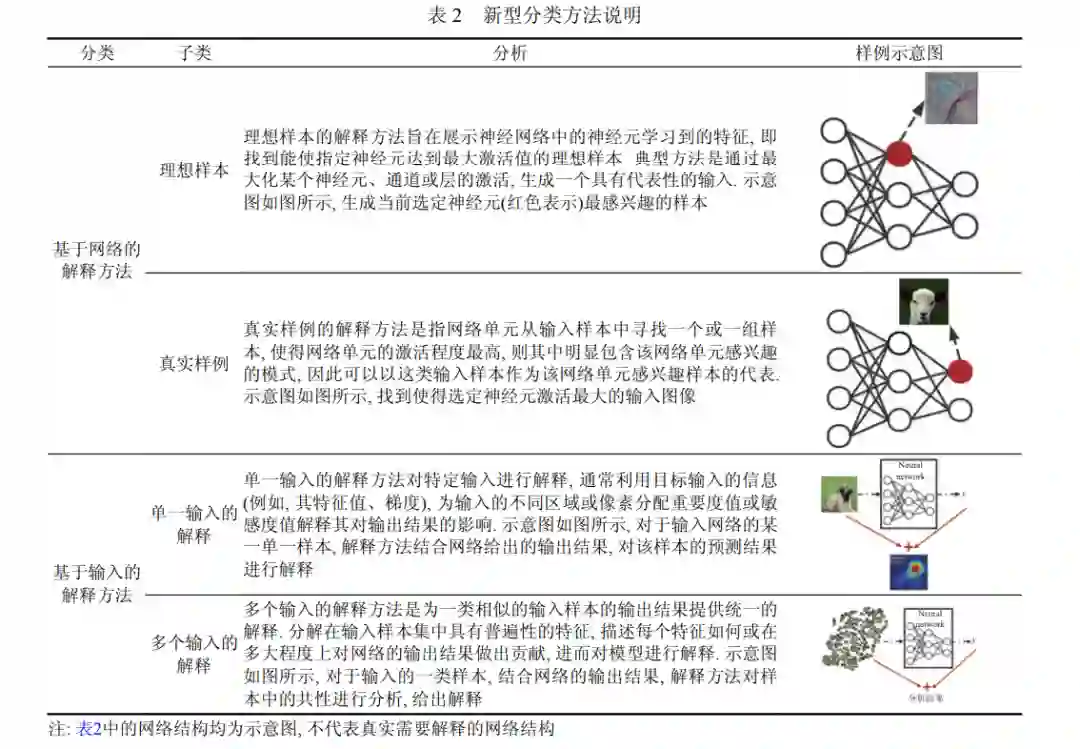

神经网络模型性能日益强大, 被广泛应用于解决各类计算机相关任务, 并表现出非常优秀的能力, 但人类 对神经网络模型的运行机制却并不完全理解. 针对神经网络可解释性的研究进行了梳理和汇总, 就模型可解释性 研究的定义、必要性、分类、评估等方面进行了详细的讨论. 从解释算法的关注点出发, 提出一种神经网络可解 释算法的新型分类方法, 为理解神经网络提供一个全新的视角. 根据提出的新型分类方法对当前卷积神经网络的 可解释方法进行梳理, 并对不同类别解释算法的特点进行分析和比较. 同时, 介绍了常见可解释算法的评估原则和 评估方法. 对可解释神经网络的研究方向与应用进行概述. 就可解释神经网络面临的挑战进行阐述, 并针对这些挑 战给出可能的解决方向.近年来, 人工智能 (artificial intelligence, AI) 成为最重要的科学研究领域之一, 具有巨大的社会影响力, AI 技 术被广泛应用于各个领域[1,2] . 随着可扩展的高性能基础设施的发展, AI 系统在许多领域已成为不可或缺的工具, 甚至在越来越多的复杂任务上完成度超过了人类水平[3,4] . 然而, AI 系统在预测、推荐和决策支持方面的出色表现通常是通过采用复杂的神经网络模型来实现的, 这些 模型隐藏了内部流程的逻辑, 此类模型通常被称为黑盒模型[5–7] . 神经网络模型通过非线性、非单调和非多项式函 数来近似数据集中变量之间的关系, 这使得内部运行原理高度不透明. 神经网络模型经常因为错误的原因在训练 集中得到正确的预测结果, 导致模型在训练中表现出色, 但在实践中表现不佳[8–11] . 因此, 神经网络的黑盒特性使 得人类难以完全相信神经网络模型的决策. 人类有进一步了解神经网络模型的意愿. 对于决策能力较人类更差的模型, 希望可以在深度了解模型后发现 问题并解决问题, 从而帮助模型改善性能. 对于决策能力与人类相似的模型, 希望可以解释决策结果, 从而使人类 信任模型, 应用模型. 对于决策能力较人类更好的模型, 希望可以分析其决策机制, 帮助人类更好更深入地理解需 要解决的问题. 可解释人工智能 (explainable AI, XAI)[12]研究致力于以人类可理解的方式解释人工智能模型[13] , 使得人类能 够理解模型的内部运行逻辑和决策结果, 为模型的故障排除和广泛使用提供方便. 可视化和解释神经网络模型的 研究工作引起了越来越多的关注. 2018 年, 欧洲议会在通用数据保护条例 (general data protection regulation, GDPR) 中引入关于自动化决策的条款, 规定数据主体有获得自动化决策中涉及的相关解释信息的权利. 此外, 在 2019 年, 人工智能高级专家组提出了可信赖人工智能的道德准则. 尽管法律上对这些条款存在不同意见[14,15] , 但 普遍认同实施这样一个原则的必要性和紧迫性. 美国国家标准与技术研究院 (National Institute of Standards and Technology, NIST) 于 2020 年 8 月发布关于 XAI 的 4 项原则[16] : 可证明性 (解释结果可以被证据证明)、可用性 (解释结果能够被模型使用用户理解并对用户有意义)、准确性 (解释结果必须准确反映模型运行机制)、限制性 (解释结果能识别出不适合其自身运行的情况). 本文主要对卷积神经网络的可解释算法进行回顾和总结, 第 1 节主要针对模型可解释的定义和研究必要性进 行讨论, 归纳受到了广泛认可的可解释定义和该领域内的常见词汇定义, 并从解决伦理问题、加强模型可靠性和 优化模型性能等几个方面, 介绍对模型进行解释的必要性. 第 2 节对近年来模型可解释的相关研究进行简要分析, 首先对可解释研究具有代表性的研究和发展脉络进行梳理, 随后介绍目前已有的可解释算法的分类方法, 并总结 现有分类方法普遍存在的问题. 第 3 节提出一种对神经网络可解释算法进行分类的新方法, 为理解可解释算法提 供新角度. 依据新的分类方法, 对当前卷积神经网络的可解释方法进行梳理, 并对不同类别解释算法的特点进行分 析和比较. 第 4 节中介绍常见的可解释算法的评估原则和评估方法. 第 5 节讨论可解释神经网络的研究方向、实 际应用和当前面临的挑战, 对解释算法的目标和应用任务等与可解释性研究密切相关的内容进行阐述, 并就神经 网络解释模型当前面临的问题进行简述, 针对这些挑战给出可能的解决方向. 第 6 节对全文进行总结.